צדיק, יש לך דקה לשמוע על אלכס משיח הAI?

האיש שבלעדיו הסמיילי 🤯 היה כנראה מובטל.

היום נכיר את האיש הכי חשוב שאתם לא מכירים.

מוכנים? בואו איתי 🧵>>

#פידטק #פידאטה #פידטכנולוגיה

(אה כן, אם שמתם Bookmark - תוסיפו איזו הקלקת לייק, זה סופר עוזר לי 🥰)

האיש שבלעדיו הסמיילי 🤯 היה כנראה מובטל.

היום נכיר את האיש הכי חשוב שאתם לא מכירים.

מוכנים? בואו איתי 🧵>>

#פידטק #פידאטה #פידטכנולוגיה

(אה כן, אם שמתם Bookmark - תוסיפו איזו הקלקת לייק, זה סופר עוזר לי 🥰)

כדי להבין מה קורה בשרשור הזה, אני בונה על זה שאתם יודעים בגדול איך עובדת רשת קונבולוציה.

זה בעצם סוג של חלק ג' אחרי רשת נוירונים רגילה.

רשת נוירונים:

רשת קונבולוציה:

נמשיך >>

זה בעצם סוג של חלק ג' אחרי רשת נוירונים רגילה.

רשת נוירונים:

https://twitter.com/tsoofbaror/status/1564335495559221249

רשת קונבולוציה:

https://twitter.com/tsoofbaror/status/1668234251807100931

נמשיך >>

1. פאן פאקט עלי, מעריץ שרוף של @GeronRoy והפודקאסט "כשבגרוש היה חור".

הפודקאסט בוחן את ההיסטוריה בראי כלכלי, כי מה הדרך הכי טובה ללמוד כלכלה אם לא מאירועים שקרו באמת?

אז בהשראתו:

היום נצלול להיסטוריה הרחוקה של הAI אי שם ב.. 2012.

מוכנים? >>

osimhistoria.com/grush

הפודקאסט בוחן את ההיסטוריה בראי כלכלי, כי מה הדרך הכי טובה ללמוד כלכלה אם לא מאירועים שקרו באמת?

אז בהשראתו:

היום נצלול להיסטוריה הרחוקה של הAI אי שם ב.. 2012.

מוכנים? >>

osimhistoria.com/grush

2. מאגר התמונות ImageNet הוא אולי הכי מפורסם מעולם הAI.

נכון להיום, כולל 14 מיליון תמונות עם יותר מ20,000 מחלקות (תיוגים שונים).

תמונות של בלונים, חתולים, כלבים, בניינים, מה שתרצו.

לקח 3 שנים לבנות אותו, והוא פורסם ב2009 לקהילת "הראיה הממוחשבת", כי אז AI עוד >>

נכון להיום, כולל 14 מיליון תמונות עם יותר מ20,000 מחלקות (תיוגים שונים).

תמונות של בלונים, חתולים, כלבים, בניינים, מה שתרצו.

לקח 3 שנים לבנות אותו, והוא פורסם ב2009 לקהילת "הראיה הממוחשבת", כי אז AI עוד >>

3. היה קצת מילה גסה.

בכל מקרה, אותו דאטהסט ענק זוקק לדאטהסט שמכונה ImageNet-1K.

הוא כולל 1.2M תמונות אימון, 50k ולידציה, 100k בחינה.

ב2010 התחילה תחרות עם השם הארוך והלא-סקסי:

ImageNet Large Scale Visual Recognition Challenge

או ILSVRC בקצרה.

התחרות עבדה כך >>

בכל מקרה, אותו דאטהסט ענק זוקק לדאטהסט שמכונה ImageNet-1K.

הוא כולל 1.2M תמונות אימון, 50k ולידציה, 100k בחינה.

ב2010 התחילה תחרות עם השם הארוך והלא-סקסי:

ImageNet Large Scale Visual Recognition Challenge

או ILSVRC בקצרה.

התחרות עבדה כך >>

4. צוותים בנו אלגוריתמים שלמדו את הדאטה, ואז נבחנו על הסט של ה100K.

עבור כל תמונה מה100k, המודל נדרש לייצר 5 תשובות (מתוך 1000 אפשריות), מה שנקרא Top-5 Error.

אם התיוג הנכון נמצא בין 5 התשובות האלה, תשובת המודל מוגדרת כהצלחה.

ב2010-2011 כשהתחרות התחילה, המודלים הכי טובים הגיעו >>

עבור כל תמונה מה100k, המודל נדרש לייצר 5 תשובות (מתוך 1000 אפשריות), מה שנקרא Top-5 Error.

אם התיוג הנכון נמצא בין 5 התשובות האלה, תשובת המודל מוגדרת כהצלחה.

ב2010-2011 כשהתחרות התחילה, המודלים הכי טובים הגיעו >>

5. לשגיאת-טופ-5 של 25.8%.

ואז (בקול של אסי) הגיע אלכס, ובשנה אחת חתך את השגיאה ל15.3%.

מה שנקרא, Everybody Got Crazy.

למה?

ב2010-11 הקבוצות הזוכות עבדו בשיטות ML קלאסיות.

כל תמונה עברה אלגוריתמים שמהנדסים ממנה מאפיינים, דוחסים אותם והעבירו אותם במסווג שמכונה SVM >>

ואז (בקול של אסי) הגיע אלכס, ובשנה אחת חתך את השגיאה ל15.3%.

מה שנקרא, Everybody Got Crazy.

למה?

ב2010-11 הקבוצות הזוכות עבדו בשיטות ML קלאסיות.

כל תמונה עברה אלגוריתמים שמהנדסים ממנה מאפיינים, דוחסים אותם והעבירו אותם במסווג שמכונה SVM >>

6. שהוא די פשוט.

ב2012 אותו אלכס, יחד עם איזה אחד שלא מזמן ביקר פה בארץ, איליה סוצקבר המדען הראשי של OpenAI וג'פרי הינטון (עוד ביגשוט בתחום), החליטו להשתמש ברשת נוירונים, אבל לא סתם!

כזו שכוללת כל מיני שדרוגים שונים ומשונים שהיום אספר לכם עליהם.

בנוסף, המימוש שלו אימן >>

ב2012 אותו אלכס, יחד עם איזה אחד שלא מזמן ביקר פה בארץ, איליה סוצקבר המדען הראשי של OpenAI וג'פרי הינטון (עוד ביגשוט בתחום), החליטו להשתמש ברשת נוירונים, אבל לא סתם!

כזו שכוללת כל מיני שדרוגים שונים ומשונים שהיום אספר לכם עליהם.

בנוסף, המימוש שלו אימן >>

7. את הרשת על GPU, דבר שכבר נעשה בעבר, אבל עדיין היה יחסית חריג באותה תקופה.

לרשת אגב, הוא קרא באופן די משעשע AlexNet.

אבל לפני שנדבר על AlexNet, בואו נדבר על LeNet.

רשת הנוירונים LeNet נולדה, תחזיקו חזק, בשנת 1998!

יאן לקון ( @ylecun ), שהיום המדען הראשי של Meta >>

לרשת אגב, הוא קרא באופן די משעשע AlexNet.

אבל לפני שנדבר על AlexNet, בואו נדבר על LeNet.

רשת הנוירונים LeNet נולדה, תחזיקו חזק, בשנת 1998!

יאן לקון ( @ylecun ), שהיום המדען הראשי של Meta >>

8. הראה כבר 1989 (זאת לא טעות, רגע) שהוא מצליח בעזרת רשתות קונבולוציה פשוטות מאד לזהות ספרות מכתב יד.

הרשת קיבלה תמונה שחור לבן בגדול 16x16, והנה המבנה שדיברתי עליו בשרשור על CNN - שכבות קונבולוציה, ואז שכבות "רגילות".

קצת יותר מ10 שנים אחרי ב1998 הוצגה >>

(בתמונה - הרשת מ1989)

הרשת קיבלה תמונה שחור לבן בגדול 16x16, והנה המבנה שדיברתי עליו בשרשור על CNN - שכבות קונבולוציה, ואז שכבות "רגילות".

קצת יותר מ10 שנים אחרי ב1998 הוצגה >>

(בתמונה - הרשת מ1989)

9. הארכיטקטורה של LeNet. אבל רגע לפני שאדבר עליה, תראו את הסרטון הזה - רשתות נוירונים ב1989!

משוגע.

זה יאן לקון הצעיר, אגב.

בכל מקרה, LeNet. >>

משוגע.

זה יאן לקון הצעיר, אגב.

בכל מקרה, LeNet. >>

10. הנה LeNet.

הרשת הזאת היא באמת אם-כל-רשתות הקונבולוציה, עם התחלת הפופולריזציה של מבנה הקונבולוציה -> אקטיבציה -> פולינג -> חוזר חלילה..

שימו לב לכל המונחים המוכרים משרשור הCNN - יש פה גרעין (Kernel), יש Padding, יש Stride.

נשים לב:

האקטיבציות הן Sigmoid. זה >>

הרשת הזאת היא באמת אם-כל-רשתות הקונבולוציה, עם התחלת הפופולריזציה של מבנה הקונבולוציה -> אקטיבציה -> פולינג -> חוזר חלילה..

שימו לב לכל המונחים המוכרים משרשור הCNN - יש פה גרעין (Kernel), יש Padding, יש Stride.

נשים לב:

האקטיבציות הן Sigmoid. זה >>

11. היה הסטנדרט ברשתות נוירונים אז.

הPooling לא היה Max Pooling הנפוץ היום, אלא Average Pooling.

עוד על הפולינג בהמשך.

אז LeNet אמנם עבדה נפלא, אבל האימון שלה היה איטי מאד (עוד לא אימנו אז עם GPU) והיא לא ממש הייתה שיפור לשיטות הקיימות, אותם SVMים

שהזכרתי קודם. בכל מקרה, LeNet >>

הPooling לא היה Max Pooling הנפוץ היום, אלא Average Pooling.

עוד על הפולינג בהמשך.

אז LeNet אמנם עבדה נפלא, אבל האימון שלה היה איטי מאד (עוד לא אימנו אז עם GPU) והיא לא ממש הייתה שיפור לשיטות הקיימות, אותם SVMים

שהזכרתי קודם. בכל מקרה, LeNet >>

12. נוצרה אבל לא "תפסה", אך מקומה ההיסטורי חייב אזכור כהשראה לAlexNet שדי דומה, עם כמה שדרוגים רציניים.

הראשון היה שימוש באקטיבציות ReLu במקום סיגמואיד.

אמפירית הבינו שRuLu עדיפה, והיא גם הנפוצה היום.

אם זה לא אומר לכם כלום, עוד אין לי שרשור אקטיבציות - בעתיד.

לא נורא, נמשיך. >>

הראשון היה שימוש באקטיבציות ReLu במקום סיגמואיד.

אמפירית הבינו שRuLu עדיפה, והיא גם הנפוצה היום.

אם זה לא אומר לכם כלום, עוד אין לי שרשור אקטיבציות - בעתיד.

לא נורא, נמשיך. >>

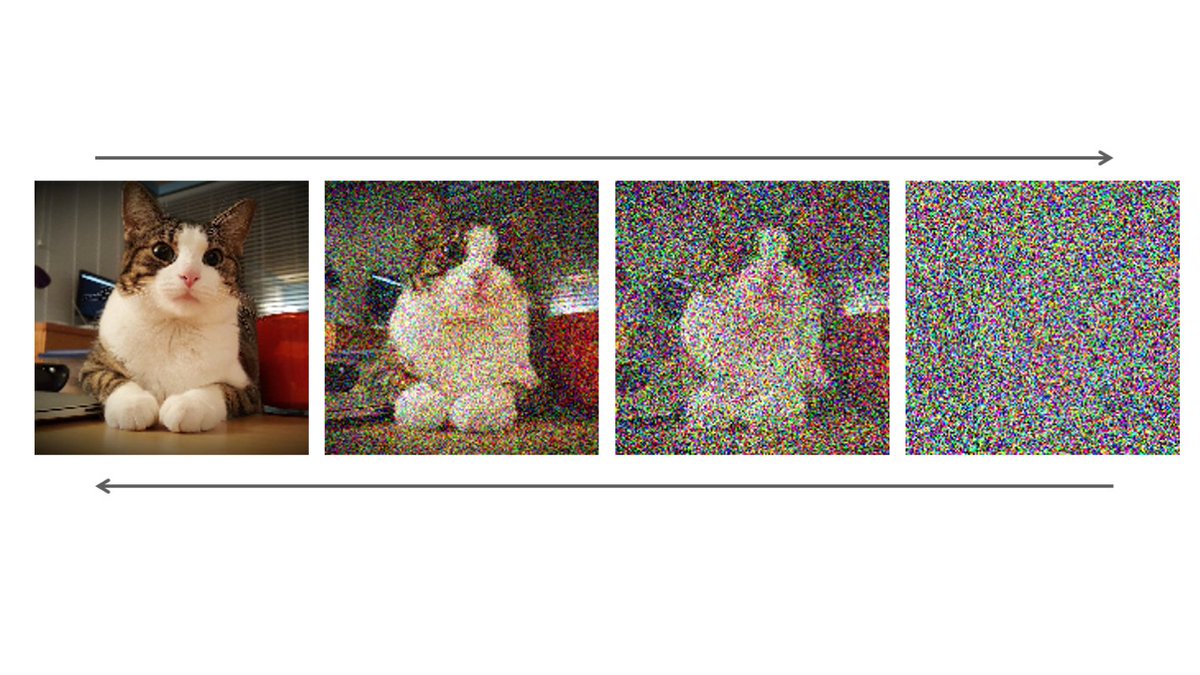

13. השדרוג השני היה החלפת פולינג ממוצע במקס.

הנה אני אחרי קונבולוציה 3x3 עם גרעין זיהוי קצוות, ופולינג בשתי הדרכים. תראו איך המקס מבליט יותר את המאפיין המזוקק (קצוות).

מגניב, לא?

השדרוג השלישי היה שכבות Dropout, עליהן עוד לא דיברתי.

מדובר על שכבות רשת נוירונים רגילות >>

הנה אני אחרי קונבולוציה 3x3 עם גרעין זיהוי קצוות, ופולינג בשתי הדרכים. תראו איך המקס מבליט יותר את המאפיין המזוקק (קצוות).

מגניב, לא?

השדרוג השלישי היה שכבות Dropout, עליהן עוד לא דיברתי.

מדובר על שכבות רשת נוירונים רגילות >>

14.אבל בהן במהלך האימון (בלבד) בהסתברות מסויימת "מכבים" נוירונים (כלומר, הם מוציאים 0).

הרעיון כאן הוא לגרום לרשת לא להיות "תלויה" בנוירונים ספציפיים למשימה

והמחשבה היא שזה מונע Overfitting.

למיטב ידיעתי היום מתחילים לצמצם את השימוש בטכניקה הזו, כי לא ברור כמה היא באמת יעילה. >>

הרעיון כאן הוא לגרום לרשת לא להיות "תלויה" בנוירונים ספציפיים למשימה

והמחשבה היא שזה מונע Overfitting.

למיטב ידיעתי היום מתחילים לצמצם את השימוש בטכניקה הזו, כי לא ברור כמה היא באמת יעילה. >>

15. השיפור הרביעי והאחרון הוא כמובן - רשת עמוקה והרבה יותר מסובכת.

הנה היא לפניכם.

עם כוח האימון של הGPU שלא היה זמין ב1989, הצליחו אלכס ושותפיו לאמן את ה"מפלצת" הזו (במונחי 2012) ולנצח בענק בתחרות.

ההצלחה של AlexNet נחשבת לאחת מיריות הפתיחה של מהפכת הAI.

שתבינו, הארכיטקטורה >>

הנה היא לפניכם.

עם כוח האימון של הGPU שלא היה זמין ב1989, הצליחו אלכס ושותפיו לאמן את ה"מפלצת" הזו (במונחי 2012) ולנצח בענק בתחרות.

ההצלחה של AlexNet נחשבת לאחת מיריות הפתיחה של מהפכת הAI.

שתבינו, הארכיטקטורה >>

16. שניצחה את AlexNet בתחרות שלוש שנים אחרי היא של גוגל, וכללה רשת נוירונים עם יותר מ100 שכבות (!).

AlexNet הייתה שכנוע אמיתי - רשתות נוירונים עובדות.

טוב.

מאד.

רגע, עברו 3 שנים וגוגל בנו רשת עם +100 שכבות.

למה החבר'ה של AlexNet לא עשו ככה?

כמה כבר התחזקו המחשבים ב3 שנים?!

או! >>

AlexNet הייתה שכנוע אמיתי - רשתות נוירונים עובדות.

טוב.

מאד.

רגע, עברו 3 שנים וגוגל בנו רשת עם +100 שכבות.

למה החבר'ה של AlexNet לא עשו ככה?

כמה כבר התחזקו המחשבים ב3 שנים?!

או! >>

17. זה לא כוח מחשוב.

היינו צריכים עוד מהפכה כדי להצליח לאמן רשתות עמוקות מאד.

עליה נדבר בשרשור הבא :))

<מוזיקת סיום>

נהנתי ממש לעשות מחקר היסטורי.

להבין תהליכי המצאה נותן המון השראה, וכשיגיע ההיסטוריון לכתוב את "ההיסטוריה של הAI", זה בהחלט מועמד לסיפור בדרגת יציאת מצרים. >>

היינו צריכים עוד מהפכה כדי להצליח לאמן רשתות עמוקות מאד.

עליה נדבר בשרשור הבא :))

<מוזיקת סיום>

נהנתי ממש לעשות מחקר היסטורי.

להבין תהליכי המצאה נותן המון השראה, וכשיגיע ההיסטוריון לכתוב את "ההיסטוריה של הAI", זה בהחלט מועמד לסיפור בדרגת יציאת מצרים. >>

18. וזהו!

מה דעתכם?

מעניינת אתכם ההיסטוריה של הAI?

ולמי שבוגר כל שאר השרשורים שלי, מרגישים שהצלחתם ליישם פה את ה"חומר הנלמד"?

ספרו לי בתגובות, אני נהנה לכתוב על הכל והדעות שלהם מכווינות אותי למה מעניין אתכם יותר.

מה דעתכם?

מעניינת אתכם ההיסטוריה של הAI?

ולמי שבוגר כל שאר השרשורים שלי, מרגישים שהצלחתם ליישם פה את ה"חומר הנלמד"?

ספרו לי בתגובות, אני נהנה לכתוב על הכל והדעות שלהם מכווינות אותי למה מעניין אתכם יותר.

אם זו פעם ראשונה שלכם אצלי, היי!

מוזמנים לחקור איתי את הקישקע של הAI,

כל פעם קצת אחרת.

זה הזמן לעקוב אחרי:

twitter.com/tsoofbaror

אהבתם?

התמורה הכי טובה היא ריטווט הציוץ הראשון.

לא רוצים לפספס כלום?

בואו לערוץ הטלגרם שלי (כבר מעל 300 איש!)

קבלו עדכון לכל תוכן חדש.

הלינק בביו.

מוזמנים לחקור איתי את הקישקע של הAI,

כל פעם קצת אחרת.

זה הזמן לעקוב אחרי:

twitter.com/tsoofbaror

אהבתם?

התמורה הכי טובה היא ריטווט הציוץ הראשון.

לא רוצים לפספס כלום?

בואו לערוץ הטלגרם שלי (כבר מעל 300 איש!)

קבלו עדכון לכל תוכן חדש.

הלינק בביו.

• • •

Missing some Tweet in this thread? You can try to

force a refresh

Read on Twitter

Read on Twitter