gist.github.com/voidlizard/c28…

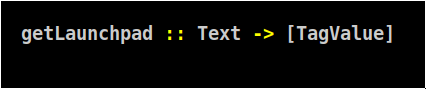

Удобнее оперировать с потоком токенов, да еще и проматывать его, но мы пока не знаем какое разбиение будет подходить для экстракции каждого атома

gist.github.com/voidlizard/575…

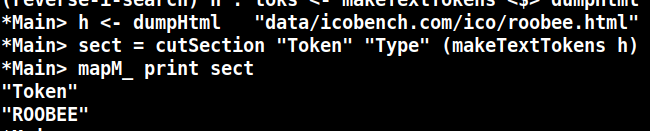

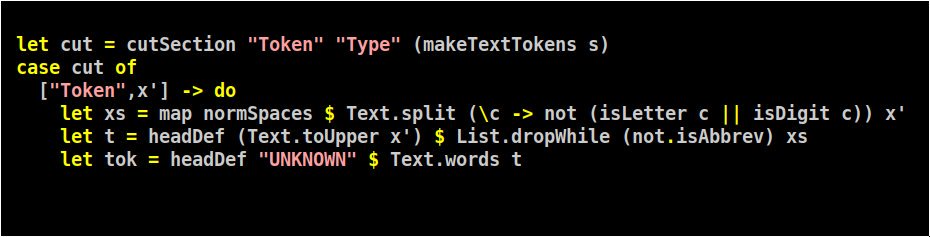

Для начала: найдем название проекта и его тикер (symbol). Symbol в моей задаче вообще и есть ключ сущности, по которому атомы будут собираться. Как и положено в анализе мусора - он неуникальный!

gist.github.com/voidlizard/efb…

gist.github.com/voidlizard/03e…

gist.github.com/voidlizard/359…

gist.github.com/voidlizard/4d9…