#統計 新刊の大塚淳著『統計学を哲学する』を近所の本屋で買って来ました。まだp.91にしか目を通していないのですが、

【データに基づく信念の改定というベイズ流の考え方】

とか

【ベイズ統計~ベイズ主義では確率は主観的な信念の度合いを測るもの】

と書いてあった!これはひどいと思いました。

【データに基づく信念の改定というベイズ流の考え方】

とか

【ベイズ統計~ベイズ主義では確率は主観的な信念の度合いを測るもの】

と書いてあった!これはひどいと思いました。

https://twitter.com/genkuroki/status/1321850930745155587

#統計 現実の統計分析や機械学習でベイズ統計の技術が「データに基づく信念の改定」としては普通使われていません。

数学的モデルとしての確率分布は使われていますが、モデル内における確率をわざわざ「主観的な信念の度合い」などと解釈したりしません。続く

数学的モデルとしての確率分布は使われていますが、モデル内における確率をわざわざ「主観的な信念の度合い」などと解釈したりしません。続く

#統計 去年の12月に出版された浜田宏他著『社会科学のための ベイズ統計モデリング』という本を見れば、社会科学の分野においても理解度の高い人たちにとって、ベイズ統計はすでに「主観確率」の「ベイズ主義」によるものではなくなっていることが分かります。続く

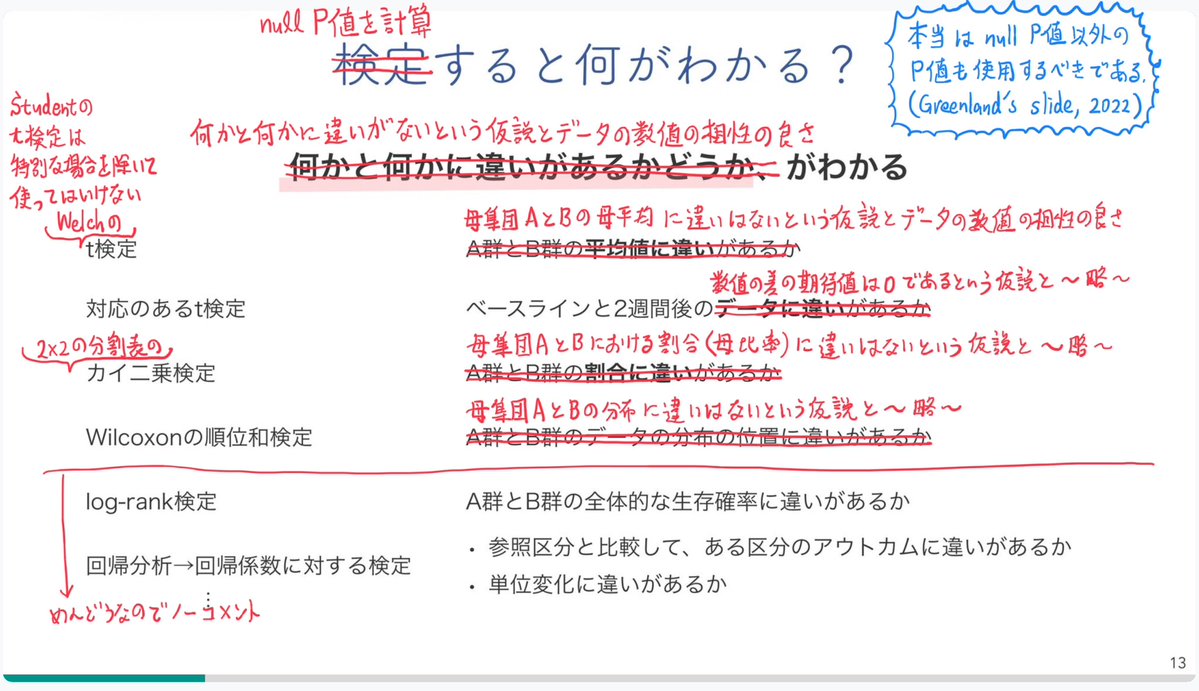

#統計 さらに、大学でのベイズ統計のある講義では添付画像のように、「主観確率」による「ベイズ主義」によるベイズ統計は廃されており、ベイズ統計は「数学で推測が当たる道を作る」方法の1つに過ぎないという扱いになっています。

watanabe-www.math.dis.titech.ac.jp/users/swatanab…

「主義」 を心配するみなさまに

渡辺澄夫

watanabe-www.math.dis.titech.ac.jp/users/swatanab…

「主義」 を心配するみなさまに

渡辺澄夫

https://twitter.com/genkuroki/status/1319504256785772544

#統計 そして、Stanなどでベイズ統計の実践をすでにやったことのある人達は、ベイズ統計を使っていても「データによって信念を改定した」などとは思っていないはずです。

「主観確率」の「ベイズ主義」に基づくベイズ統計の解釈は実践レベルではとっくの昔に終わっているのです。続く

「主観確率」の「ベイズ主義」に基づくベイズ統計の解釈は実践レベルではとっくの昔に終わっているのです。続く

#統計 ところが、大塚淳氏曰く

【この本は何を目指しているのか。その目論見を一言で表すとしたら、「データサイエンティストのための哲学入門、かつ哲学者のためのデータサイエンス入門」である。】

それならば、「主観確率」の「ベイズ主義」をきちんとゴミ箱に捨ててからそうするべきでした。

【この本は何を目指しているのか。その目論見を一言で表すとしたら、「データサイエンティストのための哲学入門、かつ哲学者のためのデータサイエンス入門」である。】

それならば、「主観確率」の「ベイズ主義」をきちんとゴミ箱に捨ててからそうするべきでした。

#統計 p.91を見た私の第一印象は最悪に近いというのは変えようがない事実。

しかし、以上のコメントはp.91にしか目を通していない段階でのコメントなので、後で撤回して、別のコメントをするかもしれません。

重要な訂正がある場合にはこのスレッド内で行います。

しかし、以上のコメントはp.91にしか目を通していない段階でのコメントなので、後で撤回して、別のコメントをするかもしれません。

重要な訂正がある場合にはこのスレッド内で行います。

#統計 検索するとこの本をすでに購入した人たちが沢山いるようですが、まだ誰も「主観確率のベイズ主義に基づく統計学」=「ベイズ統計」という見方に対する否定的なコメントは出ていないと思う。(見逃していたらごめんなさい。)

いち早く本を買った人はそういうコメントを出すべきだったと思う。

いち早く本を買った人はそういうコメントを出すべきだったと思う。

#統計 「データサイエンス」とか言いながら、ベイズ統計を「主観確率」の「ベイズ主義」に基いて語っている時点でアウト。

頻度論との関係とは無関係にアウト。

この点について知らなかった読者は気を付けた方がよいと思う。

論外にダメな所はきちんと否定してまともな部分だけを選んで読めばよい。

頻度論との関係とは無関係にアウト。

この点について知らなかった読者は気を付けた方がよいと思う。

論外にダメな所はきちんと否定してまともな部分だけを選んで読めばよい。

#統計 数学が絡む話題ではどうしても理解度に大きな差が出てしまいます。

『社会科学のためのベイズ統計モデリング』の著者の浜田さんのように数学的理解力に秀でているおかげで、「主観確率」だとか「ベイズ主義」の類に頼らずにベイズ統計を理解してしまう人達に見習うことは多いと思います。

『社会科学のためのベイズ統計モデリング』の著者の浜田さんのように数学的理解力に秀でているおかげで、「主観確率」だとか「ベイズ主義」の類に頼らずにベイズ統計を理解してしまう人達に見習うことは多いと思います。

#統計 おお!著者まで伝わった!

古典統計や頻度主義といった話題との関係とは無関係に、この21世紀に「主観確率」の「ベイズ主義」でベイズ統計について語るのはまずいです。

古典統計や頻度主義といった話題との関係とは無関係に、この21世紀に「主観確率」の「ベイズ主義」でベイズ統計について語るのはまずいです。

https://twitter.com/junotk_jp/status/1322506819827195904

#統計 数式の書き方へのコメント

p.13の下から6行目以降の数式では

n

Σ

i=1

の意味で

n

Σ

i

と"=1"が略されて書かれている。

一般に数学が苦手な読者にも読んでもらいたい場合には、この手の略記はかなりのリスク要因になります。

p.13の下から6行目以降の数式では

n

Σ

i=1

の意味で

n

Σ

i

と"=1"が略されて書かれている。

一般に数学が苦手な読者にも読んでもらいたい場合には、この手の略記はかなりのリスク要因になります。

#統計 この本での「確率モデル」という用語の使い方は、読者を混乱させる可能性があると思ったので、1ツイートで収まらないコメントをします。

一般の読者には非常に申し訳ないのですが、数学用語を断り無しで使います。

最後の方で数学を知らなくてもよい話もする予定。続く

一般の読者には非常に申し訳ないのですが、数学用語を断り無しで使います。

最後の方で数学を知らなくてもよい話もする予定。続く

#統計 まずは細かい誤植の指摘

p.23の下から3行目に

【R2 ある部分集合A∈Ωが事象なら~】

と書いてあるが、この "∈" の使い方は誤りです。A⊂Ω と書くべきでした。

もしくは、σ-algebraにも例えば𝓕のような記号を割り振って、A∈𝓕と書けばよかった。続く

p.23の下から3行目に

【R2 ある部分集合A∈Ωが事象なら~】

と書いてあるが、この "∈" の使い方は誤りです。A⊂Ω と書くべきでした。

もしくは、σ-algebraにも例えば𝓕のような記号を割り振って、A∈𝓕と書けばよかった。続く

#統計 pp.23-25では、σ-algebraや確率測度の定義をして、通常の数学用語では「確率空間」と呼ばれるものについて純粋に数学的に説明しようとしているのですが、なぜかその節に付けられたタイトルが【2-1 確率モデル】になっています。続く

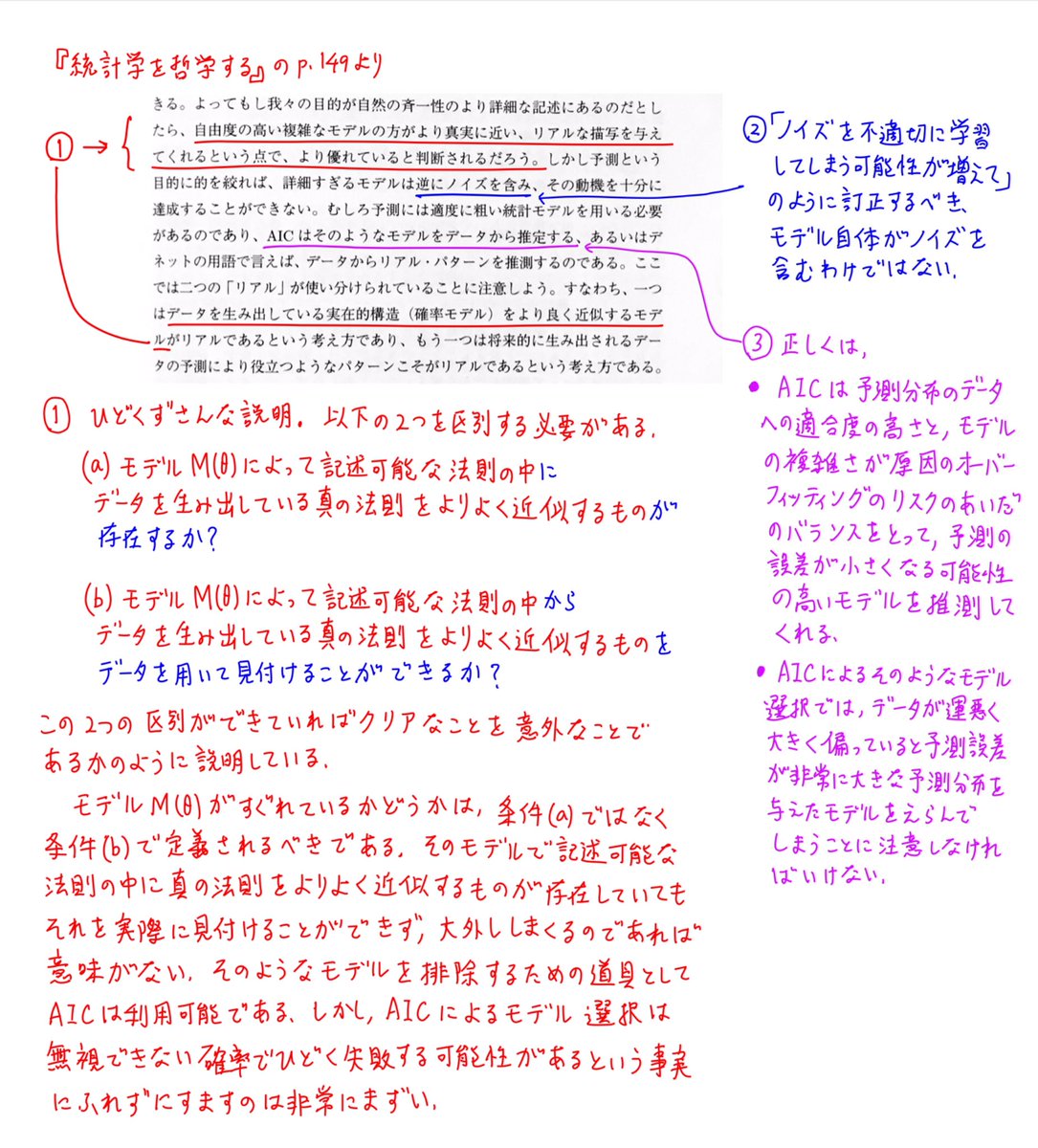

#統計 この本での「確率モデル」という用語の使い方はp.21の脚注1で説明されています(添付画像)。

データの背後に確率法則を想定することと、純粋に数学的に確率空間を考えることは概念的に異なる。

哲学の話をしたいなら、そういう概念的な違いについて繊細な態度を取って欲しかったです。続く

データの背後に確率法則を想定することと、純粋に数学的に確率空間を考えることは概念的に異なる。

哲学の話をしたいなら、そういう概念的な違いについて繊細な態度を取って欲しかったです。続く

#統計 あと、数学的に真面目に確率空間及び関連の概念について説明すると、読者が数学の難しさに負けて、何か深いことを言っているかのように誤解する可能性があります。続く

#統計 ツイッターで繰り返し述べているように、測度論的な確率概念の定式化は、「確率とは何か」のような問題を避けて、0以上で総和が1になる「確率の数値の表」のみを定式化したに過ぎません。

非自明なのは、確率の数値の表のデータのみから出発して有用な数学的道具が得られることです。

続く

非自明なのは、確率の数値の表のデータのみから出発して有用な数学的道具が得られることです。

続く

#統計 例えば、公平な通常のサイコロの「確率モデル」は確率の数値の表

1 ↦ 1/6

2 ↦ 1/6

3 ↦ 1/6

4 ↦ 1/6

5 ↦ 1/6

6 ↦ 1/6

によって与えられているとしてよい。σ代数は{1,2,3,4,5,6}の部分集合全体の集合で、確率測度PはA⊂{1,2,3,4,5,6}に対してAに含まれる元の確率の総和を対応させる函数。

1 ↦ 1/6

2 ↦ 1/6

3 ↦ 1/6

4 ↦ 1/6

5 ↦ 1/6

6 ↦ 1/6

によって与えられているとしてよい。σ代数は{1,2,3,4,5,6}の部分集合全体の集合で、確率測度PはA⊂{1,2,3,4,5,6}に対してAに含まれる元の確率の総和を対応させる函数。

#統計 sample spaceが無限集合の場合や、σ-algebraがsample spaceの冪集合でない場合への一般化を素直に行えば、一般的な確率空間の概念ができあがります。続く

#統計 上のサイコロの例から、一般の確率空間に飛ぶのは不親切で、「確率の数値の表」の連続版である確率密度函数についても説明しておいた方が親切でしょう。続く

#統計 数学が苦手な人は、確率空間を与えることは、「確率とは何か」という問題を避けて、単に確率の数値の表(もしくはその連続版の確率密度函数)を与えることに過ぎない、と了解しておけば、変な誤解を防げると思います。

あと、上でのサイコロの例のように具体例を必ず考えておくことも大事。続く

あと、上でのサイコロの例のように具体例を必ず考えておくことも大事。続く

#統計 現実に得られるデータが何らかの確率法則で生成されていると想定することを、確率空間の概念を用いて定式化することは、確率法則を生み出す仕組みには一歳触れずに、「確率の数値の表」(もしくは同類のものの一般化)のみによって定式化することだと思っておけばよいと思います。

#統計 確率空間(単なる「確率の数値の表」の一般化)を考えることと、データの背後にデータを生成した未知の法則を想定することは全然違う話なので、その辺を明瞭に区別するように読者は注意するべきだと思います。

特に数学が得意じゃない人はその点に気をつけるべきです。

特に数学が得意じゃない人はその点に気をつけるべきです。

#統計 以上において、重要なポイントは「データを生成した未知の法則」という言い方の「未知の」の部分です。

「データを生成した未知の確率法則」を「確率の数値の表」で定式化する場合には、「その数値の表は未知である」と想定する必要があります。

この点もこの本を読むときには要注意な点です。

「データを生成した未知の確率法則」を「確率の数値の表」で定式化する場合には、「その数値の表は未知である」と想定する必要があります。

この点もこの本を読むときには要注意な点です。

#統計 以上、長くなってしまいましたが、ツイッターでは繰り返し述べていることを、ここでも繰り返しただけです。

「また、あの話かよ!」と思った人には、ごめんなさい。

他人が書いた本にコメントするふりをして、自分が言いたいことを言うスタイル(笑)

「また、あの話かよ!」と思った人には、ごめんなさい。

他人が書いた本にコメントするふりをして、自分が言いたいことを言うスタイル(笑)

全然先に進まない。

このスレッドの長さは数百オーダーになる予感。

このスレッドの長さは数百オーダーになる予感。

#統計 記号の使い方についての注意

p.27以降ではX,Yをそれぞれ身長と年齢を表す確率変数としています。

一方、p.14では、n人の学生の身長と年齢の標本共分散を Cov(X, Y) と書いています。

読者は、確率変数X,Yの共分散とp.14での標本共分散を混同しないように注意が必要です。続き

p.27以降ではX,Yをそれぞれ身長と年齢を表す確率変数としています。

一方、p.14では、n人の学生の身長と年齢の標本共分散を Cov(X, Y) と書いています。

読者は、確率変数X,Yの共分散とp.14での標本共分散を混同しないように注意が必要です。続き

#統計 統計学の初学者の多くは

①確率変数達の平均や分散や共分散

と

②標本における平均や分散や共分散

を混同します。

確率空間の定義に「標本空間」という用語が出て来ることもこの混乱を増幅していると思う。

そして何よりも解説している側が十分に慎重になり切れていないことが問題。続く

①確率変数達の平均や分散や共分散

と

②標本における平均や分散や共分散

を混同します。

確率空間の定義に「標本空間」という用語が出て来ることもこの混乱を増幅していると思う。

そして何よりも解説している側が十分に慎重になり切れていないことが問題。続く

#統計 「その辺についても分かり易い教科書をお前が書け!」とか言われたりするのは結構悪夢かも(笑)

統計学は色々ややこしいので、致命的にひどい説明をせずにすべてを切り抜けることができると想定することは私には不可能。

統計学は色々ややこしいので、致命的にひどい説明をせずにすべてを切り抜けることができると想定することは私には不可能。

#統計 例えば、S市の中学1年生男子の身長について統計分析したいとします。

想定①

S市の中学1年生男子達の身長はすべて確定した数値であると想定し、n人の無作為抽出で身長のデータを得る、という設定を考えるときには、S市の中学1年生男子達全員分の身長の数値は確定しているが未知であり~続く

想定①

S市の中学1年生男子達の身長はすべて確定した数値であると想定し、n人の無作為抽出で身長のデータを得る、という設定を考えるときには、S市の中学1年生男子達全員分の身長の数値は確定しているが未知であり~続く

#統計

想定②

S市の中学1年生男子各々の身長が何らかの未知の確率法則によってランダムに決まっていると考えることもできます。この場合には、連続的な未知の確率分布を数学的に想定して、S市の中学1年生男子全員分の身長の数値はその確率分布のサイズNのサンプルになっているのように考える。

想定②

S市の中学1年生男子各々の身長が何らかの未知の確率法則によってランダムに決まっていると考えることもできます。この場合には、連続的な未知の確率分布を数学的に想定して、S市の中学1年生男子全員分の身長の数値はその確率分布のサイズNのサンプルになっているのように考える。

#統計 以上の想定①と②では、未知の確率法則の数学的定式化が違っています。さらに別の想定を考えることもできます。(そして、以上の説明で曖昧にすませた部分のギャップを埋めることもできる(笑))

データが未知の確率法則で生成されているという想定自体に無数の可能性がある点にも気をつけるべき。

データが未知の確率法則で生成されているという想定自体に無数の可能性がある点にも気をつけるべき。

#統計 p.31にも非常にまずそうな説明の仕方を発見!

さすがに【確率変数が持つ分布を特徴付ける値を、その期待値~という】という言い方は非常にまずい。

確率変数Xの分布はその函数の期待値𝔼(f(X))の全体で特徴付けられる、なら意味が通っていた。

続く

さすがに【確率変数が持つ分布を特徴付ける値を、その期待値~という】という言い方は非常にまずい。

確率変数Xの分布はその函数の期待値𝔼(f(X))の全体で特徴付けられる、なら意味が通っていた。

続く

#統計 続き。一般に、母平均μ=𝔼(X)や母分散𝔼((X-μ)²)のような有限個の値で確率変数Xの分布は一意に特徴付けられないという点も徹底的に強調するべき重要なポイントです。

なぜならば統計学入門の教科書におけるパラメトリック統計の説明がその点に無頓着である場合が多いからです。

なぜならば統計学入門の教科書におけるパラメトリック統計の説明がその点に無頓着である場合が多いからです。

#統計 p.31での期待値に関する非常にまずい説明の仕方の直後のp.31の終わりに2行からその次のページ(添付画像)にかけて、上で私も説明した重要なことが説明されています。

データを生成した未知の確率法則を想定するときの確率法則は未知であるという当たり前の話がやっとここで説明されている。

データを生成した未知の確率法則を想定するときの確率法則は未知であるという当たり前の話がやっとここで説明されている。

#統計 この本は説明のまずい点のギャップを埋めずにまともに理解することは不可能な本だと私は思いました。自分で訂正してギャップを埋めて読む人向けの本でしょう。(そういう本は数学の本では結構あります。)

#統計 説明の仕方にまずいところはあっても、この本の著者と私の間では「統計学入門の教科書の解説がひどい」という意見では一致する可能性もあるのではないかと、以上で紹介した部分を見て思いました。

「主観確率」の「ベイズ主義」でベイズ統計について語っている部分が残念です。

「主観確率」の「ベイズ主義」でベイズ統計について語っている部分が残念です。

#統計 2-2-3節では「データの生成のされ方を未知の分布に従うの独立同分布確率変数列で定式化する」という数学的な扱いが易しくなる設定について説明している。

実践的な統計分析ではそれですまない場合が多いので、私なら「簡単のため」の仮定だと言ってしまいます。続く

実践的な統計分析ではそれですまない場合が多いので、私なら「簡単のため」の仮定だと言ってしまいます。続く

続き。脱線。

「簡単のために」という言い方を「我々」はよくするのですが、多くの人がその言い方に違和感を感じて文句を言っている、という面白い話があります。検索すると結構楽しめると思います。

脱線終わり。続く

「簡単のために」という言い方を「我々」はよくするのですが、多くの人がその言い方に違和感を感じて文句を言っている、という面白い話があります。検索すると結構楽しめると思います。

脱線終わり。続く

#統計 本当は、【ヒュームが「自然の斉一性」と呼んだもの】の具体的な内容を独立同分布確率変数列(私は大文字で書くのは嫌いでi.i.d.と略す)のような狭い枠組みに押し込めることが、正しい考え方であるかどうかは、議論があって然るべき点です。

だから私は「簡単のために」と言いたくなる(笑)。

だから私は「簡単のために」と言いたくなる(笑)。

#統計 pp.33-35の2-2-4のポイントは(適当なゆるい条件を満たす)未知の分布に従う長さnの独立同分布確率変数列X_1,…,X_nについては、分布が未知のままであっても、標本平均(←これも確率変数になる)の分布のn→∞での様子について普遍的な数学的法則があることです。

#統計 未知の確率法則を未知だとみなしたままであっても使える普遍的な数学的定理があることが重要。

そういう数学的定理のお陰で、未知の確率法則でデータが生成されているという想定のもとでの、統計的推論・推測・推定が可能になる。

この部分は哲学用語の味付け無しに理解しておくべき部分です。

そういう数学的定理のお陰で、未知の確率法則でデータが生成されているという想定のもとでの、統計的推論・推測・推定が可能になる。

この部分は哲学用語の味付け無しに理解しておくべき部分です。

#統計 もちろん、数学的想定から数学的議論で何が可能であるかをクリアに理解した後に、それを哲学的な味付けのもとで合理的に解釈する自由はあります。

しかし、最初は身もふたもないほどクリアな議論で理解しておくべき重要な事柄。

しかし、最初は身もふたもないほどクリアな議論で理解しておくべき重要な事柄。

#統計 pp.35-37での「統計モデル」の説明にコメントする前に、私が繰り返し述べて来た事柄について説明します。続く

(pp.35-37の意味での「統計モデル」はみんなが「統計モデリング」と言う場合の統計モデルとほぼ同じ意味だと思って構いません。この点は「確率モデル」という用語法のまずさとは違う)

(pp.35-37の意味での「統計モデル」はみんなが「統計モデリング」と言う場合の統計モデルとほぼ同じ意味だと思って構いません。この点は「確率モデル」という用語法のまずさとは違う)

#統計 簡単のために(笑)、データは未知の分布q(x)(←確率密度函数)に従う長さnの独立同分布確率変数列として生成されていると想定している場合を考える。

そのときデータ(=長さnの独立同分布確率変数列)の確率密度函数は

q(x_1)…q(x_n)

になり、これがデータの未知の生成法則の定式化になる。続く

そのときデータ(=長さnの独立同分布確率変数列)の確率密度函数は

q(x_1)…q(x_n)

になり、これがデータの未知の生成法則の定式化になる。続く

#統計 我々は、そのデータの未知の生成法則を推測したい。

その目的のために、分析用のモデルとして既知の確率分布を使って書けるパラメータw付きの確率分布

p(x_1,…,x_n|w)

を用意して使う方法がよく使われています。続く

その目的のために、分析用のモデルとして既知の確率分布を使って書けるパラメータw付きの確率分布

p(x_1,…,x_n|w)

を用意して使う方法がよく使われています。続く

#統計 想定しているデータの未知の生成法則の確率密度函数は

q(x_1)…q(x_n)

の形(i.i.d.を与える)だが、分析用のモデルの確率密度函数をそれよりも一般的な

p(x_1,…,x_n|w)

の形にしたことは、ベイズ統計の理解では決定的に重要!続く

q(x_1)…q(x_n)

の形(i.i.d.を与える)だが、分析用のモデルの確率密度函数をそれよりも一般的な

p(x_1,…,x_n|w)

の形にしたことは、ベイズ統計の理解では決定的に重要!続く

#統計 続き。なぜならば、ベイズ統計では、パラメータw付きの確率密度函数p(x|w)とパラメータwの確率密度函数φ(w)を具体的に与えて、分析用のモデルの確率密度函数を

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

の形で与えることが多いからです(簡単のためハイパーパラメータ無しの場合にしてある)。

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

の形で与えることが多いからです(簡単のためハイパーパラメータ無しの場合にしてある)。

#統計 分析用のモデル

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

はもはや、想定していたデータの未知の生成法則

q(x_1)…q(x_n)

とは違って、i.i.d.の確率密度函数にはなっていません。

それにも関わらず数学的に良い性質のお陰でベイズ統計は役に立つことが知られているわけです。続く

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

はもはや、想定していたデータの未知の生成法則

q(x_1)…q(x_n)

とは違って、i.i.d.の確率密度函数にはなっていません。

それにも関わらず数学的に良い性質のお陰でベイズ統計は役に立つことが知られているわけです。続く

#統計 ベイズ統計をまともに理解するためには、想定しているデータの未知の生成法則とは異なる型のモデルを用いることにも数学的合理性があることを数学的に理解する必要があります。

その点を「主観確率」や「ベイズ主義」と言った用語の使用で何とかしようとするとシンプルにアウトになります。続く

その点を「主観確率」や「ベイズ主義」と言った用語の使用で何とかしようとするとシンプルにアウトになります。続く

#統計 ベイズ統計における分析用のモデル内における仮想的なデータ生成法則の密度函数

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

におけるパラメータwの確率分布φ(w)はよく事前分布(prior)と呼ばれているものです。役に立てば何でもよくて、主観の表現だと解釈する必要は全くない。続く

p(x_1,…,x_n) = ∫p(x_1|w)…p(x_w)φ(w)dw

におけるパラメータwの確率分布φ(w)はよく事前分布(prior)と呼ばれているものです。役に立てば何でもよくて、主観の表現だと解釈する必要は全くない。続く

#統計 q(x)やp(x|w), φ(w)という記号法は、渡辺澄夫著『ベイズ統計の理論と方法』の記号法をそのまま流用しています。

現時点では、i.i.d.の想定でのベイズ統計の設定について、最もクリアに書かれている教科書なので、是非とも参照して欲しいと思います。

現時点では、i.i.d.の想定でのベイズ統計の設定について、最もクリアに書かれている教科書なので、是非とも参照して欲しいと思います。

#統計 添付画像に「統計モデル」に関するp.36の説明を引用しておきます。

この部分の説明は結構良いと思いました。

しかし、統計モデルを「確率モデルにさらなる仮定を加え」たものだと説明しているのは、2つの意味で誤解を招きかねないと思いました。続く

この部分の説明は結構良いと思いました。

しかし、統計モデルを「確率モデルにさらなる仮定を加え」たものだと説明しているのは、2つの意味で誤解を招きかねないと思いました。続く

#統計 1つ目は「確率モデル」という用語法が悪過ぎて、読者が誤解する可能性が高いように思えることです。「確率モデル」と「統計モデル」を区別させるのは苦しい。

略してサボらずに、「データを生成していると想定している未知の確率法則の数学的定式化」のように長くしつこく言えば良いと思う。

略してサボらずに、「データを生成していると想定している未知の確率法則の数学的定式化」のように長くしつこく言えば良いと思う。

#統計 2つ目。「確率モデル」=「データを生成している未知の確率法則に関する想定」にさらに仮定を加えたものを「統計モデル」と呼ぶ方針だと、データを生成している未知の確率法則に関する想定における密度函数

q(x_1)…q(x_n)

と統計モデル内におけるデータ生成法則の密度函数が同じ形で~続く

q(x_1)…q(x_n)

と統計モデル内におけるデータ生成法則の密度函数が同じ形で~続く

#統計 続き~、

p(x_1|w)…p(x_n|w)

の形をしていなければいけないかのようになってしまいます。ここでq(x)は未知の確率密度函数で、p(x|w)はパラメータwを持つ既知の確率密度函数です。

このように制限するとベイズ統計の方法が排除されてしまいます。

p(x_1|w)…p(x_n|w)

の形をしていなければいけないかのようになってしまいます。ここでq(x)は未知の確率密度函数で、p(x|w)はパラメータwを持つ既知の確率密度函数です。

このように制限するとベイズ統計の方法が排除されてしまいます。

#統計 想定しているデータの生成法則(未知)には、原理的に決して一致することがないモデル(既知の確率分布で記述)を統計分析用に用いるというアイデアは非常に重要です。

#統計 事前分布の使用はそのアイデアの特殊な場合だし、ベイズ統計の技術を使って、

実際には値が確定していたが値の記録が残らなかったと想定している数値が分析用のモデル内部では確率分布していると考える

という方針もアイデアの特別な場合とみなせます。

実際には値が確定していたが値の記録が残らなかったと想定している数値が分析用のモデル内部では確率分布していると考える

という方針もアイデアの特別な場合とみなせます。

#統計 現実に使われている統計学の技術について、クリアな解説を書きたければ、役に立つ統計分析用のモデルは、データを生成していると想定している未知の確率法則にさらに仮定を付け加えてできるものだけではない、と最初から強調しておく必要があります。

#統計 p.30には、確率と確率密度の使い分けにあまり拘らずに

【両者をともに「確率」と統一的に呼ぶことにし、P(X=x)はXが離散の場合は値xの確率、連続の場合はその確率密度を表すことにする】

と書いてあるが、そういう手抜きは読者のためには、やめた方がよかった。pp.38-41を見てそう思った。

【両者をともに「確率」と統一的に呼ぶことにし、P(X=x)はXが離散の場合は値xの確率、連続の場合はその確率密度を表すことにする】

と書いてあるが、そういう手抜きは読者のためには、やめた方がよかった。pp.38-41を見てそう思った。

#統計 pp.41−42より

データを生成していると想定している未知の分布(本の中では「確率モデル」)における相関係数は母相関係数と呼ぶが、それとは完全に区別するべき統計モデルにおける相関係数はパラメータと呼ぶ方針ではなかったのか?

ここはちょっとひどすぎるかも。

データを生成していると想定している未知の分布(本の中では「確率モデル」)における相関係数は母相関係数と呼ぶが、それとは完全に区別するべき統計モデルにおける相関係数はパラメータと呼ぶ方針ではなかったのか?

ここはちょっとひどすぎるかも。

#統計 もう疲れ切ったので、pp.43-49はとばしてしまおう。

コメントするべき部分があると主張したい人は私が見える場所でコメントしてくれると助かります。

とばすことにすれば、次は【第2章 ベイズ統計】です😊

コメントするべき部分があると主張したい人は私が見える場所でコメントしてくれると助かります。

とばすことにすれば、次は【第2章 ベイズ統計】です😊

#統計 このスレッドに書いていることは、私がいつもしている話そのものなので、過去の発言をツイログで検索すれば、このスレッド内での説明不足の部分を補える可能性があります。

↓

twilog.org/genkuroki

↓

twilog.org/genkuroki

#統計 もしかして、私はp.36の説明を好意的に読み過ぎている?

https://twitter.com/genkuroki/status/1322622922784006144

#統計 p.36の説明は非常の重要だと思ったので、以下のリンク先で引用しました。

https://twitter.com/genkuroki/status/1322608279474720768

#統計 この本をいち早く購入してすでにツイッターに読んだ感想のスレッドを書いている人がいるが、その感想に理解は伴っているのだろうかと思いました。

このスレッドで紹介した部分の説明が雑なことは明らかで、そういう説明でどれだけの読者が正確に理解できたのだろうか?私には理解不能だった。

このスレッドで紹介した部分の説明が雑なことは明らかで、そういう説明でどれだけの読者が正確に理解できたのだろうか?私には理解不能だった。

#統計 多くに学生が統計学入門の教科書を読んで感じる疑問は、

データを取得した母集団の分布は不明のはずなのに、母集団分布が正規分布になっていると仮定してよいのか?

です。正解はダメに決まっているです。続く

データを取得した母集団の分布は不明のはずなのに、母集団分布が正規分布になっていると仮定してよいのか?

です。正解はダメに決まっているです。続く

#統計 続き。データを取得した母集団の分布は不明のままとした上で、分析用のモデルとして正規分布モデルを採用すると考えなければいけない。続く

#統計 続き

①データを生成した未知の法則に関する想定

と

②統計分析用に用いるモデル内の想定

は厳密に区別しないとダメです。

①の想定に新たな仮定を加えたものを②の想定だと考えてしまうと、①と②の区別が曖昧になり、非科学的な考え方になってしまいます。

①データを生成した未知の法則に関する想定

と

②統計分析用に用いるモデル内の想定

は厳密に区別しないとダメです。

①の想定に新たな仮定を加えたものを②の想定だと考えてしまうと、①と②の区別が曖昧になり、非科学的な考え方になってしまいます。

#統計 事前にデータを生成している法則についてよく分かっている場合は違いますが、そうではない一般的な状況においては「データを生成した確率法則は正規分布になっている」とすることには根拠がなさすぎになります。続く

#統計 それに対して、正規分布モデルの妥当性について根拠がないことを知りながら、試しに正規分布モデルを使った推測結果を計算してみるという行為には合理性があります。

推測結果を発表するときにも、正規分布モデルが妥当だという根拠はないと正直に言わなければいけない。続く

推測結果を発表するときにも、正規分布モデルが妥当だという根拠はないと正直に言わなければいけない。続く

#統計 続き。さらに、想定している未知の法則が正規分布からずれていても、分布の近似に関する数学的な根拠によって、正規分布モデルによる推測の誤差が実用的に十分な範囲内に収まる可能性が高いならば、そういうこともしっかり説明しておくべきでしょう。

#統計 続き。実際にコンピュータで数値実験してみると、中心極限定理が効けば誤差が小さくなるような仕組みの推定においては、推定先の未知の分布が正規分布から大きく離れていなければ誤差は小さくなります。

#統計 しかし、推定先の未知の分布が、左右対称形でないせいで、正規分布から大きく離れている場合には、中心極限定理が来にくくなって誤差が許容範囲を超えてしまうことになります。

#統計 各分野の専門家であれば、分野固有の専門知識と以上で述べたような数学の知識を使えば、正規分布モデルを用いた分析の誤差がどういう感じになりそうか大体分かる場合もあると思われます。

誤差が小さくなる公算が高ければ正規分布モデルの使用は科学的に十分合理的だと分かるわけです。

誤差が小さくなる公算が高ければ正規分布モデルの使用は科学的に十分合理的だと分かるわけです。

#統計 以上のストーリーでは、「データを生成したと想定している未知の分布が正規分布からずれていたときに、正規分布モデルによる統計分析の結果の誤差がどうなるか?」と考えることができたので、科学的な合理性を保つことができました。

#統計 しかし、正規分布の統計モデルを考えることが「データを生成していると想定している未知の分布は正規分布になっていると仮定すること」ならば、以上のストーリーは最初から起こり得ず、科学的に真っ当な分析への道は閉ざされてしまうことになります。

#統計 以前にも述べたように、以上で述べたような事柄について統計学入門における正規分布の仮定はお寒いものになっています。(具体例として東京大学教養学部統計学教室編『統計学入門』を取り上げた。)

#統計 上のストーリーを一般化を、渡辺澄夫著『ベイズ統計の理論と方法』の記号と用語を使って説明すると、勝手に真の分布q(x)がモデルp(x|w)によってぴったりq(x)=p(x|w₀)の形で書ける(実現可能)と仮定してはいけない、ということ。モデルで真の分布がぴったり実現可能でない場合も考慮するべき。

#統計 一般読者のための資料

データ(サイズnのサンプル)を生成した分布が分析用のモデルで実現できない場合のフィッティングの様子

ソースコード↓

nbviewer.jupyter.org/github/genkuro…

データはガンマ分布で生成

正規分布モデルでフィッティング

データ(サイズnのサンプル)を生成した分布が分析用のモデルで実現できない場合のフィッティングの様子

ソースコード↓

nbviewer.jupyter.org/github/genkuro…

データはガンマ分布で生成

正規分布モデルでフィッティング

#統計

正規分布モデルによるフィッティングは標本平均と標本分散の計算と実質的に同じ。

Laplace分布モデルによるフィッティングは標本の中央値の計算を含む。

標本の代表値の計算は統計モデルと関係有り。

nbviewer.jupyter.org/github/genkuro…

データはガンマ分布で生成

Laplace分布モデルでフィッティング

正規分布モデルによるフィッティングは標本平均と標本分散の計算と実質的に同じ。

Laplace分布モデルによるフィッティングは標本の中央値の計算を含む。

標本の代表値の計算は統計モデルと関係有り。

nbviewer.jupyter.org/github/genkuro…

データはガンマ分布で生成

Laplace分布モデルでフィッティング

#統計

動画の右半分は尤度函数のヒートマップです。

nbviewer.jupyter.org/github/genkuro…

データは2つ山の混合ガンマ分布で生成

単なるガンマ分布モデルでフィッティング

動画の右半分は尤度函数のヒートマップです。

nbviewer.jupyter.org/github/genkuro…

データは2つ山の混合ガンマ分布で生成

単なるガンマ分布モデルでフィッティング

#統計 以上で用いた統計モデルは指数型分布族なので、特に常に正則モデルになります。サンプルサイズnを大きくしていくと、尤度函数の形は多変量正規分布に近付き、尤度函数の台もどんどん小さくなって行く。

こういうことは正則モデルでは普遍的に起こる。

これが最尤法の数学的基礎です。

こういうことは正則モデルでは普遍的に起こる。

これが最尤法の数学的基礎です。

#統計 より実践的な例。添付画像は論文

pubmed.ncbi.nlm.nih.gov/32046819/

での新型コロナの潜伏期間の推定を同じ方法で行なってプロットした予測分布。論文にはないグラフ。

3種類のモデルを試している。私がWAICを計算したら値に大きな違いはなく、優劣は付けられなかった。

nbviewer.jupyter.org/gist/genkuroki…

pubmed.ncbi.nlm.nih.gov/32046819/

での新型コロナの潜伏期間の推定を同じ方法で行なってプロットした予測分布。論文にはないグラフ。

3種類のモデルを試している。私がWAICを計算したら値に大きな違いはなく、優劣は付けられなかった。

nbviewer.jupyter.org/gist/genkuroki…

#統計 実践的な統計分析では、データを生成していると想定している法則をモデルがほぼぴったり実現しているとは仮定できそうもない場合が多い。

分析用のモデルを複数種類試してみるなどの方法で、推測結果がモデルの詳細に大きく依存し過ぎないことやどのモデルがもっともらしいかの確認が必要。

分析用のモデルを複数種類試してみるなどの方法で、推測結果がモデルの詳細に大きく依存し過ぎないことやどのモデルがもっともらしいかの確認が必要。

#統計

東京大学教養学部統計学教室編『統計学入門』

【事前に母集団分布が××分布という形で与えられており、いくつかの定数がわかれば、母集団分布についてすべてを知ることができる場合、それをパラメトリックの場合と呼ぶ】

この説明の仕方は非常にまずい。

東京大学教養学部統計学教室編『統計学入門』

【事前に母集団分布が××分布という形で与えられており、いくつかの定数がわかれば、母集団分布についてすべてを知ることができる場合、それをパラメトリックの場合と呼ぶ】

この説明の仕方は非常にまずい。

https://twitter.com/genkuroki/status/1173150318713921538

#統計 現実の統計分析は「真実は闇の中」になることが多いと思う。

複数のモデルの比較は情報量規準などで一応可能だが、データを生成していると想定している法則がモデルでどの程度近似できているかはよくわからず、分野固有の知識を持っている専門家による精査がないと怖くて使えない感じ。

複数のモデルの比較は情報量規準などで一応可能だが、データを生成していると想定している法則がモデルでどの程度近似できているかはよくわからず、分野固有の知識を持っている専門家による精査がないと怖くて使えない感じ。

#統計 上で紹介した論文の新型コロナの潜伏期間の推定の再現を #Julia言語 のTuring.jlを使って行った結果をツイッターで紹介するときには緊張する。

なぜならば、私は完全など素人であり、責任を持てるような専門知識が皆無だからだ。私が再現した潜伏期間の推定が大外ししている可能性が怖い。

なぜならば、私は完全など素人であり、責任を持てるような専門知識が皆無だからだ。私が再現した潜伏期間の推定が大外ししている可能性が怖い。

#統計 解説:グラフはモデル内での潜伏期間の分布の密度函数のプロットです。

原論文と同様にベイズ統計を使っていますが、「主観確率」の「ベイズ主義」に基くベイズ統計は使っていません(笑)。信念がベイズ更新されたりもしていない(笑)。

原論文と同様にベイズ統計を使っていますが、「主観確率」の「ベイズ主義」に基くベイズ統計は使っていません(笑)。信念がベイズ更新されたりもしていない(笑)。

https://twitter.com/genkuroki/status/1322739668027273216

#統計 以下のリンク先の発言もこのスレッドに収録しておく。

https://twitter.com/genkuroki/status/1322592612876890117

#統計 『統計学を哲学する』のp.31の引用の再掲

私はまだp.42までとp.91にしか目を通していないのだが、その中ではこのページが最もひどい。

この本の著者は「期待値」の標準的な意味を理解していない。

私はまだp.42までとp.91にしか目を通していないのだが、その中ではこのページが最もひどい。

この本の著者は「期待値」の標準的な意味を理解していない。

#統計 真っ当な人がレビューしていてくれれば、p.31のような非常識な説明が生き残る可能性はなかったはず。さすがに

【確率変数が持つ分布を特徴付ける値を、その期待値~という】

という説明はまずすぎる。

せめて「期待値」の標準的な定義を理解してから本を書くべきであった。

【確率変数が持つ分布を特徴付ける値を、その期待値~という】

という説明はまずすぎる。

せめて「期待値」の標準的な定義を理解してから本を書くべきであった。

#統計 この本は大人気のようだが、他人にこの本を勧めるときには、この本に【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)と書いてあることを注意するくらいの親切心があった方がよいと思う。

期待値の普通の定義くらいみんな知っているだろうから、容易に指摘できるはず。

期待値の普通の定義くらいみんな知っているだろうから、容易に指摘できるはず。

#統計 雑談:分布を特徴付ける数値の組は普通パラメータと呼ばれる。

指数型分布族(←例: 正規分布、ガンマ分布、Poisson分布、二項分布など)のパラメータが分布に従う確率変数の具体的な函数の期待値で表されることは面白い話です。

続く

指数型分布族(←例: 正規分布、ガンマ分布、Poisson分布、二項分布など)のパラメータが分布に従う確率変数の具体的な函数の期待値で表されることは面白い話です。

続く

#統計 統計モデリングでビルディングブロックの役目を果たすことが多い指数型分布族の確率分布は統計力学の意味でのカノニカル分布として自然に現れ、カノニカル分布の一般化の仕組みを理解していれば、逆温度の一般化である指数型分布族のパラメータが期待値で特徴付けられることも自然に理解可能。

#統計 i.i.d.の場合のカノニカル分布の理論については、私のノートで結構詳しく解説されています↓

genkuroki.github.io/documents/2016…

Kullback-Leibler 情報量と Sanov の定理

* 大数の法則

* 中心極限定理

* Sanovの定理

は統計学における確率論の「三種の神器」。Sanovの定理は通常解説されていない。

genkuroki.github.io/documents/2016…

Kullback-Leibler 情報量と Sanov の定理

* 大数の法則

* 中心極限定理

* Sanovの定理

は統計学における確率論の「三種の神器」。Sanovの定理は通常解説されていない。

#統計 具体例はコンピュータでかなり容易に作れます。

nbviewer.jupyter.org/gist/genkuroki…

統計力学におけるカノニカル分布の最も簡単な場合 (#Julia言語)

添付動画は X と √X の期待値で特徴付けられる一般化されたカノニカル分布をMCMC法で作る様子の動画。

nbviewer.jupyter.org/gist/genkuroki…

統計力学におけるカノニカル分布の最も簡単な場合 (#Julia言語)

添付動画は X と √X の期待値で特徴付けられる一般化されたカノニカル分布をMCMC法で作る様子の動画。

https://twitter.com/genkuroki/status/1309807302514323456

#統計 正値の確率変数Xについて、Xと√Xの期待値で特徴付けられる一般化されたカノニカルの台はx>0で密度函数は

定数×exp(-ax+b√x)

の形で、ガンマ分布などに似た形の分布になります。パラメータのaとbが逆温度の一般化になっている。

こういう話は非常に面白いです。

定数×exp(-ax+b√x)

の形で、ガンマ分布などに似た形の分布になります。パラメータのaとbが逆温度の一般化になっている。

こういう話は非常に面白いです。

#統計 この本には【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)などと書かれていると指摘しても、本を購入していない人にとってはどうでもよいくだらない話にしか聞こえないだろうと予想して、くだらなくない真に面白い話を雑談として紹介しているつもり。

#統計 添付動画は一般化されたカノニカル分布としてのガンマ分布の実現の様子です。正値確率変数Xに関するXとlog(X)の期待値でガンマ分布は特徴付けられます。

ガンマ分布のパラメータの推定値はサンプルの相加平均と相乗平均から得られます。続く

nbviewer.jupyter.org/gist/genkuroki…

ガンマ分布のパラメータの推定値はサンプルの相加平均と相乗平均から得られます。続く

nbviewer.jupyter.org/gist/genkuroki…

#統計 サンプルX_1,…,X_nの相加平均は通常の標本平均で、相乗平均の対数は

log(X_1…X_n)^{1/n} = (log(X_1)+…+log(X_n))/n

とサンプルの対数平均になります。これのn→∞での極限は大数の法則よりlog(X)の期待値なる。

相加・相乗平均が出て来ることはガンマ分布の基本的な特徴です。続く

log(X_1…X_n)^{1/n} = (log(X_1)+…+log(X_n))/n

とサンプルの対数平均になります。これのn→∞での極限は大数の法則よりlog(X)の期待値なる。

相加・相乗平均が出て来ることはガンマ分布の基本的な特徴です。続く

#統計 ガンマ分布の台はx>0で密度函数は

定数×exp(-ax+b log(x))

の形で、a,bが逆温度の一般化のパラメータで、xとlog(x)の期待値でパラメータが特徴付けられます。

ガンマ分布におけるlog(x)の期待値は本質的にディガンマ函数で、コンピュータで容易に計算できる基本特殊函数の1つになっています。

定数×exp(-ax+b log(x))

の形で、a,bが逆温度の一般化のパラメータで、xとlog(x)の期待値でパラメータが特徴付けられます。

ガンマ分布におけるlog(x)の期待値は本質的にディガンマ函数で、コンピュータで容易に計算できる基本特殊函数の1つになっています。

#統計 正規分布の密度函数は

定数×exp(-ax²+bx)

の形でX²とXの期待値でパラメータa,bが特徴付けられます。

一般に一般化されたカノニカル分布=指数型分布族の密度函数は

定数×exp(-Σ_i a_i f_i(x))q(x)

の形でパラメータa_i達は𝔼[f_i(X)]達で特徴付けられる。

定数×exp(-ax²+bx)

の形でX²とXの期待値でパラメータa,bが特徴付けられます。

一般に一般化されたカノニカル分布=指数型分布族の密度函数は

定数×exp(-Σ_i a_i f_i(x))q(x)

の形でパラメータa_i達は𝔼[f_i(X)]達で特徴付けられる。

#統計 以上を読めば、たとえすぐに詳細を理解できなくても、統計モデリングのビルディングブロックとして使われる指数型分布族の確率分布のパラメータの特徴づけの基本パターンと、統計力学におけるカノニカル分布の関係を理解することが、結構基本的であることを想像できると思います。

#統計 以上で述べた一連の「雑談」の内容は、コンピュータを使った最も優しいMCMC法の演習としても価値があります。

数学的一般論によって収束先の分布がどうなるかを知っていても、コンピュータで再現できると理解が進みます。

添付動画は収束先が正規分布の場合。

数学的一般論によって収束先の分布がどうなるかを知っていても、コンピュータで再現できると理解が進みます。

添付動画は収束先が正規分布の場合。

#統計 注意

* これは中心極限定理の動画では__ない__。

* 正規分布の密度函数の定数倍を使ったMCMC法の動画でも__ない__。

* カノニカル分布としての正規分布を分布のランダムウォークで実現する動画で__ある__。

nbviewer.jupyter.org/gist/genkuroki…

* これは中心極限定理の動画では__ない__。

* 正規分布の密度函数の定数倍を使ったMCMC法の動画でも__ない__。

* カノニカル分布としての正規分布を分布のランダムウォークで実現する動画で__ある__。

nbviewer.jupyter.org/gist/genkuroki…

#統計 一般に分布q(x)に付随する一般化されたカノニカル分布(=指数型分布族)

定数×exp(-Σ_i a_i f_i(x))q(x)

は期待値達𝔼[f_i(X)]の値が与えられたときの「もっともありがちな分布」として特徴付けられます。

これは統計モデリングで適切そうな指数型分布族の選択でヒントになりえる情報だと思う。

定数×exp(-Σ_i a_i f_i(x))q(x)

は期待値達𝔼[f_i(X)]の値が与えられたときの「もっともありがちな分布」として特徴付けられます。

これは統計モデリングで適切そうな指数型分布族の選択でヒントになりえる情報だと思う。

#統計 適当に動ける範囲に制限を付けて分布をランダムウォークさせたときの収束先の分布は、その制限の範囲に含まれる分布の中でもっともありがちな分布であるということになります。

ランダムウォークで適当に制限された範囲で最もありがちな分賦を探索している様子の動画↓

ランダムウォークで適当に制限された範囲で最もありがちな分賦を探索している様子の動画↓

#統計 ソースコード nbviewer.jupyter.org/gist/genkuroki… も全公開しているので、自分で以上のような計算をコンピュータにやらせたい人はいつでも「答えのコード」を閲覧することができます。

この手の計算に #Julia言語 は非常に向いています。

この手の計算に #Julia言語 は非常に向いています。

#統計 件の本のp.47の図1.4のように

math.wm.edu/~leemis/2008am…

から添付画像の部分を引用しても、各種の分布の理解に役に立つことはありません。

統計モデリングでのビルディングブロックになるような確率分布の理解はそういうものではありません。

私がしている雑談に近い試行錯誤が重要です。

math.wm.edu/~leemis/2008am…

から添付画像の部分を引用しても、各種の分布の理解に役に立つことはありません。

統計モデリングでのビルディングブロックになるような確率分布の理解はそういうものではありません。

私がしている雑談に近い試行錯誤が重要です。

#統計 p.49の読書案内によれば、私ならば読者の理解という観点からふざけた態度だと判定するp.47の図1.4への1つ前のツイートの添付画像の部分の引用は【三中本からの孫引き】らしい。

一般にまるで曼荼羅に見える複雑な図を引用したがる人は要注意だと私は思います。自分で作った図でさえない。

一般にまるで曼荼羅に見える複雑な図を引用したがる人は要注意だと私は思います。自分で作った図でさえない。

他人が作った曼荼羅っぽい図を引用したりせずに、自分の試行錯誤の結果を図にまとめないとダメ。

そして真に意味のある試行錯誤をしていれば、網羅的な曼荼羅図が出来上がることは決してないと思う。

そして真に意味のある試行錯誤をしていれば、網羅的な曼荼羅図が出来上がることは決してないと思う。

#統計 事前分布については、以下に引用するように考えておけばよい。

gamp.ameblo.jp/yusaku-ohkubo/…

【・事前分布はRIdge回帰やLASSO回帰のように推定値を安定化させるための道具であり、主観的な事前の信念を反映させるものではない

・事前分布は、事後予測分布などを通じて客観的に評価可能である】

gamp.ameblo.jp/yusaku-ohkubo/…

【・事前分布はRIdge回帰やLASSO回帰のように推定値を安定化させるための道具であり、主観的な事前の信念を反映させるものではない

・事前分布は、事後予測分布などを通じて客観的に評価可能である】

#統計 事前分布を単なる数学的道具とみなせるだけの知識がないせいで、事前分布を「事前の主観的な確信の度合い」のように解釈するのは無知すぎます。

事前分布の適切な利用によって平均予測誤差を小さくしたりできるから、事前分布はデータサイエンスで重要な道具の1つになっています。

事前分布の適切な利用によって平均予測誤差を小さくしたりできるから、事前分布はデータサイエンスで重要な道具の1つになっています。

#統計 前もってどの事前分布を利用するべきであるか分からない場合であっても、情報量規準や交差検証などによって、どの事前分布が相対的に優れている可能性が高いかを見積もることもできる。

事前分布を主観確率で解釈している人達はどんだけ知識をアップデートしていないのやら。

事前分布を主観確率で解釈している人達はどんだけ知識をアップデートしていないのやら。

#統計 このスレッドで話題にしている『統計学を哲学する』の「第2章 ベイズ統計」はストレートに太古の時代の「主観確率」の「ベイズ主義」の話が書いてありました。

渡辺澄夫著『ベイズ統計の理論と方法』のような現在では定番の教科書さえ目を通していないのだと思いました。

渡辺澄夫著『ベイズ統計の理論と方法』のような現在では定番の教科書さえ目を通していないのだと思いました。

#統計 この本には【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)と本当に書いてあります‼️

そういう著者に渡辺澄夫著『ベイズ統計の理論と方法』のような本を勧めるのは無茶かもしれませんが、数式ではなく、言葉で説明してある部分だけでも理解できれば全然違っていたと思う。

そういう著者に渡辺澄夫著『ベイズ統計の理論と方法』のような本を勧めるのは無茶かもしれませんが、数式ではなく、言葉で説明してある部分だけでも理解できれば全然違っていたと思う。

#統計 ベイズ統計の技術を使えば、今までオーバーフィッティングが原因で不可能だった推定が可能になりだろう的な話は40年前の赤池弘次さんの論説にも書いてあります。

ismrepo.ism.ac.jp/index.php?acti…

統計的推論のパラダイムの変遷について(1980)

の第6節を参照

ismrepo.ism.ac.jp/index.php?acti…

統計的推論のパラダイムの変遷について(1980)

の第6節を参照

#統計 赤池さんは正しかった。

渡辺澄夫著『ベイズ統計の理論と方法』では、最尤法が有効でない場合であっても、ベイズ統計ならば良い性質を持つことが示されています。

そういう数学的な良い性質に触れずに、「主観確率」の「ベイズ主義」にベイズ統計を落とし込むのは無知丸出しでまずすぎます。

渡辺澄夫著『ベイズ統計の理論と方法』では、最尤法が有効でない場合であっても、ベイズ統計ならば良い性質を持つことが示されています。

そういう数学的な良い性質に触れずに、「主観確率」の「ベイズ主義」にベイズ統計を落とし込むのは無知丸出しでまずすぎます。

#統計 統計学に限らず、多くの技術は時代とともに進歩して行きます。そういう技術について「哲学」を語るときには、可能な限りその時代の技術水準に追いついて、おかしなことを言わないように気をつけるべきです。

この本の第2章はそういう意味では完全に失格。

この本の第2章はそういう意味では完全に失格。

#統計 多くの誤解もしくは時代遅れに考え方が広く普及してしまっている現代では、ベイズ統計に関する解説では真っ先に「主観確率のベイズ主義は現代のベイズ統計においては無用のものになっている」と説明するべきです。

#統計 そして、データサイエンスにも関係している話をしたければ、リッジ正則化やLASSO正則化の話に触れて、そこから事前分布の使用が平均予測誤差を下げるために役に立ちそうな道具であることに触れて、事前分布を事前の主観の表現とみなす考え方が本当に無用になっていることを説明するべき。

#統計 そしてできれば、21世紀の研究である渡辺澄夫さんの仕事に触れて、ベイズ統計ならば特異モデルになる可能性がある構造を持った複雑なモデルであっても(最尤法と違って)良い性質を持つことが示されていることにも言及した方がよいと思う。

#統計 そして、一般の場合の(i.i.d.を仮定しない場合の)ベイズ統計の性質はまだ十分に分かっていないというようなことにも触れた方がよいと思う。

我々はすでに何でも知っているわけではないという認識は非常に重要だと思います。

我々はすでに何でも知っているわけではないという認識は非常に重要だと思います。

#統計 ベイズ統計入門

未知の確率分布を持つサイコロXの出目の確率を「確率分布は添付画像のサイコロA,B,Cのどれかである」というモデルを使って推定してみよう。

サイコロAは1,2が、Bは3,4が、Cは5,6が出易いイカサマのサイコロのモデル化である。続く

未知の確率分布を持つサイコロXの出目の確率を「確率分布は添付画像のサイコロA,B,Cのどれかである」というモデルを使って推定してみよう。

サイコロAは1,2が、Bは3,4が、Cは5,6が出易いイカサマのサイコロのモデル化である。続く

#統計 ケース1

事前分布として、サイコロA,B,Cの確率はどれも1/3を設定し、サイコロXを何度も振って出た目を使ってベイズ更新を行う。

添付動画はそのベイズ更新の様子である。出目の割合を表す赤のドットの動きを見ると、サイコロXの確率分布はモデルのサイコロA,B,Cのどれとも違うっぽい。続く

事前分布として、サイコロA,B,Cの確率はどれも1/3を設定し、サイコロXを何度も振って出た目を使ってベイズ更新を行う。

添付動画はそのベイズ更新の様子である。出目の割合を表す赤のドットの動きを見ると、サイコロXの確率分布はモデルのサイコロA,B,Cのどれとも違うっぽい。続く

#統計 ケース1つ続き

実はこのケース1でのサイコロXはイカサマでないすべての目がどう確率で出るサイコロである。

この場合にはサンプルサイズ→∞でベイズ更新は収束せず、推定結果は決して真実に到達しない。

実はこのケース1でのサイコロXはイカサマでないすべての目がどう確率で出るサイコロである。

この場合にはサンプルサイズ→∞でベイズ更新は収束せず、推定結果は決して真実に到達しない。

#統計 ケース2

このケース2のサイコロXはケース1のそれとは異なる。

ケース2におけるベイズ更新の結果はモデルのサイコロBに収束している。

しかし、出目の割合の赤のドットを見ると、このケース2のサイコロXはベイズ 更新の収束先のサイコロBとは違うっぽい。

このケース2のサイコロXはケース1のそれとは異なる。

ケース2におけるベイズ更新の結果はモデルのサイコロBに収束している。

しかし、出目の割合の赤のドットを見ると、このケース2のサイコロXはベイズ 更新の収束先のサイコロBとは違うっぽい。

#統計 ケース2続き

実はこのケース2におけるサイコロXでは3の目だけが他の目よりも出る確率が少しだけ高い。

この場合には、ベイズ更新はモデルの範囲内で真実を最もよく近似する分布(サイコロB)に収束するが、決して真実にはたどりつかない。

実はこのケース2におけるサイコロXでは3の目だけが他の目よりも出る確率が少しだけ高い。

この場合には、ベイズ更新はモデルの範囲内で真実を最もよく近似する分布(サイコロB)に収束するが、決して真実にはたどりつかない。

#統計 ケース2のように、ベイズ更新の結果がモデルの範囲内で真実を最もよく近位する分布に収束することは、非常に一般的にかなり緩い仮定のもとで示せます。

サンプルサイズ→∞で、モデルの限界まで推測の精度は上がりますが、それを超えて精度が上がることはない。

サンプルサイズ→∞で、モデルの限界まで推測の精度は上がりますが、それを超えて精度が上がることはない。

#統計 ところが『統計学を哲学する』p.83(添付画像)には、まるでモデルの分布族で実際のデータ生成プロセスを全然表現できない場合であっても【ベイズ流の更新のプロセスは最終的に真理に到達しうる】と書いてある‼️

これなに?

ベイズ統計を全然わかっていないように私には見えた。

これなに?

ベイズ統計を全然わかっていないように私には見えた。

#統計 分析用の統計モデルが実際のデータ生成プロセスを全然表現できないのに、そのモデルを使って真理に到達できるはずがない。そういう魔法のようなことがベイズ 統計なら原理的に可能だと本気で信じているとしたら、相当にどうかしていると思いました。

#統計 この本の著者は「期待値」について【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)と説明してしまうくらいなので、数学的な技術的な事柄に関する説明は全く信用できず、引用している文献を参照する手間をかける気には全くなれない。

#統計 正直な感想として、ページをめくるたびに次々に襲いかかってくるいかにもまずそうな説明が苦痛な本だと思いました。

さらに先を読めばどこかに価値あることが書いてあるのでしょうか?

めちゃくちゃ辛い。

さらに先を読めばどこかに価値あることが書いてあるのでしょうか?

めちゃくちゃ辛い。

#統計 以下のリンク先(このスレッドのちょっと上)にある動画を作るためのソースコードは

nbviewer.jupyter.org/gist/genkuroki…

においてあります。このスレッドで使っていない動画もそこで閲覧できます。ベイズ更新の様子を直観的に理解するために有用だと思います。

nbviewer.jupyter.org/gist/genkuroki…

においてあります。このスレッドで使っていない動画もそこで閲覧できます。ベイズ更新の様子を直観的に理解するために有用だと思います。

https://twitter.com/genkuroki/status/1322893508982706176

#統計 厳しい言い方をしていますが、純粋に「つらい気持ち」を表現しているだけで、他意はないです。

この長大なスレッドでは、より真っ当な理解に至るために必要な資料(私自身が作った動画を含む)を可能な限り紹介するように努力しました。そういう方向の努力が実れば一番うれしいです。

この長大なスレッドでは、より真っ当な理解に至るために必要な資料(私自身が作った動画を含む)を可能な限り紹介するように努力しました。そういう方向の努力が実れば一番うれしいです。

#統計 以下のリンク先の引用は、以下のリンク先のリンク先における

stat.columbia.edu/~gelman/resear…

Philosophy and the practice of Bayesian statistics Andrew Gelman and Shalizi

2012

の紹介からの孫引きです。この論文は『統計学を哲学する』でも引用されています(pp.84-87)。続く

stat.columbia.edu/~gelman/resear…

Philosophy and the practice of Bayesian statistics Andrew Gelman and Shalizi

2012

の紹介からの孫引きです。この論文は『統計学を哲学する』でも引用されています(pp.84-87)。続く

https://twitter.com/genkuroki/status/1322862665455185921

#統計 しかし、

ameblo.jp/yusaku-ohkubo/…

【事前分布は~主観的な事前の信念を反映させるものではない】

という実践データサイエンス的には普通の考え方を受け入れておらず、「信念」という解釈を捨てていない。

「主観確率」「信念」という解釈が無用であることを理解できないようだ。

ameblo.jp/yusaku-ohkubo/…

【事前分布は~主観的な事前の信念を反映させるものではない】

という実践データサイエンス的には普通の考え方を受け入れておらず、「信念」という解釈を捨てていない。

「主観確率」「信念」という解釈が無用であることを理解できないようだ。

#統計 『統計学を哲学する』に限らず、現在では無用になっている「主観確率」の「ベイズ主義」に基くベイズ統計の解釈を捨てられない困った人達は、ベイズ統計の説明で実践的にはベイズ統計が使われそうもない単純な統計モデルで説明しようとする傾向が強い。続く

#統計 続き。よく見るのは、ベルヌーイ分布モデル(コインを投げたとき表の出る確率がpである場合のモデル化)です。

「主観確率」論者にとってそういう単純なモデルで説明することには大きなメリットがあります。「表の出る確率pとして何がもっともらしいと事前に思っているか」という話をし易い!続く

「主観確率」論者にとってそういう単純なモデルで説明することには大きなメリットがあります。「表の出る確率pとして何がもっともらしいと事前に思っているか」という話をし易い!続く

#統計 ベイズ統計の技術が有効になりそうな数学的に複雑なモデルだと、直観が効かなくなるので、主観を事前分布に反映させる話をし難くなるのです。

それは「主観確率」でベイズ統計を説明したい人にとっては非常に不都合です。続く

それは「主観確率」でベイズ統計を説明したい人にとっては非常に不都合です。続く

#統計 さらに説明用のモデルが、実際に使用されているようなモデルだったりすると、実際に使用されている事前分布が「主観」「信念」「確信」の類とは全然違う規準で決められているという事実を指摘される可能性が高まるので、さらに都合がわるいでしょう。

#統計 ベルヌーイ分布モデルは「主観確率」でベイズ統計について説明したい人にとっては非常に都合のよい単純な統計モデルだと言えます。

「主観確率」とか言わない真っ当な人達は、階層ベイズのようなちょっと複雑なモデルを例に使うことが多いと思う。

「主観確率」とか言わない真っ当な人達は、階層ベイズのようなちょっと複雑なモデルを例に使うことが多いと思う。

#統計 実際にベイズ統計の計算を試してみると、単純なモデルなら最尤法でやってもおとなしめの任意の事前分布でベイズ統計を使っても得られる結果はほぼ同じになることも多く、そうでなくても事前分布のちょっとした違いよりもモデル全体の設定の方が結果に与える影響が大きかったります。

#統計 さらに、最尤法で分析してもよいことを知りながら、複雑なモデルを回すのが楽なベイズ統計の側を使うこともある。

ベイズ統計になった途端に「主観確率」の「ベイズ主義」が必要になるなどと考えていたら、自由に統計分析できなくなってしまいます。

ベイズ統計になった途端に「主観確率」の「ベイズ主義」が必要になるなどと考えていたら、自由に統計分析できなくなってしまいます。

#統計 訂正版

「8割おじさん」として有名になった西浦博さん達による分析のリポジトリを見ると、最尤法とベイズ統計の両方を同じように使っています。

8割おじさん達が最尤法ではなくベイズ統計を使ったときにのみ信念を更新しているとは思えません(笑)

「8割おじさん」として有名になった西浦博さん達による分析のリポジトリを見ると、最尤法とベイズ統計の両方を同じように使っています。

8割おじさん達が最尤法ではなくベイズ統計を使ったときにのみ信念を更新しているとは思えません(笑)

#統計 8割おじさん達が公開しているリポジトリは

github.com/contactmodel/C…

にあり、

github.com/contactmodel/C…

には最尤法とベイズ統計(Stan)を使っているJupyter notebooksが置いてあります。どちらのノートブックでも R_t を推定している。

github.com/contactmodel/C…

にあり、

github.com/contactmodel/C…

には最尤法とベイズ統計(Stan)を使っているJupyter notebooksが置いてあります。どちらのノートブックでも R_t を推定している。

#統計 最尤法でもできることを、ベイズ統計でもやる、というのは分析法をちょっと変えただけで結果が致命的なほど大きく変わらないことの確認には有効だった可能性があります。

ベイズ統計を使った途端に「主観確率」の更新をやっていると思うようになるというのはちょっとあり得ません。

ベイズ統計を使った途端に「主観確率」の更新をやっていると思うようになるというのはちょっとあり得ません。

#統計 p.31への書き込みを増やした。さすがに

【確率変数が持つ分布を特徴付ける値を、その期待値~という】

という説明はさすがにアウト。

あと、確率変数が従う分布はデータを取得した母集団分布とは限らないので、その平均(=期待値)と分散を【母平均】【母分散】と呼ぶのもダメです。

【確率変数が持つ分布を特徴付ける値を、その期待値~という】

という説明はさすがにアウト。

あと、確率変数が従う分布はデータを取得した母集団分布とは限らないので、その平均(=期待値)と分散を【母平均】【母分散】と呼ぶのもダメです。

#統計 カギカッコ付きの「中心」を使った説明もまずいです。カギカッコに「厳密にはは中心ではないのだが」というニュアンスを込めたと忖度して欲しいのかもしれませんが、そういうことはやめた方がよかった。

このページの態度は多くの読者を落胆させることでしょう。

このページの態度は多くの読者を落胆させることでしょう。

#統計 統計学における様々な概念について語る場合には

①データを生成していると想定している未知の確率分布

と

②統計分析用のモデル内の確率分布

の厳密な区別が必要です。①における確率変数と②における確率変数が同時に必要な場合があるので、その辺の区別に神経質になった方がよいです。

①データを生成していると想定している未知の確率分布

と

②統計分析用のモデル内の確率分布

の厳密な区別が必要です。①における確率変数と②における確率変数が同時に必要な場合があるので、その辺の区別に神経質になった方がよいです。

#統計 上の①と②を区別しているつもりであっても、①の確率分布を既知の確率分布に特殊化したものが②であるかのように思っているとしたら、完全にアウトです。

①の分布を未知のまま放置した上で、②の確率分布を正規分布にしたりするのが正しい考え方です。

①の分布を未知のまま放置した上で、②の確率分布を正規分布にしたりするのが正しい考え方です。

#統計 この本では概念的に重要な事柄について驚くほど杜撰な言葉遣いで説明されています。

既出の例の他にも、最尤法について【データを最も良く予測するようなモデルのパラメータを求める】と「予測」という言葉を使って説明していることにはあきれた。続く

既出の例の他にも、最尤法について【データを最も良く予測するようなモデルのパラメータを求める】と「予測」という言葉を使って説明していることにはあきれた。続く

#統計 「そのデータと同じ数値がモデル内で発生する確率が最大になるようなパラメータを求める」とか、「そのデータにモデルが最も適合するようなパラメータを求める」のようにより正確に書くべき。

「予測」という言葉は重要なので使うべきではなかった。

「予測」という言葉は重要なので使うべきではなかった。

#統計 あと、最尤法の他にも最小二乗法があるかのように述べているが、最小二乗法は最尤法の特別な場合(残差を期待値ゼロの正規分布でモデル化した場合の最尤法)である。

#統計 添付画像の青線の部分は非常によくない。

ベイズ統計では、分析用のモデル内(モデルは事前分布も含む)での仮説の正しい確率は定義できるが、そのモデル自身の正しさや適切さは別に扱う必要がある。

この点は最尤法とベイズ統計のあいだで違いはない。続く

ベイズ統計では、分析用のモデル内(モデルは事前分布も含む)での仮説の正しい確率は定義できるが、そのモデル自身の正しさや適切さは別に扱う必要がある。

この点は最尤法とベイズ統計のあいだで違いはない。続く

#統計 さらに、最尤法とベイズ統計は近似的にほぼ同じ結果を与えることが相当に沢山あり、正則モデルを使ったi.i.d.のデータを使った推測に限定すれば、サンプルサイズを十分大きくすれば、最尤法とベイズ統計はほぼ同じ結果を常に与えることも証明できる。

#統計 このように、最尤法とベイズ統計は互いにライバル関係にあり、結果を比較可能な分析方法であり、ある場合にはほぼ同じ結果を与えることがわかっている。

そのようなもの達を完全に分断して別物であるかのようにせつめいするのは非常にまずい。

そのようなもの達を完全に分断して別物であるかのようにせつめいするのは非常にまずい。

#統計 さらに、最尤法と仮説検定の間はものすごく密接な関係がある。

沢山の種類があるχ²検定の基礎は最尤法について普遍的に成立しているWilks' theoremである。

最尤法とベイズ統計、最尤法と仮設検定の間の関係を理解していないと統計学をスムーズに使うことが難しくなってしまう。

沢山の種類があるχ²検定の基礎は最尤法について普遍的に成立しているWilks' theoremである。

最尤法とベイズ統計、最尤法と仮設検定の間の関係を理解していないと統計学をスムーズに使うことが難しくなってしまう。

#統計 沢山あるχ²検定と最尤法におけるAICを使ったモデル選択のあいだにも密接な関係がある。

* 仮説検定におけるχ²検定

* 最尤法とAIC

* ベイズ統計とWAIC

は相当に近い関係にあり、コンピュータでそれらの関係を数値的に確認することは良い練習問題になる。

* 仮説検定におけるχ²検定

* 最尤法とAIC

* ベイズ統計とWAIC

は相当に近い関係にあり、コンピュータでそれらの関係を数値的に確認することは良い練習問題になる。

#統計 最も簡単な統計モデルであるベルヌーイ分布モデルの場合の

* 最尤法のAIC

* ベイズ統計のWAICとLOOCV(一個抜き出し交差検証)

* BICと自由エネルギー

などに関するまとめが

nbviewer.jupyter.org/gist/genkuroki…

にある。最尤法とベイズ統計の違いはこの場合には小さい。

* 最尤法のAIC

* ベイズ統計のWAICとLOOCV(一個抜き出し交差検証)

* BICと自由エネルギー

などに関するまとめが

nbviewer.jupyter.org/gist/genkuroki…

にある。最尤法とベイズ統計の違いはこの場合には小さい。

#統計 『統計学を哲学する』という本は読者を以下の事柄について正しく適切に考えることから遠ざけるように書かれているので読者は注意した方が良い。社会的には負の業績。

* 期待値

* ベイズ統計

* 最尤法

* 最小二乗法

* 最尤法とベイズ統計と仮設検定の関係

などなど

本当に気を付けた方が良い。

* 期待値

* ベイズ統計

* 最尤法

* 最小二乗法

* 最尤法とベイズ統計と仮設検定の関係

などなど

本当に気を付けた方が良い。

#統計 特に統計学では

* 定義が全然違っている複数のモノが、ある種の状況において、無視できる違いを除いて一致する場合があること

に注意する必要があります。そういう場合には定義が違っていて、概念的には大きく異なるモノであっても、ある種の状況では実質的に同じものとして扱う必要がある。

* 定義が全然違っている複数のモノが、ある種の状況において、無視できる違いを除いて一致する場合があること

に注意する必要があります。そういう場合には定義が違っていて、概念的には大きく異なるモノであっても、ある種の状況では実質的に同じものとして扱う必要がある。

#統計 そのようなことが、最尤法、ベイズ法、仮説検定の間に成立している場合があるのです。概念的に異なっていたり、定義が全然違っていたり、目的も全然違っていたりしても、ある種の状況では互いに相手を近似しあっており、そのような場合には「違いはない」と言う必要が出て来ます。

#統計 思想や概念や定義の違いよりも、近似的に等しいという数学的な関係の方を優先して考えないと、実質的に同じモノを使っているのに、思想や概念た定義が違うという理由で異なる結論を出してしまう誤りを犯してしまいます。

#統計 仮説検定、最尤法、ベイズ法などなどに異なる思想や主義があるかのように考えてしまうのは、単にそれらの数学的関係を理解していないからだと思う。

数学的道具は個々の性質や道具感の関係を数学的に理解した上で、自分の目的に合わせて自由に使えば良い。

数学的道具は個々の性質や道具感の関係を数学的に理解した上で、自分の目的に合わせて自由に使えば良い。

#統計 多くの仮説検定は、実質的にパラメータ空間W₁を持つモデルM₁とそれを次元が下がったパラメータ部分空間W₀に制限したモデルM₀の間の比較になっている。

例えば、ベルヌーイ分布モデルでの帰無仮説p=1/2の両側検定は、W₁=[0,1]とW₀={1/2}のデータを用いた比較になっている。

例えば、ベルヌーイ分布モデルでの帰無仮説p=1/2の両側検定は、W₁=[0,1]とW₀={1/2}のデータを用いた比較になっている。

#統計 次元の低いW₀の側が帰無仮説を表している。

そういう比較をdim W₁ = d₁ > d₀ = dim W₀で行う場合のχ²検定の自由度は次元の差d₁ - d₀になる。そのことは最尤法での対数尤度比の漸近挙動に関するWilks' theoremから得られる。

そういう比較をdim W₁ = d₁ > d₀ = dim W₀で行う場合のχ²検定の自由度は次元の差d₁ - d₀になる。そのことは最尤法での対数尤度比の漸近挙動に関するWilks' theoremから得られる。

#統計 仮説検定、最尤法、ベイズ統計の間には、それらを断絶させる深い谷は存在せず、すべてが地続きになっており、何もかも普通に関係しているクリスタルクリアな世界が広がっている。

このような理解を目指すべき。

このような理解を目指すべき。

#統計 関連情報

なるほど。「客観ベイズ」も否定しておくのは良いことですね。

あと、最初に試す事前分布は適切な意味で「おとなしめの事前分布」がよいと私も思っています。それでダメなら「狭い事前分布」も試してみる。

なるほど。「客観ベイズ」も否定しておくのは良いことですね。

あと、最初に試す事前分布は適切な意味で「おとなしめの事前分布」がよいと私も思っています。それでダメなら「狭い事前分布」も試してみる。

https://twitter.com/BluesNoNo/status/1323051447668273153

#統計 少なくとも、Jeffreys priorを特異モデルの場合に使うと予測誤差(汎化誤差)が悪化するというようなことは知っておくべきことだと思う。

幾何的に定義される座標不変なJeffreys事前分布がダメな場合もある。

watanabe-www.math.dis.titech.ac.jp/users/swatanab…

幾何的に定義される座標不変なJeffreys事前分布がダメな場合もある。

watanabe-www.math.dis.titech.ac.jp/users/swatanab…

#統計 あと「パラメータを増やしてモデルがデータにフィットするように調節する」のと本質的に同じことを手動で行っても、オーバーフィッティングで予測誤差が悪化することがあるというような注意も重要だと思う。これはベイズ統計でも同じ。

#統計 1つ前に述べたことは、最尤法の場合に限れば当たり前。

①パラメータを増やす。

②モデルがデータに適合するパラメータを求める。

③求めたパラメータを含むパラメータ数が少ないモデルを作る。

④上の③のモデルのAICを計算。

これ「不正行為」になります。

ベイズ統計でやっても「不正行為」

①パラメータを増やす。

②モデルがデータに適合するパラメータを求める。

③求めたパラメータを含むパラメータ数が少ないモデルを作る。

④上の③のモデルのAICを計算。

これ「不正行為」になります。

ベイズ統計でやっても「不正行為」

#統計 基本的に、データを見た後で、モデルの側を色々変えてモデルがデータにぴったり適合するようにがんばると、オーバーフィッティングさせまくることになるので注意。

データを見て適切そうなモデルを探しまくった場合には、別のデータでそのモデルを検証することが必要になる。

データを見て適切そうなモデルを探しまくった場合には、別のデータでそのモデルを検証することが必要になる。

#統計 「尤度=モデル内でデータと同じ数値が生成される確率(密度)は、モデルのもっともらしさの指標ではなく、モデルのデータへの適合度の指標に過ぎない」と強調することの背景には、データにぴったりフィットさせようとすることが予測誤差を悪化させるということがある。

#統計 「データを生成していると想定される未知の確率法則がある」という設定で統計分析する場合には、データそのものではなく、未知の確率法則が推測先のターゲットになる。

モデルをデータにぴったりフィットさせることは有害な目標設定になる。

モデルをデータにぴったりフィットさせることは有害な目標設定になる。

#統計 私的なオーバーフィッティングの大雑把な定義:モデルのデータへの適合度の上昇と予測精度の劣化が同時に進行すること。

添付動画の右側の青線が予測誤差で赤線がデータへの適合度です。赤線下降と青線上昇が同時に起こっているときに過学習が起こっている。

nbviewer.jupyter.org/gist/genkuroki…

添付動画の右側の青線が予測誤差で赤線がデータへの適合度です。赤線下降と青線上昇が同時に起こっているときに過学習が起こっている。

nbviewer.jupyter.org/gist/genkuroki…

#統計 モデルをデータに適合させるパラメータの探索では、最初のうちはモデルのデータへの適合度と予測精度が同時に上昇するが、その後は、パラメータ探索がデータの新しい構造を発見してモデルのデータへの適合度が上昇するときに予測精度の劣化が同時起こるというようなことが起こる。

#統計 データから構造を読み取ってそれをモデルに反映させるごとに、予測精度がその分だけ__悪化__して行く数値例を自分で作って楽しむことは、複数通りの意味で極めて教育的だと思う。

コンピュータではなく、自分自身もデータから構造を読み取って予測を悪化させてしまうかもしれない!

コンピュータではなく、自分自身もデータから構造を読み取って予測を悪化させてしまうかもしれない!

#統計 ちなみに「経験ベイズ」というのも、モデルがデータに適合するようなパラメータ調節の一種に過ぎません。

一般に「〇〇ベイズ」という用語を見たら、歴史的偶然によって広まってしまったが、別の言い方で言い直した方がよい言葉の典型例、とみなしておけばそう間違いがないと思います。

一般に「〇〇ベイズ」という用語を見たら、歴史的偶然によって広まってしまったが、別の言い方で言い直した方がよい言葉の典型例、とみなしておけばそう間違いがないと思います。

#統計 ベイズ統計のモデル内におけるパラメータη付きの確率密度函数

p(x_1,…,x_n|η) = ∫ p(x_1|θ)…p(x_n|θ)φ(θ|η) dθ

(φ(θ|η)はパラメータη付きの事前分布)

のデータX_1,…,X_nに関する尤度

L(η)=p(X_1,…,X_n|η)

を最大化するようにパラメータηの値を調節するのが、所謂「経験ベイズ」です。

p(x_1,…,x_n|η) = ∫ p(x_1|θ)…p(x_n|θ)φ(θ|η) dθ

(φ(θ|η)はパラメータη付きの事前分布)

のデータX_1,…,X_nに関する尤度

L(η)=p(X_1,…,X_n|η)

を最大化するようにパラメータηの値を調節するのが、所謂「経験ベイズ」です。

#統計 「経験ベイズ」は以上で述べたようなモノに過ぎないのに、『統計学を哲学する』のpp.79-82には、初めて「経験ベイズ」という用語を知った人にとって適切とは思えない解説が書かれている。

「主観確率」の「ベイズ主義」抜きにベイズ統計について正確に考えることを知らないからそうなる。

「主観確率」の「ベイズ主義」抜きにベイズ統計について正確に考えることを知らないからそうなる。

#統計 「経験ベイズ」も「モデルをデータにフィットさせるためのパラメータ調節」に過ぎず、その使用者がどのような主義や思想を持っていても、それとは無関係に、モデルをデータにフィットさせるためのパラメータ調節一般で生じることが数学的に生じる。

#統計 通常の議論では、主義や思想と無関係に決まっていること(典型例は数学的にどうなっているか)を明らかにして行くことを優先し、その過程で発見された主義や思想に依存することを別に取り上げる。

そういう慎重な手続きが欠けている本を読むときには注意が必要である。

そういう慎重な手続きが欠けている本を読むときには注意が必要である。

#統計 例えば、最尤法とベイズ統計や仮説検定の関係について説明する場合には、まず、主義や思想とは独立に、それらの間に数学的に(特に解析学的に)どのような関係があるかを明確にしておく慎重さが必要である。そして、主義や思想について語る場合にはそういう数学的結果に矛盾しないようにするべき。

#統計 渡辺澄夫著『ベイズ統計の理論と方法』のpp.80-82では、分散1の正規分布モデル(パラメータは1つ)と標準正規分布モデル(パラメータ無し)に関するAIC, BIC, 尤度比検定を比較しています。

最尤法、ベイズ、仮説検定の関係の一例がそこにある。

最尤法、ベイズ、仮説検定の関係の一例がそこにある。

#統計 渡辺澄夫さんが解説しているその例で起こっていることは、数学的に非常に一般的に起こっています。数学的に、最尤法、ベイズ統計、仮説検定は互いに密接に関係している。

ベルヌーイ分布モデルの場合については私のノート(既出)

nbviewer.jupyter.org/gist/genkuroki…

を参照。WAICやWBICも扱われている。

ベルヌーイ分布モデルの場合については私のノート(既出)

nbviewer.jupyter.org/gist/genkuroki…

を参照。WAICやWBICも扱われている。

#統計 最小二乗法は単なる直交射影の線形代数にしか見えないのだが(実際にはそのように見えるほど数学を理解していない人の方が多数派)、正規分布モデルの最尤法の一種になっているという認識は実践的な統計モデリングを行う場合には必須の教養のうちの1つ。

こういう点にも雑であってはいけない。

こういう点にも雑であってはいけない。

https://twitter.com/genkuroki/status/1323010318801383424

#統計 このスレッドで指摘している『統計学を哲学する』の杜撰な説明の仕方を見れば、この本を統計学における考え方についての教養を身に付けるための本として他人に勧めるのは非常にまずいことが分かると思う。

すでに勧めてしまった人はそれを撤回した方がよい

すでに勧めてしまった人はそれを撤回した方がよい

#統計 繰り返しになるが、【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)という説明の仕方はひどすぎる。

統計学の文脈では「確率分布を特徴づけるパラメータ」という言い方が頻出なのでめちゃくちゃまずい。

確率分布を特徴づけるパラメータを検索↓

google.com/search?sxsrf=A…

統計学の文脈では「確率分布を特徴づけるパラメータ」という言い方が頻出なのでめちゃくちゃまずい。

確率分布を特徴づけるパラメータを検索↓

google.com/search?sxsrf=A…

#統計 添付画像はすでに引用済みのp.36の脚注部分。そこでは

【母数=期待値】

という書き方がされていた‼️

確率分布の平均や分散は期待値で表せるが、中央値はそうではない(一意に決まらない場合もある)。

集団の様子を要約するための数値は必ずしも期待値の形になっているとは限らない。

【母数=期待値】

という書き方がされていた‼️

確率分布の平均や分散は期待値で表せるが、中央値はそうではない(一意に決まらない場合もある)。

集団の様子を要約するための数値は必ずしも期待値の形になっているとは限らない。

#統計 統計学における母数という用語の使い方は混乱している場合がある。

データが未知の母集団分布からの無作為抽出で得られていると想定しているときに、その母集団分布は平均や分散といった量でパラメトライズされているわけではないのに、母平均や母分散を母数(パラメータ)と呼ぶことがある。続く

データが未知の母集団分布からの無作為抽出で得られていると想定しているときに、その母集団分布は平均や分散といった量でパラメトライズされているわけではないのに、母平均や母分散を母数(パラメータ)と呼ぶことがある。続く

#統計 個人的には(おそらく私以外の多くの数学ユーザーは)、パラメータ付き確率分布のパラメータのみをパラメータと呼び、パラメータ付きではない確定した母集団分布の平均や分散をパラメータ(母数)とは呼びたくない。

母集団分布の平均や分散は母集団分布をパラメトライズしたりしていない!続く

母集団分布の平均や分散は母集団分布をパラメトライズしたりしていない!続く

#統計 その辺を誤解し難いように整理するためには

* 母集団分布の平均や分散を決してパラメータとは呼ばない。

* 「母数」という言い方も使わない。

* 確率分布族をパラメトライズしている変数はパラメータと呼ぶ。

とするとよいと思う。

あと、「母数=期待値」などと決して書かない(笑)

* 母集団分布の平均や分散を決してパラメータとは呼ばない。

* 「母数」という言い方も使わない。

* 確率分布族をパラメトライズしている変数はパラメータと呼ぶ。

とするとよいと思う。

あと、「母数=期待値」などと決して書かない(笑)

#統計 確率分布族のパラメータ達はその族に入れた座標系なのですが、指数型分布族の場合にはパラメータ達をその分布に従う確率変数の函数の期待値達で与えることができます。これは指数型分布族についての基本の1つ。

パラメータと期待値の関係について語りたければこういう話をクリアにすればよい。

パラメータと期待値の関係について語りたければこういう話をクリアにすればよい。

#統計 最悪なのは、未知の母集団分布だったはずのものを、勝手に既知の確率分布族のパラメータが特別な場合、例えば正規分布の特別な場合で置き換えて、母集団分布の平均や分散をパラメータと呼び、パラメータの意味を曖昧にしてしまうこと。

これをやらかすと一挙に非科学的なスタイルになる。

これをやらかすと一挙に非科学的なスタイルになる。

#統計 『統計学を哲学する』は間違い探しで楽しむ本になることを覚悟して購入した方がよい。

この本の著者は「色々わかっていない」という印象がどんどん強くなって来る。

【「Major axes」と表示されているのが回帰直線。】(p.17, 図1.1)

見逃していたので追加。色々ずさん。

この本の著者は「色々わかっていない」という印象がどんどん強くなって来る。

【「Major axes」と表示されているのが回帰直線。】(p.17, 図1.1)

見逃していたので追加。色々ずさん。

個人的には次世代の学生に被害が及ばないか心配。

金銭および知識の両面で。

『統計学を哲学する』を他人に勧めた人達が本当にこの本の内容を理解して読んだとはとても思えない。

目を通してキーワードを拾っただけの印象で他人に勧めたんじゃないか?

金銭および知識の両面で。

『統計学を哲学する』を他人に勧めた人達が本当にこの本の内容を理解して読んだとはとても思えない。

目を通してキーワードを拾っただけの印象で他人に勧めたんじゃないか?

#統計 「頻度主義vs.ベイズ主義」の対立を煽っていなくても、21世紀現在数学的に分かっていることを使った整理を十分にすることなく、「主観確率」だの「ベイズ主義」だのがベイズ統計の理解に必須であるかのように語ること自体が有害。

必須ではないことを最初に明瞭に認めるくらいのことは必要。

必須ではないことを最初に明瞭に認めるくらいのことは必要。

#統計 あと、議論では必ず例を使って説明することが大事。現代ではStanなどの道具を使っている様子を公開している人達を比較的容易に発見できます。

「主観確率」「ベイズ主義」とか言いたい人はそこで使われているベイズ統計をそれらの用語を使って解釈して見せることが必要。

「主観確率」「ベイズ主義」とか言いたい人はそこで使われているベイズ統計をそれらの用語を使って解釈して見せることが必要。

#統計 このスレッドでも幾つか実践的な事例を紹介していますが、「主観確率」やら「ベイズ主義」とやらは実践的なベイズ統計の応用例を理解するためには何も役に立たず、わたしには完全に無用なものに見える。

誰ならば、Stanを使って(笑)、信念をベイズ更新しているとみなさないと困るのやら。

誰ならば、Stanを使って(笑)、信念をベイズ更新しているとみなさないと困るのやら。

#統計 実践的には「階層モデルの正しい情報量基準や1個抜き出し交差検証の計算の仕方」の知識は役に立ちます。

結構多くの研究者が既存のライブラリの安易な適用で済ませているせいで、間違った使い方をしている疑いを私は持っています。

深刻な問題ですが、調査が大変なので手を出していない。

結構多くの研究者が既存のライブラリの安易な適用で済ませているせいで、間違った使い方をしている疑いを私は持っています。

深刻な問題ですが、調査が大変なので手を出していない。

#統計 あと、他人がMCMCを回して得た結果を自分でも再現できるかどうかを試してみるのは結構ためになります。

ぴったり再現できる場合は稀で、ちょっとした条件の違いで結果がどう変わるかが見える(笑)

実は他人による再現の試みを見るだけでも相当にためになる。

ぴったり再現できる場合は稀で、ちょっとした条件の違いで結果がどう変わるかが見える(笑)

実は他人による再現の試みを見るだけでも相当にためになる。

#統計 そして、各分野の専門家が持っている固有の知識が決定的に重要そうなことにも気付きます。

#統計 うぎゃあ!😅

回帰の式が

M₁: y = β₀ + β₁ x₁ + ε, ε ~ N(0, σ₁²)

ではなく、

【M₁: y = β₁ x₁ + ε, ε ~ N(μ₁, σ₁²)】(p.142)

【ただし、ε ~ N(μ, σ²) は誤差項εが平均μ、分散σ²の正規分布に従う、ということを示している】(p.143)

になっていた!

誤差項の平均がμ‼️😱

回帰の式が

M₁: y = β₀ + β₁ x₁ + ε, ε ~ N(0, σ₁²)

ではなく、

【M₁: y = β₁ x₁ + ε, ε ~ N(μ₁, σ₁²)】(p.142)

【ただし、ε ~ N(μ, σ²) は誤差項εが平均μ、分散σ²の正規分布に従う、ということを示している】(p.143)

になっていた!

誤差項の平均がμ‼️😱

#統計 p.17の図1.1では「Major axis」が回帰直線になっていたし、p.139では【最尤法の他に~最小二乗法】があるかのような説明の仕方になっていたし(最小二乗法は最尤法の特殊な場合)、嫌な予感はしていたのですが、pp.142-143では、

回帰の誤差項の平均がμ‼️

という設定を採用していた‼️😅😅😅

回帰の誤差項の平均がμ‼️

という設定を採用していた‼️😅😅😅

#統計 線形回帰において

y = a + bx + ε、ε〜Normal(0,σ²)

における回帰係数a,bと誤差の大きさσ²は別扱いするパラメータです。

最小二乗法(=このモデルの最尤法)でaとbはyのデータについて線形に決まる仲間のパラメータです。

この辺は学部レベルの統計学で習っている人もいると思います。

y = a + bx + ε、ε〜Normal(0,σ²)

における回帰係数a,bと誤差の大きさσ²は別扱いするパラメータです。

最小二乗法(=このモデルの最尤法)でaとbはyのデータについて線形に決まる仲間のパラメータです。

この辺は学部レベルの統計学で習っている人もいると思います。

#統計 実際には上で引用したpp.142-143の前のp.141の段階で

誤差項の平均がμ‼️

という設定になっています。

「誤差項」という日本語の意味がよく分かっていないんですかね?

引用部分について他にも言いたいことがあるのですが、皆さんにまかせます。

全体的に作りが雑で杜撰という印象が確定。

誤差項の平均がμ‼️

という設定になっています。

「誤差項」という日本語の意味がよく分かっていないんですかね?

引用部分について他にも言いたいことがあるのですが、皆さんにまかせます。

全体的に作りが雑で杜撰という印象が確定。

#統計 この本を他人に勧めている人がこの本を本当に読んだかどうかは相当に非常に疑わしい。

少なくとも、まだ統計学について十分詳しくなっていない人に、こんな雑なものを勧めちゃダメであることは確実だと思います。

「期待値」とか「線形回帰」についての常識的な解説さえ著者はできていない‼️😱

少なくとも、まだ統計学について十分詳しくなっていない人に、こんな雑なものを勧めちゃダメであることは確実だと思います。

「期待値」とか「線形回帰」についての常識的な解説さえ著者はできていない‼️😱

#統計

【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)

という説明が出版済み書籍に残っていることにも驚いたが、pp.141-143で

線形回帰の誤差項の平均はμ‼️

という設定が採用されていることにもびっくりしました。

「誤差項」という言葉の意味さえよく分かっていない感じ。

【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)

という説明が出版済み書籍に残っていることにも驚いたが、pp.141-143で

線形回帰の誤差項の平均はμ‼️

という設定が採用されていることにもびっくりしました。

「誤差項」という言葉の意味さえよく分かっていない感じ。

#統計 これは非常に残念なことで、どこかの段階で、雑で杜撰な説明を排除する努力をしていればこんなことにならなかった。

普通に学部教科書レベルの統計学を知っている人が丁寧にレビューしていればこんなことにはならなかったと思う。

普通に学部教科書レベルの統計学を知っている人が丁寧にレビューしていればこんなことにはならなかったと思う。

笑った顔を見せずに、わざと「とがったこと」を言いまくる議論を楽しもうと思っていたのですが、そういう空気では無くなって来た感じ。😭

あ、【普通に学部教科書レベルの統計学を知っている人が丁寧にレビューしていればこんなことにはならなかったと思う】は、レビュワーを責めているように受け取られかねないよくない発言でした。ごめんなさい。

全責任が著者個人のみにあることは言うまでもない。

全責任が著者個人のみにあることは言うまでもない。

#統計 解説

データをY_1,…,Y_nの平均μと分散σ²を計算して、データを正規分布モデルNormal(μ, σ)でフィッティングすることは、単純な正規分布モデルの最尤法に一致しています。

要するに、標本の平均と分散の計算は本質的に単純な正規分布モデルの最尤法とみなせます。続く

データをY_1,…,Y_nの平均μと分散σ²を計算して、データを正規分布モデルNormal(μ, σ)でフィッティングすることは、単純な正規分布モデルの最尤法に一致しています。

要するに、標本の平均と分散の計算は本質的に単純な正規分布モデルの最尤法とみなせます。続く

#統計 解説続き

上の単純な正規分布モデルの最尤法は線形回帰の特別な場合

y = β₀ + ε, ε~Normal(0, σ)

であるともみなせます。ここではμではなく、β₀と書きました。

これは通常の線形回帰の場合に

y = β₀ + β₁ x + ε, ε~Normal(0, σ)

と一般化される。続く

上の単純な正規分布モデルの最尤法は線形回帰の特別な場合

y = β₀ + ε, ε~Normal(0, σ)

であるともみなせます。ここではμではなく、β₀と書きました。

これは通常の線形回帰の場合に

y = β₀ + β₁ x + ε, ε~Normal(0, σ)

と一般化される。続く

#統計 通常の線形回帰の場合

y = β₀ + β₁ x + ε, ε~Normal(0, σ)

における β₀ + β₁ x の部分が、単純な正規分布モデルの記号における μ (の一般化)にあたるものです。そのことは尤度函数を真面目に書き下せば特に分かりやすくなると思います。

y = β₀ + β₁ x + ε, ε~Normal(0, σ)

における β₀ + β₁ x の部分が、単純な正規分布モデルの記号における μ (の一般化)にあたるものです。そのことは尤度函数を真面目に書き下せば特に分かりやすくなると思います。

#統計 単純な正規分布モデル

y~Normal(μ, σ)

のデータY_1,…,Y_nに関する尤度函数は

L(μ, σ) = (1/√(2πσ²))ⁿ exp(-((Y_1 - μ)²+…+(Y_n - μ)²)/(2σ²))

です。y~Normal(μ, σ)は

y = μ + ε, ε~Normal(0, σ)

と書いてもよい。続く

y~Normal(μ, σ)

のデータY_1,…,Y_nに関する尤度函数は

L(μ, σ) = (1/√(2πσ²))ⁿ exp(-((Y_1 - μ)²+…+(Y_n - μ)²)/(2σ²))

です。y~Normal(μ, σ)は

y = μ + ε, ε~Normal(0, σ)

と書いてもよい。続く

#統計 線形回帰モデル

y=β₀+β₁x+ε

ε~Normal(μ, σ)

のデータ(x_1,Y_1),…,(x_n,Y_n)に関する尤度函数は

L(β₀,β₁,σ) = (1/√(2πσ²))ⁿ exp(-((Y_1 - (β₀+β₁x_1))²+…+(Y_n - (β₀+β₁x_n))²)/(2σ²))

です。上の単純な正規分布モデルのμ達をβ₀+β₁x_i達で置き換えた形の式になっている。

y=β₀+β₁x+ε

ε~Normal(μ, σ)

のデータ(x_1,Y_1),…,(x_n,Y_n)に関する尤度函数は

L(β₀,β₁,σ) = (1/√(2πσ²))ⁿ exp(-((Y_1 - (β₀+β₁x_1))²+…+(Y_n - (β₀+β₁x_n))²)/(2σ²))

です。上の単純な正規分布モデルのμ達をβ₀+β₁x_i達で置き換えた形の式になっている。

#統計 続き。すぐ上の線形回帰の場合のデータを生成している確率法則を次のように書くこともあります。

Y_i = β₀+β₁x_i+ε_i

ε_i~Normal(0, σ)

(ε_i達は独立, i=1,…,n)

よくある「確率プログラミング言語」で統計分析する場合にはこれに近い文法でコードを書けるようになっていることが多い。

Y_i = β₀+β₁x_i+ε_i

ε_i~Normal(0, σ)

(ε_i達は独立, i=1,…,n)

よくある「確率プログラミング言語」で統計分析する場合にはこれに近い文法でコードを書けるようになっていることが多い。

#統計 続き。上と同じことを

Y_i ~ Normal(β₀+β₁x_i, σ)

(Y_i達は独立、i=1,…,n)

と書いてもよい。これがよくある最小二乗法の場合です。

最小二乗法は残差ε_i達が独立同分布な平均ゼロの正規分布に従うとするモデルの最尤法に等価です。

最尤法と別に最小二乗法があるわけではないです。

Y_i ~ Normal(β₀+β₁x_i, σ)

(Y_i達は独立、i=1,…,n)

と書いてもよい。これがよくある最小二乗法の場合です。

最小二乗法は残差ε_i達が独立同分布な平均ゼロの正規分布に従うとするモデルの最尤法に等価です。

最尤法と別に最小二乗法があるわけではないです。

#統計 任意の函数達f_1(x),…,f_r(x)の一次結合によるフィッティングを行うための最小二乗法のモデルの記述は

Y_i = β_1 f_1(x_i) + … + β_r f_r(x_i) + ε_i

ε_i ~ Normal(0, σ)

(ε_i達は独立, i=1,…,n)

とか

Y_i ~ Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

(Y_i達は独立, i=1,…,n).

Y_i = β_1 f_1(x_i) + … + β_r f_r(x_i) + ε_i

ε_i ~ Normal(0, σ)

(ε_i達は独立, i=1,…,n)

とか

Y_i ~ Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

(Y_i達は独立, i=1,…,n).

#統計 以上のように、残差

ε_i = Y_i - (β_1 f_1(x_i) + … + β_r f_r(x_i))

達が平均0の独立同分布な正規分布に従うとするのが、最尤法が最小二乗法と等価になるモデルの記述になります。

続く

ε_i = Y_i - (β_1 f_1(x_i) + … + β_r f_r(x_i))

達が平均0の独立同分布な正規分布に従うとするのが、最尤法が最小二乗法と等価になるモデルの記述になります。

続く

#統計 こういう感じに、

Y_i~Normal(μ, σ)

↓

Y_i~Normal(β₀+β₁x_i, σ)

↓

Y_i~Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

と統計学入門で必ず習う単純な正規分布モデルから一般の最小二乗法まで「地続きに」理解することが基本になります。

こういう地道な勉強が楽しい。

Y_i~Normal(μ, σ)

↓

Y_i~Normal(β₀+β₁x_i, σ)

↓

Y_i~Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

と統計学入門で必ず習う単純な正規分布モデルから一般の最小二乗法まで「地続きに」理解することが基本になります。

こういう地道な勉強が楽しい。

#統計 今だと、以上で書いた形の式にかなり近い表現でモデルをコンピュータに入力できて、ほぼ自動的に最尤法(上の場合には最小二乗法になる)やベイズ法の結果を表示してくれます。

そういう経験を積めば「百聞は一見に如かず!」と言いたくなる感じで理解が進み易くなると思います。

そういう経験を積めば「百聞は一見に如かず!」と言いたくなる感じで理解が進み易くなると思います。

#統計 パラメータβ_j, σ達の事前分布も

Y_i~Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

β_j~Prior_j()

σ~Prior_σ()

のように与えれば、即ベイズ法のモデルの記述になります。

より一般に所謂「グラフィカルモデル」の記述は上のような式で書かれることが多い。

Y_i~Normal(β_1 f_1(x_i) + … + β_r f_r(x_i), σ)

β_j~Prior_j()

σ~Prior_σ()

のように与えれば、即ベイズ法のモデルの記述になります。

より一般に所謂「グラフィカルモデル」の記述は上のような式で書かれることが多い。

#統計

サンプルの標本平均と標本分散の計算

=単純な正規分布モデルの最尤法

↓

最小二乗法

=残差が独立同分布な平均0の正規分布に従うとするモデルでの最尤法

↓

以上のベイズ版

のように、高校でも習うような標本平均と標本分散の計算は「地続き」でベイズ版の回帰に繋がっているのです。

サンプルの標本平均と標本分散の計算

=単純な正規分布モデルの最尤法

↓

最小二乗法

=残差が独立同分布な平均0の正規分布に従うとするモデルでの最尤法

↓

以上のベイズ版

のように、高校でも習うような標本平均と標本分散の計算は「地続き」でベイズ版の回帰に繋がっているのです。

#統計 以上で説明したモデルはどれも分析用の数学的なフィクション。

以上のようなモデルとは別に、データが未知の確率法則で生成されていると想定することが基本になります。

データを生成している法則は不明のままで、データのみからどこまでその不明の法則に迫れるかが基本問題になります。

以上のようなモデルとは別に、データが未知の確率法則で生成されていると想定することが基本になります。

データを生成している法則は不明のままで、データのみからどこまでその不明の法則に迫れるかが基本問題になります。

#統計 最重要ポイントなので繰り返します。

①データを生成している未知の確率法則の存在を想定する。

②データの数値だけから、その未知の法則についてどれだけのことを知ることができるか、が基本問題。

③データの数値情報を使って未知の法則に迫るために、分析用の数学的モデルを設定する。

①データを生成している未知の確率法則の存在を想定する。

②データの数値だけから、その未知の法則についてどれだけのことを知ることができるか、が基本問題。

③データの数値情報を使って未知の法則に迫るために、分析用の数学的モデルを設定する。

#統計 上の考え方は非常に普遍的で、仮説検定、最尤法、ベイズ統計などをその考え方で統一的に理解することが可能です。

仮説検定、最尤法、ベイズ統計は前提とする思想が違う全然別のものである、というような思い込みを心に植え付けられてしまうと、ダメになってしまうので要注意です。

仮説検定、最尤法、ベイズ統計は前提とする思想が違う全然別のものである、というような思い込みを心に植え付けられてしまうと、ダメになってしまうので要注意です。

#統計 これは良い質問!

#統計 そうです。「モデル内の確率法則」と誤解を招かずに済む説明の仕方をするべきでした。ごめんなさい。文字数制限の圧力に負けた。

「実際にデータを生成していると想定している確率法則」と「分析用のモデル内でのデータ生成の確率法則」は別のものです。

#統計 そうです。「モデル内の確率法則」と誤解を招かずに済む説明の仕方をするべきでした。ごめんなさい。文字数制限の圧力に負けた。

「実際にデータを生成していると想定している確率法則」と「分析用のモデル内でのデータ生成の確率法則」は別のものです。

https://twitter.com/EZX2FOFxVpvStIK/status/1323440142367875072

#統計 次の2つを同時並行的に考えることが基本になります。

①現実におけるデータを生成している確率法則(存在すると想定するが、その法則は原則として永久に未知であると考える)

②分析用のモデル内仮想世界におけるデータ生成の確率法則(実践的にはモデルをコンピュータに入力して利用する)

①現実におけるデータを生成している確率法則(存在すると想定するが、その法則は原則として永久に未知であると考える)

②分析用のモデル内仮想世界におけるデータ生成の確率法則(実践的にはモデルをコンピュータに入力して利用する)

#統計

①現実におけるデータを生成している確率法則

②分析用のモデル内仮想世界におけるデータ生成の確率法則

は完全に別ものだと考えた上で、この2つでデータの数値は共通のものとすることによって、それらを数学的に関係付けるわけですが。その数学的な関係が統計分析の基礎付けになります。

①現実におけるデータを生成している確率法則

②分析用のモデル内仮想世界におけるデータ生成の確率法則

は完全に別ものだと考えた上で、この2つでデータの数値は共通のものとすることによって、それらを数学的に関係付けるわけですが。その数学的な関係が統計分析の基礎付けになります。

#統計 お勧めの勉強の仕方

①の「現実におけるデータを生成している未知の確率法則」を「データがコンピュータの擬似乱数を使って生成されている場合」に置き換えて、②のモデルを使った分析でどこまで分かるかをモンテカルロシミュレーションで確認すると、理解が捗ります。

①の「現実におけるデータを生成している未知の確率法則」を「データがコンピュータの擬似乱数を使って生成されている場合」に置き換えて、②のモデルを使った分析でどこまで分かるかをモンテカルロシミュレーションで確認すると、理解が捗ります。

#統計 ①の「現実におけるデータを生成している未知の確率法則」は単に未知のままというより「闇の中」という感じで、統計分析の結果その未知の法則にどこまで迫れたかさえよく分からないことが多い。

そういう場合のみを見ても理解に必要な数学的法則を確認できません。続く

そういう場合のみを見ても理解に必要な数学的法則を確認できません。続く

#統計 ①の「現実におけるデータを生成している未知の確率法則」を「自分で決めたコンピュータで実行可能なデータ生成の確率法則」にデータを繰り返し生成して、②の分析用のモデルにぶち込んだ結果を見れば、2つを比較可能になります。

そこで見える普遍的なパターンが統計分析の基礎になる。

そこで見える普遍的なパターンが統計分析の基礎になる。

#統計 このスレッドのずっと上の方では、私自身が

自分で決めた確率法則に従ってコンピュータにデータの数値をランダムに生成させる

↓

それを分析用のモデルにぶち込んで計算

↓

視覚化

を #Julia言語 によるソースコードを全公開してやって見せています。普遍的パターンについても解説した。

自分で決めた確率法則に従ってコンピュータにデータの数値をランダムに生成させる

↓

それを分析用のモデルにぶち込んで計算

↓

視覚化

を #Julia言語 によるソースコードを全公開してやって見せています。普遍的パターンについても解説した。

#統計

sin(x) + 正規分布乱数 でデータを生成

↓

5次式によるフィッティングの最小二乗法のモデルにぶち込む

↓

線形代数で解かずに尤度が大きくなるパラメータ値を探索する方法で計算

↓

視覚化

↓

オーバーフィッティングの様子が見える

↓

実はこれはオーバーフィッティングの普遍的なパターン

sin(x) + 正規分布乱数 でデータを生成

↓

5次式によるフィッティングの最小二乗法のモデルにぶち込む

↓

線形代数で解かずに尤度が大きくなるパラメータ値を探索する方法で計算

↓

視覚化

↓

オーバーフィッティングの様子が見える

↓

実はこれはオーバーフィッティングの普遍的なパターン

https://twitter.com/genkuroki/status/1323112916162207746

#統計

コンピュータにサイコロXを何回もふらせてデータを生成。

動画中の赤のドットが出た目の割合。

サイコロXは3の目の出る確率だけがちょっとだけ高い。

↓

「サイコロは等確率で、1,2が出易いサイコロA、3,4が出易いB、4,5が出易いCのどれか」というベイズ法のモデルにぶち込む

↓

計算して視覚化

コンピュータにサイコロXを何回もふらせてデータを生成。

動画中の赤のドットが出た目の割合。

サイコロXは3の目の出る確率だけがちょっとだけ高い。

↓

「サイコロは等確率で、1,2が出易いサイコロA、3,4が出易いB、4,5が出易いCのどれか」というベイズ法のモデルにぶち込む

↓

計算して視覚化

https://twitter.com/genkuroki/status/1322893535549431809

#統計

コンピュータでガンマ分布に従う乱数でデータを生成

↓

データをモデルY_i~Normal(μ, σ)にぶち込む

↓

視覚化

データの生成確率法則はガンマ分布ですが、分析用のモデルは正規分布です。

動画の右半分は尤度函数のヒートマップ。

尤度函数のグラフを沢山見ておくことは大事なことです。

コンピュータでガンマ分布に従う乱数でデータを生成

↓

データをモデルY_i~Normal(μ, σ)にぶち込む

↓

視覚化

データの生成確率法則はガンマ分布ですが、分析用のモデルは正規分布です。

動画の右半分は尤度函数のヒートマップ。

尤度函数のグラフを沢山見ておくことは大事なことです。

https://twitter.com/genkuroki/status/1322666771296350208

#統計

データをガンマ分布で生成

↓

モデルY_i~Laplace(a,b) (ラプラス分布モデル)にぶち込む

↓

視覚化

動画の右半分は尤度函数の視覚化。明るい部分ほど尤度が高い。

データを生成している確率法則はガンマ分布だが、分析用のモデル内でのデータ生成確率法則はラプラス分布。

データをガンマ分布で生成

↓

モデルY_i~Laplace(a,b) (ラプラス分布モデル)にぶち込む

↓

視覚化

動画の右半分は尤度函数の視覚化。明るい部分ほど尤度が高い。

データを生成している確率法則はガンマ分布だが、分析用のモデル内でのデータ生成確率法則はラプラス分布。

https://twitter.com/genkuroki/status/1322666785598918656

#統計 上の2つの場合で、正規分布

p_{normal}(y|μ,σ) = (1/√(2πσ²))exp(-(y-μ)²/(2σ²))

とLaplace分布

p_{Laplace}(y|a,b) = (1/(2b))exp(-|y-a|/b)

の場合を特に見せたことには、ある意図がありました。続く

p_{normal}(y|μ,σ) = (1/√(2πσ²))exp(-(y-μ)²/(2σ²))

とLaplace分布

p_{Laplace}(y|a,b) = (1/(2b))exp(-|y-a|/b)

の場合を特に見せたことには、ある意図がありました。続く

#統計 データ(サンプル)の標本平均と標本分散の計算は、実は正規分布モデルの最尤法でのμとσ²の推定にちょうどなっています。(最小二乗法も最尤法になっていることはこれの一般化)

標本平均と標本分散の計算という記述統計のイロハのイは実はもろに正規分布モデルの最尤法になっているのです!続く

標本平均と標本分散の計算という記述統計のイロハのイは実はもろに正規分布モデルの最尤法になっているのです!続く

#統計 記述統計のイロハのイには、中央値を代表値として使うことが含まれます。

実は、サンプルの中央値aとサンプルにおけるaとの差の絶対値の平均bの計算は、Laplace分布モデルの最尤法によるa,bの推定に一致!

要するに中央値を使うことはLaplace分布によるフィッティングの一部になっている。

実は、サンプルの中央値aとサンプルにおけるaとの差の絶対値の平均bの計算は、Laplace分布モデルの最尤法によるa,bの推定に一致!

要するに中央値を使うことはLaplace分布によるフィッティングの一部になっている。

#統計 平均よりも中央値の方が外れ値に強いことは、正規分布よりもLaplace分布の方が「裾が太い」ことに関係していると考えることができます。

記述統計のイロハのイも我々の基本的な考え方の中に自動的に取り込まれてしまう!

記述統計と推測統計を思想が違う完全に別物と思い込まない方がよい。

記述統計のイロハのイも我々の基本的な考え方の中に自動的に取り込まれてしまう!

記述統計と推測統計を思想が違う完全に別物と思い込まない方がよい。

#統計 上の例で、データを生成する確率法則をガンマ分布にしたのは、左右非対称な分布の典型例の1つだからです。対数正規分布でもよかった。

年収の分布はガンマ分布や対数正規分布のような形で、代表値として中央値がよく使われる。その場合に近い場合をコンピュータで作ったつもりです。

年収の分布はガンマ分布や対数正規分布のような形で、代表値として中央値がよく使われる。その場合に近い場合をコンピュータで作ったつもりです。

#統計 年収の分布の代表値として中央値を使うことは、我々の立場では以下のリンク先のようなことをしていることになります。

無味乾燥に見える記述統計のイロハのイに過ぎない「中央値」でさえ、こんなに面白い!

無味乾燥に見える記述統計のイロハのイに過ぎない「中央値」でさえ、こんなに面白い!

https://twitter.com/genkuroki/status/1322666785598918656

#統計 以上で見せた動画を見れば、正規分布でもLaplace分布でもないガンマ分布でデータが生成されている場合に、正規分布モデルやLaplace分布モデルを適用した場合の「誤差」の程度も分かります。

#統計 もしも、データを生成した分布を含むシンプルなモデル(今の場合はガンマ分布モデル)を使用可能ならばそうした方が推定の誤差は小さくなります。

しかし、実データの分析では真の分布は闇の中です。オーバーフィッティングの心配もある。

実データの分析では分野固有の知識が決定的に重要です。

しかし、実データの分析では真の分布は闇の中です。オーバーフィッティングの心配もある。

実データの分析では分野固有の知識が決定的に重要です。

#統計 以上の計算例でベイズ法を使ったのはサイコロXの場合だけですが、他の場合もこの程度のシンプルなモデルでは最尤法ではなくベイズ統計を使ってもほぼ同じ結果が得られます。(ただし、回帰でのオーバーフィッティングはベイズ法では予測分布がぼやけるという形で観測される。)

#統計 対立を煽っていなくても、「頻度主義の統計学とベイズ主義の統計学がある」という思い込みを心に植え付けに来る文献の記述は、はなっから馬鹿にして相手をしない方が私はよいと思います。

思想について語るなら、それ以前に思想抜きに理解できる数学的事柄をしっかり勉強してからにするべき。

思想について語るなら、それ以前に思想抜きに理解できる数学的事柄をしっかり勉強してからにするべき。

#統計 「予測」という言葉は「まだ観測されていない値の分布の予測」という意味で使うべきで、「すでに得られているデータを予測する」のように使うべきじゃないのですが、『統計学を哲学する』ではそういうことをやらかしています。

「哲学」を標榜しながら、数学だけではなく、言葉の扱いがずさん。

「哲学」を標榜しながら、数学だけではなく、言葉の扱いがずさん。

#統計 「予測」という言葉は統計学について語るときの最重要キーワードなので、大事に扱うべきです。

p.139に、最尤法では与えられたデータを【最もよく予測するようなモデルのパラメータを求める】と書いていますが、そこでは「予測」ではなく、「適合」「フィット」という言葉を使うべきでした。

p.139に、最尤法では与えられたデータを【最もよく予測するようなモデルのパラメータを求める】と書いていますが、そこでは「予測」ではなく、「適合」「フィット」という言葉を使うべきでした。

#統計 p.144では、これから観測されるデータの分布の予測の意味で「予測」という言葉を使っているように読めますが、説明の仕方が十分にクリアでない。

【似たようなデータの予測】という言い方をしているせいで、その「似たようなってどういう意味?」と読者が叫ばざるを得なくなっている。

【似たようなデータの予測】という言い方をしているせいで、その「似たようなってどういう意味?」と読者が叫ばざるを得なくなっている。

#統計 普通に教科書に書いてあることを知っていると、数学だけではなく、言葉の使い方がずさんな点が非常に気になり、ものすごく不快な本になっているように感じられます。

正しい考え方に興味がない人がこの本を他人に勧めている可能性があるので、みんな注意した方がよいです。

正しい考え方に興味がない人がこの本を他人に勧めている可能性があるので、みんな注意した方がよいです。

#統計 予測分布という言葉があるのだから、最尤法の場合も予測分布を定義して、その予測誤差の大きさを問題にすればよいのに、添付画像のような説明になっているせいで、おそらくほとんどの読者は理解不能になるだろう。続く

#統計 予測分布の平均対数尤度の一般向けの説明をしたいのだろうが、おそらく「尤度」という言葉に引きずられて、平均対数尤度を得るためにも1000人分のデータが必要であるかのような変な説明の仕方になっている。

稠密に「この著者は分かっていないな」と感じさせる説明が出て来てつらい。

稠密に「この著者は分かっていないな」と感じさせる説明が出て来てつらい。

#統計 既知のデータY_1,…,Y_nから、次に観測されるY_{n+1}の確率分布を推測することが、典型的な「予測」です。

既知のデータY_1,…,Y_nから任意の方法で作った次に観測されるY_{n+1}の分布の予測とみなされる確率分布p*(y)が「予測分布」の一般的な定義です。予測分布の作り方は無数にある。

既知のデータY_1,…,Y_nから任意の方法で作った次に観測されるY_{n+1}の分布の予測とみなされる確率分布p*(y)が「予測分布」の一般的な定義です。予測分布の作り方は無数にある。

#統計 既知の1000人分のデータY_1,…,Y_nから、その次のY_{n+1}の確率分布を予測できればよくて、その次も1000人分である必要はない。

(Y_{n+1}, Y_{n+2}, … がi.i.d.で大数の法則が使えることの応用はまた別の話)

こういうクリアな話がことごとく奇妙なスタイルで説明されている。

(Y_{n+1}, Y_{n+2}, … がi.i.d.で大数の法則が使えることの応用はまた別の話)

こういうクリアな話がことごとく奇妙なスタイルで説明されている。

#統計 データが分布q(y)のi.i.d.で生成されているときには、次に観測されるY_{n+1}の真の分布もq(y)になります。

予測分布p*(y)によるY_{n+1}の真の分布のシミュレーションの誤差はSanovの定理より、Kullback-Leibler情報量D(q||p*)の大きさで測られます。

genkuroki.github.io/documents/2016…

予測分布p*(y)によるY_{n+1}の真の分布のシミュレーションの誤差はSanovの定理より、Kullback-Leibler情報量D(q||p*)の大きさで測られます。

genkuroki.github.io/documents/2016…

#統計 KL情報量で測られる誤差の大きさは、

(汎化誤差)=-(log p*(Y_{n+1}) の Y_{n+1} に関する平均)

からある定数を引いたものに等しいので、汎化誤差を小さくできれば、予測分布の誤差も小さくできる。

上のlog p*(Y_{n+1})は予測分布の対数尤度です。続く

(汎化誤差)=-(log p*(Y_{n+1}) の Y_{n+1} に関する平均)

からある定数を引いたものに等しいので、汎化誤差を小さくできれば、予測分布の誤差も小さくできる。

上のlog p*(Y_{n+1})は予測分布の対数尤度です。続く

#統計 汎化誤差の定義には、次に観測される確率変数 Y_{n+1} の1個だけあればよい。1000人分はいりません(笑)。

しかし、確率変数Y_{n+1}に関する-log p*(Y_{n+1})の平均(期待値)の計算には、未知であるY_{n+1}の真の分布が必要なので、汎化誤差そのものを我々は計算できません。

しかし、確率変数Y_{n+1}に関する-log p*(Y_{n+1})の平均(期待値)の計算には、未知であるY_{n+1}の真の分布が必要なので、汎化誤差そのものを我々は計算できません。

#統計 しかし、もしも既知のデータY_1,…,Y_nの数値のみを使って、予測分布p*(y)のY_{n+1}の真の分布に対する汎化誤差の代わりに実用的に使える量を計算できるならば、それを使って予測分布の誤差を下げることが可能になるかもしれない。続く

#統計 それをある条件のもとで最尤法を使った場合に可能にしたのが、赤池弘次さんです。

AICと書かれ、赤池さん自身は【an information criterion の略記】だと言っている(笑)。

赤池さんが書いたものはこういう点でも面白いのでおすすめ。

jstage.jst.go.jp/article/butsur…

AICと書かれ、赤池さん自身は【an information criterion の略記】だと言っている(笑)。

赤池さんが書いたものはこういう点でも面白いのでおすすめ。

jstage.jst.go.jp/article/butsur…

#統計 AICを赤池さん以外の人達はより権威的は響きを持つ「赤池情報量規準」と呼ぶ傾向があります。

そういう権威的響きの印象に負けて、権威あるものだと感じたままで終わると、知性が劣化してしまうので要注意です。

「恐れ」を無くすには自分で計算してみるしかありません。

百聞は一見に如かず

そういう権威的響きの印象に負けて、権威あるものだと感じたままで終わると、知性が劣化してしまうので要注意です。

「恐れ」を無くすには自分で計算してみるしかありません。

百聞は一見に如かず

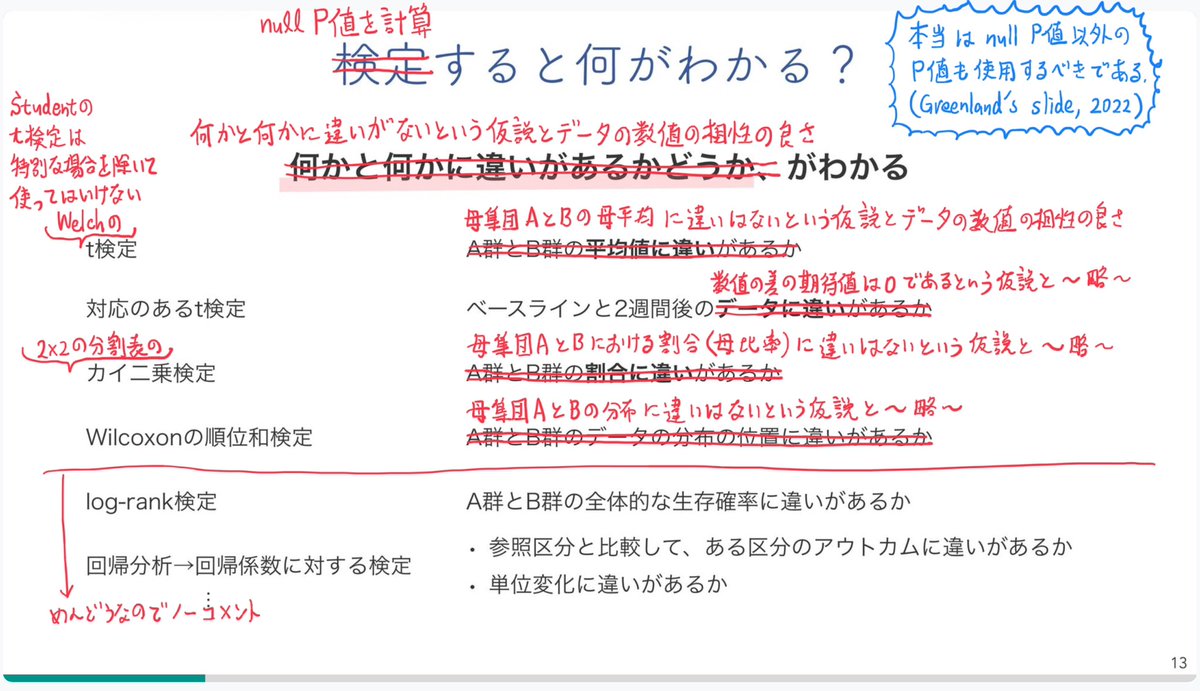

#統計 ベルヌーイ分布モデルという最もシンプルなモデルの場合に、最尤法の平均汎化誤差EE[GE_MLE]や平均AIC EE[AIC]などを、サンプルサイズnごとに計算して比較するために作ったのが添付画像のグラフです。

nbviewer.jupyter.org/gist/genkuroki…

nbviewer.jupyter.org/gist/genkuroki…

#統計 他にも、ベイズ統計の場合の平均汎化誤差E[GE_Bayes]と平均WAICと平均1個抜き出し交差検証E[LOOCV]も計算しています。

n→∞で全部一致することが知られているのですが、nが小さな場合にはAICの値のみが他と大きく違っていることがわかります。n=100で全部ほぼ一致。

nbviewer.jupyter.org/gist/genkuroki…

n→∞で全部一致することが知られているのですが、nが小さな場合にはAICの値のみが他と大きく違っていることがわかります。n=100で全部ほぼ一致。

nbviewer.jupyter.org/gist/genkuroki…

#統計 こんな感じで、最尤法もベイズ統計も差別せずに、適切な規準を作って比較すると、シンプルなモデルで十分にサンプルサイズを大きくすれば、結果は全部一致することが多いです。

上の場合には小さなnで最尤法のAICのみがちょっと離れており、ベイズ版のWAICの方がちょっと優れているっぽい。

上の場合には小さなnで最尤法のAICのみがちょっと離れており、ベイズ版のWAICの方がちょっと優れているっぽい。

#統計 こういう計算を積み重ねたことがある人ならば、たとえ対立を煽っていなくても「頻度主義とベイズ主義の異なる統計学がある」という主張の薄っぺらさがよく分かると思う。

ほんと、馬鹿じゃないかと思います。

ほんと、馬鹿じゃないかと思います。

#統計 そういうお馬鹿さん達が恥ずかしい思いをするようには十分になっていない理由についても、別口の件(算数教育問題)での経験から幾つか思っていることがあります。

こういうところにも我々の社会は改善の余地が残っているということなのでしょう。

こういうところにも我々の社会は改善の余地が残っているということなのでしょう。

#統計 サンプルを動かす平均ではなく、個々のサンプルごとに、真の予測誤差とAICで測ったその対応物の同時プロットが添付画像の上半分です(下半分はそのベイズ版)。

* 青線のサンプルから作った予測分布の真の予測誤差

と

* AICでのその対応物(AICの差)の破線

を比較!

nbviewer.jupyter.org/gist/genkuroki…

* 青線のサンプルから作った予測分布の真の予測誤差

と

* AICでのその対応物(AICの差)の破線

を比較!

nbviewer.jupyter.org/gist/genkuroki…

#統計

* 青線のサンプルから作った予測分布の真の予測誤差

と

* AICでのその対応物(AICの差)の破線

が見事に逆相関‼️(相関係数がほぼ-1‼️)。

AIC側の破線が0未満になるとモデル選択に失敗します。

横軸のスケールは確率に比例するように頑張ってちょうせつしてあります。

* 青線のサンプルから作った予測分布の真の予測誤差

と

* AICでのその対応物(AICの差)の破線

が見事に逆相関‼️(相関係数がほぼ-1‼️)。

AIC側の破線が0未満になるとモデル選択に失敗します。

横軸のスケールは確率に比例するように頑張ってちょうせつしてあります。

#統計 AICが予測誤差の小さな予測分布を選択するための情報量規準であるという予備知識だけがあって、AICの「真の顔」を見たことがない人達は、AICと真の予測誤差のきれいな逆相関に驚くと思います。

そのように思って欲しいのでグラフを紹介しています(笑)

百聞は一見に如かず!

そのように思って欲しいのでグラフを紹介しています(笑)

百聞は一見に如かず!

#統計 逆相関はベイズ版でもまったく同様です。

真の予測誤差とAICのサンプルを動かす平均はnが大きいときに一致するのですが、

揺らぎの方向は正反対

になることが証明されています。(渡辺澄夫『ベイズ統計の理論と方法』p.80下から10行目)

真の予測誤差とAICのサンプルを動かす平均はnが大きいときに一致するのですが、

揺らぎの方向は正反対

になることが証明されています。(渡辺澄夫『ベイズ統計の理論と方法』p.80下から10行目)

#統計 グラフの横軸のスケールは確率に比例し、AIC側の橙の破線が0未満になることとAICによるモデル選択の失敗は同値なので、モデル選択に失敗する確率は低いが、失敗確率は16%と仮説検定で要求されることが多い値の5%よりはかなり大きいです。

#統計 実はAIC側のグラフにあと

1.84=quantile(Chisq(1), 0.95) - 2

だけ上に持ち上げれば、0未満になる確率がちょうど5%程度になります。(対数尤度比検定に一致する!)

こういう感じでこのグラフから、AICによるモデル選択と仮説検定の関係も読み取れます。

1.84=quantile(Chisq(1), 0.95) - 2

だけ上に持ち上げれば、0未満になる確率がちょうど5%程度になります。(対数尤度比検定に一致する!)

こういう感じでこのグラフから、AICによるモデル選択と仮説検定の関係も読み取れます。

#統計 AICを使うモデル選択は、モデル達を対等に扱ってどれがもっともらしいかを判定する行為です。

それに対して、仮説検定は、帰無仮説のモデル側が選ばれ易くなるように下駄を履かせた場合(上での1.84の持ち上げが下駄を履かせることに相当)の「モデル選択」に相当しているわけです。

それに対して、仮説検定は、帰無仮説のモデル側が選ばれ易くなるように下駄を履かせた場合(上での1.84の持ち上げが下駄を履かせることに相当)の「モデル選択」に相当しているわけです。

#統計 そして、添付画像の下半分のベイズ版のグラフが上半分の最尤法版のグラフとほぼ同じであることから、ベイズ版のWAICやLOOCVを1.84上に持ち上げてやれば、有意水準5%仮説検定をベイズ統計を経由して行うこともできることが分かります。

#統計 以上のような話は、「仮説検定とモデル選択は全然違う」とか「仮説検定とベイズ統計は全然違う」とか、場合によっては「根拠となる主義・思想自体が違う」というような思い込みの毒を飲まされた人達にとって、良い解毒剤になり得ると思います。

#統計 グラフの解説を追加

どういう計算をやっているか

成功確率w=0.4の独立試行をn=100回行ったときに成功した回数kが横軸。データ「n回中k回成功」はこのようにして生成されているという設定。

横軸のスケールは成功確率w=0.4のときにn=100回中k回成功する確率に比例。

nbviewer.jupyter.org/gist/genkuroki…

どういう計算をやっているか

成功確率w=0.4の独立試行をn=100回行ったときに成功した回数kが横軸。データ「n回中k回成功」はこのようにして生成されているという設定。

横軸のスケールは成功確率w=0.4のときにn=100回中k回成功する確率に比例。

nbviewer.jupyter.org/gist/genkuroki…

#統計 続き

成功確率0.4でn=100回試すと、k=40回成功する確率が最も高くなる。だから、グラフ中の横軸の目盛の刻み幅(確率に比例)はk=40の周辺で広くなっており、k=40から離れるほど狭くなっている。

#Julia言語 のプロットライブラリにそのような機能はデフォルトでないので自分で実装した!

成功確率0.4でn=100回試すと、k=40回成功する確率が最も高くなる。だから、グラフ中の横軸の目盛の刻み幅(確率に比例)はk=40の周辺で広くなっており、k=40から離れるほど狭くなっている。

#Julia言語 のプロットライブラリにそのような機能はデフォルトでないので自分で実装した!

#統計 上段のグラフは、「n回中k回成功」というデータにベルヌイ分布模型の最尤法を適用した場合。

「最尤法」と書くと難しく見えてしまうかもしれないが、実際の計算では「n回中k回成功した」というデータから「成功確率はw=k/nである」と推定するだけです。最も単純な点推定です。

「最尤法」と書くと難しく見えてしまうかもしれないが、実際の計算では「n回中k回成功した」というデータから「成功確率はw=k/nである」と推定するだけです。最も単純な点推定です。

#統計 以下、真の成功確率をw₀=0.4と書き、データから推定した成功確率をw*=k/nと書くことにします。

このとき、真の分布は「確率w₀=0.4で成功する」で、データから最尤法で作った予測分布は「確率w*=k/nで成功する」です。そして、その予測分布の予測誤差をKL情報量で定義してやります。続く

このとき、真の分布は「確率w₀=0.4で成功する」で、データから最尤法で作った予測分布は「確率w*=k/nで成功する」です。そして、その予測分布の予測誤差をKL情報量で定義してやります。続く

#統計 予測誤差を意味するKL情報量の式は

KL = w₀ log(w₀/w*) + (1-w₀)log((1-w₀)/(1-w*))

です。上段のグラフの青線のPrediction Error of MLEはこのKLの値のグラフです。KLの値は w* = w₀ の予測分布と真の分布が一致するときに最小値の0になり、そこから離れると大きくなる。

KL = w₀ log(w₀/w*) + (1-w₀)log((1-w₀)/(1-w*))

です。上段のグラフの青線のPrediction Error of MLEはこのKLの値のグラフです。KLの値は w* = w₀ の予測分布と真の分布が一致するときに最小値の0になり、そこから離れると大きくなる。

#統計 上段の橙の破線は、ベルヌイ分布モデル(パラメータは1個)の最尤法に関するAIC(以下単にAICと書く)から、モデルとして真の分布(成功確率w₀=0.4)のAICにあたるもの(AIC₀)を引いた値のプロットです。

モデル選択ではAICが小さい方が選択されます。続く

モデル選択ではAICが小さい方が選択されます。続く

#統計 続き。だから、AIC < AIC₀ すなわち橙の破線の AIC - AIC₀ が負のとき、真の分布そのものではない、ベルヌイ分布モデルの側が選択され、正しいモデル選択に失敗してしまうことになります。

この場合にはAICでのモデル選択に失敗する確率は18%程度です。(上で16%としたのは誤り)

この場合にはAICでのモデル選択に失敗する確率は18%程度です。(上で16%としたのは誤り)

#統計 注意:実際にプロットしているのは、通常のKL情報量のスケールではなく、対数尤度比のχ²検定で使用されているスケールです。縦軸のスケールは自由度1のχ²分布のスケールとして意味を持っています。

#統計 成功確率w₀=0.4の真の分布と、成功確率w*=k/100の最尤法による予測分布の比較では、データでの100回中の成功回数が40から離れるに従って、真の分布よりも最尤法による予測分布の方がもっともらしく見えて来るのは当然で、その当然の感覚を橙の破線のAIC - AIC₀は適切に数値化している感じ。

#統計 正しいモデル選択をしたい人にとっては、AIC - AIC₀ が真の予測誤差と逆相関していることは不都合なのですが、データが運悪く偏っている場合とそうなる確率が高くてそうなった場合はデータを見他だけでは判別できないので、これは仕方がないことだと思います。

#統計 AICなどの道具を使っても、運悪く低確率で生じる偏ったデータのせいで正しい分析に失敗することは防げません。

統計学を他人に勧めることはギャンブルを勧めることなので、このようにどのようなときに賭けに負ける可能性があるかについて正直に説明しないと倫理的に問題があると思う。

統計学を他人に勧めることはギャンブルを勧めることなので、このようにどのようなときに賭けに負ける可能性があるかについて正直に説明しないと倫理的に問題があると思う。

#統計 以上のように実際にAICをプロットして、AICを使ったモデル選択について説明して、「勝率は悪くないが、運悪くデータが偏っていると賭けに負ける」という話まで説明すれば、私が「各分野固有の専門知識は非常に重要である」と言わざるを得なくなることは必然であることも理解できると思う。

#統計 AIC - AIC₀ の最大値が2になっているの理由は、パラメータが1個の場合のAICの定義によってパラメータの個数の2倍の2が足されているから。

AICとAIC₀の定義についてはソースコードを参照↓

nbviewer.jupyter.org/gist/genkuroki…

AICとAIC₀の定義についてはソースコードを参照↓

nbviewer.jupyter.org/gist/genkuroki…

#統計 この手の統計学の知識は、

ギャンブルに勝つために役に立つ道具であること

や

どのような場合にギャンブルに負けることになるか

を十分に理解していてかつ、

応用先の分野についての強力な専門知識を持っている人

が使った場合に特に力を発揮するように思えます。

ギャンブルに勝つために役に立つ道具であること

や

どのような場合にギャンブルに負けることになるか

を十分に理解していてかつ、

応用先の分野についての強力な専門知識を持っている人

が使った場合に特に力を発揮するように思えます。

#統計 【重要】AICについて「モデルを複雑にすることによってモデルのデータへの適合度を上げても予測精度は下がる場合がある」というような話をするだけでは、AICと真の予測誤差がきれいに逆相関しているという重要な事実を無視してしまうので個人的に良くないと思う。具体的な計算例が大事。【重要】

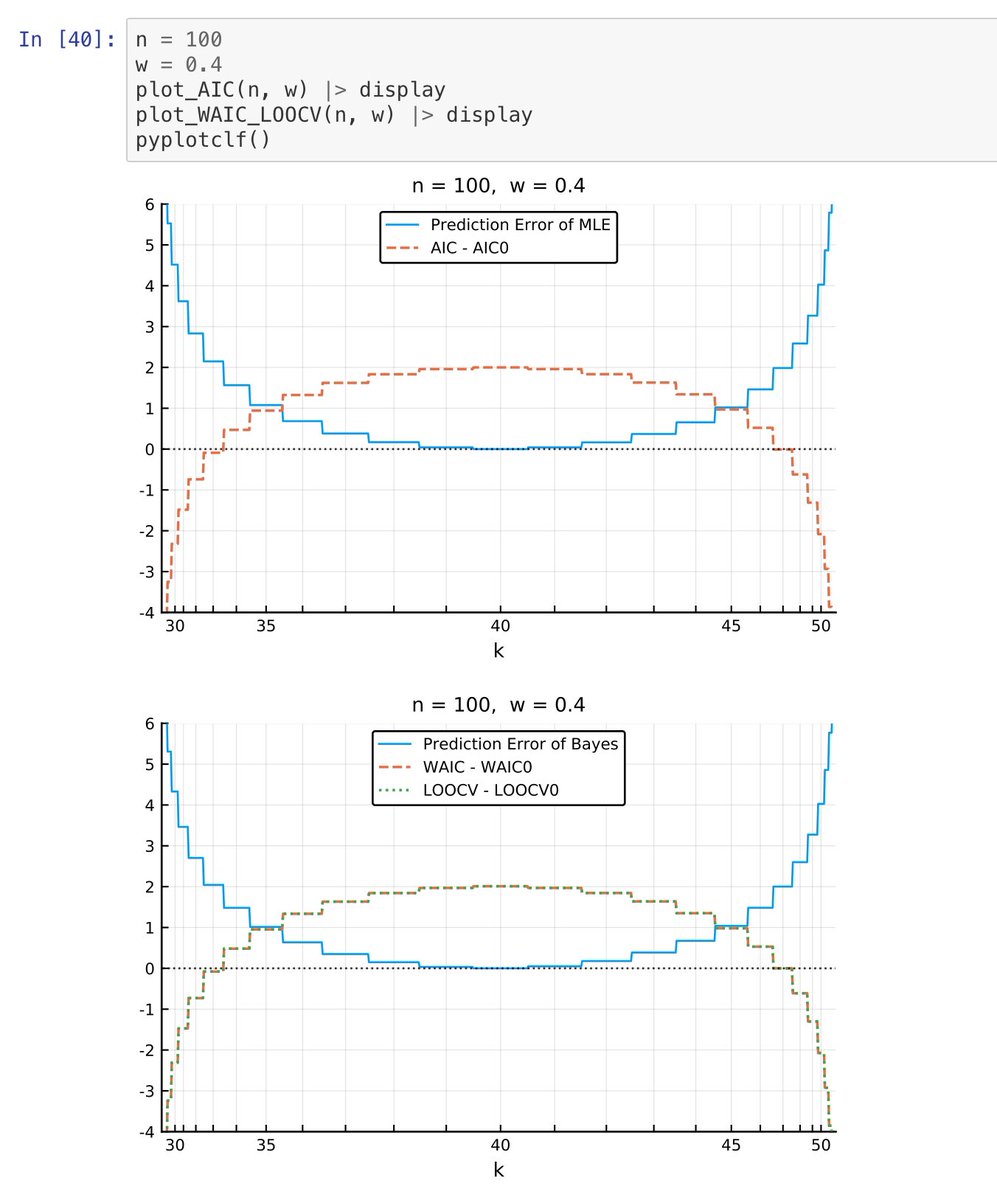

#統計 『統計学を哲学する』のp.147から「AICの哲学的含意」を説明している部分を引用。説明が杜撰なのでコメントしておきます。

①【真実を「歪めた」ないし省略したモデルの方】という言い方を躊躇することなく言うのはやめた方が良いです。

なぜならば~続く

①【真実を「歪めた」ないし省略したモデルの方】という言い方を躊躇することなく言うのはやめた方が良いです。

なぜならば~続く

#統計 続き。なぜならば、現実の統計分析では、データを生成している真の法則は闇の中でずっと不明のままになるからです。

AICで選択されたモデルが、真の法則をよい近似を含んでいるから選ばれたのか、それともパラメータ数を抑えたお陰で過剰適合を免れたから選ばれたのかは闇の中。

AICで選択されたモデルが、真の法則をよい近似を含んでいるから選ばれたのか、それともパラメータ数を抑えたお陰で過剰適合を免れたから選ばれたのかは闇の中。

#統計 ②あと、パラメータの少ない簡素なモデルの方が【良い予測を行う場合がある】の前に【長期的には】という但し書きが付いている理由も不明。

もしかして無限の未来までデータを取得し続けて大数の法則を使うことを想定している?もしもそうならひどい誤解。

もしかして無限の未来までデータを取得し続けて大数の法則を使うことを想定している?もしもそうならひどい誤解。

#統計 パラメータが少ない簡素化されたモデルはノイズを学習してしまうリスクが小さくなる分だけ、予測性能が上がる可能性があります。

しかし、簡素化したせいで、そのモデルで実現できる真の分布の最良の近似の誤差が大きくなってしまうリスクは増える。

その両方に配慮しているのがAICです。

しかし、簡素化したせいで、そのモデルで実現できる真の分布の最良の近似の誤差が大きくなってしまうリスクは増える。

その両方に配慮しているのがAICです。

#統計 もう一度強調しておきますが、データを生成している真の法則は現実の統計分析では闇の中。ずっとわからないままになる。

その未知の法則に扱い易い条件(例えばi.i.d.とか)を想定した数学的に一般的な議論でAICの有用性がわかる仕組みになっています。

その未知の法則に扱い易い条件(例えばi.i.d.とか)を想定した数学的に一般的な議論でAICの有用性がわかる仕組みになっています。

#統計 AICの導出で想定されている条件をデータを生成している未知の法則が小さな誤差で満たしていれば、長期的であるか否かと無関係に、AICを使ったモデル選択のギャンブルに勝つ可能性は結構高いです。

どうして【長期的には】という但し書きが付いているのか不明過ぎ。

どうして【長期的には】という但し書きが付いているのか不明過ぎ。

#統計 パラメータを増やしたモデルの最尤法の数値実験を繰り返したことがある人なら、パラメータを増やすとパラメータの値が暴れ易くなって「大変なこと」になり易いことをよく知っているはずです。

それを知っていれば【パラドキシカル】(pp.146-147にある言葉)に思うこと自体がおかしい。

それを知っていれば【パラドキシカル】(pp.146-147にある言葉)に思うこと自体がおかしい。

#統計 ③この本のp.144以降にある「平均対数尤度」は「平均汎化誤差の-1倍」を意味しているようだ。汎化誤差は、予測分布の密度函数の対数の真の分布に関する平均の-1倍。さらに予測分布は真の分布のサンプルに依存して決まるので、真のサンプル分布についての汎化誤差の平均を考えることができる。

#統計 ②追加。【長期的に】安定な法則について【長期的に】予測を出して確認し続ければ、【長期的に】安定な法則に関する新たなデータがたまりまくることになる。新たなデータも利用した方がお得(笑)。

どうして【長期的には】と但し書きを付けたのか?

どうして【長期的には】と但し書きを付けたのか?

#統計 ④p.149以降にある【AICは真なる分布からの距離を測るものである】という単純に間違っている主張(正しいのは実践的には計算不可能なKL情報量が真の分布とモデルで作った分布の距離を表す)についての【リアル・パターン】論は単なるたわごとだと思いました。

#統計 p.144-145の毎年1000人のデータを集める話も奇妙だったが(添付画像1)、その奇妙な話を図にしたと思われるものがp.150にあった(添付画像2)。

どうも【長期的には】という但し書きは本当にそう思っていて書かれた可能性が高い。

どうも【長期的には】という但し書きは本当にそう思っていて書かれた可能性が高い。

#統計 普通の考え方を再度復習。

データY_1,Y_2,…は未知の分布q(y)のi.i.d.として生成されていると想定する。

やりたいことは、データY_1,…,Y_nが既知になったときに、そのデータから次のY_{n+1}の確率分布を推測することである。

この基本設定が分かっていれば奇妙な説明にはならないはず。続く

データY_1,Y_2,…は未知の分布q(y)のi.i.d.として生成されていると想定する。

やりたいことは、データY_1,…,Y_nが既知になったときに、そのデータから次のY_{n+1}の確率分布を推測することである。

この基本設定が分かっていれば奇妙な説明にはならないはず。続く

#統計 正則性その他の条件を満たす統計モデルp(y|θ)を使った最尤法では、尤度函数 L(θ)=p(Y_1|θ)…p(Y_n|θ)を最大化するパラメータθ*を求めて、p*(y)=p(y|θ*)をその次のY_{n+1}の分布の推測結果だとする。p*(y)=p(y|θ*)は予測分布と呼ばれる。続く

#統計 上の設定ではY_{n+1}の真の分布は未知のq(y)である。

予測分布による真の分布のシミュレーションの誤差はSanovの定理より、KL情報量

D(q||p*) = ∫q(y)log(q(y)/p*(y))dy

で測られる。これは汎化誤差

G(q||p*) = -∫q(y)log p*(y) dy

と定数差しかないので、~続く

予測分布による真の分布のシミュレーションの誤差はSanovの定理より、KL情報量

D(q||p*) = ∫q(y)log(q(y)/p*(y))dy

で測られる。これは汎化誤差

G(q||p*) = -∫q(y)log p*(y) dy

と定数差しかないので、~続く

#統計 続き~、汎化誤差を最小化すれば予測分布の真の分布に対する誤差も最小化される。

しかし、汎化誤差は未知の真の分布q(y)を使って定義されているので、実践的には計算不可能。

だから、データY_1,…,Y_nのみを使って計算できる代替物を見つけたい。続く

しかし、汎化誤差は未知の真の分布q(y)を使って定義されているので、実践的には計算不可能。

だから、データY_1,…,Y_nのみを使って計算できる代替物を見つけたい。続く

#統計 その代替物として有名なのがAICである。しかし、ずっと上の方のベルヌーイ分布モデルの場合のように、nを大きくすると、AICと汎化誤差は逆相関するので、AICは汎化誤差の推定値としても平均汎化誤差の推定値としても一致性を持たない。続く

#統計 しかし、上の方で紹介した例では、AICを使うと正しいモデル選択に82%程度の確率で成功し、18%の確率でひどく予測を外しまくる結果の方を選択することになる。

AICによるモデル選択の実態はこういうものである。

AICによるモデル選択の実態はこういうものである。

#統計 Bernoulli分布モデル(これより易しい例はない‼️😊)の場合のAICについてはこのスレッドの上の方の以下のリンク先の前後を参照せよ。

そこではAICに関する真実が説明されている。

そこではAICに関する真実が説明されている。

https://twitter.com/genkuroki/status/1323514902435127297

#統計 AICが間違ったモデルを選択してしまう場合が生じる理由は、運悪くサンプルが偏ってしまい、偏ったサンプルにオーバーフィットした側のモデルの方がAICが低くなってしまう場合があるから。

そうなる確率はそれなりに低いのですが、真実から大きくかけ離れた予測分布の側を選択してしまいます。

そうなる確率はそれなりに低いのですが、真実から大きくかけ離れた予測分布の側を選択してしまいます。

#統計 あるシンプルなケースでAICによるモデル選択が失敗する確率は十数パーセントになり、失敗したときの予測の外し方は非常に大きくなります。

我々の社会のリスクに関わる事柄を扱う場合にはマジで要注意だと思います。

他人にギャンブルを勧める人はリスクも強調しないと倫理的に問題がある。

我々の社会のリスクに関わる事柄を扱う場合にはマジで要注意だと思います。

他人にギャンブルを勧める人はリスクも強調しないと倫理的に問題がある。

#統計 真の予測誤差に逆相関するというAICとその仲間達の普遍的な数学的性質を知っていて、そのリスクについても正直に触れることが重要だという立場で、件の本のAICの哲学的含意の説明を読むことがどれだけ辛いことであるかを想像してみて欲しいです。

#統計 こういう感じで「売れ線の本」を酷評するようなことを私だって本当はしたくないのですが、AICなどに関する数学や数値実験の結果とソースコードを保有公開しているような人でなければ、このスレッドに書いたような警告を出すのは無理だと思う。

他に誰がいる?

他に誰がいる?

#統計 実践的な統計学の応用では、真の法則がずっと不明のままであり、選択したモデルを実際に応用しまくるまで、サンプルが運悪く偏っていたせいでモデル選択にひどく失敗していたことに気付くことはないのです。

各分野固有の専門知識による防波堤を築くことは非常に重要です。

各分野固有の専門知識による防波堤を築くことは非常に重要です。

#統計 p.83に【分布族が対象を十全にモデル化】していなくても【ある弱い前提さえおけば、ベイズ流の更新プロセスは最終的に真理へと到達しうる】と書いてあるのですが、この部分は相当にまずい。

【Earman, 1992, pp.144-149】に何が書いてある?

ミスリーディングな要約をしているのでは?続く

【Earman, 1992, pp.144-149】に何が書いてある?

ミスリーディングな要約をしているのでは?続く

https://twitter.com/genkuroki/status/1322895550367232001

#統計 極端な話として、パラメータを1つも持たない分布族=固定された確率分布で真の分布と違うものを採用すれば、ベイズ更新しての何も更新されず、真実とは異なる固定された確率分布がそのまま予測分布として固定されたままになります。続く

#統計 もしも仮に未知の分布q(y)の無限に長いi.i.d. Y_1, Y_2, Y_3, … が得られたならば、ベイズ統計とは無関係に、未知だった分布 q(y) が分かってしまいます。

しかし、これは理想化され過ぎた設定を採用しているので、推測統計学的には意味がないです。

しかし、これは理想化され過ぎた設定を採用しているので、推測統計学的には意味がないです。

#統計 データが未知の分布q(y)のi.i.d.として生成されているという想定で、統計モデルp(y|θ)を使った未知の分布q(y)の推測を行うときの限界は、分布族p(y|θ)内の分布でq(y)を最良近似するものになる。ベイズであろうがなかろうが同じ。

モデルで実現可能な分布の範囲内での最良の結果が限界になる。

モデルで実現可能な分布の範囲内での最良の結果が限界になる。

#統計 以下のリンク先の動画はモデルの範囲内での最良の結果にベイズ更新が収束している例になっています。

しかし、モデルが真実の分布を含まないので、べいず更新の収束先は真実から程遠いものになっている。

こういう例の視覚化はこのスレッドに他にも色々あります。

こういう例が大事。

しかし、モデルが真実の分布を含まないので、べいず更新の収束先は真実から程遠いものになっている。

こういう例の視覚化はこのスレッドに他にも色々あります。

こういう例が大事。

https://twitter.com/genkuroki/status/1322893535549431809

#統計 【分布族が対象を十全にモデル化】していなくても【ある弱い前提さえおけば、ベイズ流の更新プロセスは最終的に真理へと到達しうる】(p.83)という説をとなえるのは、さすがに非常識的過ぎる。

他人にこの本を紹介するときには、この手の事柄について警告しておかないと非常にまずいです。

他人にこの本を紹介するときには、この手の事柄について警告しておかないと非常にまずいです。

#統計 【確率変数が持つ分布を特徴付ける値を、その期待値~という】(p.31)という説明の仕方もひどい。本当にそう書いてあります!

統計学では「確率分布を特徴づけるパラメータ」という言い方が頻出なので常識があればこういう説明の仕方はできなかったはず。

統計学では「確率分布を特徴づけるパラメータ」という言い方が頻出なので常識があればこういう説明の仕方はできなかったはず。

https://twitter.com/genkuroki/status/1323135501851766785

#統計 p.17の図1.1の【「Major axis」と表示されているのが回帰直線】はひどいデタラメ。

p.139で【最尤法の他】に【最小二乗法】があるかのように書いていますが、最小二乗法による回帰は最尤法の特別な場合。

pp.142-143では

回帰の誤差項εの平均がμ‼️

という設定を採用😭

色々非常識的過ぎ

p.139で【最尤法の他】に【最小二乗法】があるかのように書いていますが、最小二乗法による回帰は最尤法の特別な場合。

pp.142-143では

回帰の誤差項εの平均がμ‼️

という設定を採用😭

色々非常識的過ぎ

https://twitter.com/genkuroki/status/1323309477995581440

#統計 【誤差項ε】について

【M₁: y = β₁ x₁ + ε, ε ~ N(μ₁, σ₁²)】(p.142)

【ただし、ε ~ N(μ, σ²) は誤差項εが平均μ、分散σ²の正規分布に従う、ということを示している】(p.143)

と書いてあることには

ε→∞

と似た可笑しさがあると思う。🤣

「誤差項ε」なのに!😅

【M₁: y = β₁ x₁ + ε, ε ~ N(μ₁, σ₁²)】(p.142)

【ただし、ε ~ N(μ, σ²) は誤差項εが平均μ、分散σ²の正規分布に従う、ということを示している】(p.143)

と書いてあることには

ε→∞

と似た可笑しさがあると思う。🤣

「誤差項ε」なのに!😅

https://twitter.com/genkuroki/status/1323307933585690624

#統計 回帰モデル

y = β₀ + β₁ x₁ + β₂ x₂ + ε, ε~Normal(0, σ²)

におけるεは「残差」と呼ばれます。

「残差」を気楽に「誤差」と呼んでしまうこと自体は許されても、「回帰モデルの期待値と観測値の差またはそのモデル化」と「真の値と観測値の差」を混同するのは非常にまずいです。

y = β₀ + β₁ x₁ + β₂ x₂ + ε, ε~Normal(0, σ²)

におけるεは「残差」と呼ばれます。

「残差」を気楽に「誤差」と呼んでしまうこと自体は許されても、「回帰モデルの期待値と観測値の差またはそのモデル化」と「真の値と観測値の差」を混同するのは非常にまずいです。

#統計 『統計学を哲学する』p.149でのAICに関する説明はずさん過ぎてひどいので読者は注意した方がよい。

この本を素晴らしいと言っている人達は「馬脚を現した」とみなして、その人が今後統計学がらみのことを言っていても、内容のまともさを疑うようにした方がよい。

この本を素晴らしいと言っている人達は「馬脚を現した」とみなして、その人が今後統計学がらみのことを言っていても、内容のまともさを疑うようにした方がよい。

https://twitter.com/genkuroki/status/1323639788805652482

#統計 『統計学を哲学する』p.149でのAICに関する説明はずさん。

モデルで記述できる法則の中に真の法則をよりよく近似するものが含まれているかどうかと、データを用いてそのようなものを実際に見付けることができるかどうか全然違う問題。

その区別を前面に出さずに説明するのはまずい。続く

モデルで記述できる法則の中に真の法則をよりよく近似するものが含まれているかどうかと、データを用いてそのようなものを実際に見付けることができるかどうか全然違う問題。

その区別を前面に出さずに説明するのはまずい。続く

#統計 モデルで記述できる法則の中に真の法則をよりよく近似するものが含まれているかどうかと、そのようなものを実際に見付けることができるかどうかを区別するという当たり前の話を当たり前に聞こえるように説明するのではなく、それらを混同し易くした上でそれらの区別に関わる説明をするのは悪質。

#統計 パラメータを増やしてどんどんモデルを複雑にして行けば、その中に真の法則をよりよく近似するものが含まれる可能性は増えます。

しかし、限られたデータを使った推定では、モデルの複雑化が原因のオーバーフィッティングが起こって、大外しの推定しかできなくなる危険性が増す。続く

しかし、限られたデータを使った推定では、モデルの複雑化が原因のオーバーフィッティングが起こって、大外しの推定しかできなくなる危険性が増す。続く

#統計 続き。その2つのバランスを取って、予測分布の予測誤差がより小さくなる可能性が高くなるようなモデル選択を目指すための道具の1つがAICです。

「バランスを取る」という説明がバランスの取れた誤解されない説明の仕方だと思います。

『統計学を哲学する』の説明はバイアスをかけすぎ(笑)

「バランスを取る」という説明がバランスの取れた誤解されない説明の仕方だと思います。

『統計学を哲学する』の説明はバイアスをかけすぎ(笑)

#統計 そして何よりもまずいのは、AICを使ったモデル選択がどのように失敗するかについて説明しようとしていないことです。

ある種の場合に、AICは小さいが無視できない確率で(私が示した例では十数%)、予測誤差が非常に大きな予測分布を与えたモデルの側を選択します。

この事実は非常に重要!

ある種の場合に、AICは小さいが無視できない確率で(私が示した例では十数%)、予測誤差が非常に大きな予測分布を与えたモデルの側を選択します。

この事実は非常に重要!

https://twitter.com/genkuroki/status/1323649332214550528

#統計

* AICはバランスを取っていること

および

* AICは小さいが無視できない確率で(私が示した例では十数%)、予測誤差が非常に大きな予測分布を与えたモデルの側を選択してしまうこと

を理解していれば、『統計学を哲学する』における「AICの哲学的含意」は薄っぺらなものに見えるはずです。

* AICはバランスを取っていること

および

* AICは小さいが無視できない確率で(私が示した例では十数%)、予測誤差が非常に大きな予測分布を与えたモデルの側を選択してしまうこと