Interview de l'avocat Grégoire Weigel, ex-Chef de département en charge du #Pluralisme de l'information et des Campagnes électorales au Conseil Supérieur de l'Audiovisuel (CSA) de 2007 à 2014 sur le comptage du temps d'antenne d'Eric #Zemmour imposé à #Facealinfo sur @CNEWS.

L'avocat Grégoire Weigel, ex-juriste au #CSA sur le comptage du temps d'antenne d'Eric #Zemmour imposé à #Facealinfo sur @CNEWS interroge ce que veut dire la notion "d'acteur du débat politique national" pour les intellectuels: seront-ils aussi décomptés ?

L'avocat Grégoire Weigel, ex-juriste au #CSA explique que mécaniquement le décompte du temps de parole d'Eric #Zemmour augmente le temps de parole de l’exécutif et diminue le temps de parole de l'opposition et de la majorité parlementaire.

Révélations sur les pressions politiques exercées par la gauche sur le #CSA, lorsque Christine Kelly en était membre, pour décompter le temps de parole du journaliste Eric Brunet, réputé être de la droite libérale.

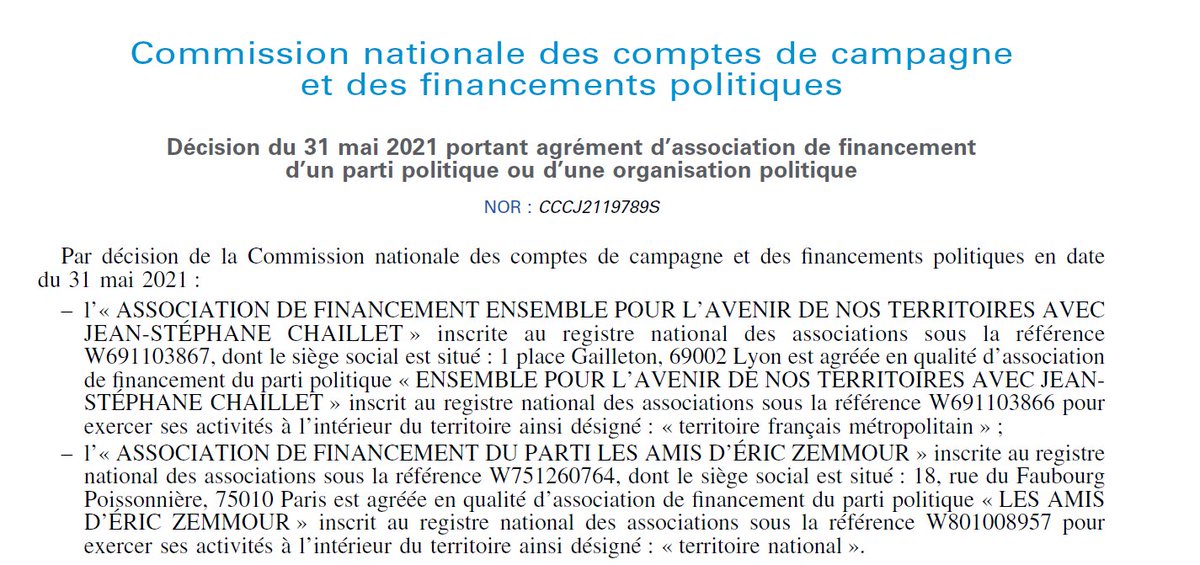

Il faut toutefois noter que l'association de financement électoral nommée “Les Amis d’Eric #Zemmour” qui a été officiellement agréée par la Commission nationale des comptes de campagne peut s’apparenter à un parti politique, ce qui ouvre la voie à un décompte du temps de parole.

Mais l'angle juridique du #CSA est différent: Comment définir un « acteur du débat politique national » ? 🤔

Vraie question.

Vraie question.

• • •

Missing some Tweet in this thread? You can try to

force a refresh