💥Redirecciones entre archive.org y tu sitemap💥

He creado un Google Colab para que puedas acelerar la definición de redirecciones entre urls en archive.org y tu sitemap.

Es GRATIS y lo único que necesitas es una cuenta de Google.

He creado un Google Colab para que puedas acelerar la definición de redirecciones entre urls en archive.org y tu sitemap.

Es GRATIS y lo único que necesitas es una cuenta de Google.

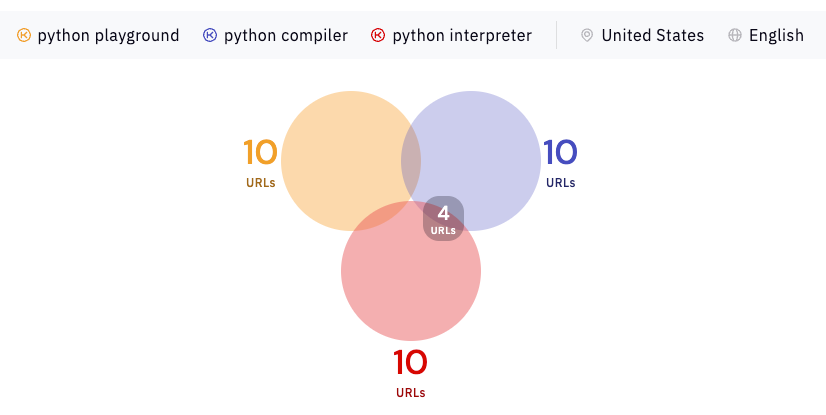

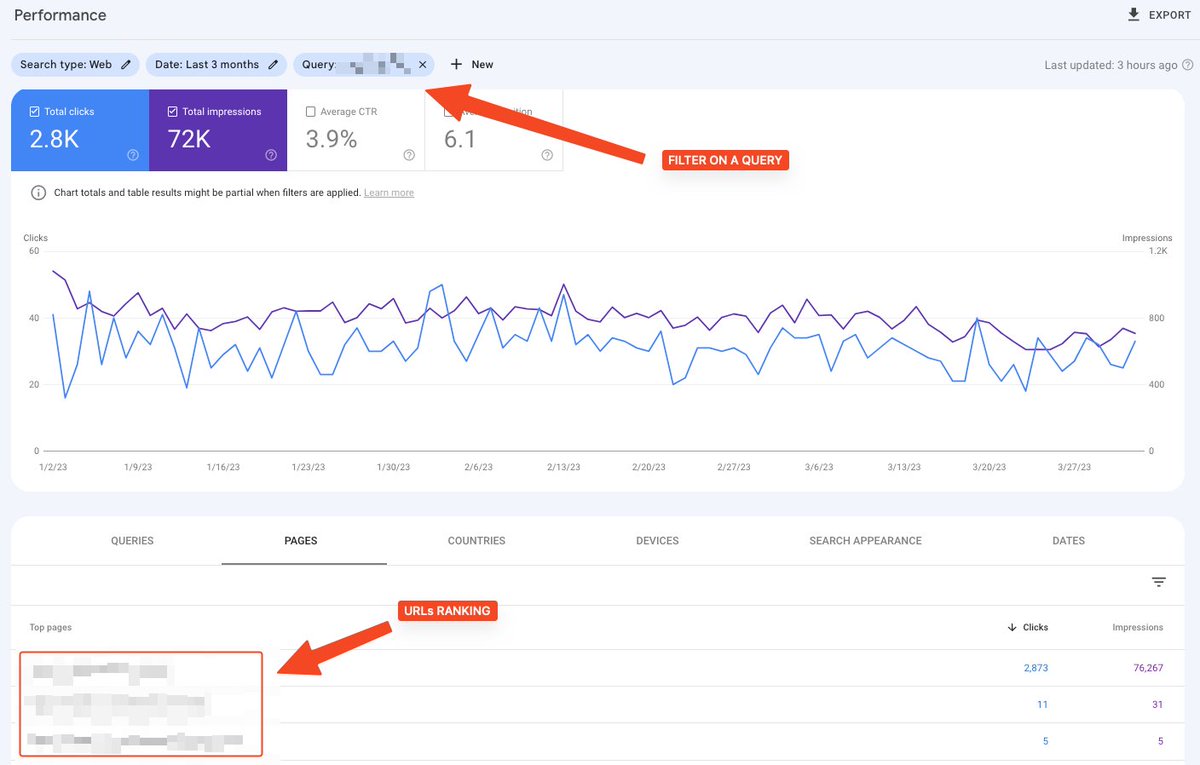

Esta tarea suele ser necesaria en caso de una migración mal hecha. En este caso, tienes que implementar redirecciones entre el histórico (archive.org) y el actual (tu sitemap).

Otras fuentes pueden existir (GA, GSC, …) y las podría agregar si te pueden servir.

Otras fuentes pueden existir (GA, GSC, …) y las podría agregar si te pueden servir.

Ahora, esta tarea es un coñazo y muchas veces hay una similitud entre la estructura de las URLs del histórico y actuales.

Por lo tanto, podemos intentar acelerar esta tarea con una simple automatización.

Por lo tanto, podemos intentar acelerar esta tarea con una simple automatización.

Etapa 1: Accede a colab.research.google.com/drive/1LvUbdff… y haz un copia del documento

Etapa 2: rellena las variables

1. Tu dominio

2. La URL de tu sitemap (o sitemap index)

3. La similitud mínima que deseas para que dos URLs se consideren equivalentes

He puesto valores de ejemplo con un proyecto que conozco un poco para que puedas ver resultados.

1. Tu dominio

2. La URL de tu sitemap (o sitemap index)

3. La similitud mínima que deseas para que dos URLs se consideren equivalentes

He puesto valores de ejemplo con un proyecto que conozco un poco para que puedas ver resultados.

La similitud (entre 0 y 100) usa el algoritmo TF-IDF. Suelo usar un valor entre 40 y 60 para tener resultados decentes, pero realmente depende del proyecto.

Si te interesa tener más detalles sobre el algoritmo, puedes mirar maartengr.github.io/PolyFuzz/tutor….

Si te interesa tener más detalles sobre el algoritmo, puedes mirar maartengr.github.io/PolyFuzz/tutor….

Etapa 3: Ejecuta el código usando el menú: Runtime > Run all

Como siempre, he agregado comentarios (en inglés) para que se entienda el código y la lógica.

Como siempre, he agregado comentarios (en inglés) para que se entienda el código y la lógica.

Etapa 4: Analiza los resultados

Ten en cuenta que:

* Muchas URLs no aparecerán. Es normal porque hay mucha basura en archive.org y no siempre hay un equivalente decente en tu sitemap

* No se comprueban los códigos de estado actuales en ningún momento

Ten en cuenta que:

* Muchas URLs no aparecerán. Es normal porque hay mucha basura en archive.org y no siempre hay un equivalente decente en tu sitemap

* No se comprueban los códigos de estado actuales en ningún momento

Si lo deseas, puedes descargar la tabla completa.

Te aconsejo que hagas una revisión manual: la idea es ahorrar tiempo, no que el sistema te haga todo solo y que no tengas que comprobar nada 😅

Te aconsejo que hagas una revisión manual: la idea es ahorrar tiempo, no que el sistema te haga todo solo y que no tengas que comprobar nada 😅

• • •

Missing some Tweet in this thread? You can try to

force a refresh