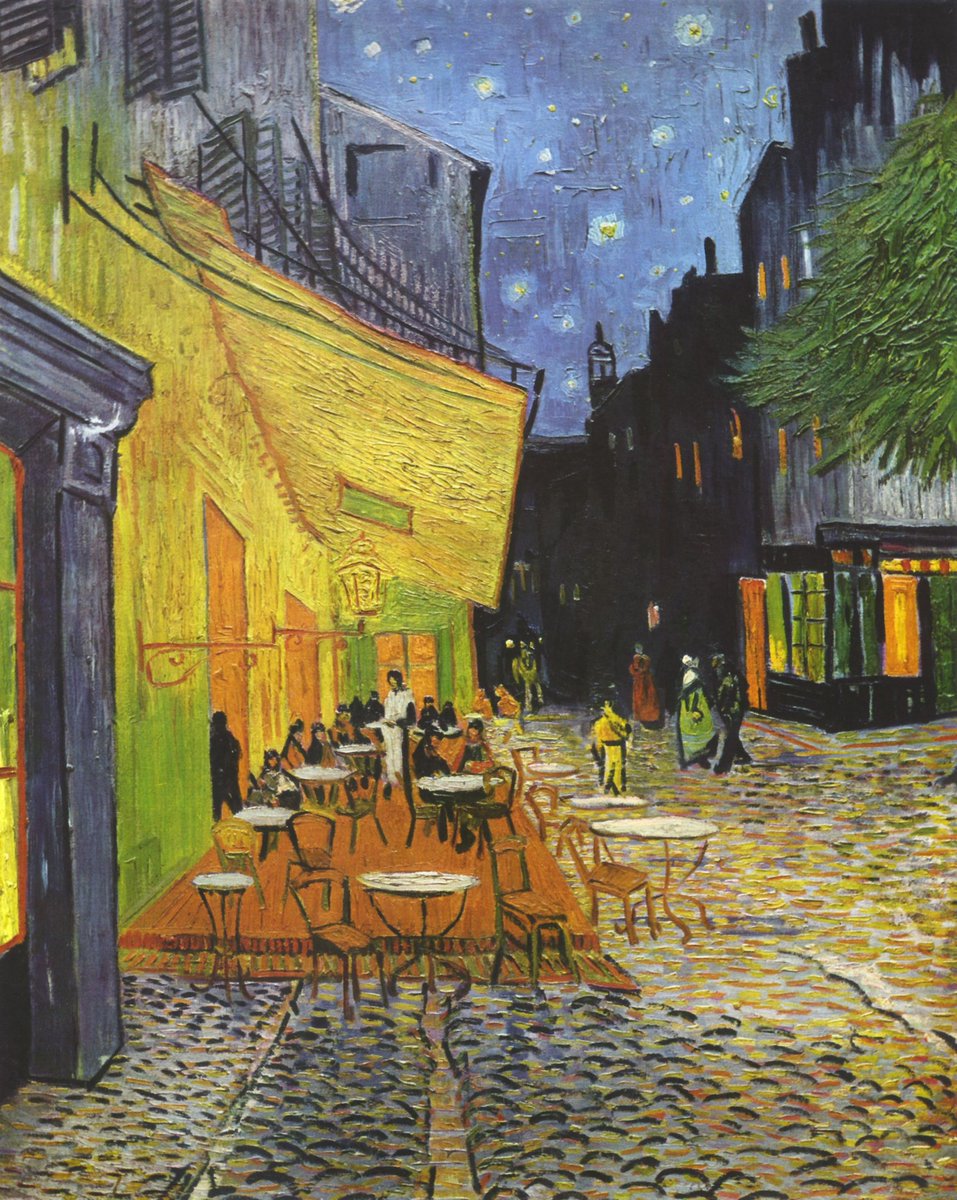

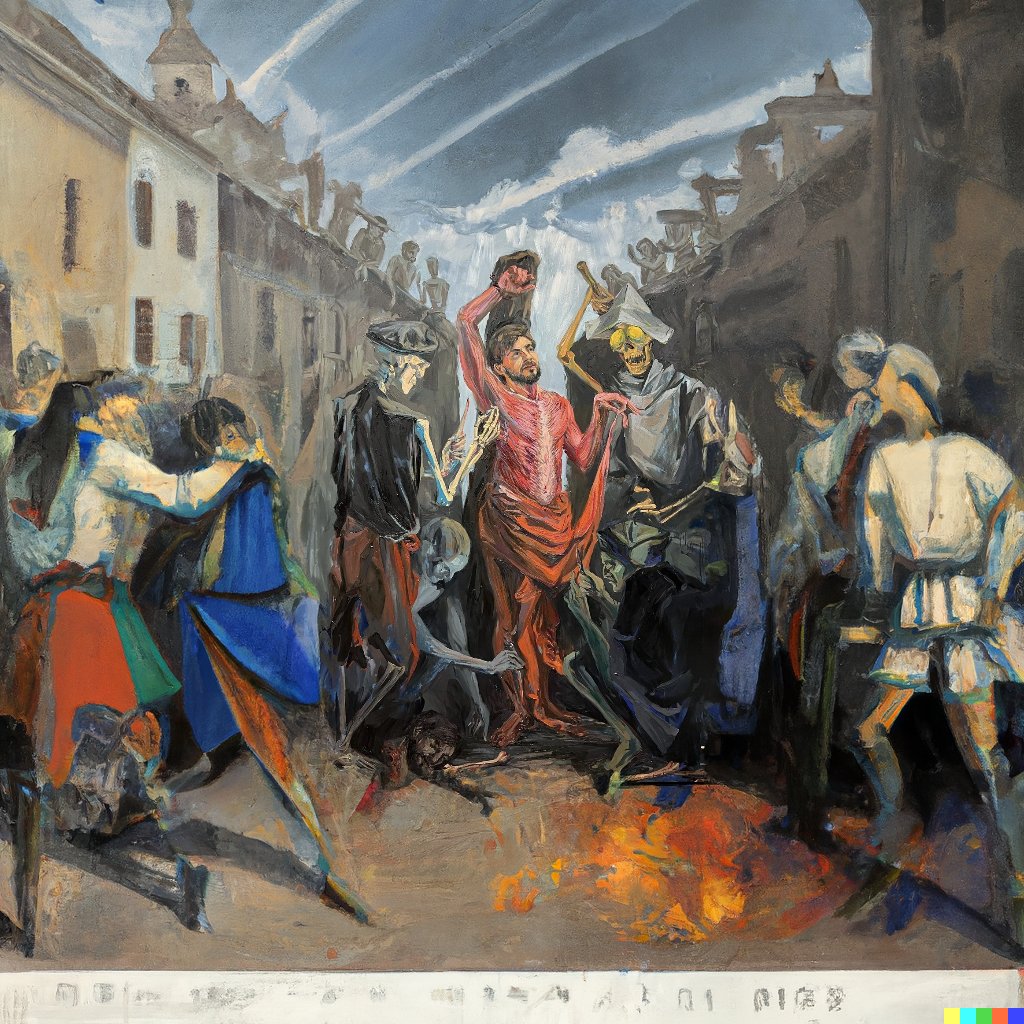

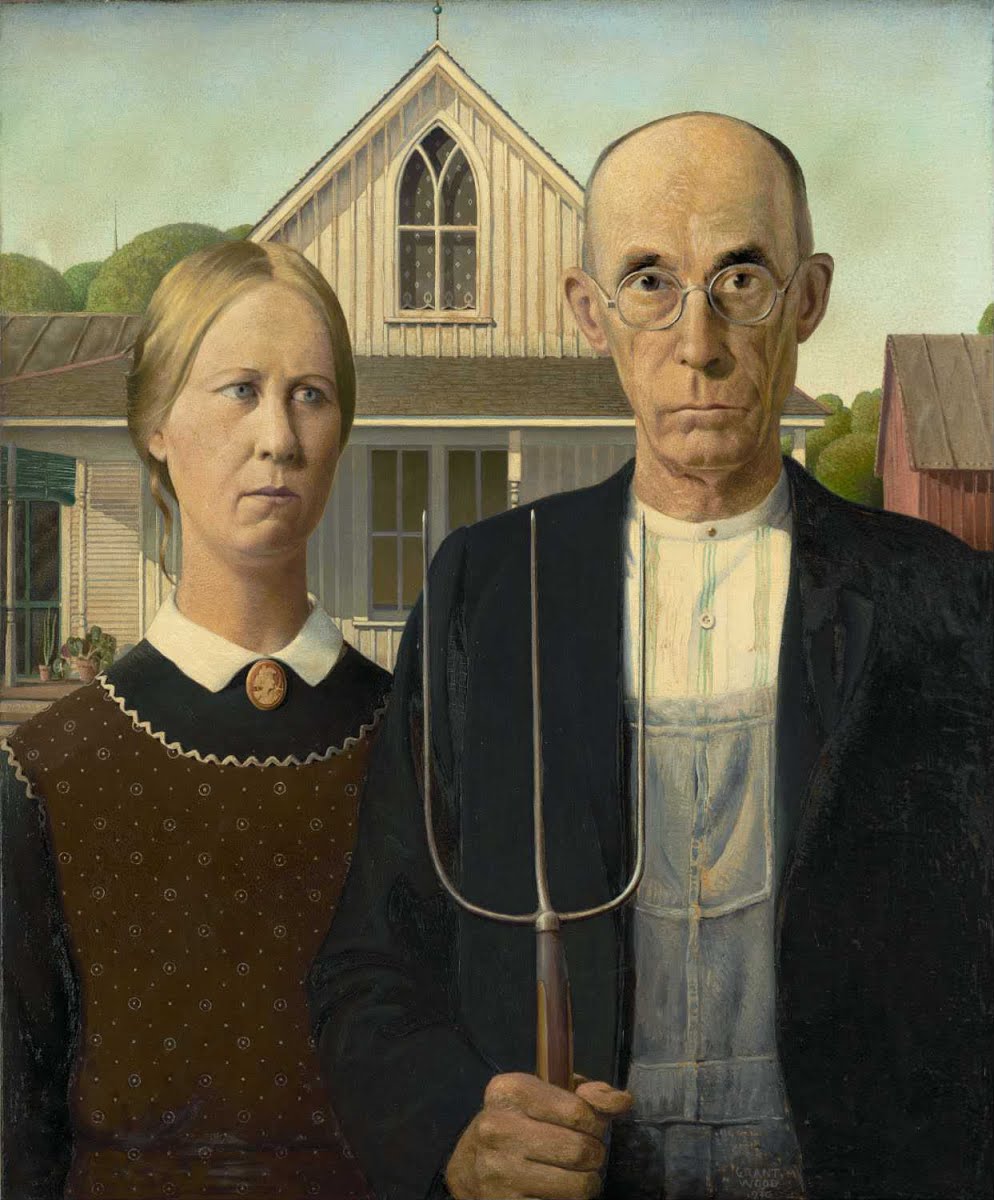

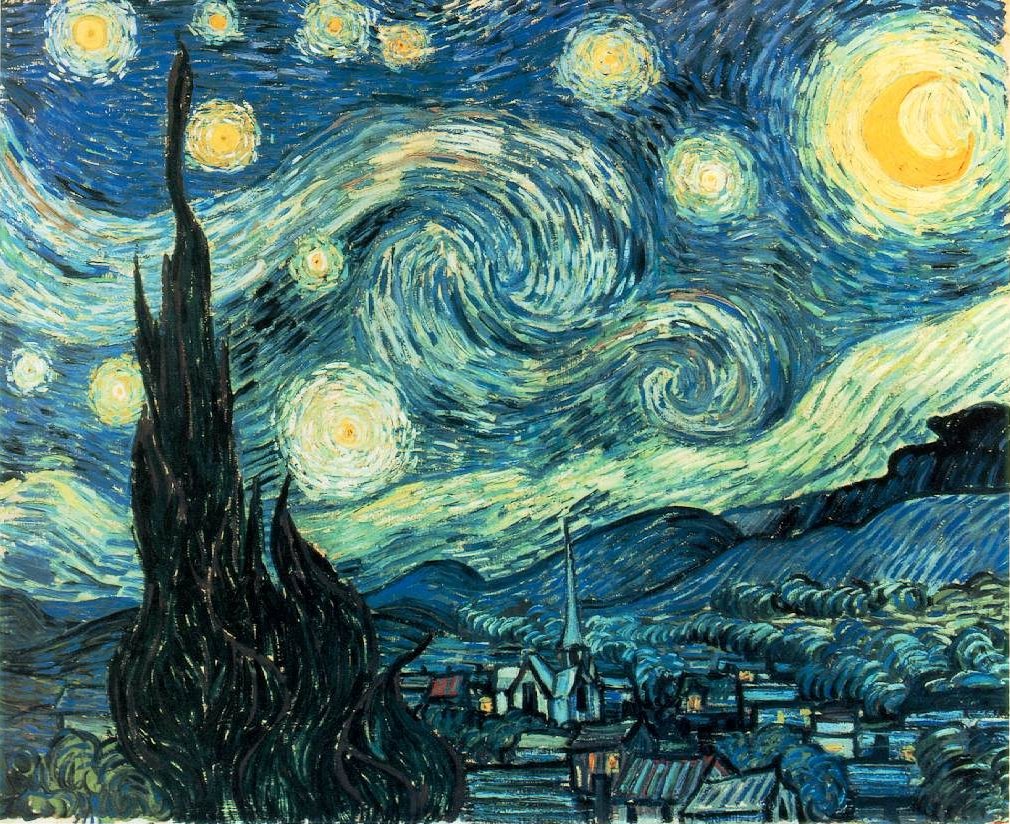

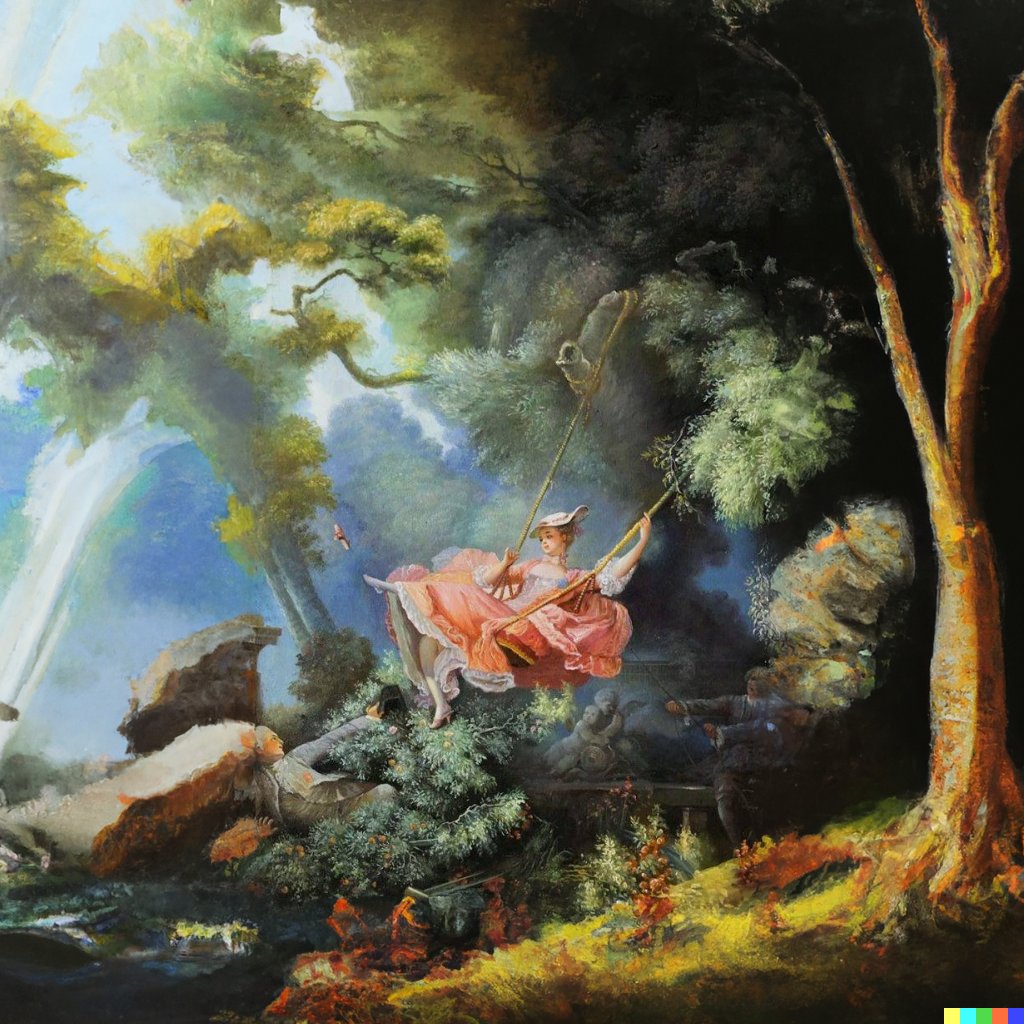

Acostumbramos a ver cuadros famosos por como se muestran en el museo, pero lo que muchos desconocen es cómo eran estas obras en sus lienzos originales.

Este quizá sea uno de los casos más llamativos, dejando en el olvido aquello que se decía de "La Luna Mona" 👇

#dalle2

Este quizá sea uno de los casos más llamativos, dejando en el olvido aquello que se decía de "La Luna Mona" 👇

#dalle2

O el famoso grito de Munch, una obra mucho más perturbadora cuando ampliamos el plano.

Así grito hasta yo...

Así grito hasta yo...

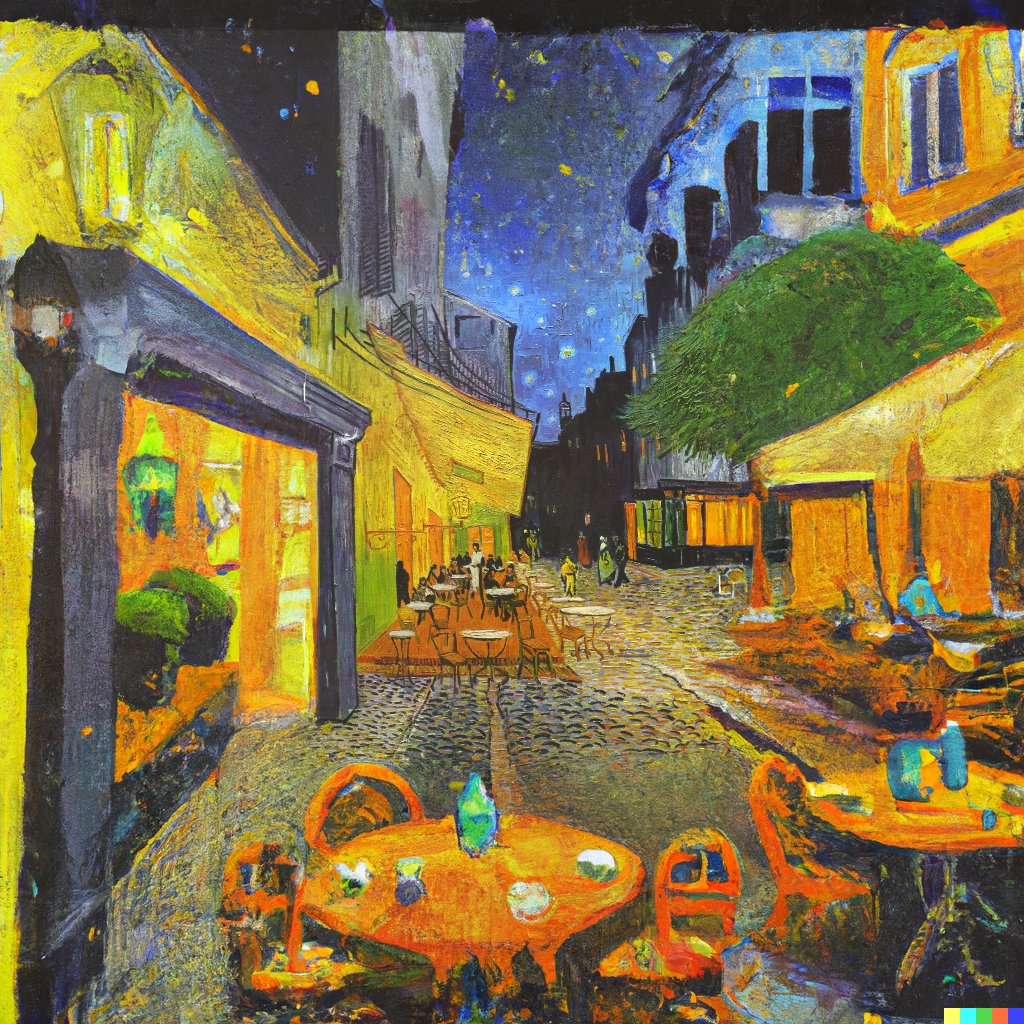

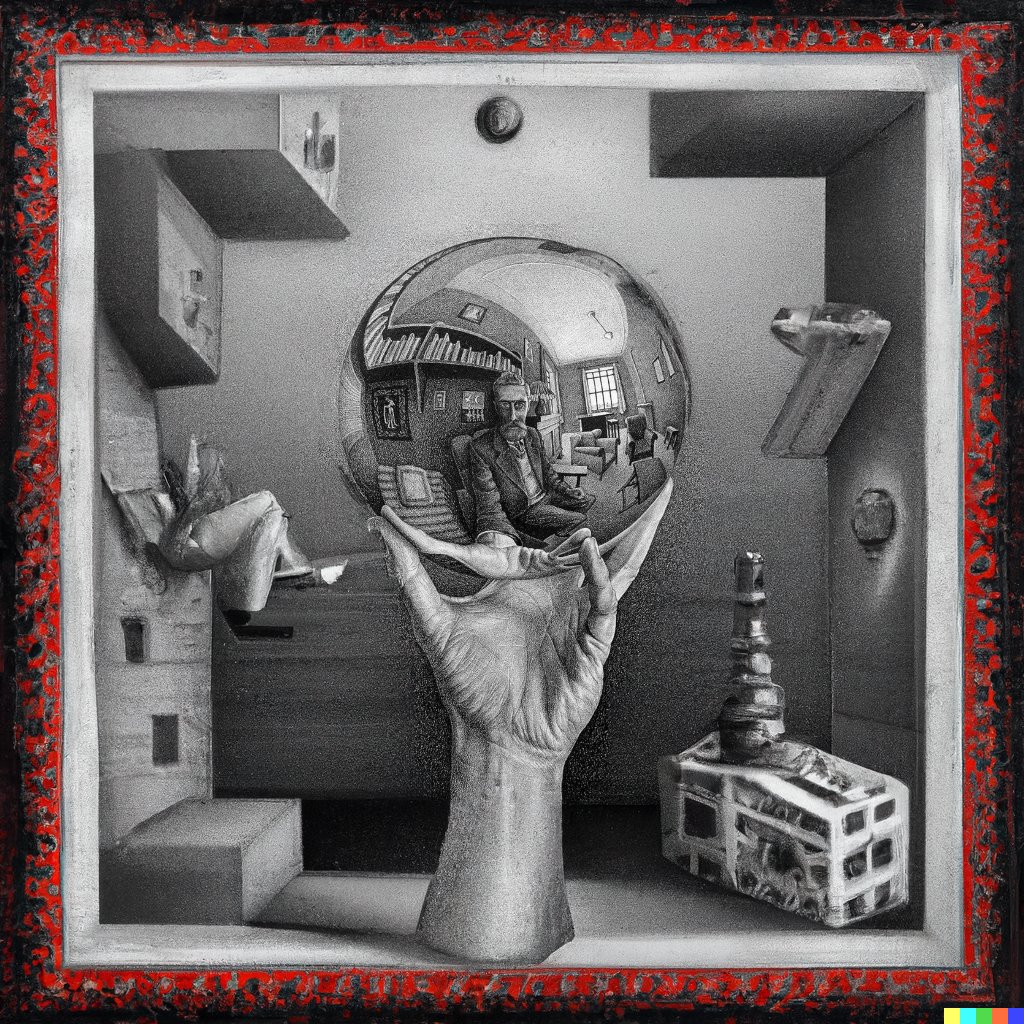

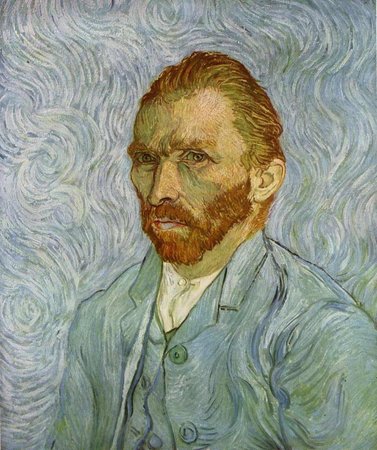

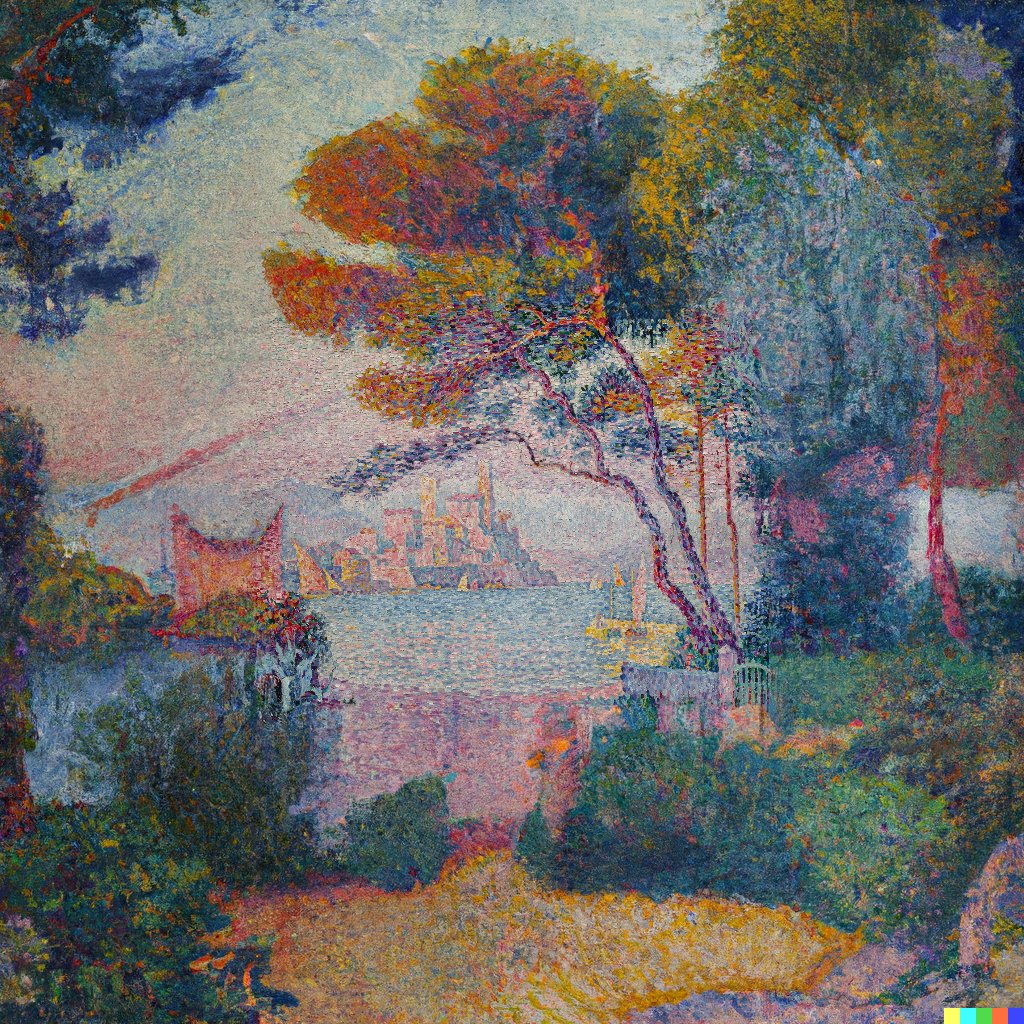

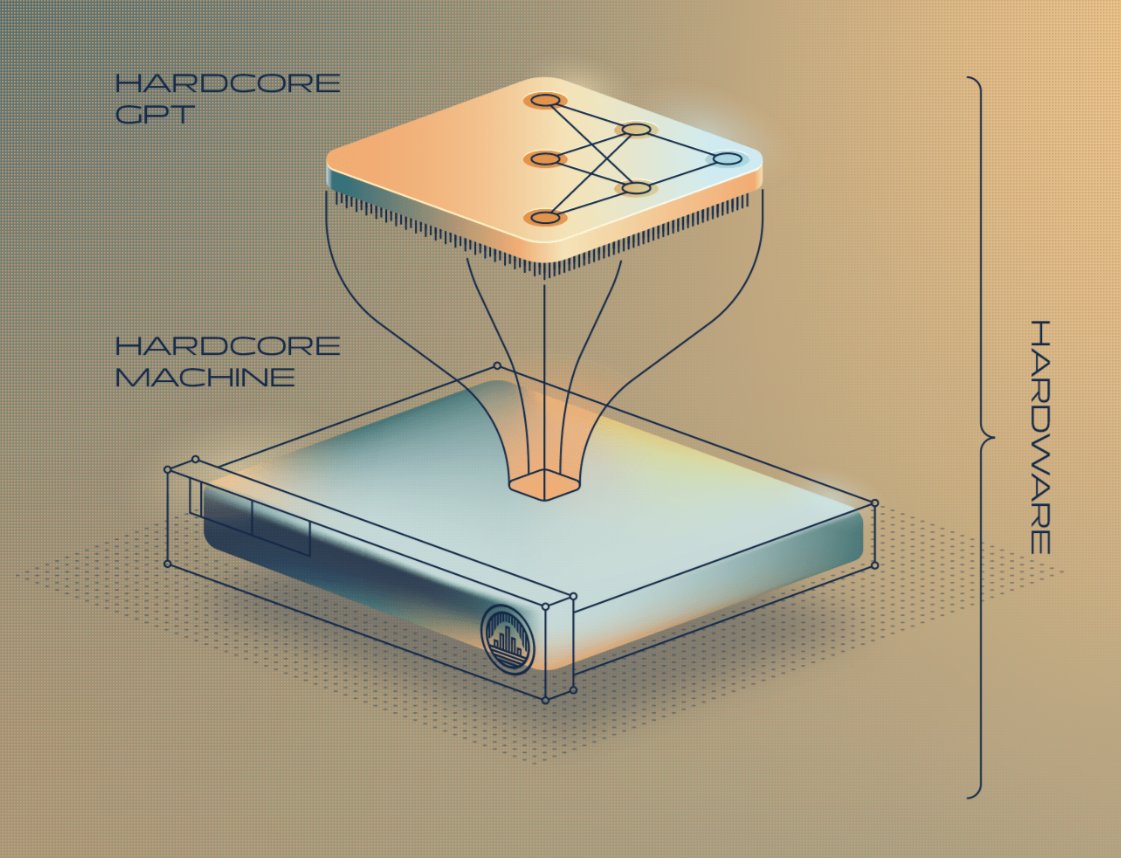

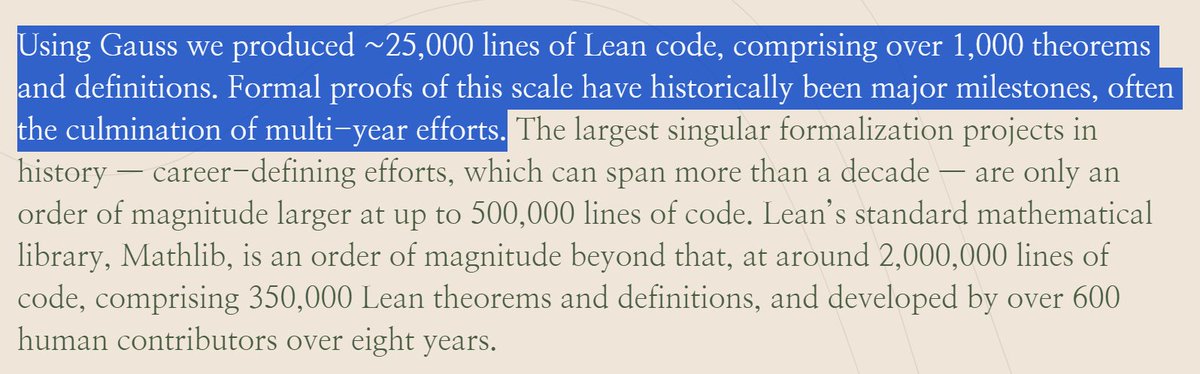

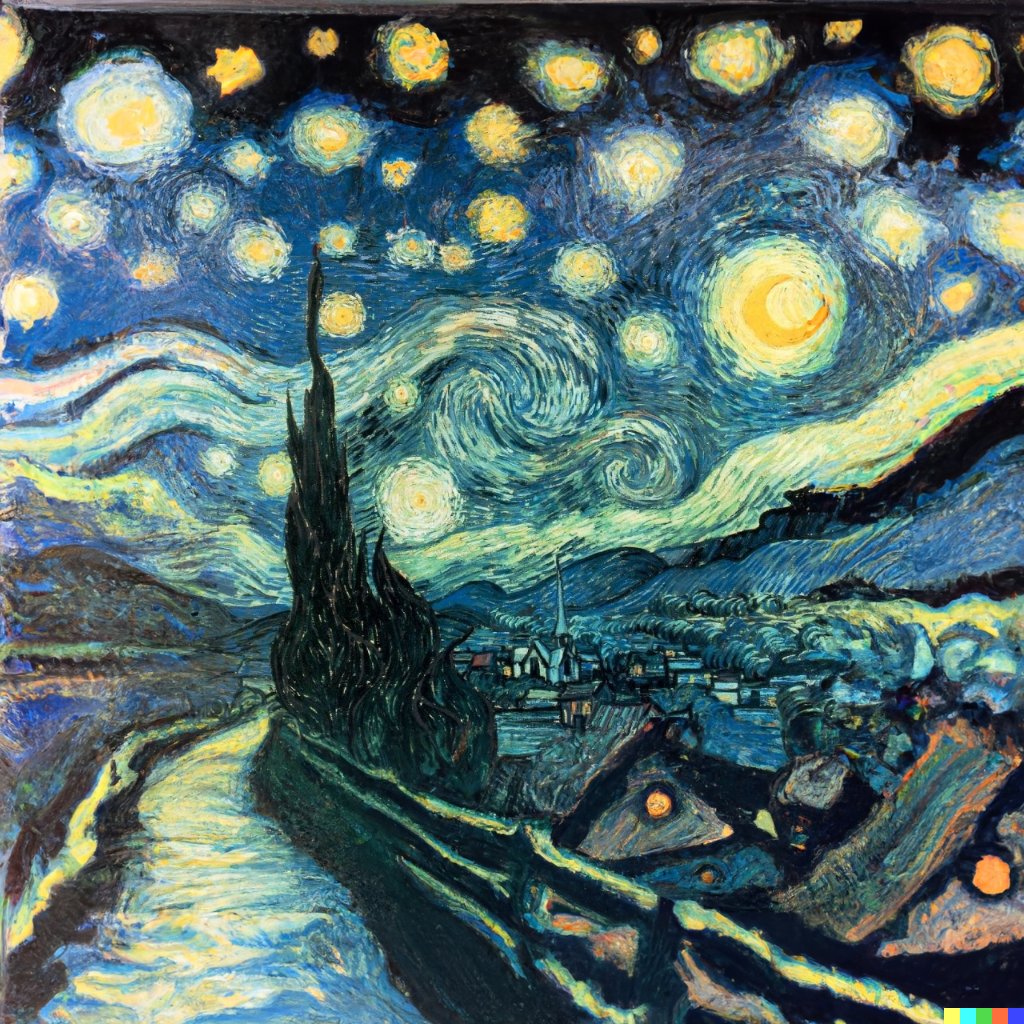

Para quien desconozca el proceso de cómo he hecho las imágenes anteriores, estoy usando una IA llamada DALL•E 2 para completar las partes faltantes de una imagen (inpainting).

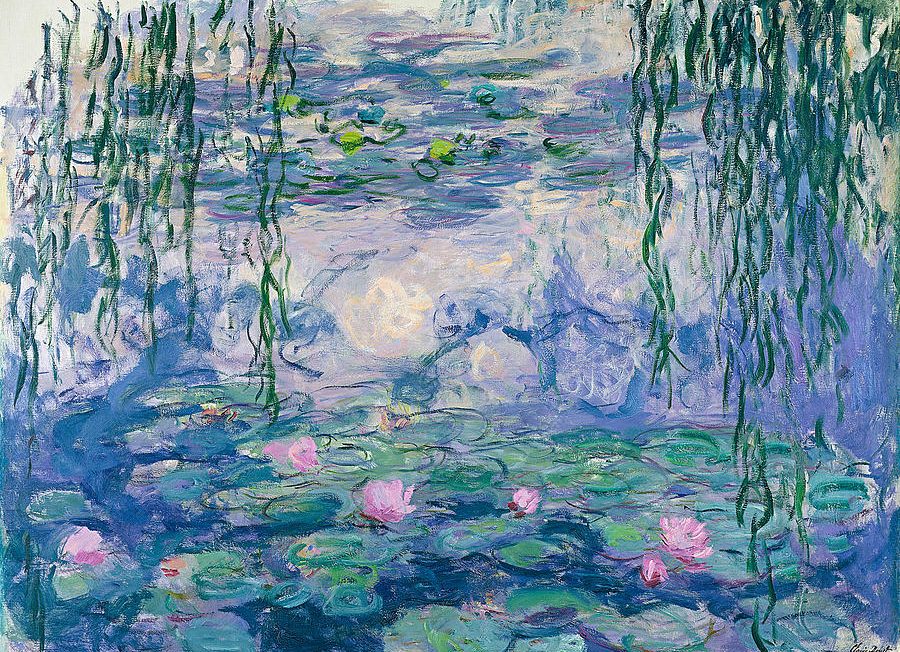

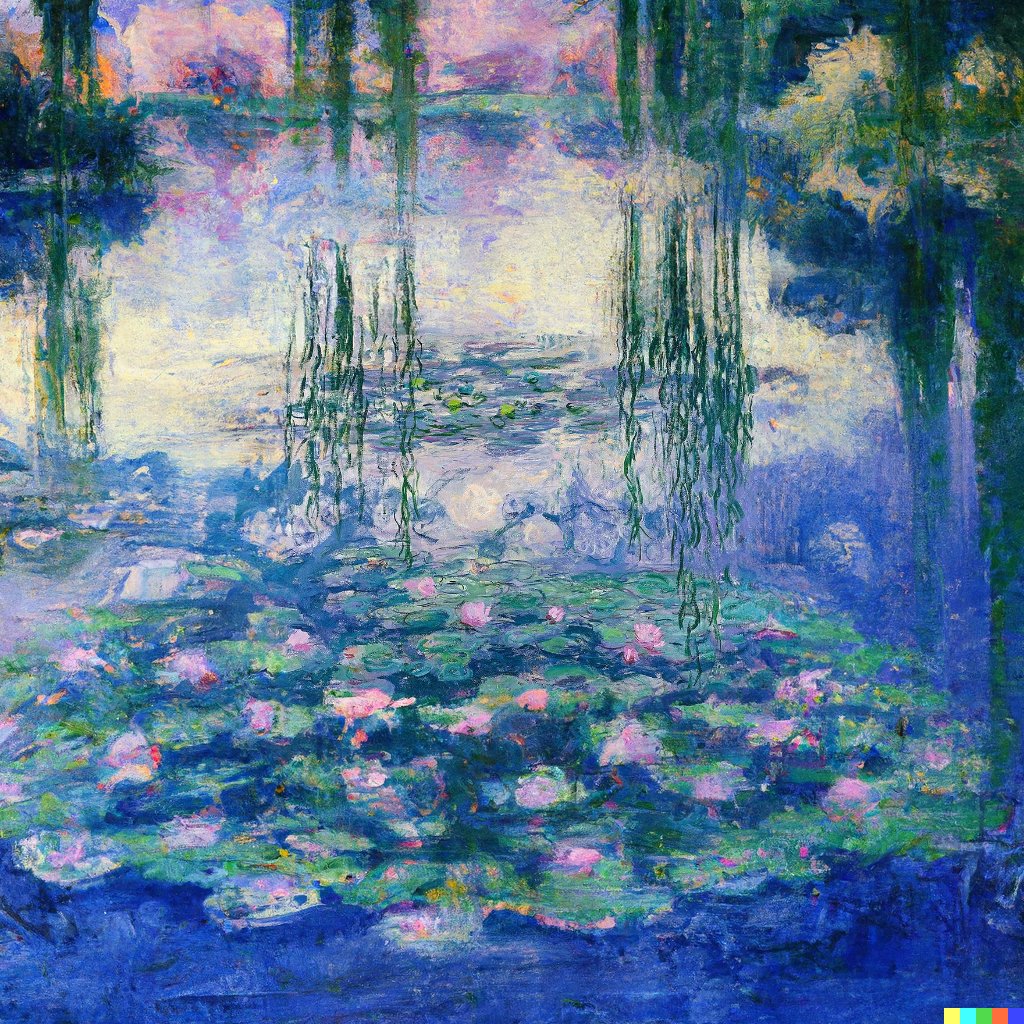

1) Primero uso una app de edición para extender los bordes de un cuadro famoso. Por ejemplo, Monet 👇

1) Primero uso una app de edición para extender los bordes de un cuadro famoso. Por ejemplo, Monet 👇

2) Borro aquellas partes que quiero que la IA complete, y le doy muy pocas pautas como input de texto para no condicionar el resultado (en este caso, sólo el nombre del pintor).

En pocos segundos, estos es lo que obtenemos 🤯 🖼️

En pocos segundos, estos es lo que obtenemos 🤯 🖼️

En 15 seg, obra creada!

La parte mas complicada del todo el proceso siempre suele ser elegir cuál de todos los resultados publicar :)

La parte mas complicada del todo el proceso siempre suele ser elegir cuál de todos los resultados publicar :)

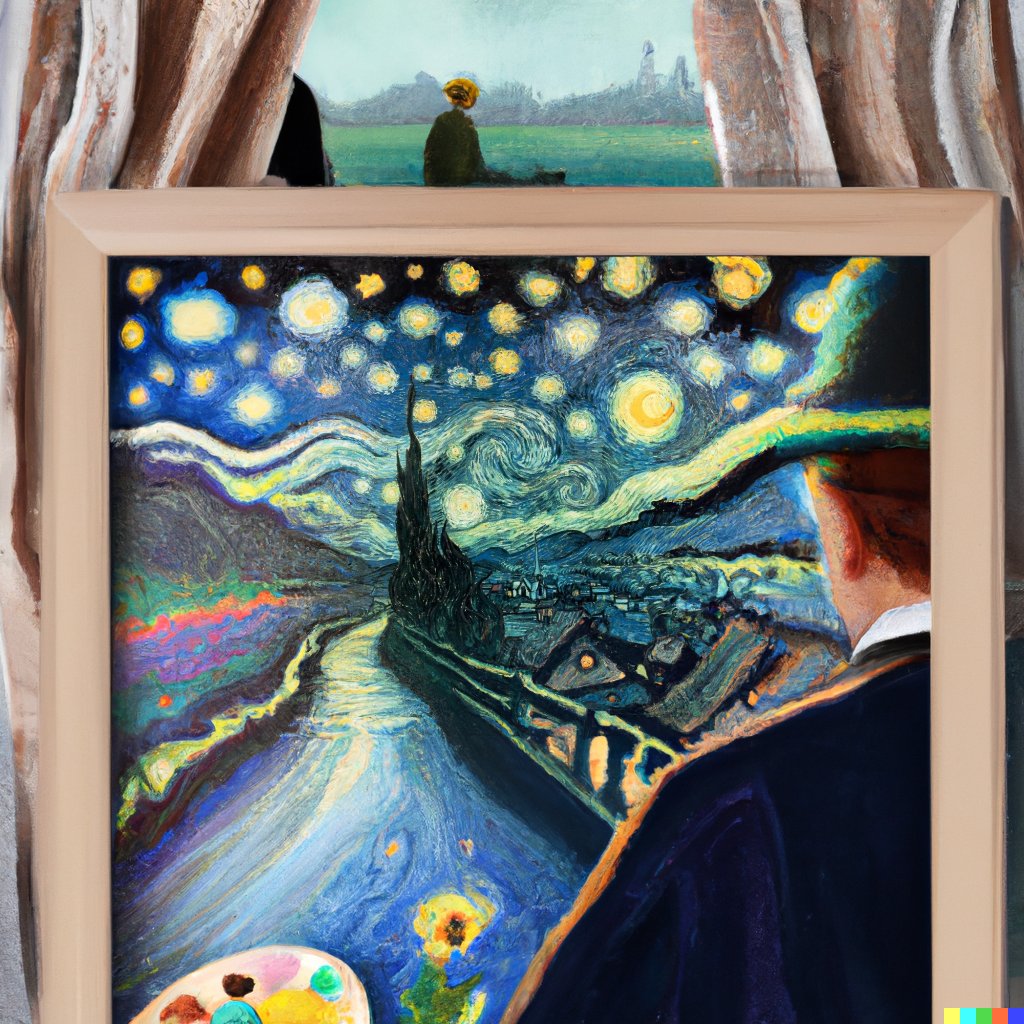

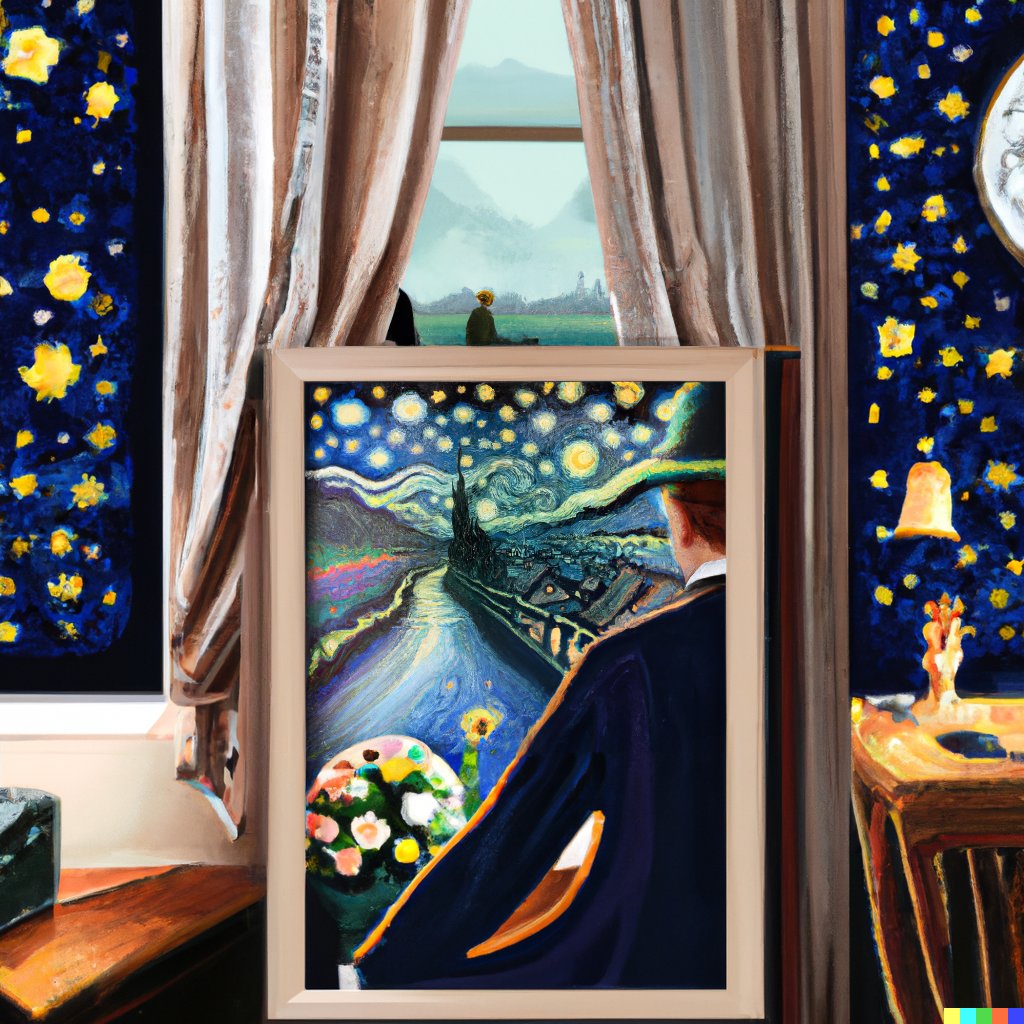

Y en realidad, esto es tan infinito como el lenguaje. Si quiero puedo pedirle la foto del cuadro colgado en el salón de mi casa.

¿Os tengo convencidos del potencial de DALL•E 2? ¿Sigo?

Y con Edward Hopper cerramos el museo por hoy. No dejéis de compartir este pedazo de hilo y dejadme recomendaciones de cuadros o fotografías históricas que queráis ampliar! ♥️

Esta tarde abriré las puertas del museo con nuevas obras (...vamos, que continuaré el hilo).

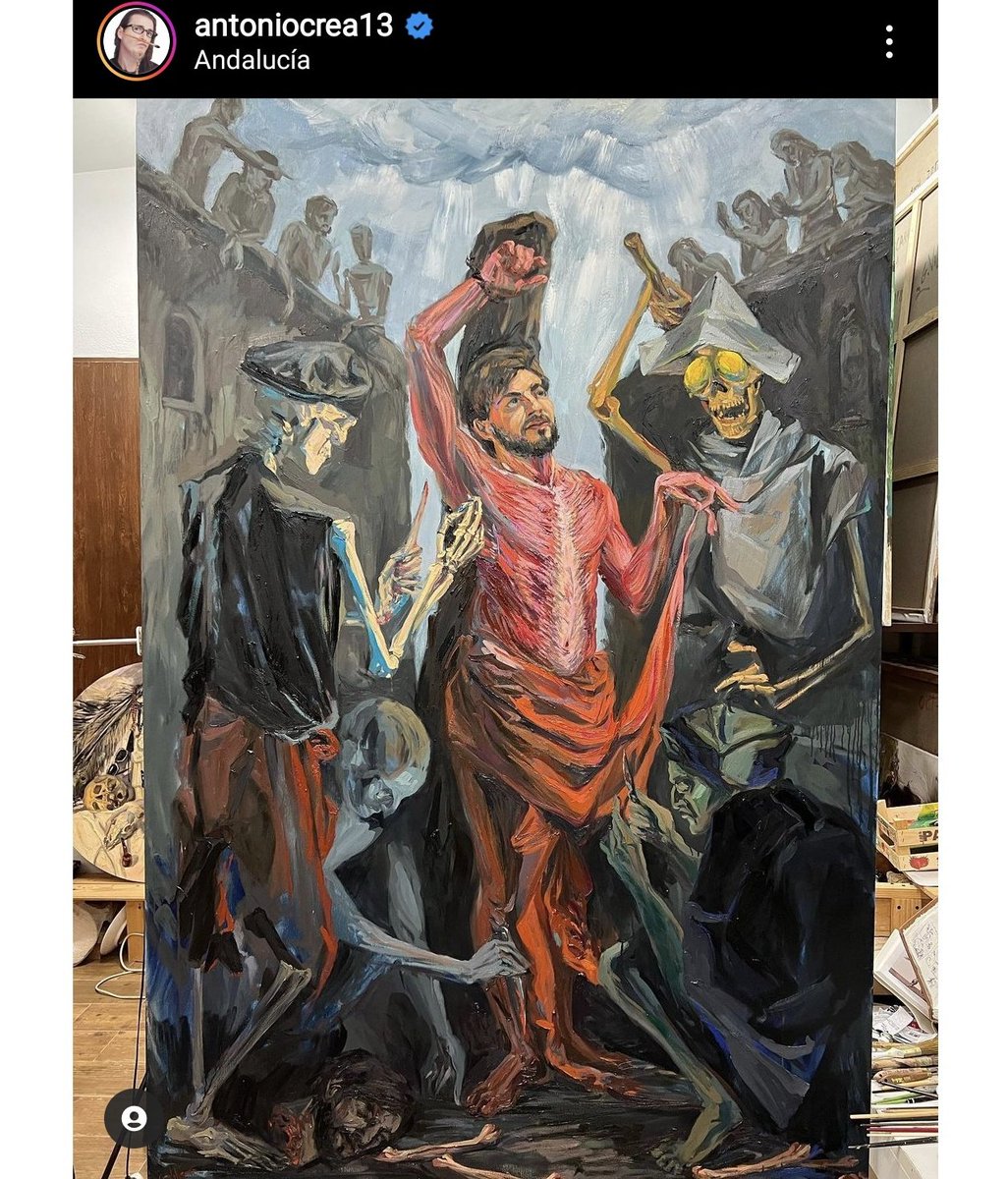

Mientras tanto y para que veáis que el potencial de esta herramienta no queda sólo en cuadros conocidos, mirad este hilo! 👇🧵

Mientras tanto y para que veáis que el potencial de esta herramienta no queda sólo en cuadros conocidos, mirad este hilo! 👇🧵

https://twitter.com/DotCSV/status/1538606271666040839?t=YBW96GB86nUk4DlFUkEazg&s=19

¡Se abre el museo! Y continuamos donde lo dejamos ayer con Hopper, ampliando la obra a la que le cantó Pitbull con su famoso Hotel Room 👇

Me preguntabais qué pasa si ampliaba varias veces la obra, un resultado tras otro. Pues lo que sucede es que ponemos a la IA a soñar ✨

¿Las Meninas? Cuando te alejas demasiado resulta que acabas metido en otro salón. Una nueva perspectiva 👀

El próximo experimento tiene un toque especial porque el resultado lo podemos comparar con un inpainting histórico real, tal y como nos cuenta @AlbaCeColl en este hilo tan bien hilado de Las Hilanderas de Velázquez.

https://twitter.com/AlbaCeColl/status/1545318051788341248?t=L_XHGaZrzC3Mktw3Hq3Zfg&s=19

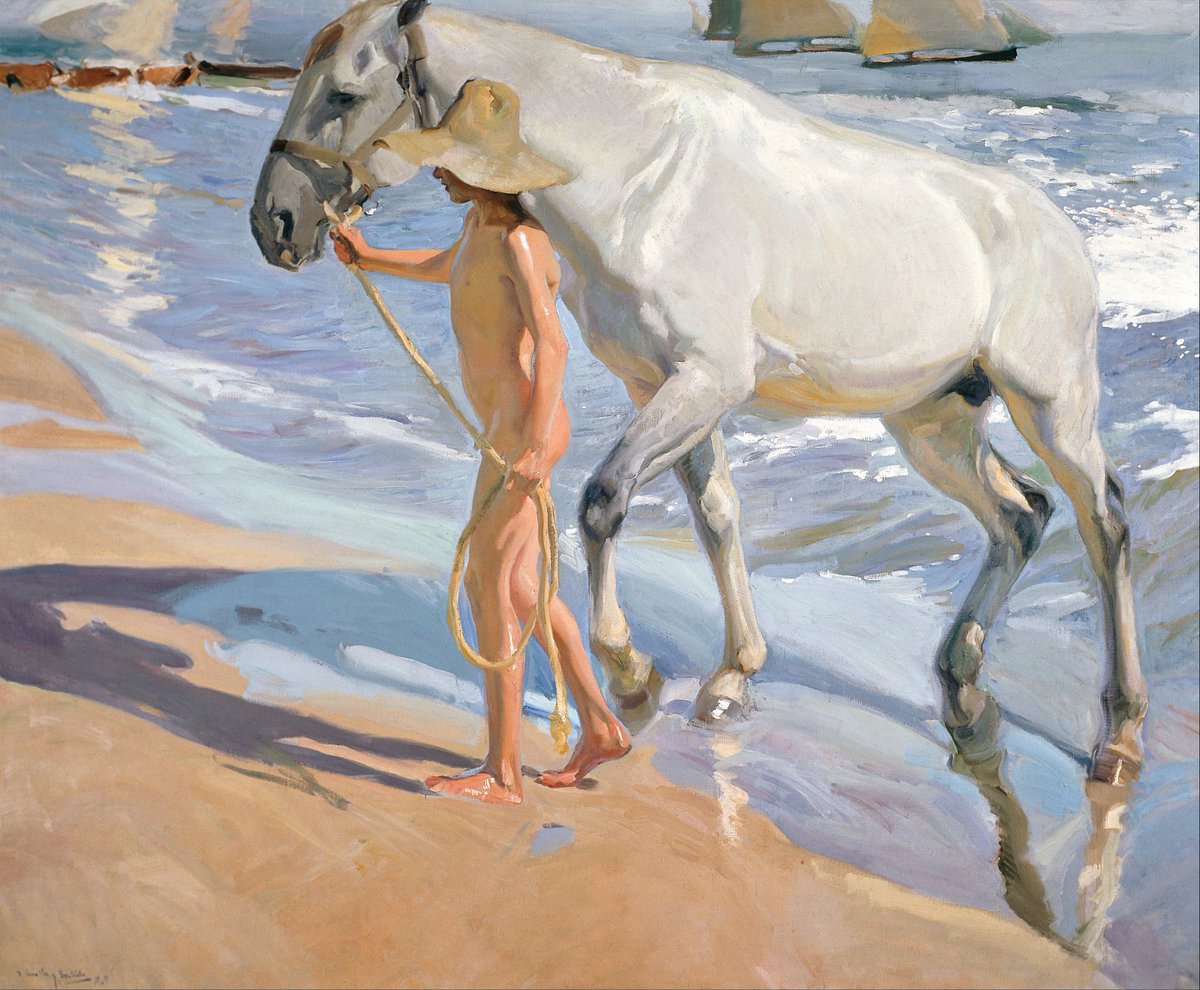

Y con este espectacular resultado de un Sorolla, cierro el museo de los lienzos agrandados por hoy :)

Dejad vuestras recomendaciones y no dejéis de compartir el hilo! ♥️

Dejad vuestras recomendaciones y no dejéis de compartir el hilo! ♥️

Creo que es el momento de decir que si no tenéis ni idea de cómo está hecho esto, o qué es DALL•E 2, que tenéis que ver este vídeo de mi canal 👇

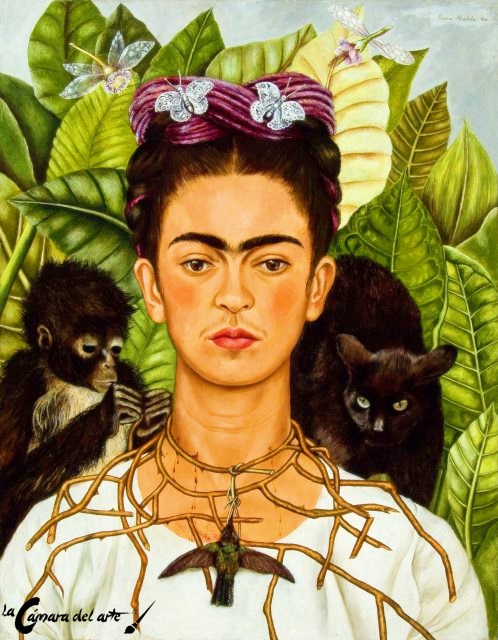

La xavala de la perla. Me encanta cómo ha cogido parte del color azul tan característico para aplicarlo a otros elementos de la escena.

Con Banksy es gracioso porque no consigo que expanda el resultado, pero sí mover el graffiti de localización 😅

Vamos con otro interesant...

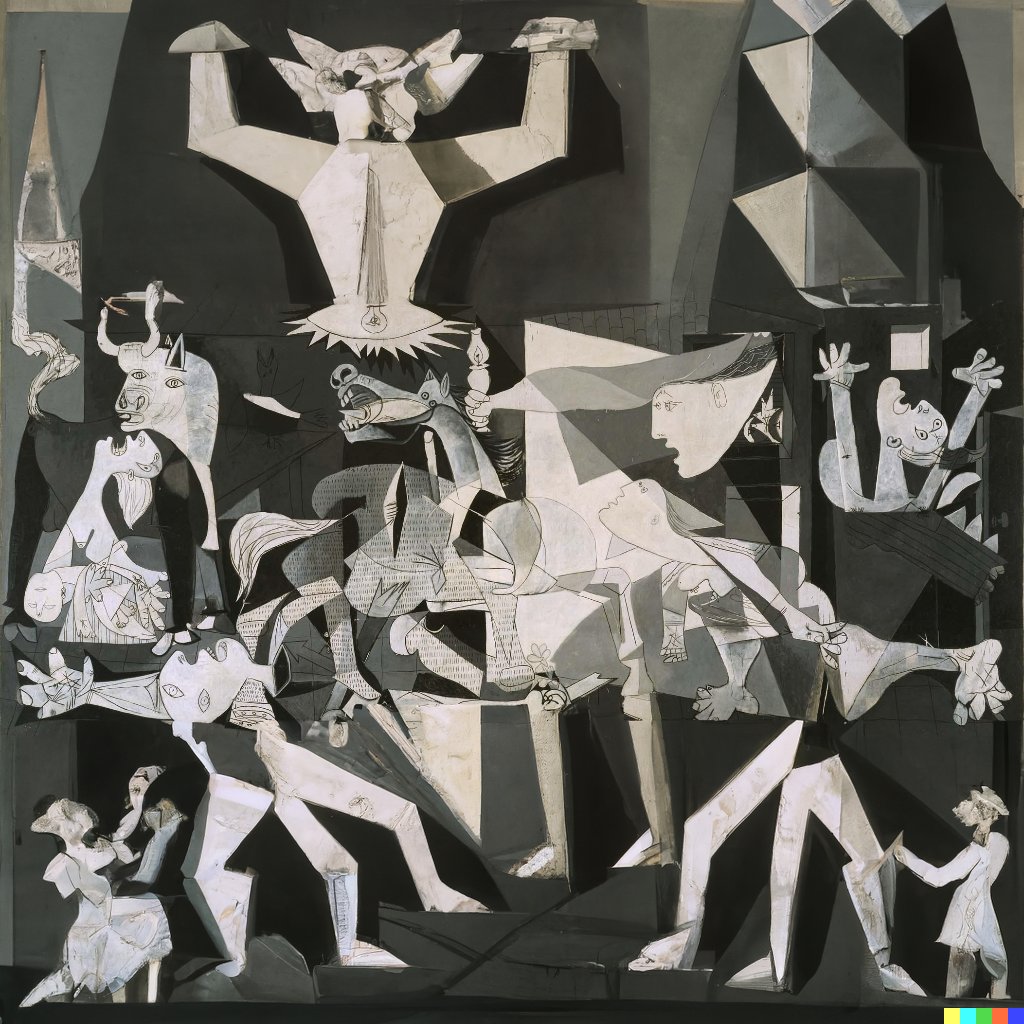

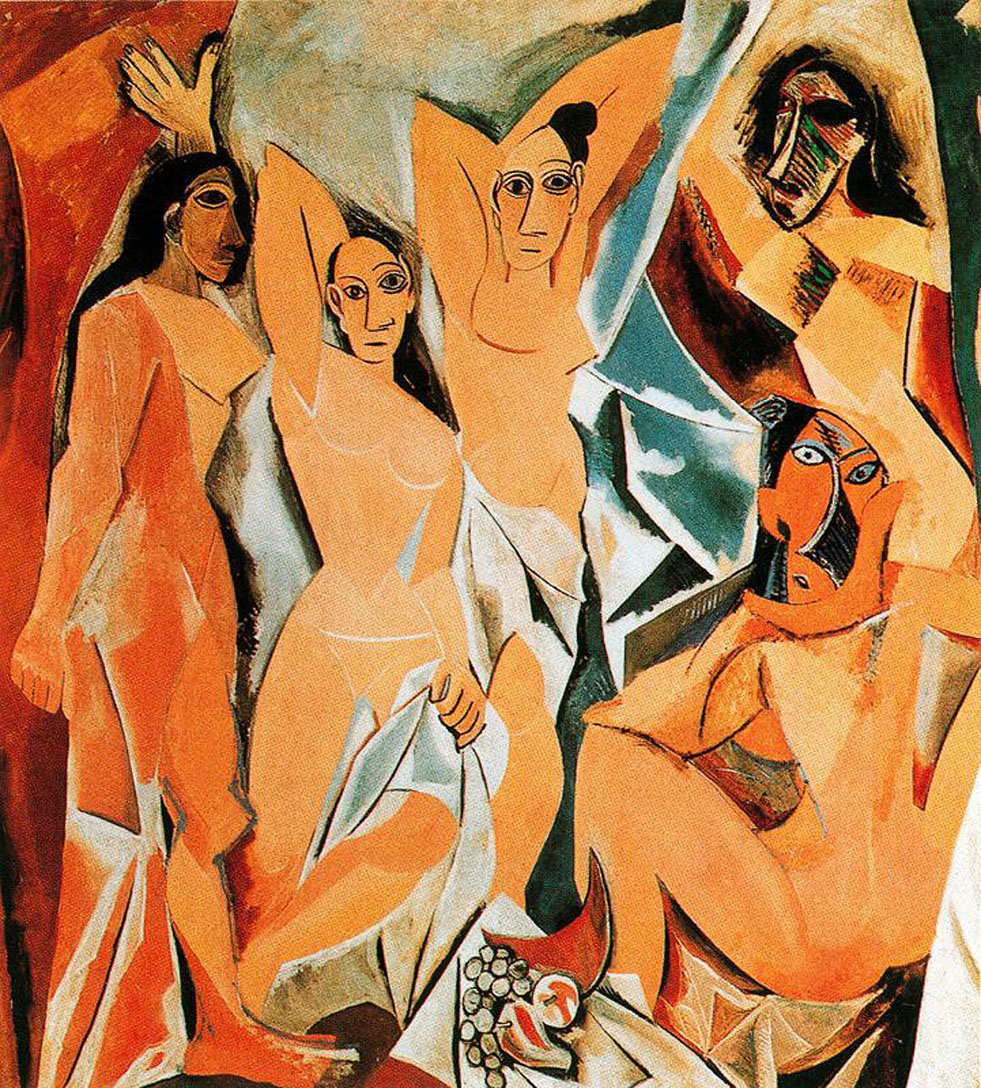

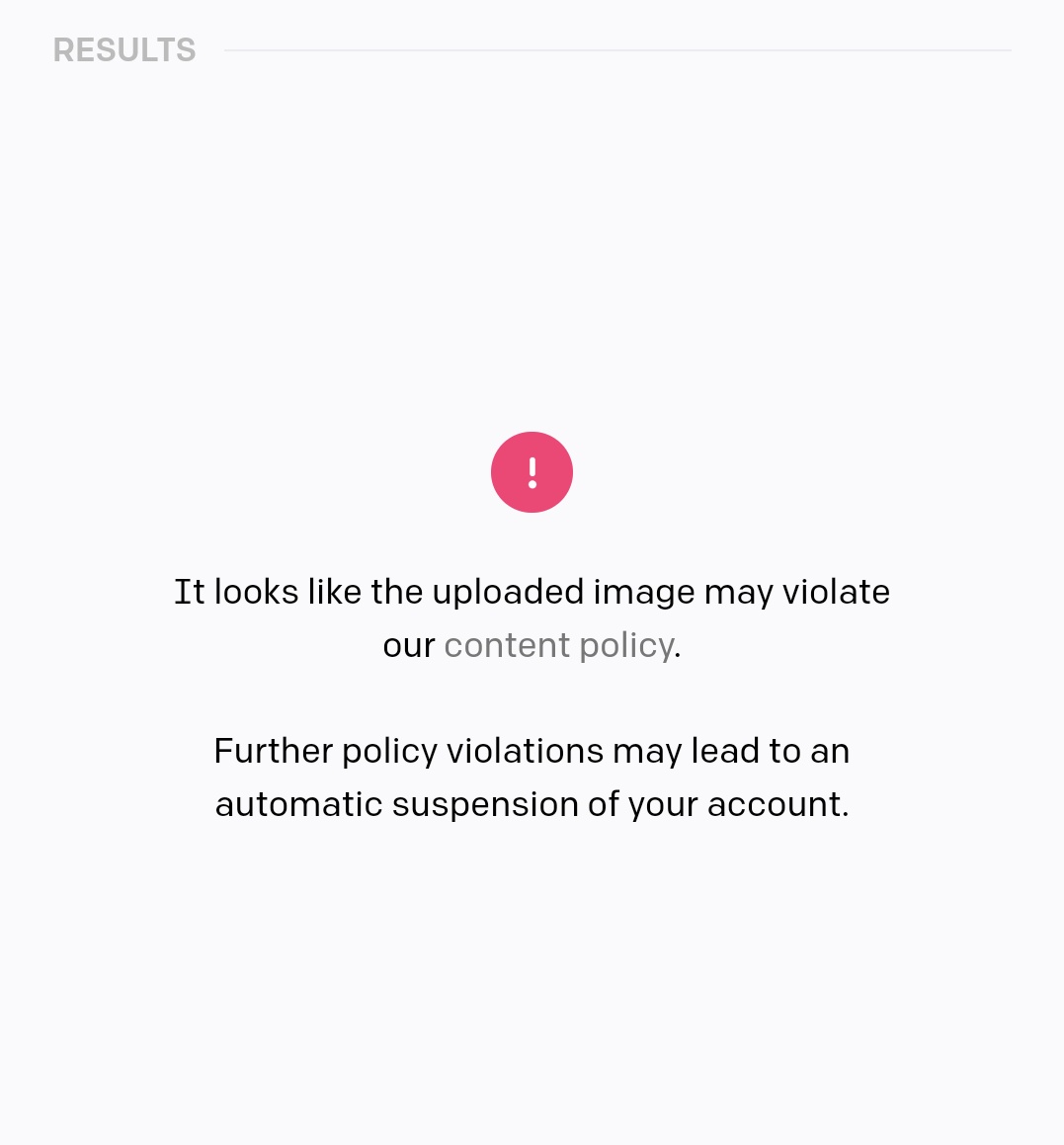

Upsss, parece que por un lado la IA es muy buena detectando formas cubistas y por el otro el humano muy restrictivo en su puritanismo. 🤷♂️

Upsss, parece que por un lado la IA es muy buena detectando formas cubistas y por el otro el humano muy restrictivo en su puritanismo. 🤷♂️

No olvidamos que todo esto lo está haciendo una IA que automáticamente ha aprendido todo esto, a partir de ver millones y millones de imágenes.

¿Verdad?

¿Verdad?

• • •

Missing some Tweet in this thread? You can try to

force a refresh