論文を読むと1.4*10^12tokenでLLaMAは学習されているらしく、これは世界最大レベルのデータセットの学習量(Chinchillaと同程度レベル)ですね。最近「コードの学習」が推論能力の強化に効いているのではないかという仮説があ理、LLaMAはざっくり200GBのgithubデータを正味学習している気がしていて、

https://twitter.com/jaguring1/status/1629233936290435073

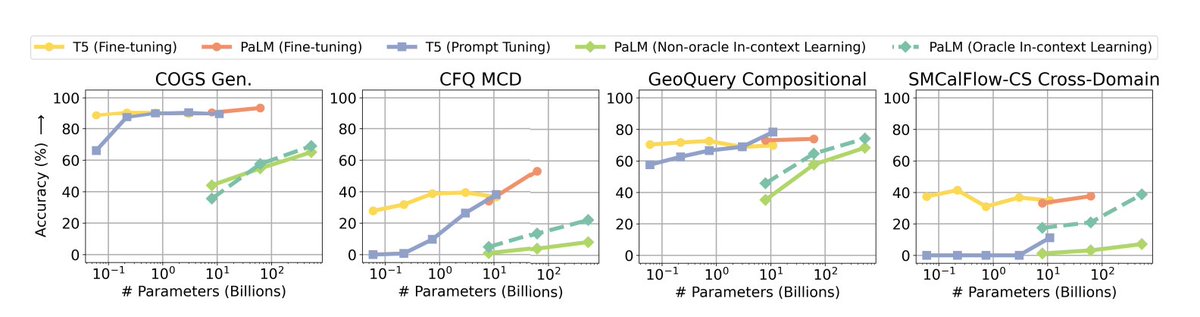

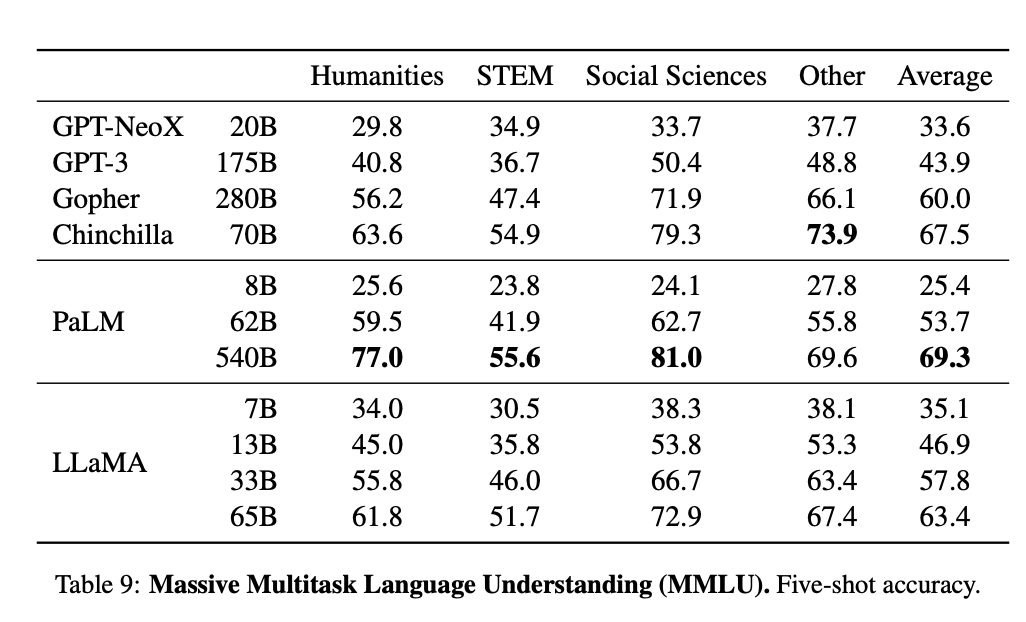

PaLMは100GB程度、Chinchillaは300GB程度と推定されると考えると、以下のMMLUのスコアで同程度のパラメータ(70B,65B,62B)同士を比べるとChinchilla>LLaMA>PaLMとなるのが綺麗に説明つくかもしれない。

それと13BパラメータがGPT3レベルの規模を様々なタスクで超えているのは単純にGPT3が3*10^11tokenで学習しているのに対して、13Bパラメータには10^12tokenで学習が施されているかつソースコードの学習が含まれているから性能が高くなっている気がする。

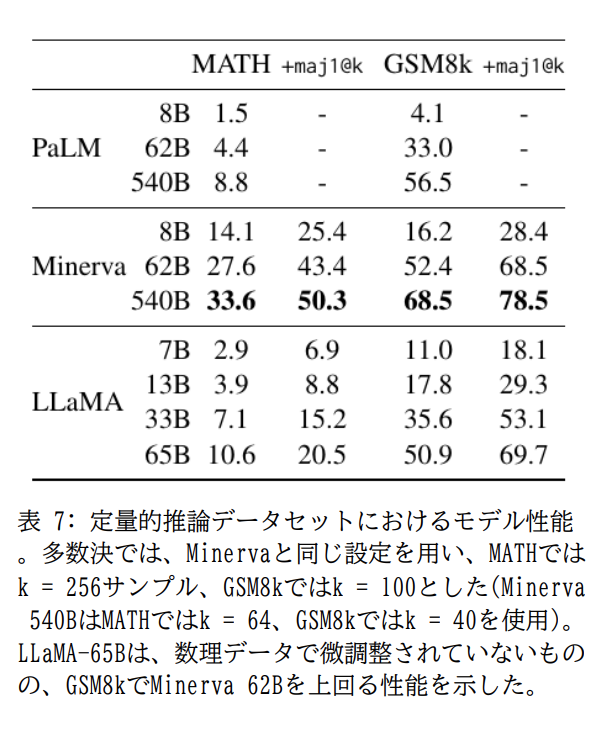

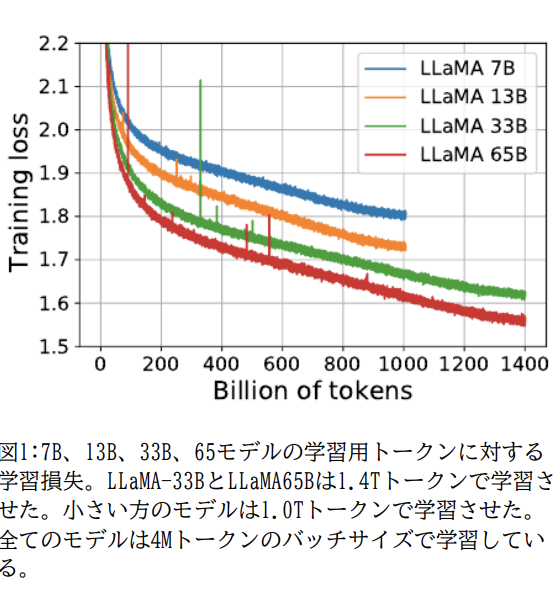

それとMATH、GSM8kという中高生の数学データセットでLLaMAの33BはPaLM66Bにどちらにも勝ってるし、学習データ量増やしたり、ソースコード学習量増やすことで右図のように損失はへるし下流タスクも今後性能上がり続ける可能性が小規模モデルでもあり得る。

ちなみに世界中に存在する高品質言語データはおおよそ10^13token程度と予想されているので、あと1桁我々人類はスケーリングを言語モデルで続けることが可能だと思われる。

おそらく後1年くらいはスケーリングローというか今の密な言語モデルのパラダイムが続き、

https://twitter.com/bioshok3/status/1598144094068359168?s=20

おそらく後1年くらいはスケーリングローというか今の密な言語モデルのパラダイムが続き、

スケールに加えて様々なプロンプトの工夫やら強化学習やら微調整やら外部ツール活用やら他何らかのアルゴリズムの改善やら+そこに高速化手法やメモリ消費の削減手法が組み合わさることでもう一段階進化すると思われる。初代GPT3->ChatGPTくらいの主観的変化かなと個人的には考えている。

• • •

Missing some Tweet in this thread? You can try to

force a refresh