AI Safety/Governance/Alignment/National security/Singularity/Superintelligence/AGI/X-Risk/prediction

https://t.co/MuWGjdu5Tg

INODS Research Fellow

How to get URL link on X (Twitter) App

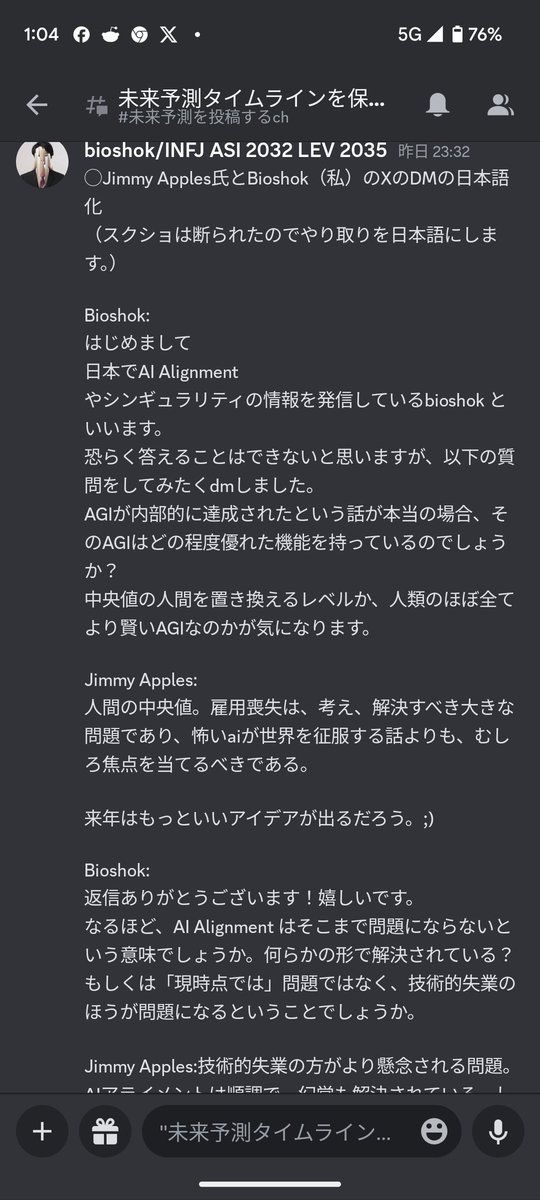

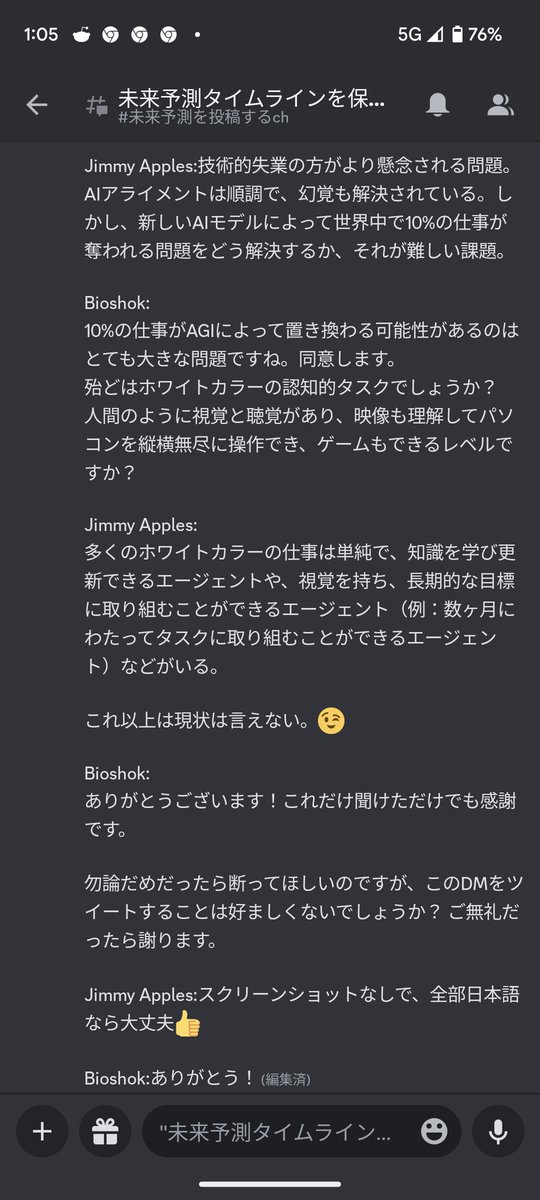

https://twitter.com/bioshok3/status/1717739325214114223許可が出たので10/28のJimmy Apples氏との会話を公開するが、ここにバイデン大統領についての話も書いていますが、大統領もある程度知っていると主張している。もしこれが本当だったら、(恐らく違う)大統領はAGIをみてこんなに対応をいそいでいると陰謀論的に解釈できるね

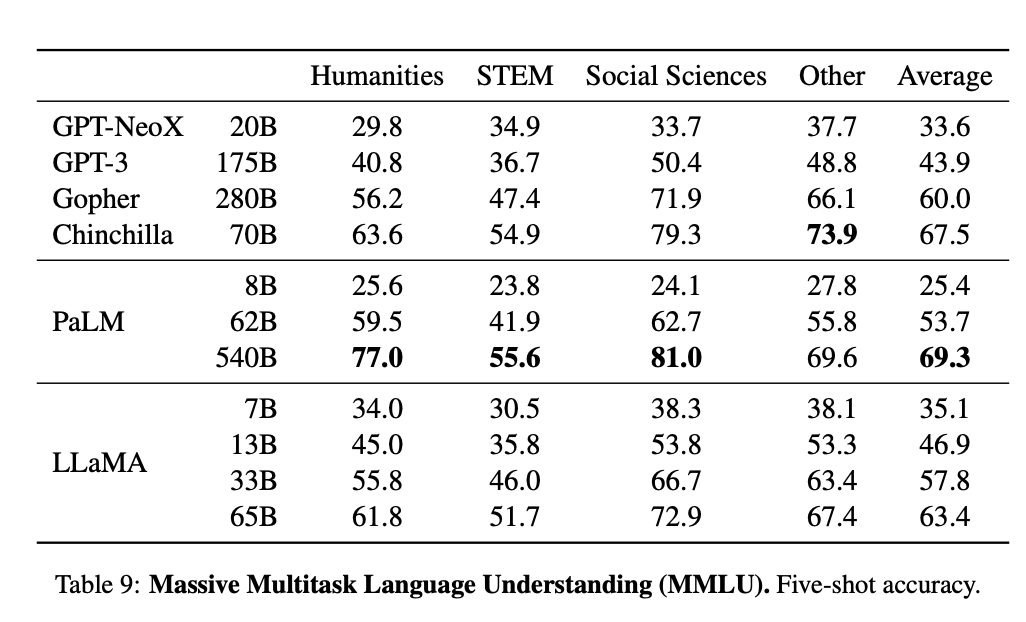

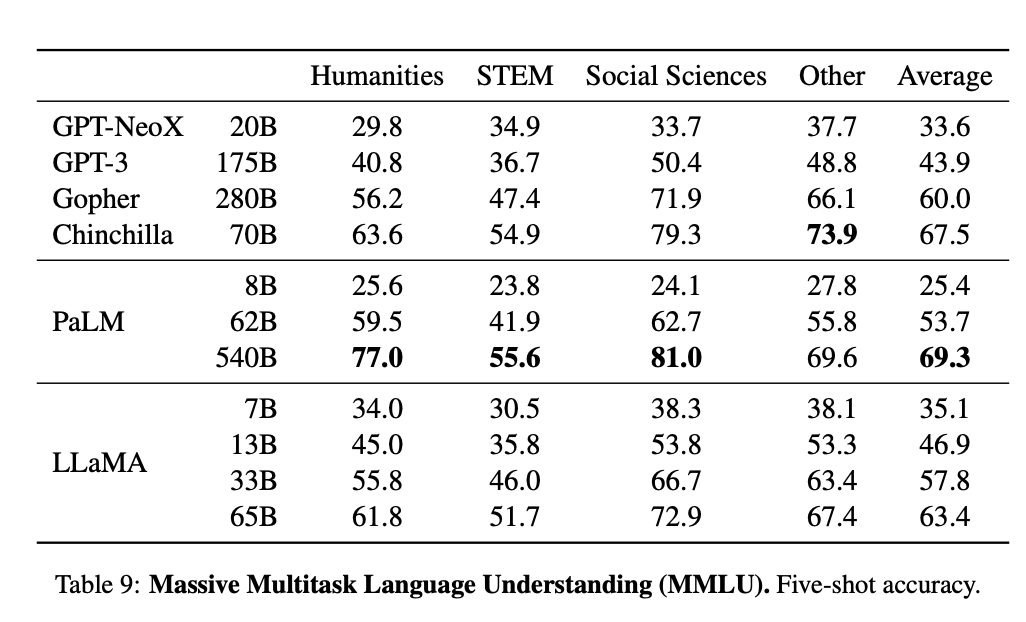

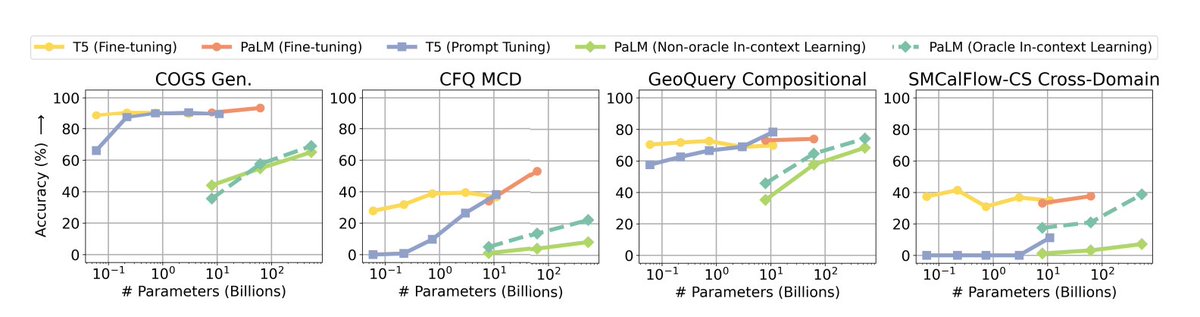

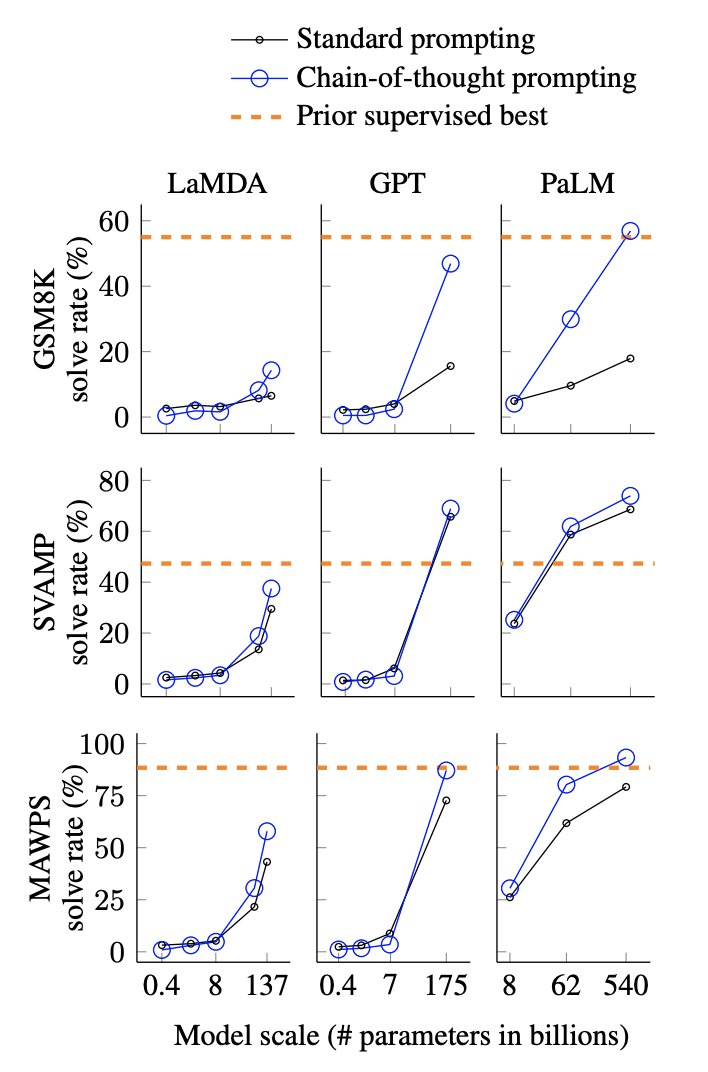

https://twitter.com/jaguring1/status/1629233936290435073PaLMは100GB程度、Chinchillaは300GB程度と推定されると考えると、以下のMMLUのスコアで同程度のパラメータ(70B,65B,62B)同士を比べるとChinchilla>LLaMA>PaLMとなるのが綺麗に説明つくかもしれない。

https://twitter.com/xf1280/status/1628483168306364416

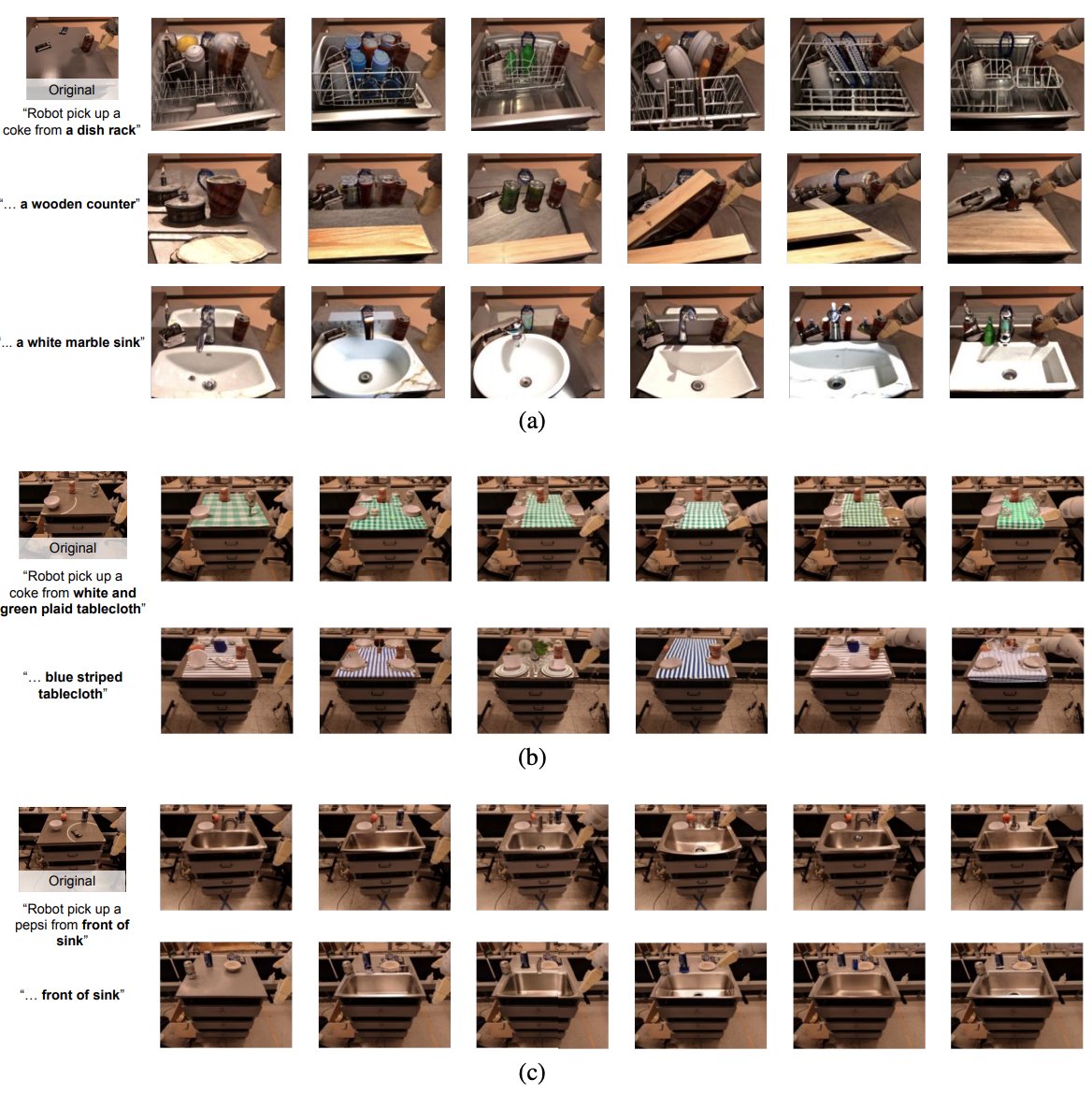

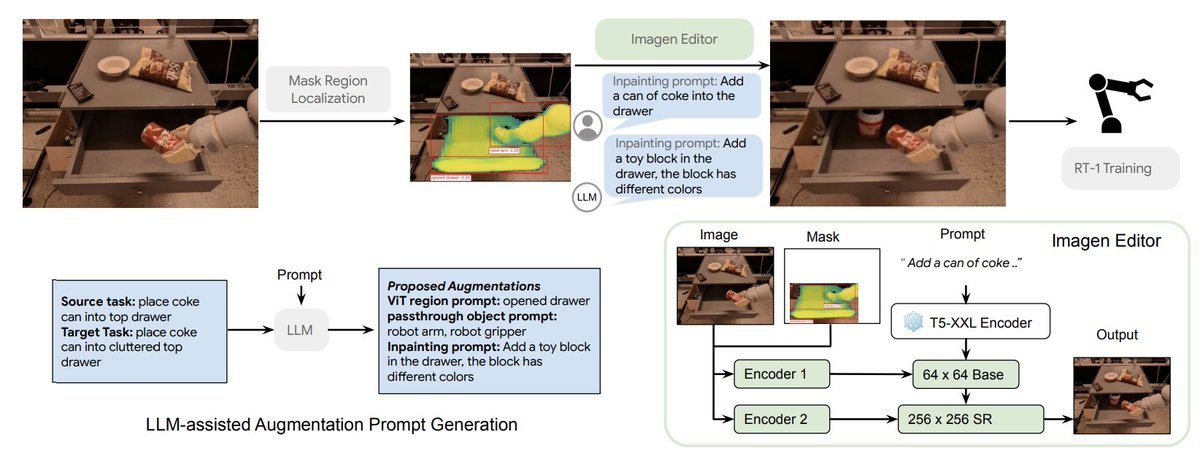

手法は以下の図。例えばタスクが「コーラを引き出しに入れる」だったら、その中からコーラと引き出しをセグメンテーションし、次に画像編集AIでセグメンテーションマスクとプロンプトを入力として、画像全体の一貫性をできるだけ保ちつつ新たな視覚入力を生成する。

手法は以下の図。例えばタスクが「コーラを引き出しに入れる」だったら、その中からコーラと引き出しをセグメンテーションし、次に画像編集AIでセグメンテーションマスクとプロンプトを入力として、画像全体の一貫性をできるだけ保ちつつ新たな視覚入力を生成する。

https://twitter.com/satyanadella/status/1623031898544152578

theverge.com/2023/2/7/23587…

theverge.com/2023/2/7/23587…https://twitter.com/umiyuki_ai/status/1622909316624973824日本がビジネス的に遅れるからAIトレンドに乗っかろうとかそういう次元ではない。国家安全保障上の問題になるので、取り組もうくらいの勢いが必要な気がする。

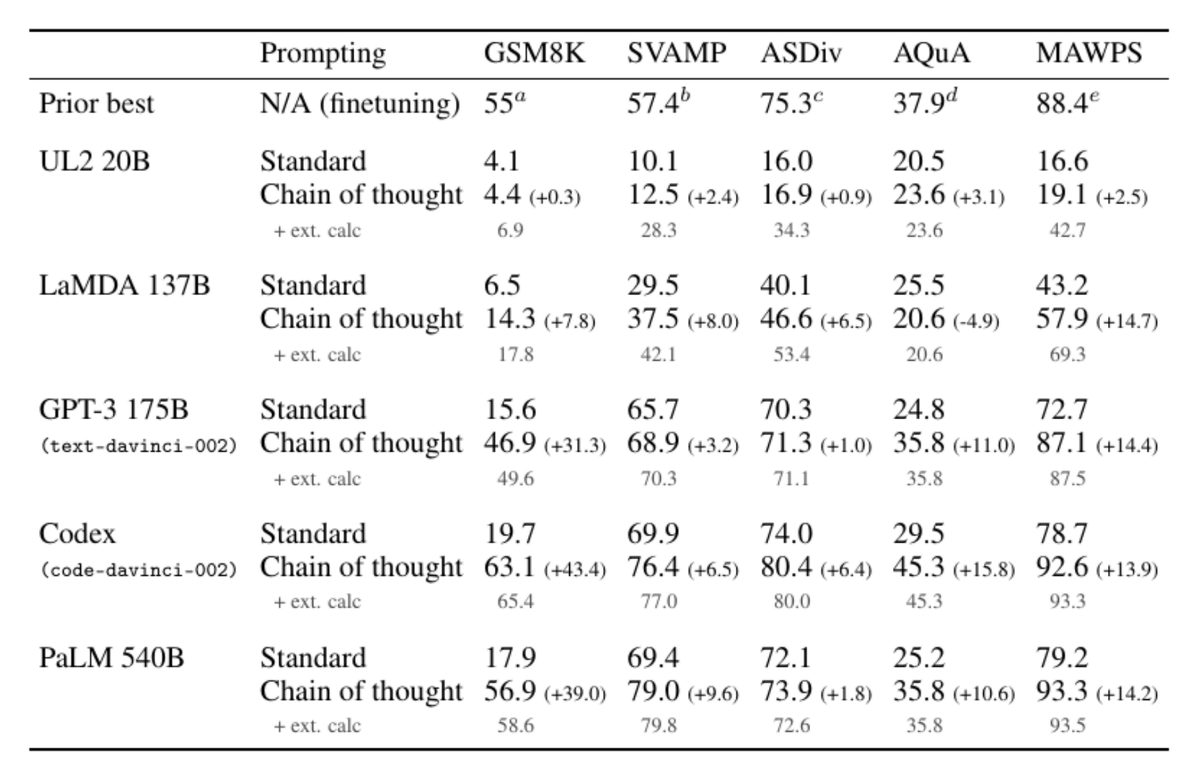

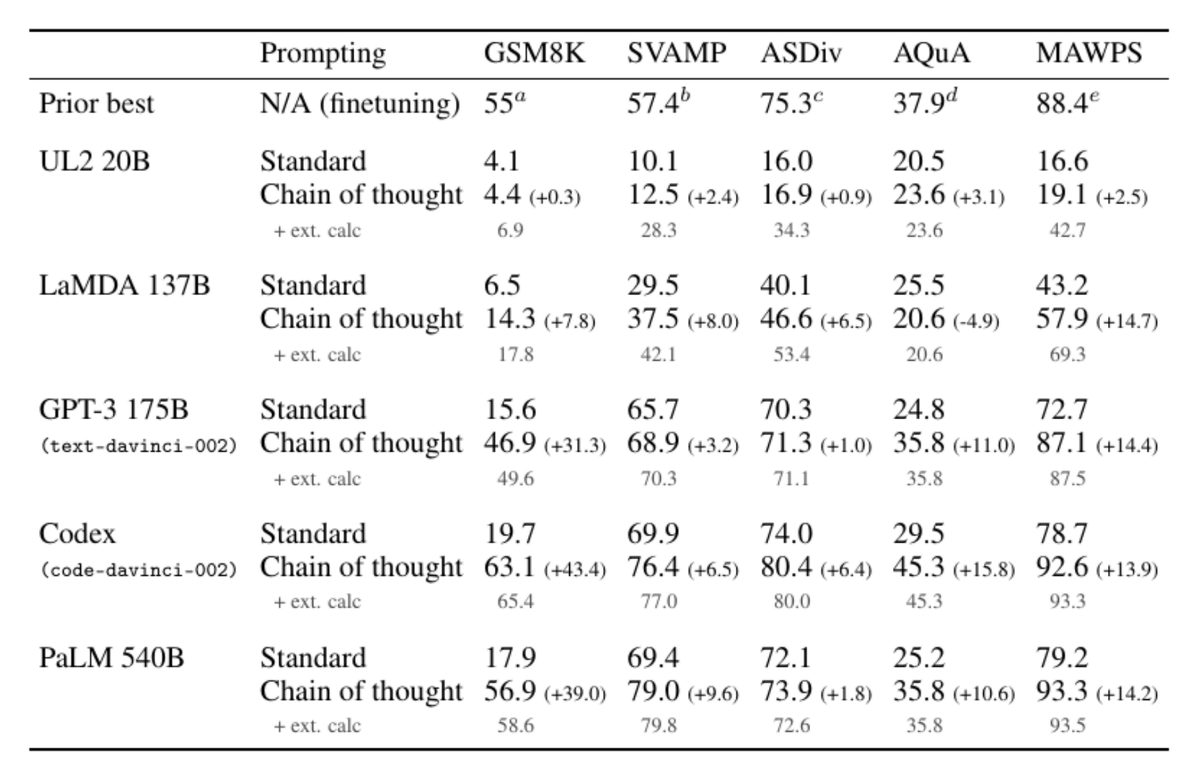

googleはLaMDAベースのBARDを数週間以内に出そうとしているけど、それだとMicrosoftのBing搭載されるCodexベースのGPT3.5以降の推論能力に負ける可能性があると思う。

googleはLaMDAベースのBARDを数週間以内に出そうとしているけど、それだとMicrosoftのBing搭載されるCodexベースのGPT3.5以降の推論能力に負ける可能性があると思う。

https://twitter.com/Futurist_SF/status/1588865256906199040結論をまとめますと、