How to get URL link on X (Twitter) App

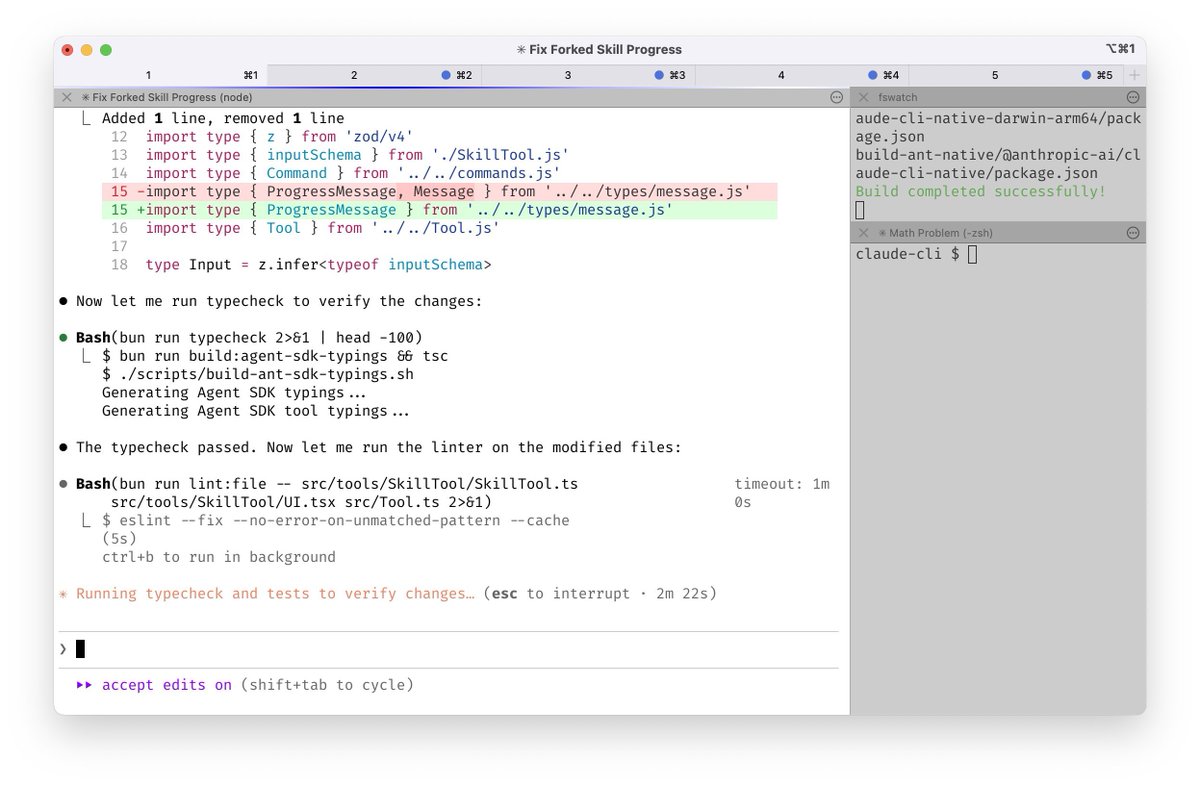

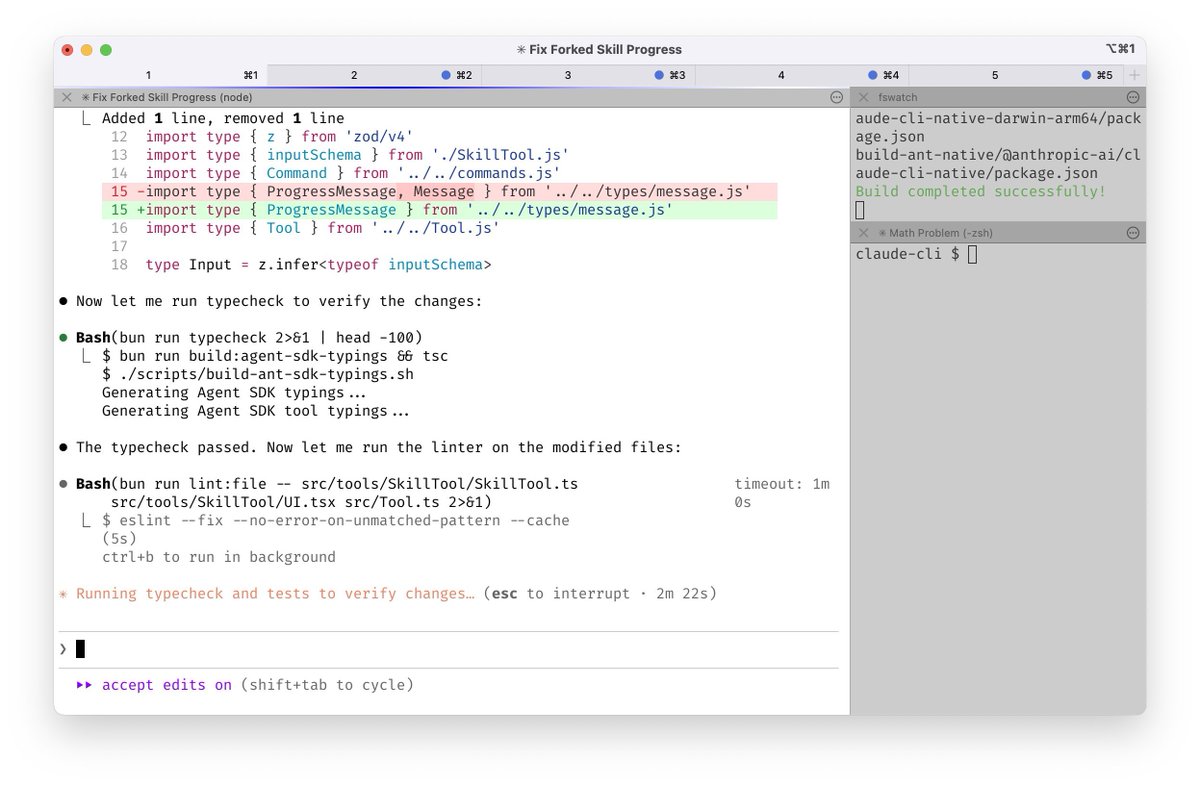

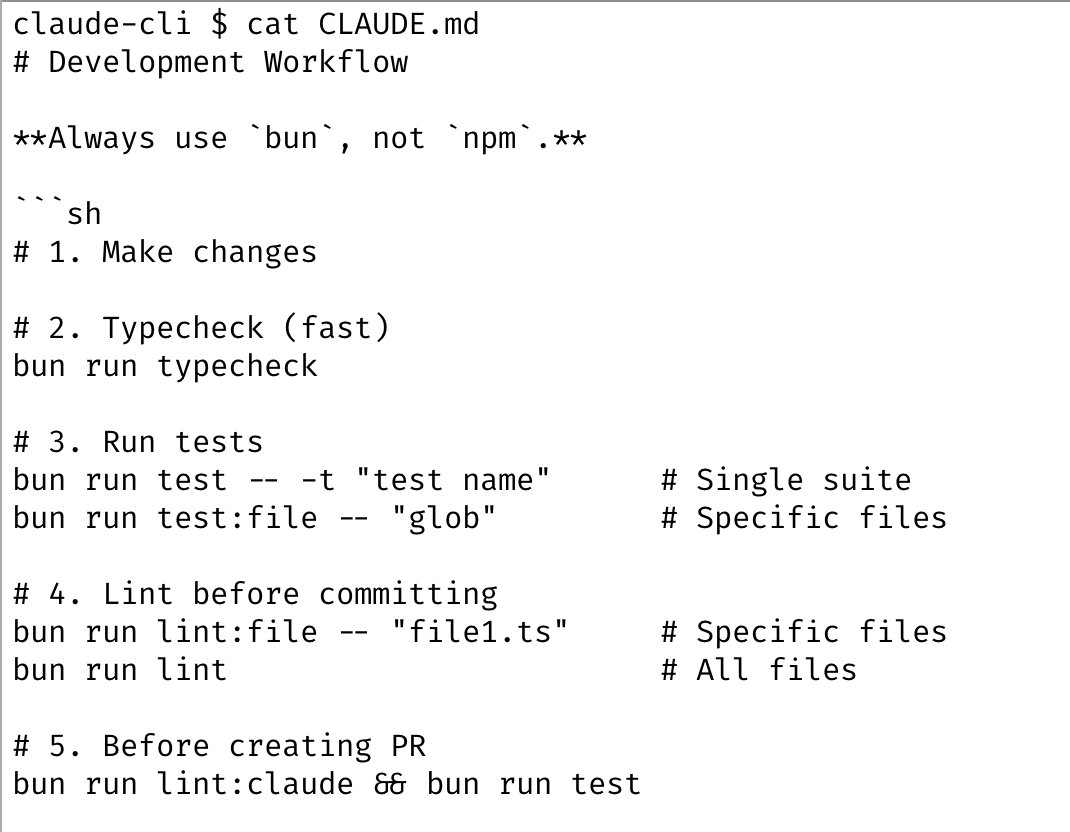

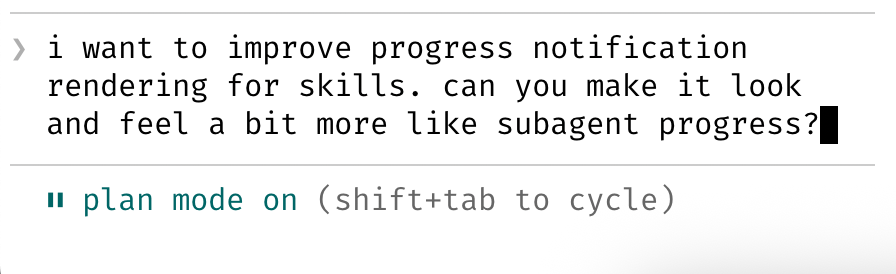

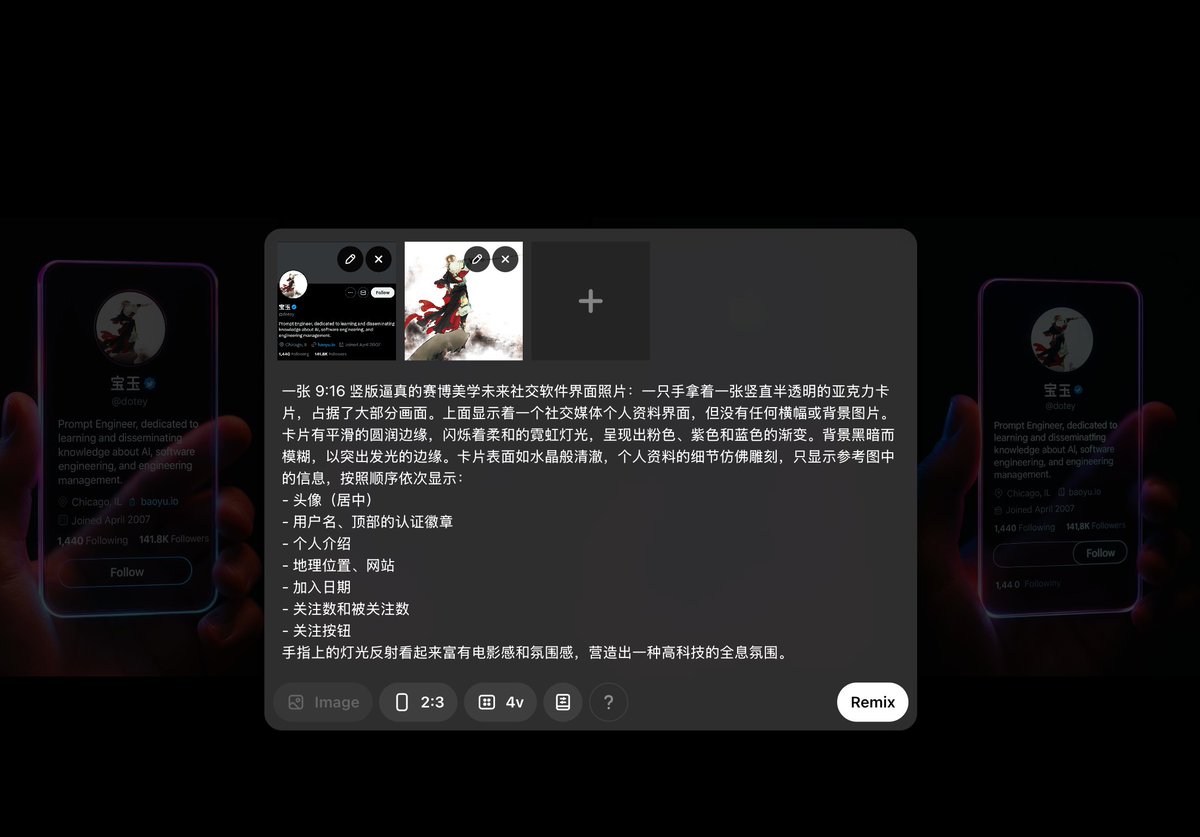

Ralph Wiggum 插件:让 Claude Code “通宵干活”

Ralph Wiggum 插件:让 Claude Code “通宵干活”https://x.com/dotey/status/2007197068394164613

https://twitter.com/dotey/status/2002561113842495805

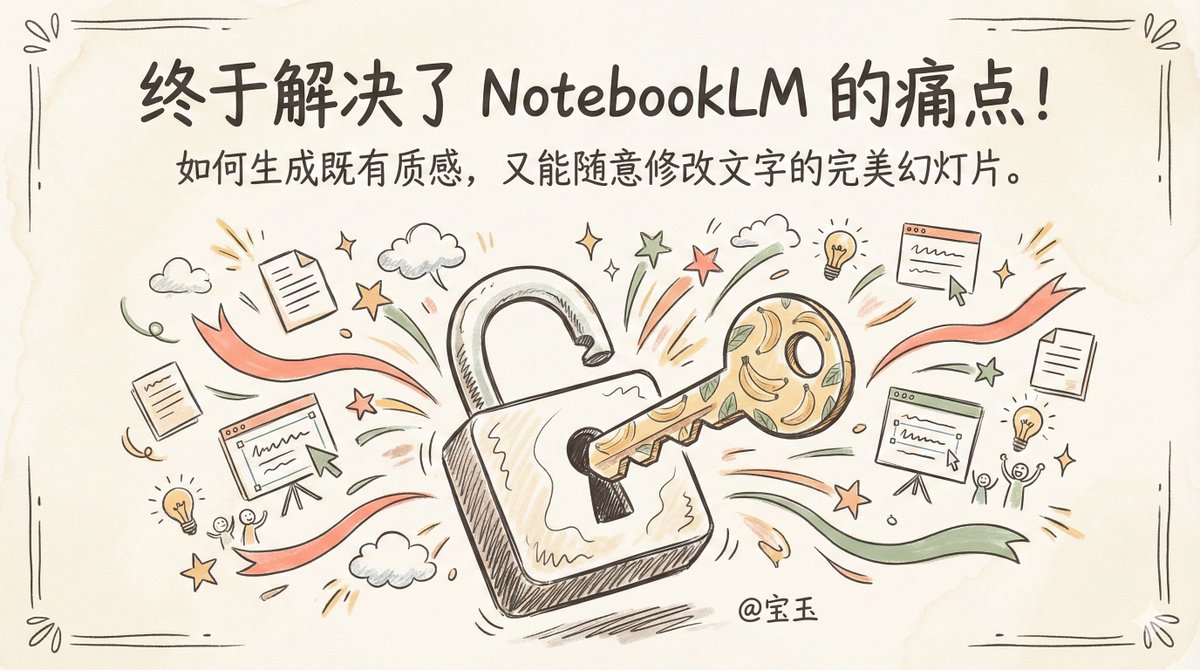

但有一个大问题:生成的 Slides 是死图,文字不能改,内容不能动。

但有一个大问题:生成的 Slides 是死图,文字不能改,内容不能动。

Dynamically generate a current weather card based on a given city name. (date is optional)

Dynamically generate a current weather card based on a given city name. (date is optional)https://x.com/dotey/status/1993729800922341810

https://x.com/dotey/status/1991790313799606651

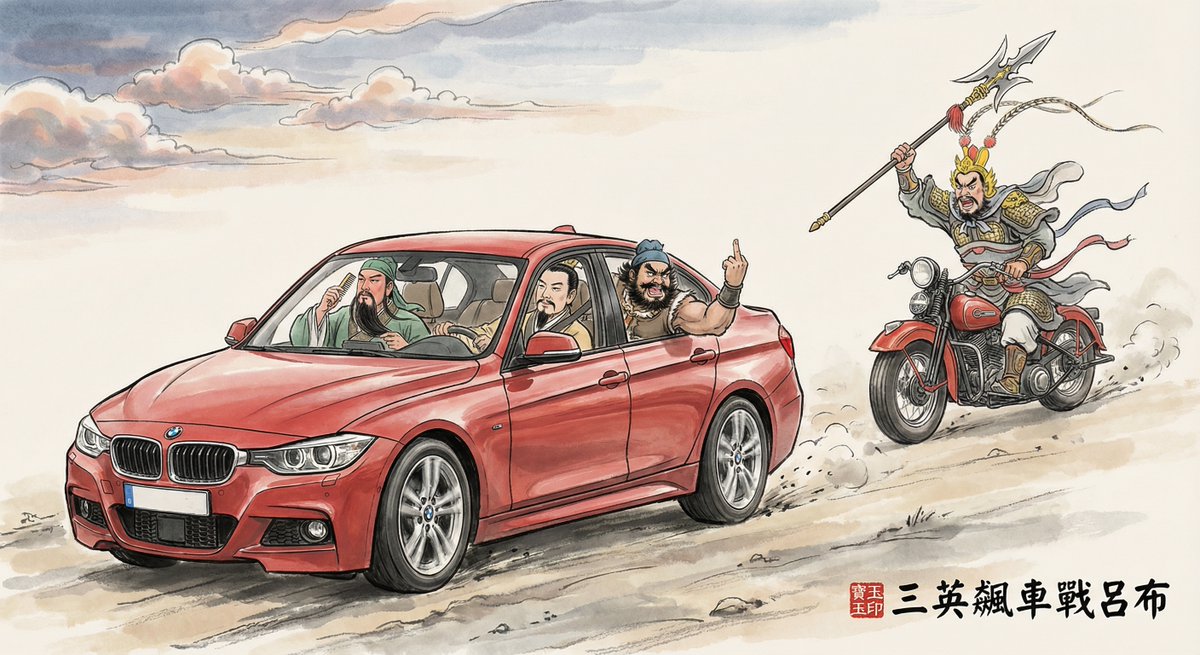

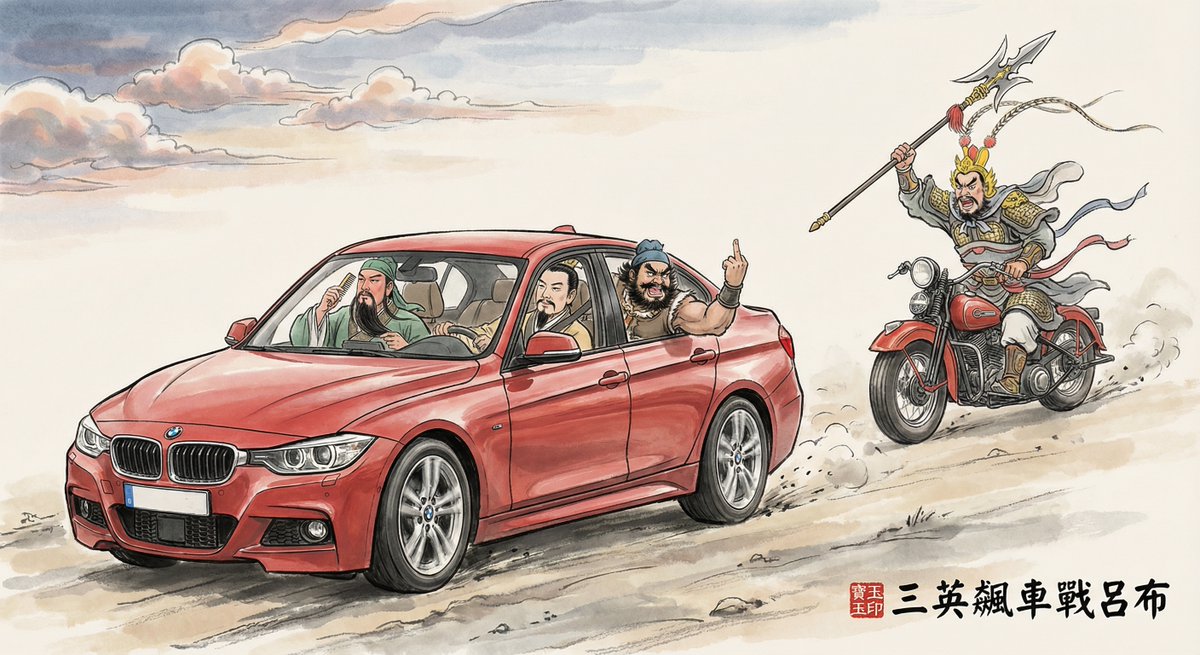

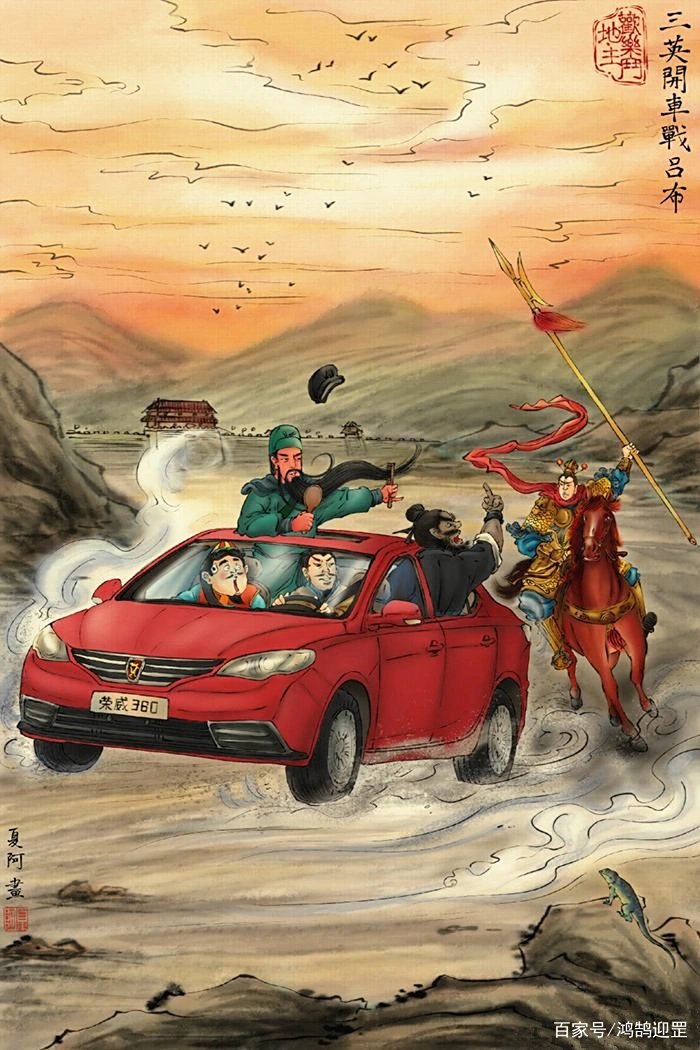

网友作品

网友作品

注:图画创意原作者夏阿,只是尝试用 AI 重现

注:图画创意原作者夏阿,只是尝试用 AI 重现

https://x.com/dotey/status/1985846791842250860

可能有人还记得 2023 年 @DrJimFan 他们团队做的一个玩 Minecraft 的 Agent Voyager,就能把玩游戏的技能写成代码,保存起来后续使用,最终让 Agent 在 Minecraft 中做很多事。现在想想还是蛮超前的。

可能有人还记得 2023 年 @DrJimFan 他们团队做的一个玩 Minecraft 的 Agent Voyager,就能把玩游戏的技能写成代码,保存起来后续使用,最终让 Agent 在 Minecraft 中做很多事。现在想想还是蛮超前的。https://x.com/DrJimFan/status/1662115266933972993

Sora 或者 ChatGPT

Sora 或者 ChatGPT

案例:解读《DeepSeek-OCR: Contexts Optical Compression》

案例:解读《DeepSeek-OCR: Contexts Optical Compression》https://x.com/dotey/status/1981079085590667331

https://x.com/dotey/status/1972758349944111445它和 OpenAI 的 Agent SDK 不一样的地方在于 Claude Agent SDK 这个是开箱即用,内置了 Claude Code 的所有工具,包括子智能体、Slask Command、MCP 支持,OpenAI 的只是开发框架,你还要自己写一堆工具

https://x.com/kylesean6/status/1973944225596387484

另外也没办法真的 8 小时,Claude Code 会偷懒,执行一会就会自行中断,即使没用多少上下文,暂时还没解决这个问题,但是思路可以借鉴一下,如果有更好办法,欢迎留言交流。

另外也没办法真的 8 小时,Claude Code 会偷懒,执行一会就会自行中断,即使没用多少上下文,暂时还没解决这个问题,但是思路可以借鉴一下,如果有更好办法,欢迎留言交流。

https://twitter.com/Fenng/status/1971483507798188062它要是真支持插件倒也还好,插件也不支持,使用体验极其割裂,要第三方插件上排版好,然后复制粘贴过去,图片什么的还经常无法正常复制过去,需要一个个手动上传,视频的上传也极其繁琐,每次用就感觉在吃💩

https://x.com/xqql388BC/status/1971718279669653839

https://x.com/dotey/status/1966384042665783719

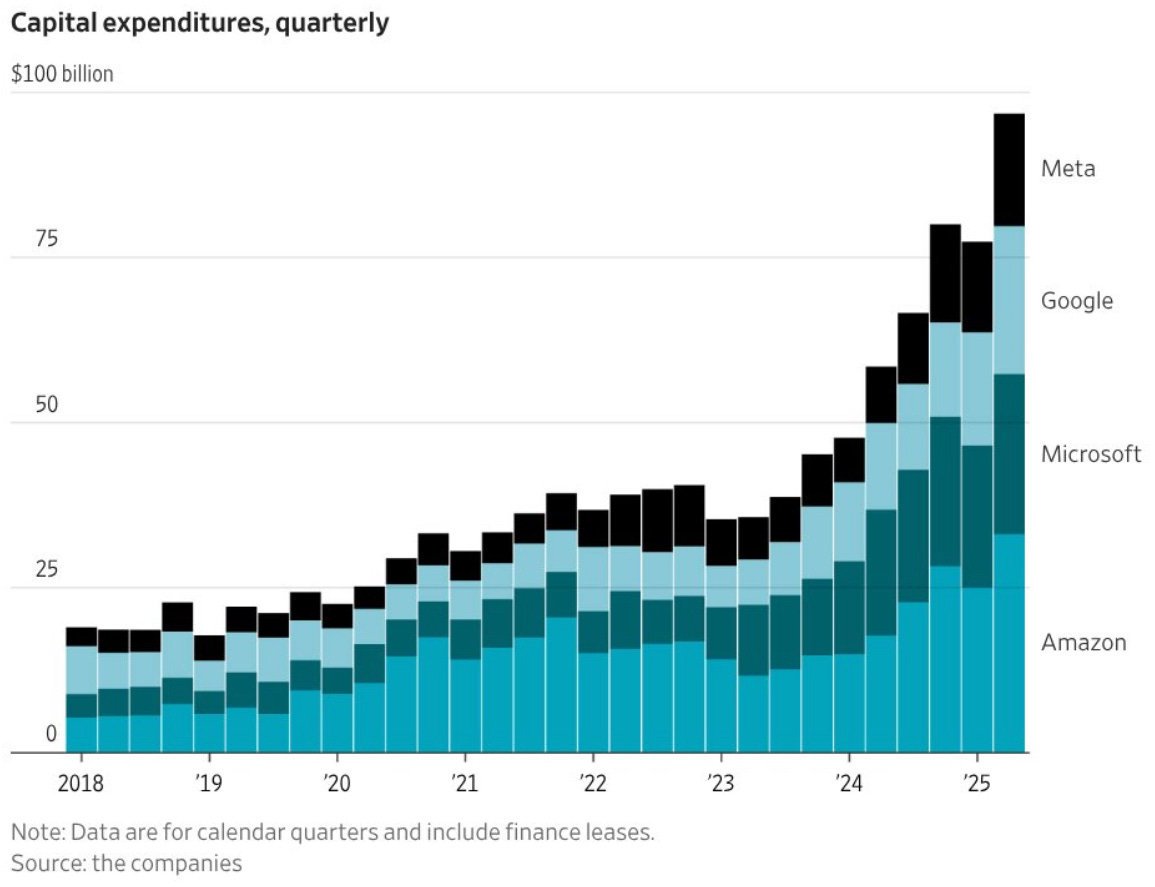

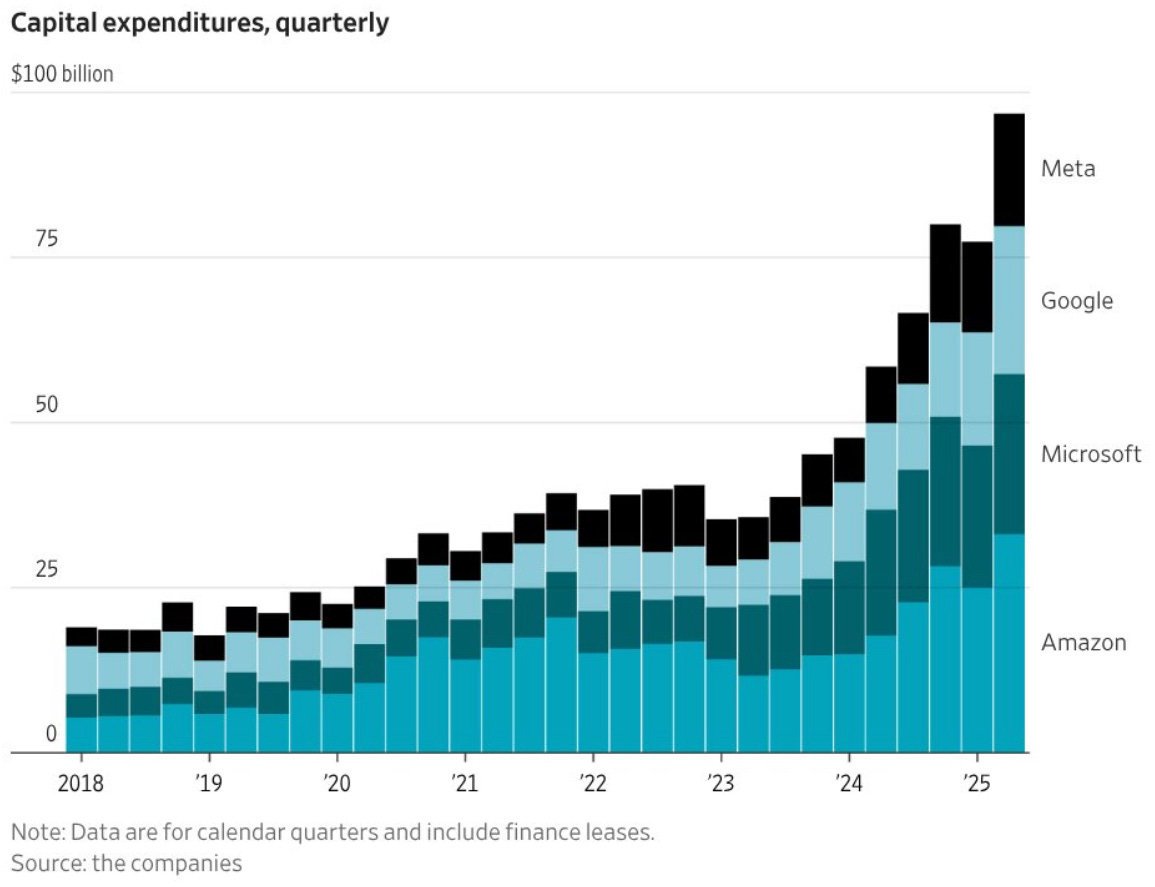

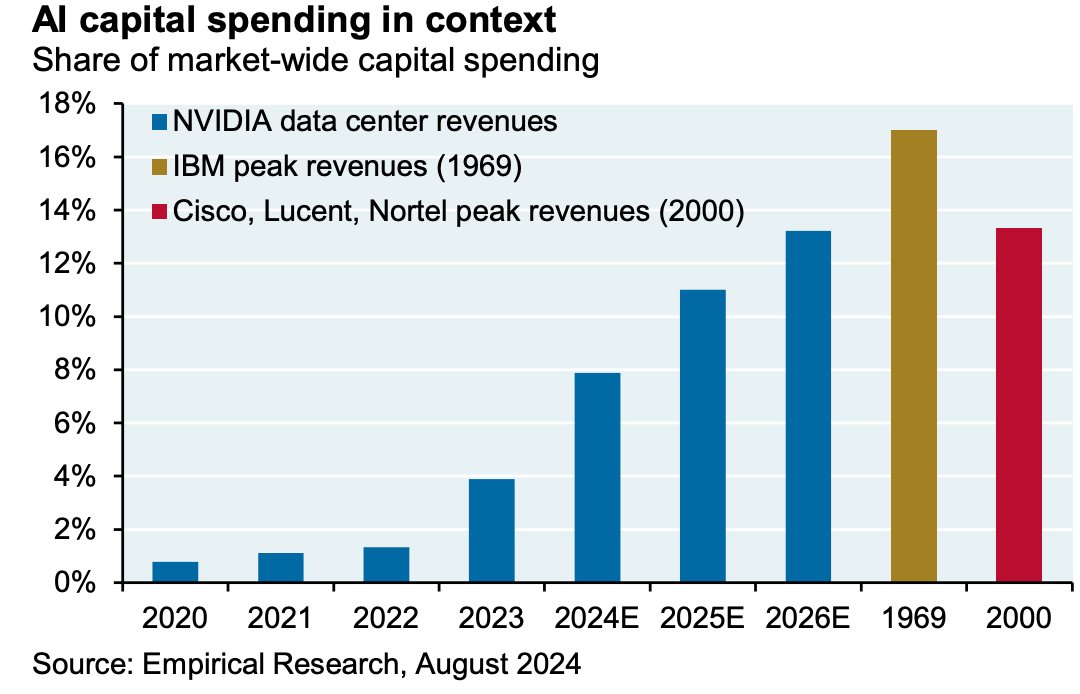

你能将这些数字置于历史背景中吗?

你能将这些数字置于历史背景中吗?

https://twitter.com/atian25/status/1942782582065881461@frxiaobei 的观点:

https://x.com/frxiaobei/status/1949827073507569823

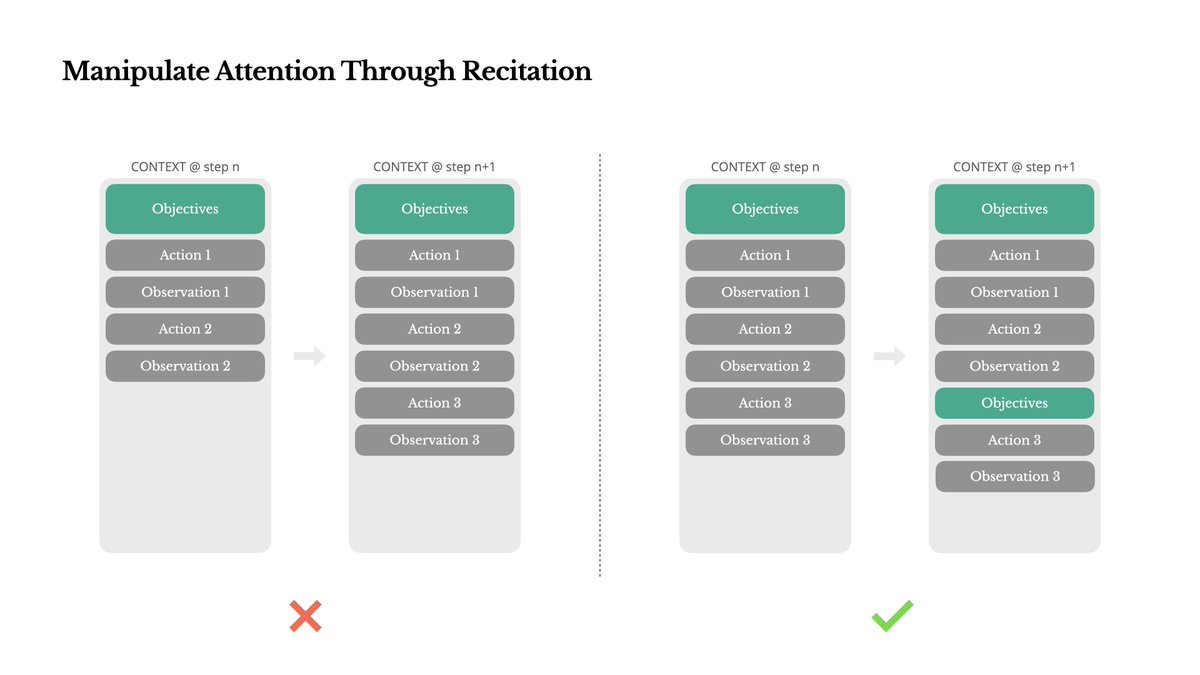

5. 通过复述操控注意力

5. 通过复述操控注意力

https://x.com/dotey/status/1931142417849491693

“talk is cheap,show me the code”

“talk is cheap,show me the code” https://twitter.com/autogpt5/status/1926064229553000793

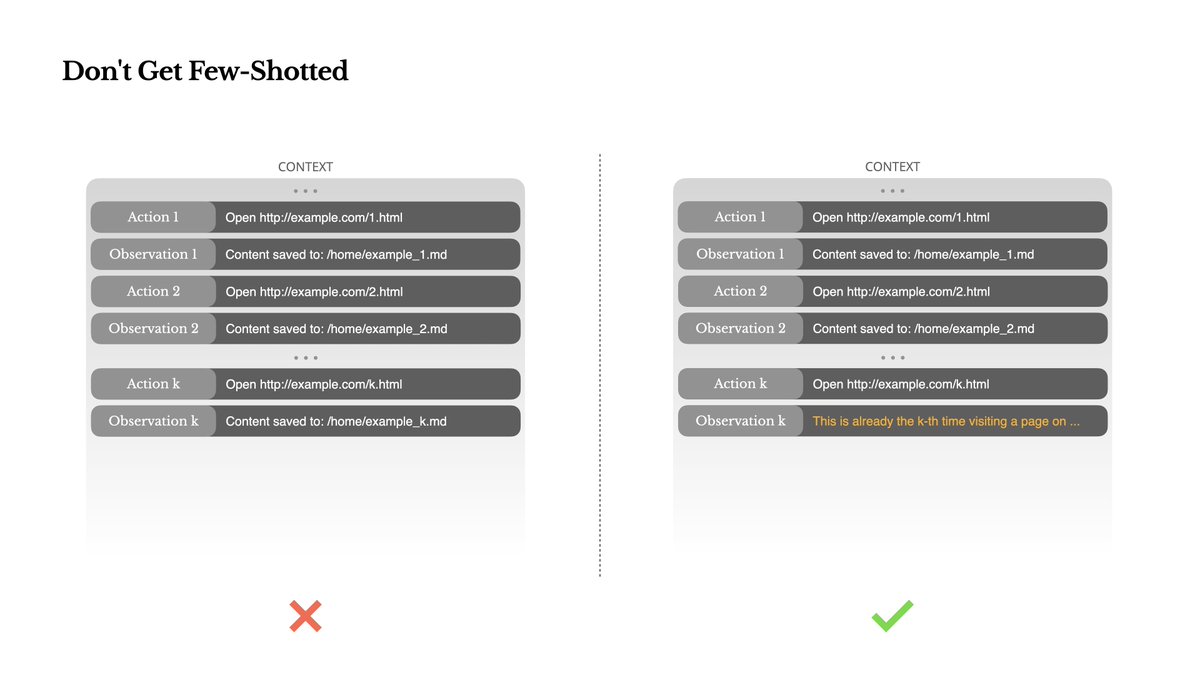

划重点:知道 Deep Research 智能体的架构后怎么更好的使用

划重点:知道 Deep Research 智能体的架构后怎么更好的使用

第一阶段:AI 智能自动完成(Copilot 时代)

第一阶段:AI 智能自动完成(Copilot 时代)