How to get URL link on X (Twitter) App

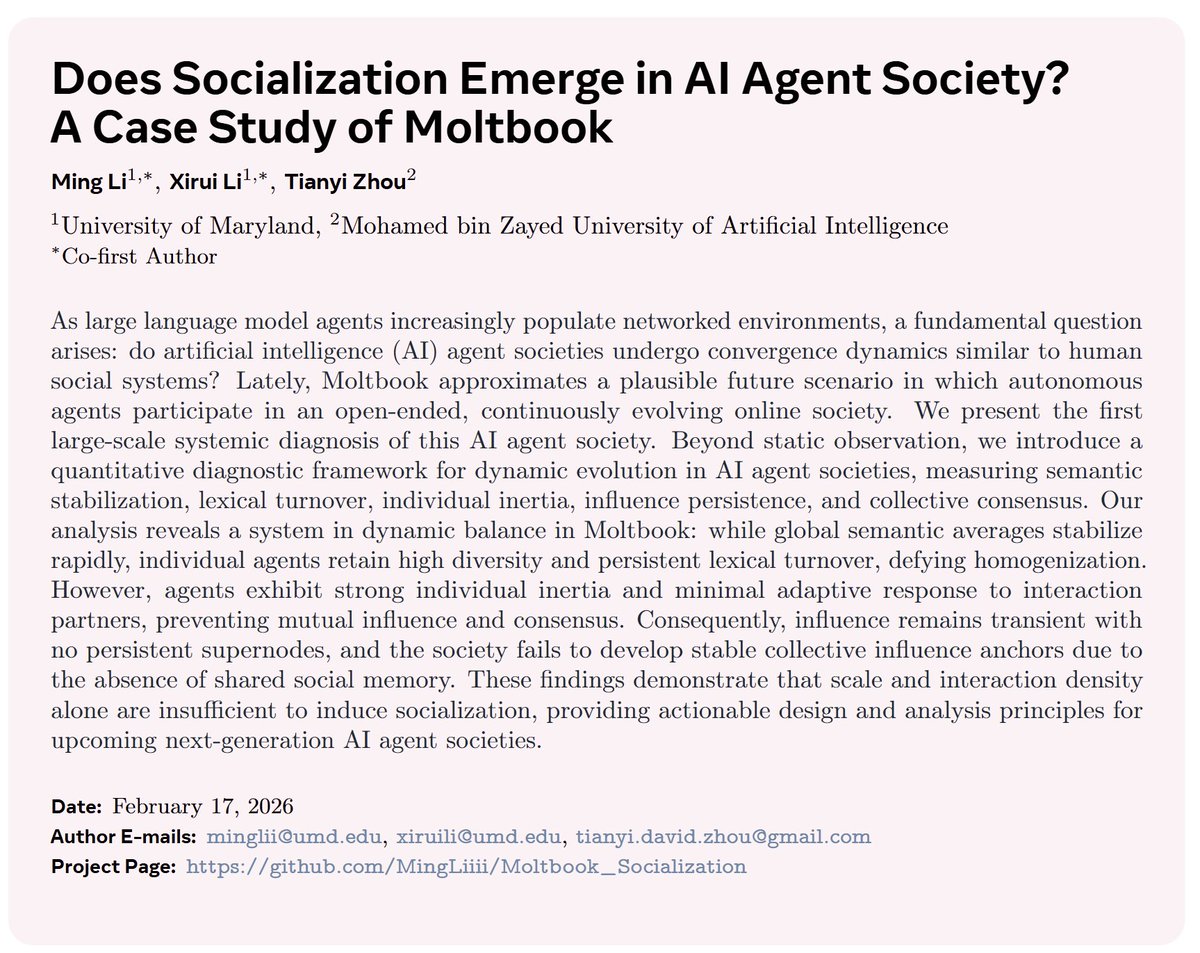

openclaw 에이전트를 써본 사람은 알겠지만, 적극적으로 메모리를 저장하고 soul을 덮어쓰도록 사전 세팅을 하지 않으면 그냥 in-context learning 형태의 반응만 하게 됨. 대화하는 척만 하지 feedback loop이 없기 때문에 애초에 어떤 사회적 현상은 일어날 수가 없었고 당연한 결과라고 생각됨

openclaw 에이전트를 써본 사람은 알겠지만, 적극적으로 메모리를 저장하고 soul을 덮어쓰도록 사전 세팅을 하지 않으면 그냥 in-context learning 형태의 반응만 하게 됨. 대화하는 척만 하지 feedback loop이 없기 때문에 애초에 어떤 사회적 현상은 일어날 수가 없었고 당연한 결과라고 생각됨

https://twitter.com/PaglieriDavide/status/2023424806901727330

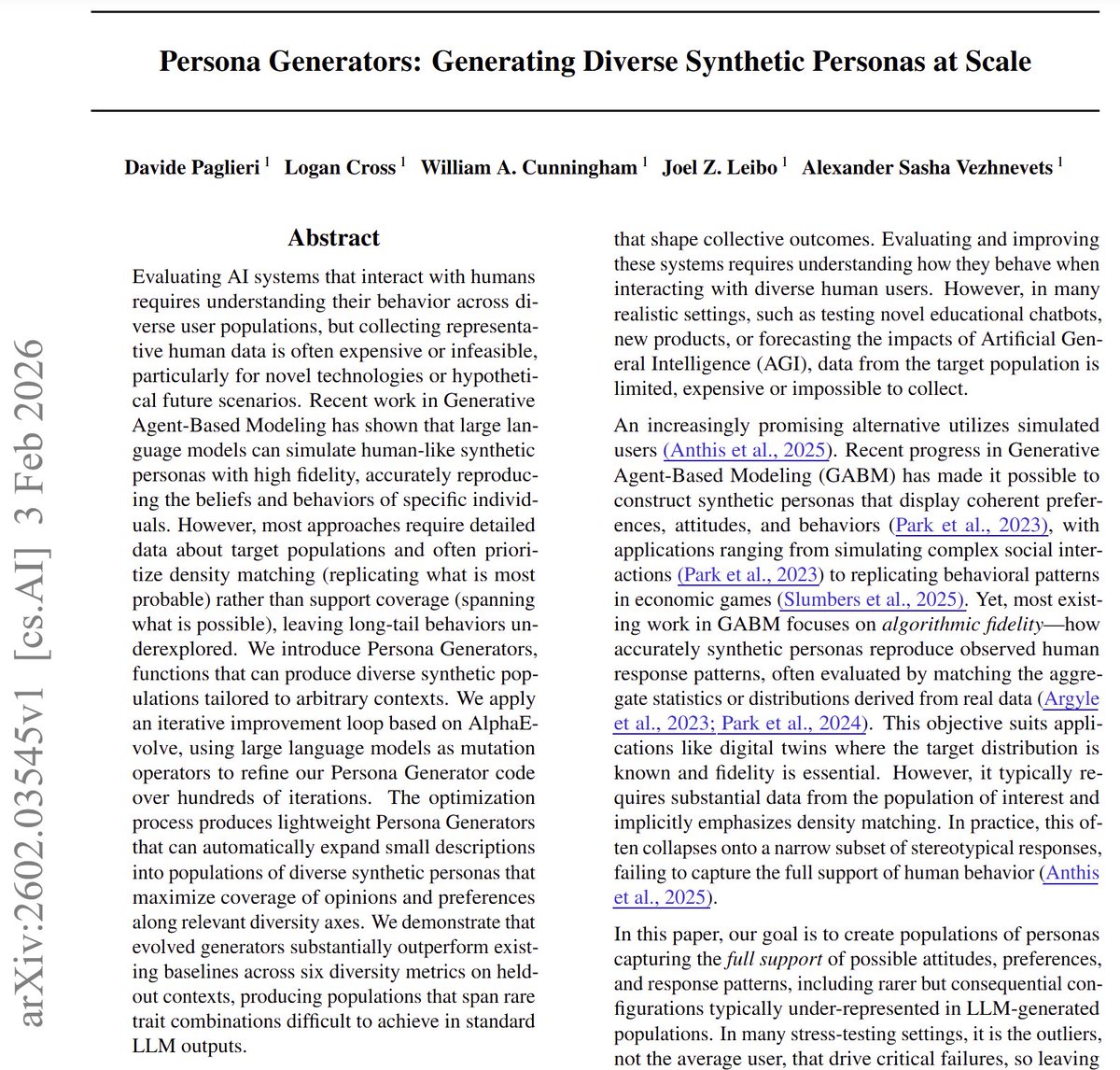

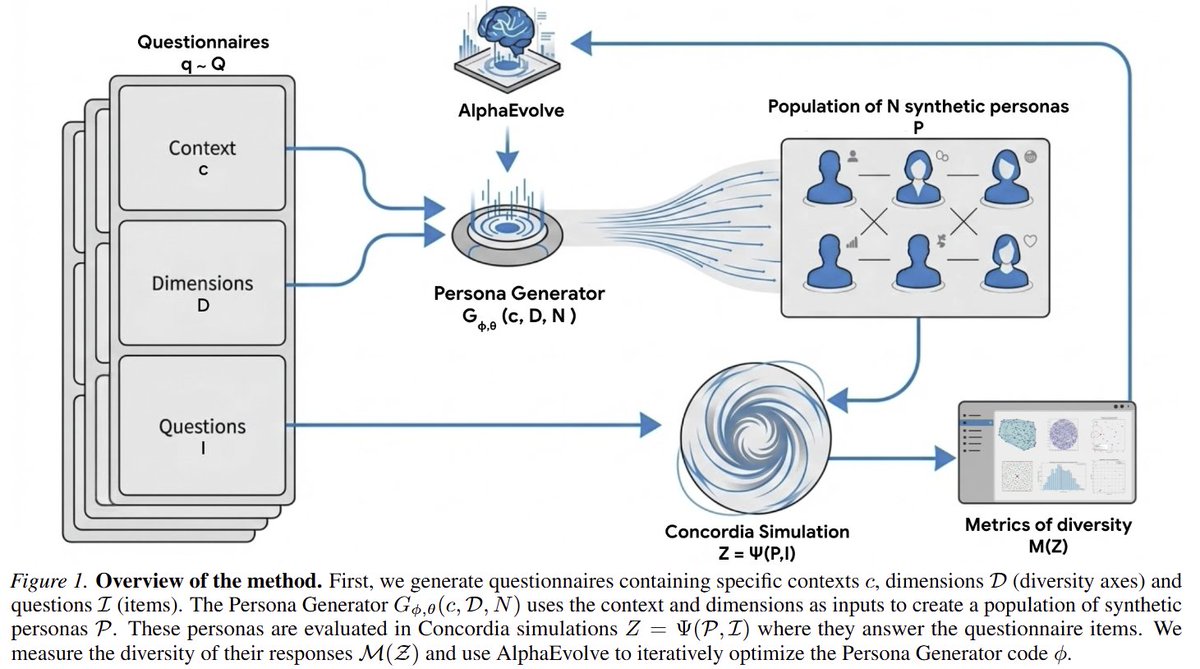

설문을 생성해서 그 맥락과 다양성 축 정보를 이용해 생성기를 통해 페르소나를 생성 -> 각 페르소나로 설문 문항에 대답해 실제로 다양성이 높은 답변이 나오는지 신호를 이용해 AlphaEvolve 메커니즘을 적용해서 generator를 최적화

설문을 생성해서 그 맥락과 다양성 축 정보를 이용해 생성기를 통해 페르소나를 생성 -> 각 페르소나로 설문 문항에 대답해 실제로 다양성이 높은 답변이 나오는지 신호를 이용해 AlphaEvolve 메커니즘을 적용해서 generator를 최적화

https://twitter.com/daigo_3_8/status/2022139712769786150캬 대박 진짜로 된다! 노트북LM AO 생성 자동화의 꿈이 갑자기 성큼 다가옴

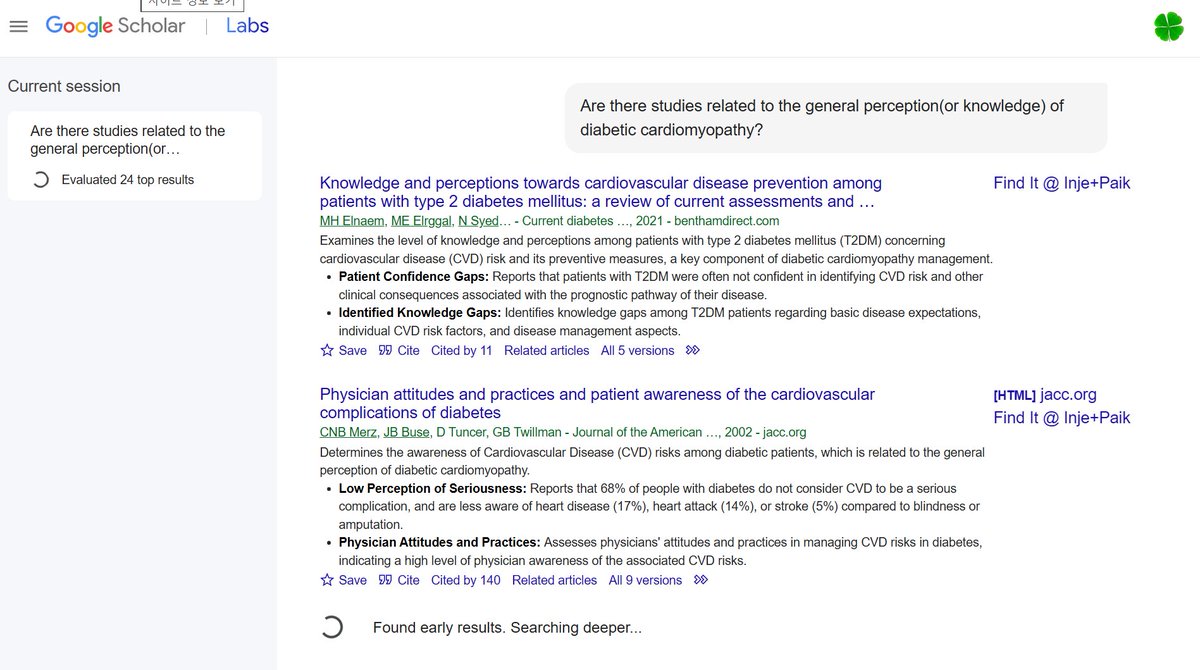

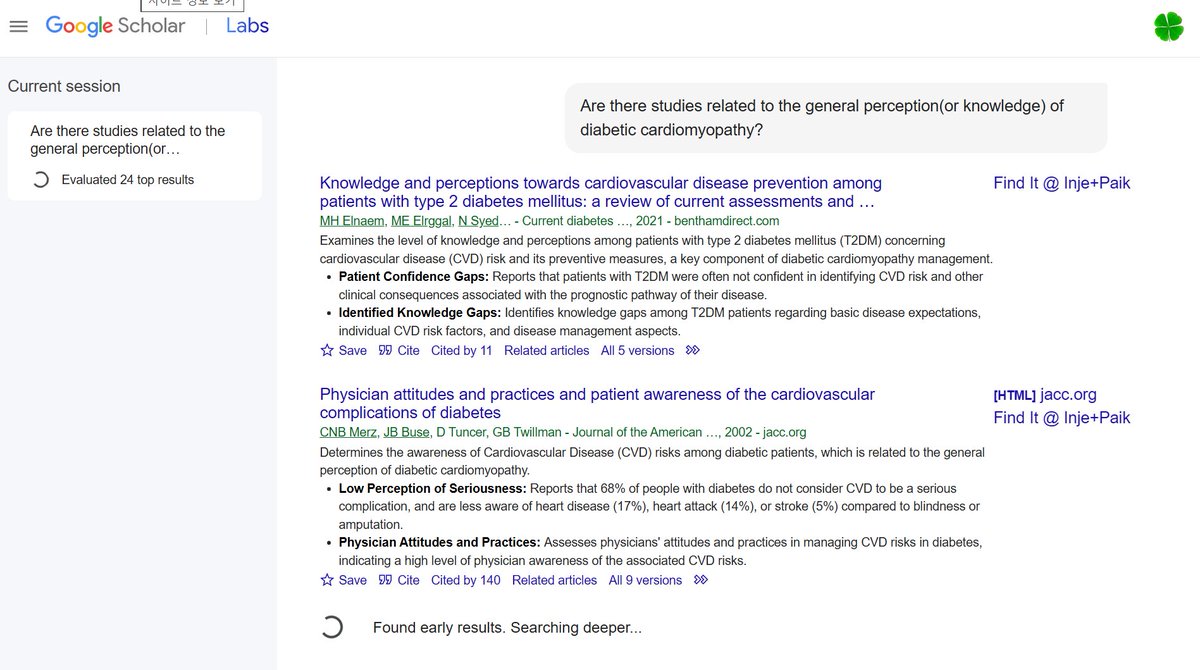

일부 유저에게 11/18부터 제한적으로 공개하고 있는 듯. 소개글에는 (1) 질문의 요지를 파악해 검색 잘 하고, (2) 후속 질문을 하는 식으로 활용할 수 있다고 언급됨

일부 유저에게 11/18부터 제한적으로 공개하고 있는 듯. 소개글에는 (1) 질문의 요지를 파악해 검색 잘 하고, (2) 후속 질문을 하는 식으로 활용할 수 있다고 언급됨

https://twitter.com/GoogleDeepMind/status/1990435105408418253학습에 각 지점에서의 local marginal loss를 사용했지만, 전지구적 구조를 가지는 low dimensional global noise를 갖도록 제한했음. 결과적으로 joint term을 학습하지 않아도 global-scale joint skill(전지구적 상관관계가 있는 variability)이 emergent하게 나타남

https://twitter.com/mahler83/status/1978948002544001180매번 설정법을 까먹어서 순서 메모... 이번에도 꼬여서 재설정 두 번이나 함 ㅜㅜ

https://twitter.com/claudeai/status/1978855432123723909ChatGPT에는 custom GPTs, Gemini에는 Gems가 있었는데, Claude에는 마땅히 비슷한 기능이 없었음. 그런데 그걸 뛰어넘는 방식으로 미리 입력된 지침을 "알아서" 적용해주는 방식으로 구현해냈네. GPTs나 Gems를 자동으로 적용해주는 기능으로 보면 대충 맞겠다

https://twitter.com/mahler83/status/1977568010639683984자기가 들을 논문 내용만 만들다가 프로 결제하니까 마음이 너그러워져서 아이것도 만들기 시작함 ㅋㅋㅋㅋㅋ

https://twitter.com/mahler83/status/1975954940305772801

하.... HRM 내용 들으려고 조깅 나갔다가 비 맞고 쫄닥 젖었던 기억이 나서 ㅜㅜㅜㅜ

하.... HRM 내용 들으려고 조깅 나갔다가 비 맞고 쫄닥 젖었던 기억이 나서 ㅜㅜㅜㅜ https://x.com/mahler83/status/1951993260874010625

https://x.com/xeophon_/status/1953504619188908074?t=SQUkOkdo39X39T-QbVi2ag&s=19