Nuttige zaken die je met het nieuwe Crawl Stats report in #GSC op kunt pakken:

1: Host status van de afgelopen 90 dagen monitoren en eventuele foute in deze periode aan het licht brengen #gsc

2: Afhankelijk van het type site kunnen verhoudingen in type gecrawlde bestanden nuttig zijn. Richt je je veel op images maar zie je deze weinig gecrawld worden? Kan technisch issue zijn. Bijvoorbeeld het niet goed ontsluiten van deze bestanden of het (traag) serveren #gsc #seo

2.1: Wellicht worden er veel images gecrawld die je helemaal niet gecrawld wilt hebben? Google kan hierdoor de prioriteit die zij aan images geven omlaag schroeven. #gsc #seo

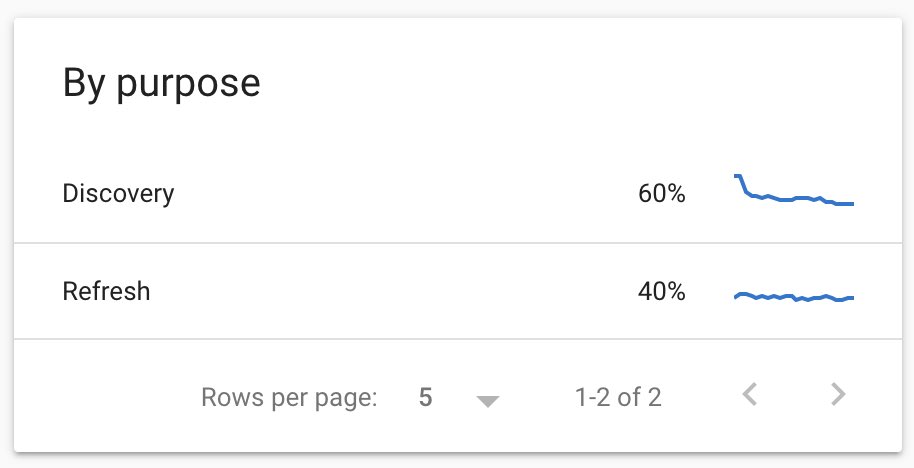

3: Discovery vs refresh: Publiceer je veel, maar blijft Google hangen in refresh crawls? Dat zou kunnen duiden op een structuur die zwaarder leunt op al eerder gepubliceerde content ipv je nieuwe content #gsc #seo

3.1: Als je een nieuwssite hebt zal je hier wat anders zien dan een meer statische site. Ik zie verschillen in discovery tussen de 1 en 60%(!!). Grote dynamische sites waarvan grotere delen niet geindexeerd zijn hebben ook een hoog discover %. #gsc #seo

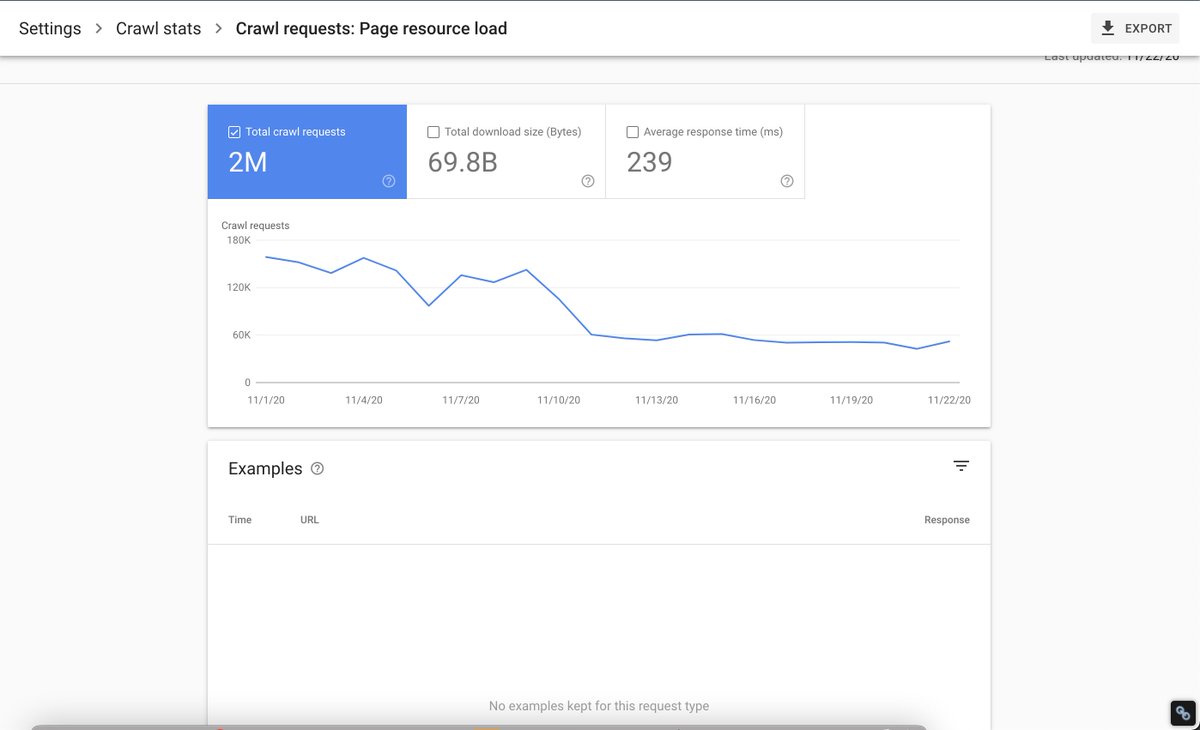

4: "By Googlebot type" is interessant: ”Page resource load". Dit zijn de request die Googlebot doet naar bestanden die bij een pagina (voor renderen). Idealiter is dit een laag %, behalve als je bijvoorbeeld voor iedere pagina aparte of extra CSS/JS gebruikt. #gsc #seo

4.1: Aparte CSS/JS is voor Core Web Vitals vaak wel weer aan te raden per type pagina, zodat je Largest Contentful Paint (LCP) beter uit de verf kan komen. #gsc #seo

4.2: Vreemde is dat hier geen voorbeelden gegeven worden. Voor sommige sites is dit aantal requests erg groot. #gsc #seo

Let wel goed op het volgende:

1: Google geeft zelf aan dat de gerapporteerde URL's om voorbeeld URL's gaat en je dus geen compleet beeld kunnen geven #gsc #seo

1: Google geeft zelf aan dat de gerapporteerde URL's om voorbeeld URL's gaat en je dus geen compleet beeld kunnen geven #gsc #seo

2: Potential crawls (crawls die niet uitgevoerd zijn, maar die (waarschijnlijk) wel in de rij hebben gestaan) worden ook mee geteld in het aantal gecrawlde bestanden. Hier heb je verder geen inzicht in! #gsc #seo

2.1: Google schaart deze onder "Fetches that were never made because the robots.txt file was insufficiently available." #gsc #seo

3: Houd je robots.txt beschikbaarheid in de gaten. Uit de nieuwe documentatie blijkt dat als deze eerst wel beschikbaar was, maar later niet meer op te vragen (anders dan 404), Google stopt met crawlen voor 1 dag. #gsc #seo

3.1: "If your robots.txt file remains unavailable for a day, Google will halt crawling for a while until it can get an acceptable response to a request for robots. #gsc #seo

4: De voorbeeld URL's kunnen zeer beperkt zijn: Ik zie in verschillende accounts een percentage van >0,03% van HTML request als voorbeeld en >0,2% voor images. #gsc #seo

5: Ondanks dat Google aangeeft dat ze nofollows sinds dit jaar ook crawlen, geven ze in hun nieuwe documentatie toch aan dat je infinite crawl traps (bijv. kalenders) uit kunt sluiten met nofollows op links. #gsc #seo

6: In dezelfde docucumentatie geeft Google ook aan dat wanneer je site teveel gecrawld wordt, je voor directe verlichting robots.txt kunt gebruiken. Dat is best vreemd, want Google crawld deze soms maar 1x per dag. #gsc #seo

7: Waarom zit dit onder settings??? Zoals oa @sjoerdcopier ook al aangaf

8: Hier de pagina met de documentatie van Google zelf voor het Crawl Stats Report support.google.com/webmasters/ans… #gsc #seo

• • •

Missing some Tweet in this thread? You can try to

force a refresh