Natural Language Processing/Machine Learning | Doctor of Philosophy | Father | You name it

How to get URL link on X (Twitter) App

Strona projektu AutoRT, tam są linki do artykułów:

Strona projektu AutoRT, tam są linki do artykułów:https://x.com/LeszBuk/status/1620440272512368640?s=202/ O konstytucji AI i etyce uwikłanej w trenowanie LLMs

https://x.com/LeszBuk/status/1623734866998333445?s=20

2/ Pisałem o tym jakiś czas temu i tamten tłit wywołał, co zrozumiałe, trochę dyskusji.

2/ Pisałem o tym jakiś czas temu i tamten tłit wywołał, co zrozumiałe, trochę dyskusji.https://twitter.com/LeszBuk/status/1625986577716371456?s=20

Elon zapowiedział, że formuje własny zespół do stworzenia LLM. Model, który ma powstać, nie będzie posiadał kagańców w postaci politycznej poprawności. Będzie też mógł obrażać użytkownika.

Elon zapowiedział, że formuje własny zespół do stworzenia LLM. Model, który ma powstać, nie będzie posiadał kagańców w postaci politycznej poprawności. Będzie też mógł obrażać użytkownika.

https://twitter.com/leszbuk/status/1620440272512368640?s=61&t=R3gFkBWXwuUSSN3PYJnGlw1/ Upublicznienie przez OpenAI modelu ChatGPT wywołało duże poruszenie. O ile w naszym światku technologicznym już od co najmniej 2-3 lat było wiadomo, że istnieją modele o takich możliwościach, to jednak takie firmy jak Google bały się dać otwarty dostęp do nich.

1/ Zgodnie z koncepcją "singularity" inteligencja maszyny miałaby być lepsza od ludzkiej w każdej dziedzinie. Nie wiem, czy tak będzie i szczerze mówiąc, nie przepadam za tą koncepcją, ale na pewno istnieją obszary, w których już obecnie maszyny są lepsze od nas.

1/ Zgodnie z koncepcją "singularity" inteligencja maszyny miałaby być lepsza od ludzkiej w każdej dziedzinie. Nie wiem, czy tak będzie i szczerze mówiąc, nie przepadam za tą koncepcją, ale na pewno istnieją obszary, w których już obecnie maszyny są lepsze od nas.

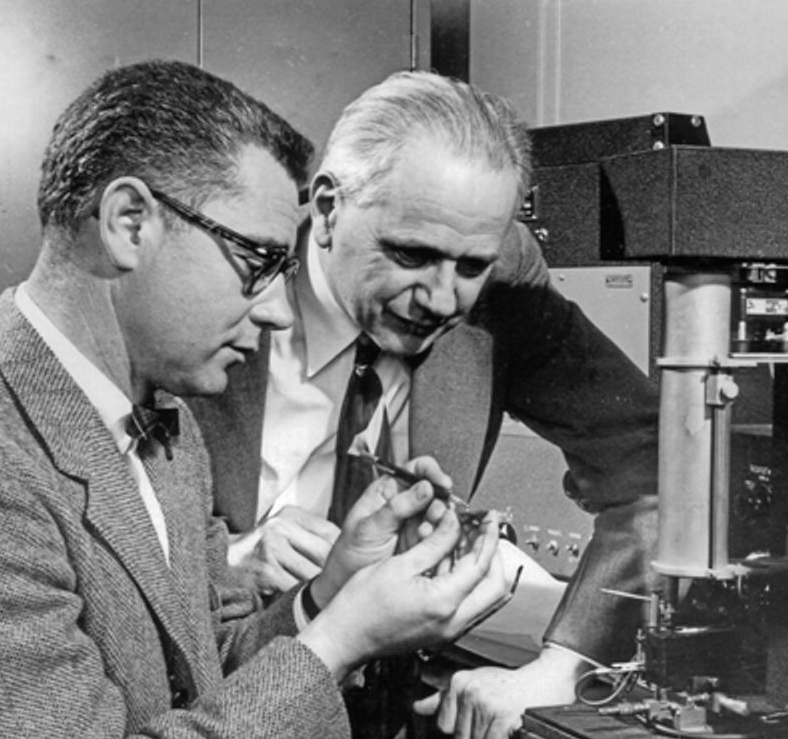

Książka przedstawia całą historię półprzewodników i układów scalonych od samych początków, mających miejsce w Bell Labs, powstanie Doliny Krzemowej aż po lata 2020-2021, kiedy pandemia uderza w gospodarkę światową.

Książka przedstawia całą historię półprzewodników i układów scalonych od samych początków, mających miejsce w Bell Labs, powstanie Doliny Krzemowej aż po lata 2020-2021, kiedy pandemia uderza w gospodarkę światową.