Avant de commencer ma démonstration, je vous préviens que ma démonstration va aller bcp plus loin que les tests diagnostics.

On y va !

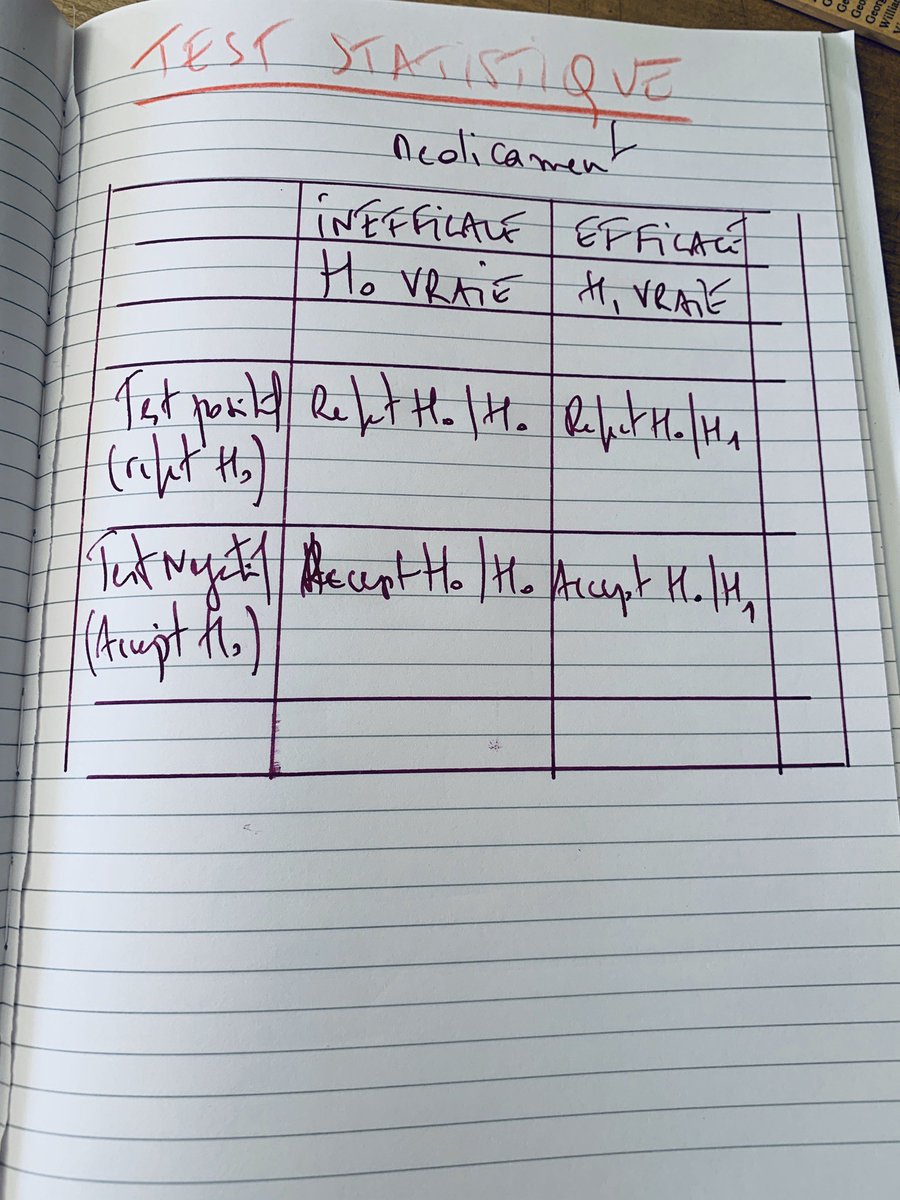

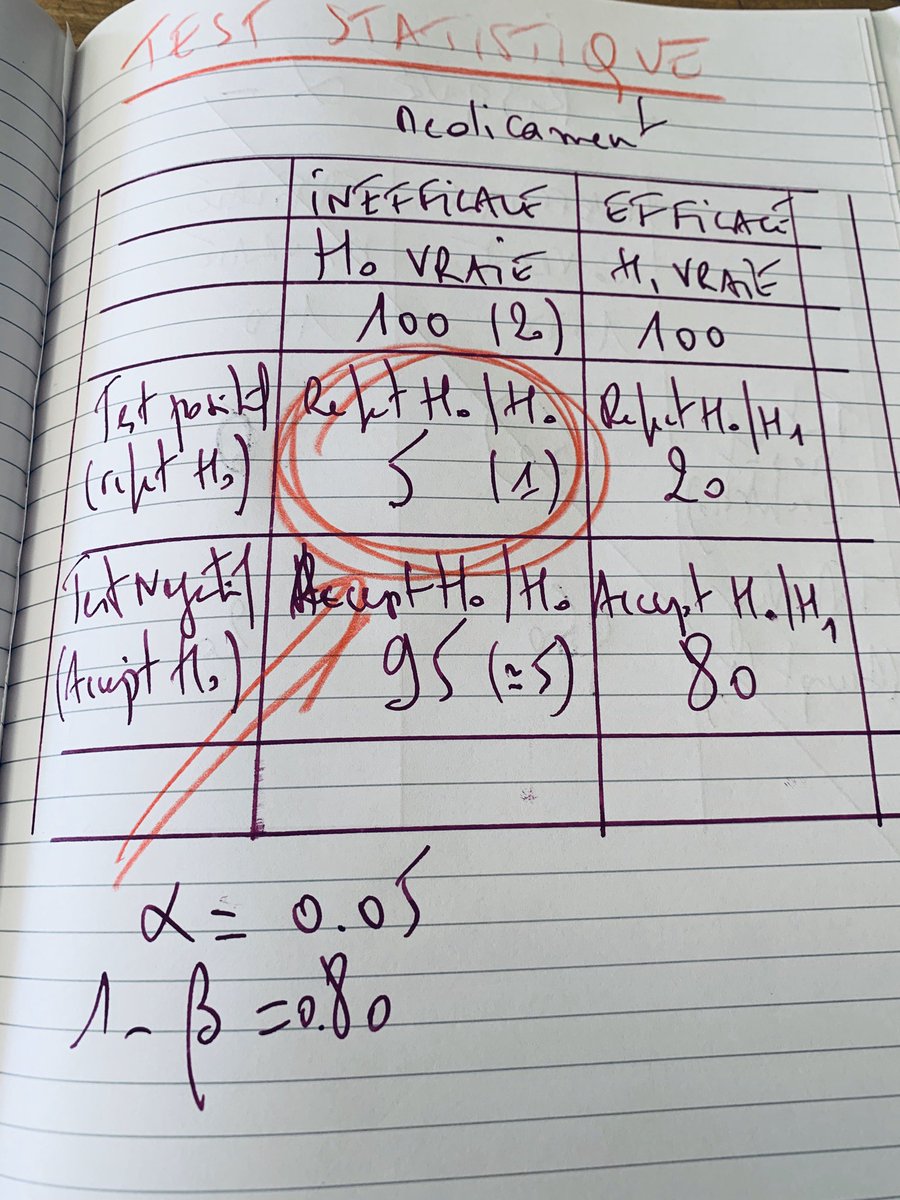

Reprenons notre tableau.

S’aggissant d’un médicament, vous avez deux possibilité ... soit il est efficace, soit il ne l’est pas.

En faisant l’hypothèse FONDAMENTALE que votre essai est PARFAITEMENT conduit.

C’est LA raison pour laquelle les personnes qui cherchent à tout prix à montrer qu’un traitement est efficace ALORS QU’IL NE L’EST PAS, vont tout mettre en œuvre pour augmenter le risque alpha cad ...

1/ Il faut se dérober aux approches rigoureuses de la conduite des essais cliniques.

2/ Augmenter artificiellement le risque alpha.

3/ Multiplier le nombre d’essais cliniques.