В основном компьютерщики и математики, а не лингвисты. Лингвистическое тут есть, но его не так много, особенно по сравнению с количеством математики и программирования для создания и использования новых методов

К русским нлп-шникам: я не знаю русского жаргона, так как начал заниматься этой сферой здесь, так что расскажите если что

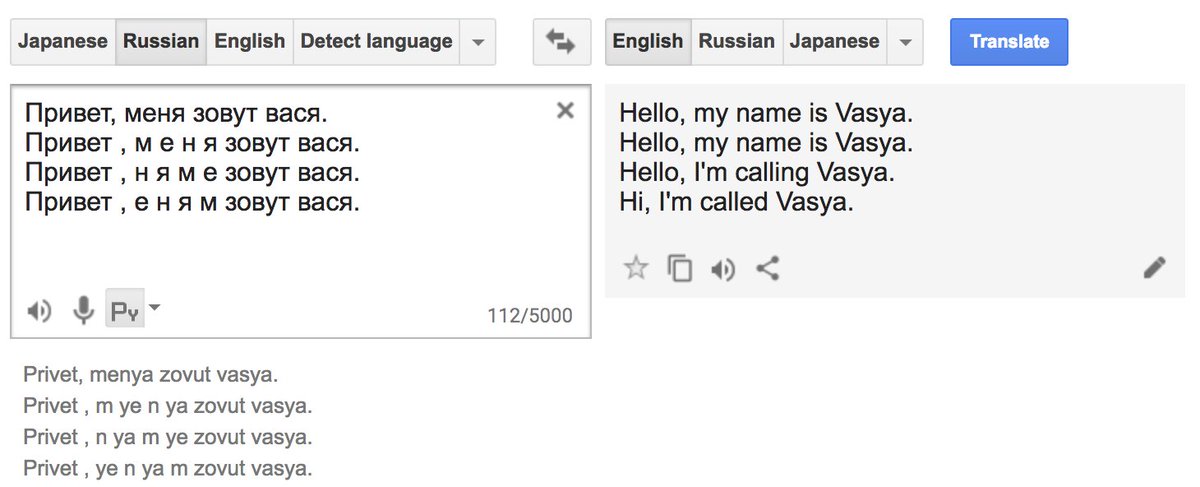

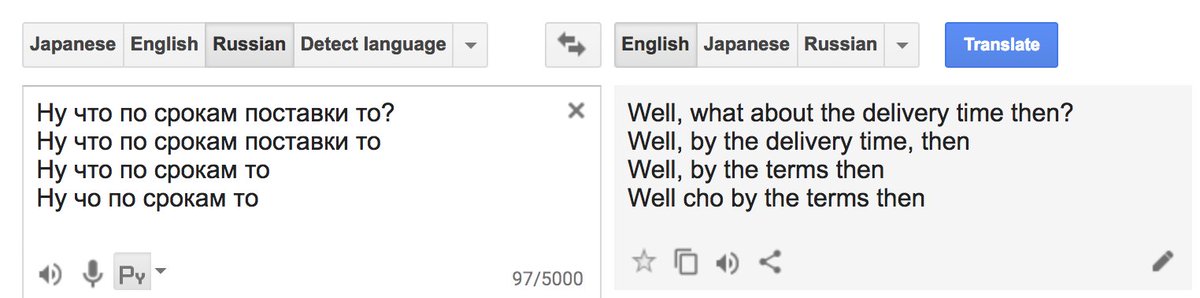

Линк: translate.google.com/#ru/en/%D0%9D%…

Японский я оставлю без перевода, пользуйтесь гугл-транслейтом в лучших традициях этого треда.

Тогда бы можем посчитать нграмы (до определённого порядка) на большом объеме текстов и использовать полученные величины для вычисления вероятностей

Хорошо ув. г-н. Иванов, мы вас запомним.

особенно в веб-речи где нет пунктуации и больших букв всё очень сложно такие дела

wolframalpha.com/input/?i=heigh…

Наша метрика будет tf.idf = log(tf + 1) * log(n / df), она используется в том числе и для поиска

Обходим весь корпус.

Для каждого слова из корпуса рассматриваем контекст (например 5 слов влево и вправо)

Берём слово, контекстное слово и штук 10 случайных “мусорных” слов

Эта штука вызвала большое волнение в под-сообществе, занимающимся машинным переводом.

Заметьте пробелы, которые не меняют смысл. Можно даже поиграться с порядком букв в слове, результат тот же.