149. Зависит от определения “обычного компа” и задач. Если надо именно разрабатывать новые нейросетевые модели таки нужно некоторое количество вычислительных ресурсов. Но куда больше проблемы будут с данными. Открытых ресурсов мало и они мелкие.

1) Как-то структурировать информацию, доступную в текстовом виде

2) Понять запрос -> представить его в виде, чтобы он совпадал с информацией

3) Каким-то образом исполнить этот запрос

В математической записи что-то типа:

Президент(Путин, РФ)

Президент(Трамп, США)

research.fb.com/downloads/babi/

1 Mary moved to the bathroom.

2 John went to the hallway.

3 Where is Mary? bathroom 1

4 Daniel went back to the hallway.

5 Sandra moved to the garden.

6 Where is Daniel? hallway 4

И нам нужно отвечать на вопросы в нём

[1]John took the water bottle out of the backpack so that it would be lighter.

[2]John took the water bottle out of the backpack so that it would be handy.

Надо разрешить it, то есть понять на что оно указывает

pfnet.github.io/interactive-ro…

Смотрите ещё это видео, на японском правда. На английском меньше объектов:

en.wikipedia.org/wiki/Makoto_Na…

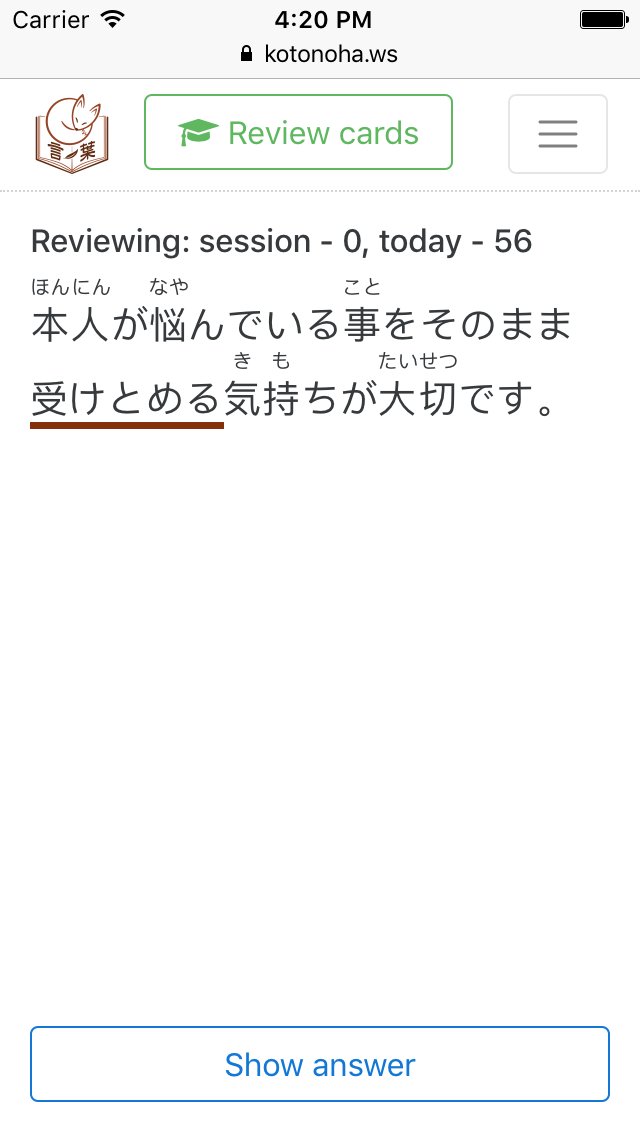

Исправляет много детских и не очень ошибок, которые стыдно показывать другим людям. А в своём глазу бревна не видно (кому видно тем повезло)

а) для хардкорщиков (правда менее хардкорщиков, что пишут свой софт)

б) очень сложно засунуть туда свой контекст к словам, который ОБЯЗАТЕЛЬНО нужно иметь

в) он заваливает новыми карточками

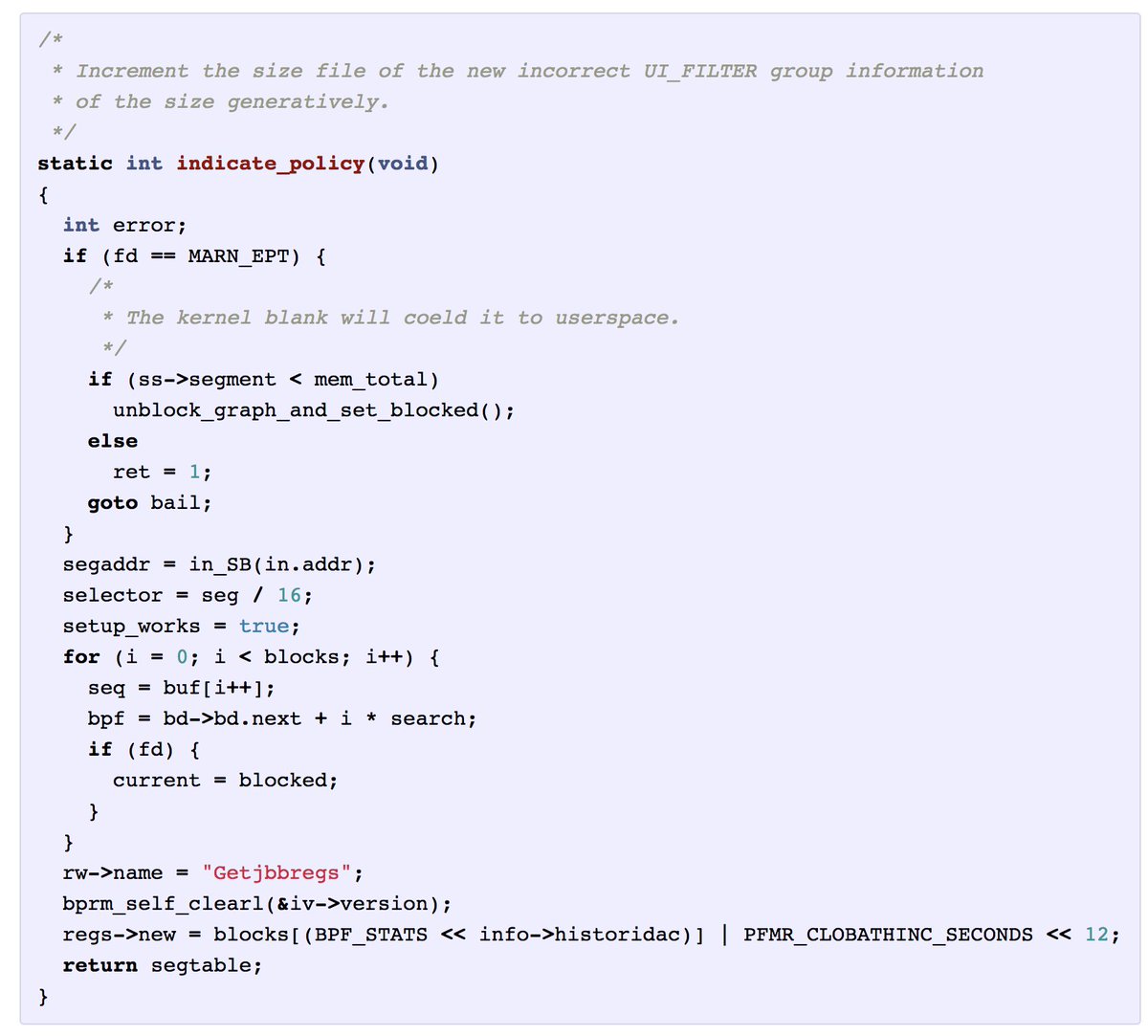

karpathy.github.io/2015/05/21/rnn…