minimal working examples抜きには曖昧過ぎて微妙に危険な感じ。よい推定、よい予測、よい意思決定の中身が不明過ぎる。

特に「意思決定」という言葉が「推定」や「予測」など任意の行動を決める意味が広い用語になっているせいで、「本当はよい意思決定を目指すべきだ」と誤解する危険性がある。続く

特に「意思決定」という言葉が「推定」や「予測」など任意の行動を決める意味が広い用語になっているせいで、「本当はよい意思決定を目指すべきだ」と誤解する危険性がある。続く

https://twitter.com/yujitach/status/1468446614960640000

教科書によく書いてある意思決定論では、パラメータ付きのモデル(推定推測推論用のモデル、以下単にモデルという)の内部で「最悪の場合の最善手」(ミニマックス)や「期待リスク最小化」(事前分布を主観確率と解釈すれば主観内で計算した期待リスク最小化)を考えます。

続く。リスクの定義を決める損失函数として「推定の悪さ」「予測の悪さ」の指標にすれば「モデル内でのよい推定」「モデル内でのよい予測」が得られ、仮に「金銭的な損失」の指標にできれば「モデル内での金銭的に最適な意思決定」が得られます。

そういう話は確かに結構面白いです。続く

そういう話は確かに結構面白いです。続く

用語の使い方について補足:統計学の文脈で「推定」(estimation)は「モデルのパラメータ値の決定」を意味することが多いです。「予測の悪さ」は予測分布と未知の真の分布の違いの大きさ(KL情報量がよく使われる)を意味することが多い。

補足続き。だから【現象を記述しているモデルを推定】という言い方で「推定」という言葉を使うと、「与えられたモデルのパラメータの決定」という意味での統計学的な文脈での「推定」とは全然違う意味になります。

https://twitter.com/yujitach/status/1468446616135008257

しかし、そのようにして得られた「よい推定」「よい予測」「よい意思決定」はモデル内で得られたものに過ぎません。

モデルそのものを丸ごと入れ替えた方がよい場合のことは一切考慮に入っていない。

「よい意思決定」全般がそういうものであることには、教科書レベルで注意が必要だと思います。続く

モデルそのものを丸ごと入れ替えた方がよい場合のことは一切考慮に入っていない。

「よい意思決定」全般がそういうものであることには、教科書レベルで注意が必要だと思います。続く

曖昧な点をこちらが勝手に推測してこのスレッドを書いています。

「よい予測」はモデル選択の文脈でも意思決定論とは異なるスタイルで扱われています。

例えば、AICによる予測の良さ重視のモデル選択をそのような扱いの例として想定することもできます。続く

「よい予測」はモデル選択の文脈でも意思決定論とは異なるスタイルで扱われています。

例えば、AICによる予測の良さ重視のモデル選択をそのような扱いの例として想定することもできます。続く

ただし、AIC(および類似の指標)はどれも、予測のよさそのものではありません。

以下、予測誤差はKL情報量で定義されているとします。

推測先の未知の分布のAICを原点に取るとAICと予測誤差の確率的揺らぎの向きは漸近的に正反対で同じ大きさになります。特に、相関係数が-1になる.続く

以下、予測誤差はKL情報量で定義されているとします。

推測先の未知の分布のAICを原点に取るとAICと予測誤差の確率的揺らぎの向きは漸近的に正反対で同じ大きさになります。特に、相関係数が-1になる.続く

だから、AICが小さくなり過ぎることによってモデル選択に失敗した場合に選択されたモデルによる予測の誤差は非常に大きくなります。

これは、データが運悪く偏り過ぎていると、そのデータによる予測が大外しになることの、AICバージョンに過ぎない。

以上で紹介したリスクは交差検証でも完全に同様。

これは、データが運悪く偏り過ぎていると、そのデータによる予測が大外しになることの、AICバージョンに過ぎない。

以上で紹介したリスクは交差検証でも完全に同様。

さらに、仮にモデル選択に失敗していなくても、選択肢として採用したモデルの中に十分に妥当なものが含まれているとは限らない。

ひどい失敗の可能性を原理的に排除できない。いわゆる不良設定問題になっています。

しかし、以上で述べたリスクを承知でAICや交差検証を利用すれば十分に役に立つ。

ひどい失敗の可能性を原理的に排除できない。いわゆる不良設定問題になっています。

しかし、以上で述べたリスクを承知でAICや交差検証を利用すれば十分に役に立つ。

「よい意思決定」「よいモデル選択」などについて、「予測の良さは良い意思決定を意味しない」のようなことを私は言うべきではないと思っています。

各々の統計学的道具の限界が分かるように説明して、統計学がお墨付きが得られるような道具ではないことをいつでも強調するべきだと思います。続く

各々の統計学的道具の限界が分かるように説明して、統計学がお墨付きが得られるような道具ではないことをいつでも強調するべきだと思います。続く

教科書的な統計的意思決定論入門については、以下のリンク先で紹介した渡辺澄夫さんが説明用に提示した例を自分で計算してみるとよいと思います。

それらの例(および渡辺さんの解説)を理解すれば統計学の文脈での「〇〇はよい意思決定であるとは限らない」型の言説の危険性も分かると思います。

それらの例(および渡辺さんの解説)を理解すれば統計学の文脈での「〇〇はよい意思決定であるとは限らない」型の言説の危険性も分かると思います。

https://twitter.com/genkuroki/status/1467392980609044481

この話題では曖昧な言葉に頼るのは危険で、minimal working examples を必ず示して、議論にする必要があると思う。

私が本心から統計的意思決定論を面白がっていることについては以下のリンク先から、対戦型推定ゲームに関するスレッド群を見てください。

どんなに面白いものであっても、実践的に使う場合には要注意。

どんなに面白いものであっても、実践的に使う場合には要注意。

https://twitter.com/genkuroki/status/1359783244158226434

AICなどと真の予測誤差が正反対の向きに同じ大きさで揺らぐことの最も易しい場合の確認

↓

nbviewer.org/gist/genkuroki…

Bernoulli分布モデル

Bernoulli分布モデル(二項分布モデル)という最も易しいモデルで色々計算し尽くすのは非常に教育的だと思う。上記の対戦型推定ゲームもそういう主旨。

↓

nbviewer.org/gist/genkuroki…

Bernoulli分布モデル

Bernoulli分布モデル(二項分布モデル)という最も易しいモデルで色々計算し尽くすのは非常に教育的だと思う。上記の対戦型推定ゲームもそういう主旨。

https://twitter.com/genkuroki/status/1460820071903739910

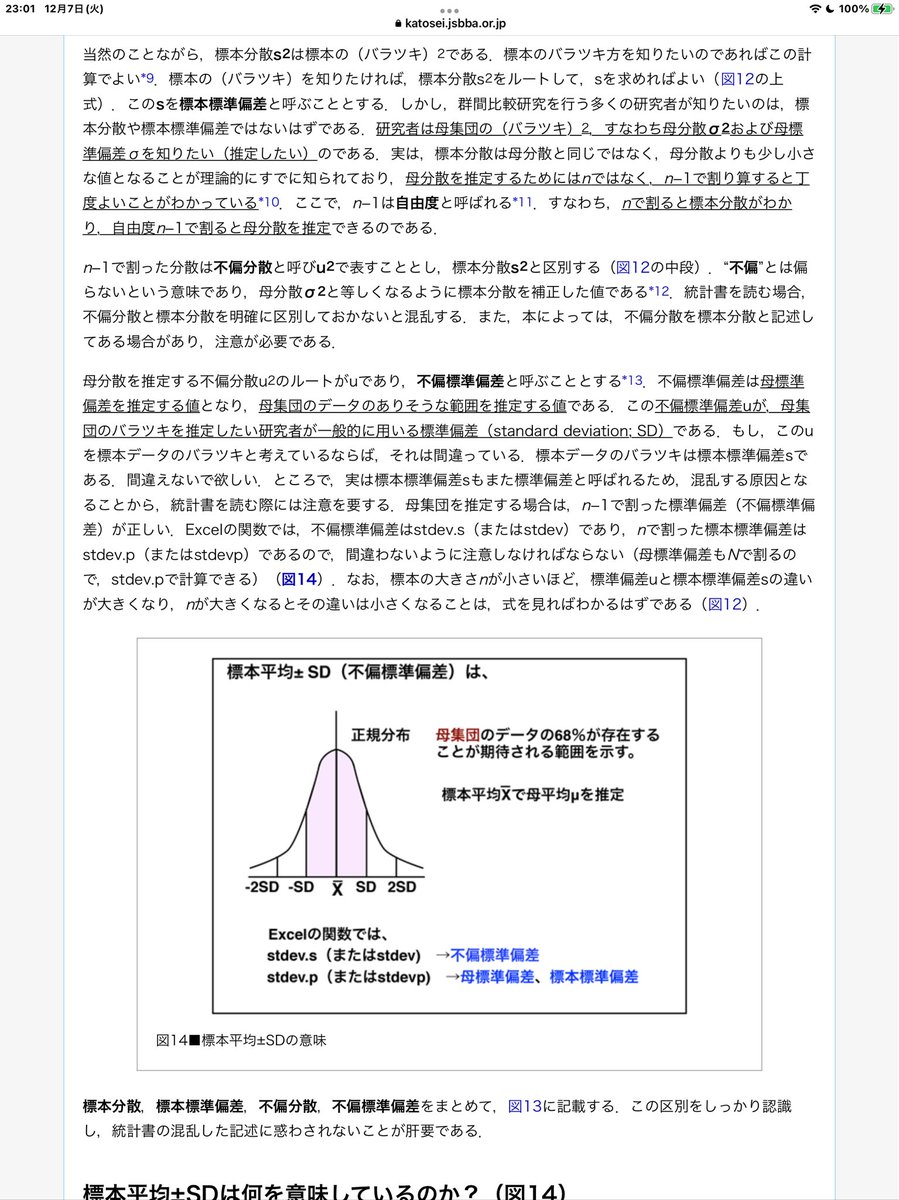

#統計 グラフに読み方

nはサンプルサイズで、wはサンプルを生成するベルヌイ試行のパラメータ。w=0.4(成功確率0.4)にしている。

横軸のkはn回中の成功回数。横軸は確率でスケールしてあるので、出やすいkの値の周辺の目盛りの幅は大きくなっている。n=100, w=0.4なので、k=400で幅は最大。続く

nはサンプルサイズで、wはサンプルを生成するベルヌイ試行のパラメータ。w=0.4(成功確率0.4)にしている。

横軸のkはn回中の成功回数。横軸は確率でスケールしてあるので、出やすいkの値の周辺の目盛りの幅は大きくなっている。n=100, w=0.4なので、k=400で幅は最大。続く

https://twitter.com/genkuroki/status/1460820071903739910

#統計 青線は、各データkごとにモデルから決まる予測分布の予測誤差。青線の値の正確な定義は,予測分布とw=0.4の真の分布のKL情報量の2n倍である。

予測誤差が最小になるのはデータがk=400の場合で、そこからずれるほどデータとモデルによる予測誤差は大きくなる。(これは当然そうなるべき結果)続く

予測誤差が最小になるのはデータがk=400の場合で、そこからずれるほどデータとモデルによる予測誤差は大きくなる。(これは当然そうなるべき結果)続く

#統計 橙破線は、上段の最尤法の場合はAICで、下段のベイズ法の場合はWAICの値。ベイズ法ではLOOCVの値もプロットしているが、この場合にWAICとほぼぴったり一致している。

ただし、それらの原点をw=0.4の真の分布のAICやWAIC, LOOCVに設定してプロット。値は予測誤差にスケールを合わせてある。

ただし、それらの原点をw=0.4の真の分布のAICやWAIC, LOOCVに設定してプロット。値は予測誤差にスケールを合わせてある。

#統計 AICやWAICやLOOCVは「それらの値が小さなモデルを選択する」という形式で使われる。それさえ知っていればひとまずそれらの定義を知っている必要はない。

橙破線は真の分布のそれらの値を原点にとってプロットしているので、

橙破線の値 > 0 ⇔ w=0.4に対応する真の分布モデルの側が選択される

橙破線は真の分布のそれらの値を原点にとってプロットしているので、

橙破線の値 > 0 ⇔ w=0.4に対応する真の分布モデルの側が選択される

#統計

橙破線の値 > 0 ⇔ w=0.4に対応する真の分布モデルの側が選択される

でかつ、パラメータwが固定されていないモデルよりも、真の分布モデルを選択することは正しいモデル選択なので

モデル選択に失敗 ⇔ 橙破線の値 < 0

です。左右の端でモデル選択に失敗する。

橙破線の値 > 0 ⇔ w=0.4に対応する真の分布モデルの側が選択される

でかつ、パラメータwが固定されていないモデルよりも、真の分布モデルを選択することは正しいモデル選択なので

モデル選択に失敗 ⇔ 橙破線の値 < 0

です。左右の端でモデル選択に失敗する。

#統計 データからパラメータを推定すると、データが運悪く偏り過ぎている場合に何が真に正しいかの判断を間違ってしまう、という当たり前のことが、AICなどの情報量基準を使っても起こることが以下のグラフの橙破線によって示されています。

#統計 あと、ベルヌイ試行のようなシンプルなモデルを使った推定推測推論では、最尤法を使ってもベイズ法を使っても十分nが大きければ違いがないことも、グラフの上段と下段を比較すれば分かります。

#統計 さらに未知である真の予測誤差の青線とAICなどの情報量基準の確率的揺らぎの向きが正反対になっていることもグラフからひと目でわかります。

それにも関わらず、84%程度の確率で真のモデルの選択に成功する理由は青線と橙破線の期待値(1になる)が一致しているからである。

それにも関わらず、84%程度の確率で真のモデルの選択に成功する理由は青線と橙破線の期待値(1になる)が一致しているからである。

#統計 真のモデルの選択に失敗する両端の「橙破線 < 0」の部分では、そのとき選択されるモデルの予測誤差(青線)は非常に大きくなります。

モデル選択に失敗した場合の選択されたモデルの予測分布の予測誤差は一般似大きな値になります。

モデル選択に失敗した場合の選択されたモデルの予測分布の予測誤差は一般似大きな値になります。

#統計 以上の説明ではAICなどの定義の説明を略しましたが、適当な教科書で定義を確認すれば、ベルヌイ分布モデルは易しいモデルなので自力で以上と同じ結果を得ることはそう難しくないと思います。

#Julia言語 でのソースコード↓

nbviewer.org/gist/genkuroki…

#Julia言語 でのソースコード↓

nbviewer.org/gist/genkuroki…

私は例によって #Julia言語 で計算したのですが、ベルヌイ分布モデルの場合には各種の量に公式を作れるので、計算自体は非常に易しく、添付画像のように横軸を確率でスケールすることなどに大部分の時間を取られました。

視覚化の作業は多くの場合に重くなることが多い。

nbviewer.org/gist/genkuroki…

視覚化の作業は多くの場合に重くなることが多い。

nbviewer.org/gist/genkuroki…

#統計 私がAICなどの情報量規準に関する解説を見つけた場合には、まずこのグラフに矛盾しているようなことを言っていないかどうかを確認しています。

AICがそのまま予測の良さを表しているかのごとくの解説は厳しくトンデモ扱いされるべきです。不良設定問題をなめるな。

nbviewer.org/gist/genkuroki…

AICがそのまま予測の良さを表しているかのごとくの解説は厳しくトンデモ扱いされるべきです。不良設定問題をなめるな。

nbviewer.org/gist/genkuroki…

#統計 繰り返し:AICがそのまま予測の良さを表しているかのごとくの解説は厳しくトンデモ扱いされるべき。

グラフを見れば分かるように、データが偏るとAICは小さくなり、予測誤差は大きくなります。

それにも関わらず役に立つ道具である、のように考えないとまずい。

グラフを見れば分かるように、データが偏るとAICは小さくなり、予測誤差は大きくなります。

それにも関わらず役に立つ道具である、のように考えないとまずい。

#統計 AICなどの情報量規準の値が、データが偏ると(真の分布のAICを原点に取ったとき)小さくなる理由も説明しておきましょう。

AICは予測分布の尤度が大きくなると小さくなるように定義されています。

実はそのことからほぼ自明にデータが偏るとAICは小さくなることが出ます。続く

AICは予測分布の尤度が大きくなると小さくなるように定義されています。

実はそのことからほぼ自明にデータが偏るとAICは小さくなることが出ます。続く

#統計

予測分布の尤度は「予測分布のデータへの適合度」です。

だから、データが偏っていると、データを生成した真の分布の尤度は小さくなり(真の分布のデータへの適合度は下がり)、データに合わせてパラメータを決めた予測分布の尤度は上がります。

予測分布の尤度は「予測分布のデータへの適合度」です。

だから、データが偏っていると、データを生成した真の分布の尤度は小さくなり(真の分布のデータへの適合度は下がり)、データに合わせてパラメータを決めた予測分布の尤度は上がります。

#統計 だから、パラメータを固定していないモデルのAICからパラメータの値が固定されている真の分布のモデルのAICを引いて得られる値は、データが偏ると小さくなります。

尤度が分布のデータへの適合度だと知っていれば自明にそうなることがわかります。

尤度が分布のデータへの適合度だと知っていれば自明にそうなることがわかります。

#統計 尤度が「尤もらしさ」でも「証拠の強さ」でもなく、単に「モデルの確率分布のデータの数値への適合度」の確率論的指標に過ぎないという知識は、特にAICなどによるモデル選択の仕組みを理解するために必須の予備知識になります。

#統計 尤度などに関する基礎知識をおさえていれば、特別に複雑な数学的議論を経由することなく、AICの重要な性質を定性的にかつ直観的に納得できるようになります。

• • •

Missing some Tweet in this thread? You can try to

force a refresh