Je suis désolé d'enchaîner les mauvaises nouvelles, mais celle-là me paraît particulièrement préoccupante, même si beaucoup de détails restent à éclaircir.

@timnitGebru, co-directrice de l'équipe #AIEthics de @Google, a été licenciée ce matin.

businessinsider.fr/us/timnit-gebr…

@timnitGebru, co-directrice de l'équipe #AIEthics de @Google, a été licenciée ce matin.

businessinsider.fr/us/timnit-gebr…

Selon @ekp, un tel licenciement est "ridicule", sachant son expertise, ses compétences et son influence.

"C'est l'une de ces nombreuses fois où je me mets à penser qu'il n'y a juste aucun espoir pour l'industrie des technologies".

"C'est l'une de ces nombreuses fois où je me mets à penser qu'il n'y a juste aucun espoir pour l'industrie des technologies".

https://twitter.com/ekp/status/1334349173554966532

Selon @alexhanna aussi, la décision de @Google est scandaleuse.

"Google pourrait être un des leaders de la recherche sur les implications sociales de l'IA et des technologies. Mais ils sont en train de choisir une autre voie."

"Google pourrait être un des leaders de la recherche sur les implications sociales de l'IA et des technologies. Mais ils sont en train de choisir une autre voie."

https://twitter.com/alexhanna/status/1334322766984736771

Il y a aura un backlash médiatique que j'espère énorme.

Ce qui me terrifie, c'est que @Google considère que ce backlash (qu'ils ont certainement anticipé) est un coût moindre que les avantages à se débarrasser de leur co-directrice de l'équipe d'#AIEthics...

Ce qui me terrifie, c'est que @Google considère que ce backlash (qu'ils ont certainement anticipé) est un coût moindre que les avantages à se débarrasser de leur co-directrice de l'équipe d'#AIEthics...

Alors, bien sûr, je suis dans le flou quant à ce qu'il s'est passé.

Mais connaissant un peu les travaux de @timnitGebru et les sujets du moment en IA, je parierais que ces décisions ont à voir avec la commercialisation scandaleuse de #GPT3 par @OpenAI...

Mais connaissant un peu les travaux de @timnitGebru et les sujets du moment en IA, je parierais que ces décisions ont à voir avec la commercialisation scandaleuse de #GPT3 par @OpenAI...

https://twitter.com/abidlabs/status/1291165311329341440

.@le_roux_nicolas critique à son tour publiquement le management de son employeur vis-à-vis de @timnitGebru, qu'il qualifie de "terrible".

https://twitter.com/le_roux_nicolas/status/1334492980288385032

.@mjg59 raconte un cas similaire antérieur chez @Google, et affirme que @Google ne traite pas ses minorités avec autant de soin que ses autres employés.

https://twitter.com/mjg59/status/1334387057360138241

Voici l'email envoyé par @timnitGebru qui a conduit à son licenciement.

Certains supérieurs chez @Google semblent avoir exigé la rétraction d'un article de @timnitGebru accepté à publication dans une conférence académique.

Sans justification.

platformer.news/p/the-witherin…

Certains supérieurs chez @Google semblent avoir exigé la rétraction d'un article de @timnitGebru accepté à publication dans une conférence académique.

Sans justification.

platformer.news/p/the-witherin…

La réaction de @mmitchell_ai, la co-directrice de l'équipe #AIEthics de @Google.

"Je suis surtout sous le choc."

"Je suis surtout sous le choc."

https://twitter.com/mmitchell_ai/status/1334586105723666432

Une lettre co-signée par 415 employés de @Google proteste le licenciement de @timnitGebru, via @GoogleWalkout.

La cause suggérée du licenciement est une recherche sur les implications éthiques des algorithmes de traitement du langage utilisés par @Google.

googlewalkout.medium.com/standing-with-…

La cause suggérée du licenciement est une recherche sur les implications éthiques des algorithmes de traitement du langage utilisés par @Google.

googlewalkout.medium.com/standing-with-…

On en arrive à la raison pour laquelle cette nouvelle me paraît terrifiante.

Je la suspecte très vivement d'être un choix délibéré des directeurs de @Google pour faire passer les intérêts à court terme de l'entreprise au dépens des conséquences socio-économiques de ses produits.

Je la suspecte très vivement d'être un choix délibéré des directeurs de @Google pour faire passer les intérêts à court terme de l'entreprise au dépens des conséquences socio-économiques de ses produits.

J'aimerais que ces dirigeants mesurent davantage l'impact de leurs produits, non seulement sur les utilisateurs, mais aussi et surtout sur l'équilibre du monde moderne, et, in fine, sur la sécurité de ces dirigeants aussi.

Sans éthique, nous courons TOUS à notre perte.

Sans éthique, nous courons TOUS à notre perte.

Il y a une incohérence frappante entre le texte co-signé par 415 employés de Google (à gauche) et l'email envoyé par @JeffDean (à droite).

Cette affaire est décidément très louche...

Le texte co-signé :

googlewalkout.medium.com/standing-with-…

Les emails :

platformer.news/p/the-witherin…

Cette affaire est décidément très louche...

Le texte co-signé :

googlewalkout.medium.com/standing-with-…

Les emails :

platformer.news/p/the-witherin…

Ce chouette article de @WIRED fait le point sur la situation. À lire si vous débarquez dans cette affaire !

wired.com/story/prominen…

wired.com/story/prominen…

J'ai signé la lettre ouverte de @GoogleWalkout.

La lettre me semble très bien écrite, et les trois demandes me semblent raisonnables et critiques pour la sécurité et l'éthique des algorithmes qui gouvernent le monde moderne.

Académiques, à votre tour.

googlewalkout.medium.com/standing-with-…

La lettre me semble très bien écrite, et les trois demandes me semblent raisonnables et critiques pour la sécurité et l'éthique des algorithmes qui gouvernent le monde moderne.

Académiques, à votre tour.

googlewalkout.medium.com/standing-with-…

Certains semblent penser qu'il est préférable d'attendre une régulation des GAFAM. Mais :

(1) il n'y aura pas de régulation tant qu'il n'y aura pas de pression publique suffisante,

(2) Pourquoi ne pas encourager les 415+ bonnes volontés chez Google ?

(3)

(1) il n'y aura pas de régulation tant qu'il n'y aura pas de pression publique suffisante,

(2) Pourquoi ne pas encourager les 415+ bonnes volontés chez Google ?

(3)

https://twitter.com/vlanx0/status/1334881406145728513?s=19

Voici l'abstract de l'article de @timnitGebru, dont Google a exigé la rétraction, révélée par un reviewer.

Il s'agit en effet d'une critique éthique des algorithmes de traitement du langage, et en particulier de la course aux IA toujours plus puissantes.

reddit.com/r/MachineLearn…

Il s'agit en effet d'une critique éthique des algorithmes de traitement du langage, et en particulier de la course aux IA toujours plus puissantes.

reddit.com/r/MachineLearn…

Voici une réponse détaillée de @JeffDean, qui insiste sur le fait que la décision de rétraction est motivée par la qualité de l'article.

L'article avait été accepté à publication par @FAccTConference, qui accepte pourtant les éditions post-acceptation...

L'article avait été accepté à publication par @FAccTConference, qui accepte pourtant les éditions post-acceptation...

https://twitter.com/JeffDean/status/1334953632719011840

Le post Facebook de @L_badikho, mon co-auteur de #LeFabuleuxChantier, récemment recruté chez Google Brain par @JeffDean, mais qui aurait sans doute refusé sans le soutien de @timnitGebru.

"Nous ne pouvons pas en rester aux conditions du XIX ou XXe siècle"

facebook.com/elgharbi.erri7…

"Nous ne pouvons pas en rester aux conditions du XIX ou XXe siècle"

facebook.com/elgharbi.erri7…

.@math_rachel souligne plusieurs éléments qui montrent que, contrairement à ce que @JeffDean prétend, la rétraction du papier et le licenciement de @timnitGebru n'ont pas suivi le processus de révision "classique" de @Google.

https://twitter.com/math_rachel/status/1334985987525472258

.@techreview a eu accès à l'article dont @Google a forcé la rétraction.

Les tensions avec les intérêts de l'entreprise semblent évidentes et suggèrent vivement que sa rétraction est plus motivée par des intérêts financiers que par une faiblesse du papier.

technologyreview.com/2020/12/04/101…

Les tensions avec les intérêts de l'entreprise semblent évidentes et suggèrent vivement que sa rétraction est plus motivée par des intérêts financiers que par une faiblesse du papier.

technologyreview.com/2020/12/04/101…

Par ailleurs, s'il s'agissait de corriger un manque de références, @JeffDean et ses collègues ne semblent pas avoir fait le nécessaire pour obtenir les améliorations du papier souhaitées.

(@emilymbender est co-autrice du fameux papier)

(@emilymbender est co-autrice du fameux papier)

https://twitter.com/emilymbender/status/1334965581699665923

.@YejinChoinka, Professeure à @UW, ne semble pas du tout avoir eu les réserves de @JeffDean sur la qualité de l'article de @timnitGebru, lorsqu'on lui a demandé un avis avant soumission.

Cette histoire ressemble de plus en plus une manoeuvre anti-éthique.

Cette histoire ressemble de plus en plus une manoeuvre anti-éthique.

https://twitter.com/YejinChoinka/status/1335066327111725056

Plus étrange encore, selon @le_roux_nicolas, chercheur à @GoogleAI, l'article aurait été approuvé par le processus de review interne à Google.

On a là une version des faits qui contredit complètement celle de @JeffDean...

On a là une version des faits qui contredit complètement celle de @JeffDean...

https://twitter.com/le_roux_nicolas/status/1335028688115658752

Certains semblent sceptique d'une quelconque recherche sur l'éthique des algorithmes venant des GAFAM.

Visiblement, vous n'êtes pas familiers avec les travaux de @timnitGebru, publiés aux noms de @MSFTResearch ou @GoogleAI:

proceedings.mlr.press/v81/buolamwini…

dl.acm.org/doi/abs/10.114…

Visiblement, vous n'êtes pas familiers avec les travaux de @timnitGebru, publiés aux noms de @MSFTResearch ou @GoogleAI:

proceedings.mlr.press/v81/buolamwini…

dl.acm.org/doi/abs/10.114…

Plus de @timnitGebru (y en a beaucoup 😅)

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

https://t.co/o6hgZt7yjx

@Facebook a un blog dédié à ces questions :

about.fb.com/news/category/…

Il semble important de défendre ces recherches !

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

dl.acm.org/doi/abs/10.114…

https://t.co/o6hgZt7yjx

@Facebook a un blog dédié à ces questions :

about.fb.com/news/category/…

Il semble important de défendre ces recherches !

Pour prendre un peu de perspective, je vous recommande cette excellente interview du génial @tristanharris sur @80000Hours par @robertwiblin, très loin du manichéisme de #TheSocialDilemma.

Ça explique pourquoi #CestCompliqué. Mais il semble urgent d'agir.

pca.st/episode/48e2fc…

Ça explique pourquoi #CestCompliqué. Mais il semble urgent d'agir.

pca.st/episode/48e2fc…

Samy Bengio, le boss de @timnitGebru, est "stupéfait" par cette histoire.

Il semble avoir été court-circuité par la direction de Google, contre laquelle il s'oppose désormais publiquement.

Lui aussi cherche des explications.

Il semble avoir été court-circuité par la direction de Google, contre laquelle il s'oppose désormais publiquement.

Lui aussi cherche des explications.

https://twitter.com/timnitGebru/status/1335384711837913089?s=19

Wow !!! Peter Norvig, directeur de la recherche de Google, a lui aussi signé la lettre ouverte !

On peut peut-être espérer un gros ménage chez Google. Mais pour cela, il faut plus de support.

Pensez à signer à votre tour cette lettre ouverte.

googlewalkout.medium.com/standing-with-…

On peut peut-être espérer un gros ménage chez Google. Mais pour cela, il faut plus de support.

Pensez à signer à votre tour cette lettre ouverte.

googlewalkout.medium.com/standing-with-…

J'ai fait une vidéo qui résume un peu la situation, et dans laquelle j'explique pourquoi il me semble très important de signer cette lettre ouverte.

Le futur des algorithmes qui nous gouvernent déjà me semble en jeu. Et donc, celui de l'humanité aussi.

Le futur des algorithmes qui nous gouvernent déjà me semble en jeu. Et donc, celui de l'humanité aussi.

Cette publication de 2020 montre que YouTube progresse dans le combat contre la mésinformation. Mais qu'il y a encore beaucoup de chemin à faire !!

L'éthique dans les entreprises a désespérément besoin de votre soutien pour continuer à progresser.

dl.acm.org/doi/abs/10.114…

L'éthique dans les entreprises a désespérément besoin de votre soutien pour continuer à progresser.

dl.acm.org/doi/abs/10.114…

Plein de prénoms francophones récemment ajoutés dans la liste des signataires 😍😍😍

googlewalkout.medium.com/standing-with-…

googlewalkout.medium.com/standing-with-…

Très content de voir 27 signatures de membres de l'EPFL, loin devant KTH (2), ETH Zurich (8) et Cambridge (11), et juste derrière Carnegie Mellon (28).

Bon, par contre, tout ça est encore loin derrière Stanford (70), Berkeley (79) et Harvard (87)...

googlewalkout.medium.com/standing-with-…

Bon, par contre, tout ça est encore loin derrière Stanford (70), Berkeley (79) et Harvard (87)...

googlewalkout.medium.com/standing-with-…

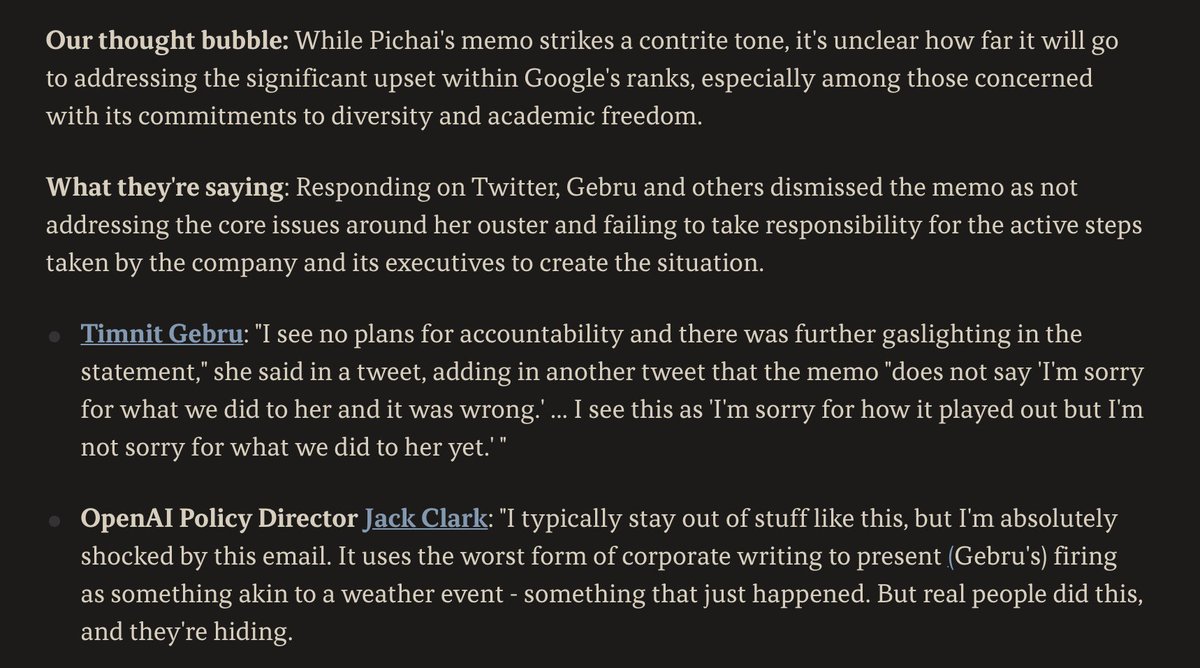

La réaction de Sundar Pichai, le PDG de Google.

Elle est jugée très insatisfaisante par certains observateurs, à commencer par @timnitGebru.

Elle est surtout très orientée Google. Mais l'éthique de Google devrait aller bien au-delà des employés Google...

axios.com/sundar-pichai-…

Elle est jugée très insatisfaisante par certains observateurs, à commencer par @timnitGebru.

Elle est surtout très orientée Google. Mais l'éthique de Google devrait aller bien au-delà des employés Google...

axios.com/sundar-pichai-…

La course à la performance n'est pas réservée au privé.

Certains académiques semblent très agacés par le fait que les conférences en IA demandent aux chercheurs d'envisager les conséquences sociales de leurs travaux.

(lisez les réponses à Domingos !!)

Certains académiques semblent très agacés par le fait que les conférences en IA demandent aux chercheurs d'envisager les conséquences sociales de leurs travaux.

(lisez les réponses à Domingos !!)

https://twitter.com/pmddomingos/status/1336187141366317056

Comme en parle @smartereveryday, il y a d'énormes campagnes de désinformation pour sculpter l'opinion publique.

Quelle crédence mettez-vous en l'utilisation de techniques similaires par Google pour décrédibiliser l'éthique des IA ?

venturebeat.com/2020/12/10/tim…

Quelle crédence mettez-vous en l'utilisation de techniques similaires par Google pour décrédibiliser l'éthique des IA ?

venturebeat.com/2020/12/10/tim…

.@Miles_Brundage identifie ici un clair cas de compte fake qui prétend travailler chez Google Brain, et qui semble vouloir causer plus de confusions.

À qui appartient ce compte ? Combien y a-t-il de tels comptes ? Et sont-ils financés et par qui ?

À qui appartient ce compte ? Combien y a-t-il de tels comptes ? Et sont-ils financés et par qui ?

https://twitter.com/Miles_Brundage/status/1337570411265970176?s=19

Bon, prenons un peu de recul, et revenons-en aux algorithmes de traitement de langage.

Y a-t-il vraiment des risques éthiques ?

Voici des résultats d'interactions avec GPT-3.

Imaginez maintenant GPT-3 aux commandes de Google et YouTube...

middlebury.edu/institute/site…

Y a-t-il vraiment des risques éthiques ?

Voici des résultats d'interactions avec GPT-3.

Imaginez maintenant GPT-3 aux commandes de Google et YouTube...

middlebury.edu/institute/site…

Les conclusions des auteurs de l'étude.

"Les créateur des IA et les gouvernements doivent investiguer dès que possible la création de normes sociales, politiques publiques et initiatives éducatives pour empêcher un torrent de propagandes et de désinformations algorithmiques."

"Les créateur des IA et les gouvernements doivent investiguer dès que possible la création de normes sociales, politiques publiques et initiatives éducatives pour empêcher un torrent de propagandes et de désinformations algorithmiques."

Y a-t-il un conflit moral auquel vous êtes confrontée ?

@timnitGebru : Si je travaille dans une grande entreprise comme Google, est-ce que je rends les choses meilleures, ou est-ce que je légitimise de mauvais comportements et je rends les choses pires ?

@timnitGebru : Si je travaille dans une grande entreprise comme Google, est-ce que je rends les choses meilleures, ou est-ce que je légitimise de mauvais comportements et je rends les choses pires ?

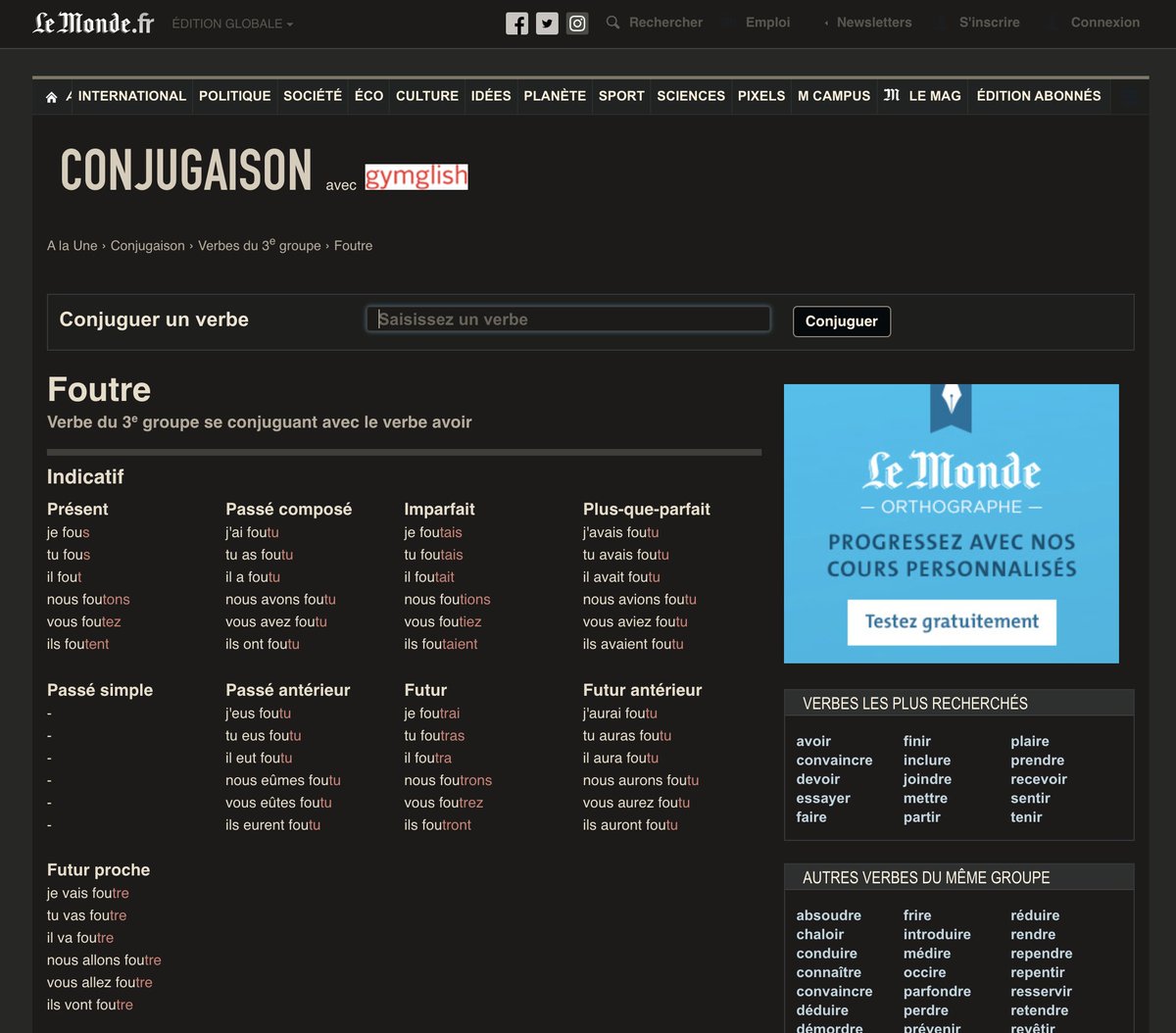

Ma tribune a été publiée sur @lemondefr !!

J'y parle de l'affaire @timnitGebru et de ce qu'elle révèle sur l'importance qui est donnée à l'éthique par Google et le monde académique.

Et de pourquoi il est important de tous davantage s'y intéresser.

lemonde.fr/idees/article/…

J'y parle de l'affaire @timnitGebru et de ce qu'elle révèle sur l'importance qui est donnée à l'éthique par Google et le monde académique.

Et de pourquoi il est important de tous davantage s'y intéresser.

lemonde.fr/idees/article/…

Et voilà ce que Google voulait protéger !!

Leur équipe de recherche a développé le plus gros algorithme de traitement de langages à ce jour, surpassant GPT-3 d'un facteur 10.

La course à la performance n'a jamais été aussi évidente... et inquiétante.

arxiv.org/pdf/2101.03961…

Leur équipe de recherche a développé le plus gros algorithme de traitement de langages à ce jour, surpassant GPT-3 d'un facteur 10.

La course à la performance n'a jamais été aussi évidente... et inquiétante.

arxiv.org/pdf/2101.03961…

D'après @Kyle_L_Wiggers, dans leur article (que je n'ai pas encore lu), les chercheurs de Google ne mentionnent même pas les enjeux éthiques (pourtant énormes !!).

venturebeat.com/2021/01/12/goo…

Pire, l'équipe d'éthique semble avoir été court-circuitée !

venturebeat.com/2021/01/12/goo…

Pire, l'équipe d'éthique semble avoir été court-circuitée !

https://twitter.com/timnitGebru/status/1349389412791148546

Ça va de mal en pis.

Après @timnitGebru, @Google s'attaque à @mmitchell_ai, l'autre co-directrice de l'équipe d'éthique des IA !!

venturebeat.com/2021/01/20/goo…

Je suis très déçu que la lettre ouverte n'a pas davantage de soutiens internes et externes à Google.

googlewalkout.medium.com/standing-with-…

Après @timnitGebru, @Google s'attaque à @mmitchell_ai, l'autre co-directrice de l'équipe d'éthique des IA !!

venturebeat.com/2021/01/20/goo…

Je suis très déçu que la lettre ouverte n'a pas davantage de soutiens internes et externes à Google.

googlewalkout.medium.com/standing-with-…

Quand @harari_yuval est venu à l'@EPFL, il disait que "ceux qui contrôlent le flux de l'information contrôlent le futur de l'humanité".

@Google semble l'avoir compris et semble avoir décidé d'abuser activement de son pouvoir pour taire ses critiques.

@Google semble l'avoir compris et semble avoir décidé d'abuser activement de son pouvoir pour taire ses critiques.

https://twitter.com/kareem_carr/status/1359316517805051904

Pour ceux qui souhaiteraient répliquer, apparemment, il faut ajuster sa localisation pour avoir des résultats nord-américains :

https://twitter.com/teemu_roos/status/1359411006305427460

Google semble persister à malmener les membres de son équipe d'éthique des IA, malgré leur situation déjà psychologiquement difficile.

Ma préoccupation est qu'on se dirige vers des audits uniquement externes qui n'ont aucun accès à la "soupe" interne...

Ma préoccupation est qu'on se dirige vers des audits uniquement externes qui n'ont aucun accès à la "soupe" interne...

https://twitter.com/timnitGebru/status/1359943561807093767

L'autre co-directrice de l'éthique des IA à @Google, @mmitchell_ai, a été licenciée à son tour, dans des situations tout aussi douteuses.

Google est en train de démanteler les forces internes qui oeuvraient activement pour l'éthique.

Je suis terrifié.

theguardian.com/technology/202…

Google est en train de démanteler les forces internes qui oeuvraient activement pour l'éthique.

Je suis terrifié.

theguardian.com/technology/202…

Je suis aussi extrêmement déçu par la relative faible mobilisation pour l'éthique des algorithmes, en interne et en externe.

La lettre ouverte n'est signée que par 2% de Google, et par <0,1% du monde académique et de l'industrie de la tech.

googlewalkout.medium.com/standing-with-…

La lettre ouverte n'est signée que par 2% de Google, et par <0,1% du monde académique et de l'industrie de la tech.

googlewalkout.medium.com/standing-with-…

Google contrôle une énorme partie du flux de l'information, dont la sécurité et le bien-être de nos sociétés sont si dépendants.

Ce qu'il est en train de se passer me semble extrêmement terrifiant pour le futur de l'humanité.

Et j'ai l'impression que tout le monde s'en fout...

Ce qu'il est en train de se passer me semble extrêmement terrifiant pour le futur de l'humanité.

Et j'ai l'impression que tout le monde s'en fout...

Par ailleurs, le fameux article qui a déclenché toute cette histoire, et que Google a préféré enfouir pour protéger le déploiement (beaucoup trop précipité) de ses algorithmes de traitement, est maintenant accessible en ligne.

https://twitter.com/emilymbender/status/1352798178672742400

Nouvelle vidéo !!

Je fais le point sur cette histoire terrifiante et sur mon état de panique.

Il me semble urgent d'exiger beaucoup plus de transparence des algorithmes et des entreprises qui gouvernent aujourd'hui sans partage sur le web.

Je fais le point sur cette histoire terrifiante et sur mon état de panique.

Il me semble urgent d'exiger beaucoup plus de transparence des algorithmes et des entreprises qui gouvernent aujourd'hui sans partage sur le web.

• • •

Missing some Tweet in this thread? You can try to

force a refresh