La entropía es la medida del desorden de un sistema.

Y esta es, posiblemente, una de las peores definiciones de una magnitud física que se precie.

S es la entropía

ln es logaritmo neperiano

W es el número de configuraciones de los constituyentes de un sistema que son compatibles con el estado que observamos en dicho sistema.

¿Mejor ahora?

¿Va?

En el primer caso tenemos 1 configuración por (1/2)(1/2)(1/2)(1/2)

En el segundo caso tenemos 4x(1/16)

Eso implica que si dejamos al sistema evolucionar será más probable encontrar la situación de tener las partículas repartidas por todo el volumen que tenerlas en tal o cual mitad.

Eso es la segunda ley de la termo que nos dice que la entropía en un sistema aislado aumenta o permanece constante.

S=W.

El tema está que en termodinámica sabemos que si mezclamos dos sistemas la entropía del conjunto es la suma de entropías (al menos).

W=(W1)(W2).

Es decir, si la entropía fuese directamente W no sería aditiva sino multiplicativa.

¿Por qué? Pues porque...

ln(AB)=ln(A)+ln(B)

Usualmente pensamos en términos energéticos y nos preguntamos cuántas partículas tienen tal o cual energía elemental si el sistema grandote tiene una energía E.

Pero un momento...

E1= 15.5

E2=31.0

Lo que estamos asumiendo es que las partículas solo pueden tener esas energías y ninguna otra. No puede haber una energía de 16.34 por ejemplo.

En el tuit anterior estamos trabajando con unidades naturales de la energía.

(Ojo, nadie aquí está diciendo que no se pueda tomar el límite al continuo pero la discretización que subyace deja huella)

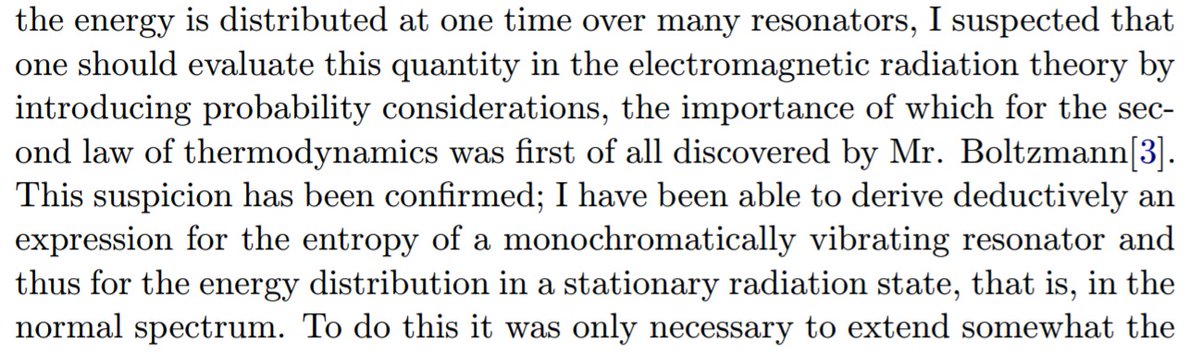

Pero vamos, que no le hacía falta escribirla, de esos escritos se deduce esa bonita fórmula y por eso todo el mundo se la asigna.

a) Nadie creía que una magnitud física fundamental como la entropía tuviera una definición probabilística.

b) Casi nadie creía en los átomos.

Le repugnaba el trabajo de Boltzmann sobre la entropía.

(hermes.ffn.ub.es/luisnavarro/nu…)

strangepaths.com/files/planck19…

Planck hablando de todo esto y de Boltzmann: