- Seshadhiri Dhanasekaran

இன்னிக்கு நாம Bias (சார்பு) மற்றும் Variance ( மாறுபாடு) குறித்து விரிவாக பாப்போம்.

#MachineLearningTamil

#Thread

#MachineLearning

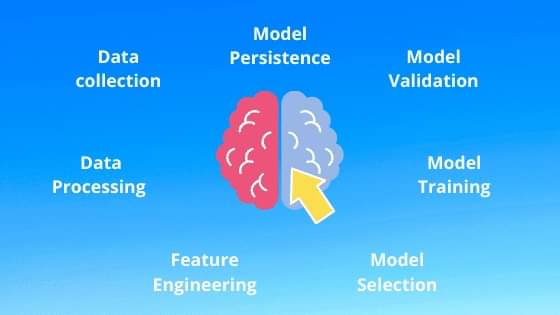

1. Bias Error

2. Variance Error

3. Irreducible Error

Bias என்பது algorithm தன்னுடைய Yயை குறித்து assumption (அனுமானம் ) செய்து கொள்வது. அதாவது Y இப்படி தான் இருக்கும் என்று ஒரு அனுமானுத்துடன் செல்வது .

High - Bias - Output குறித்து அதிகமான அனுமானம் கொள்ளுதல்.

Linear Regression, Linear Discriminant Analysis and Logistic Regression எல்லாம் High-Bias மாடல்கள்.

Variance என்பது மாறுபட்ட Training டேட்டா பயன்படுத்தப்பட்டால் Target Function (Y) மதிப்பீடு மாறும் அளவு மட்டுமே.Variance is the amount that the estimate of the target function will change if different training data was used.

Decision Trees, k-Nearest Neighbors and Support Vector Machines எல்லாம் high-variance மாடல்கள்.

இந்த Biasயும் , Varianceயும் ஆப்போசிட் relation (அ) நெகடிவ் Correlation உறவை கொண்டது.

அதாவது Bias அதிகமானால் Variance குறையும். Variance அதிகமானால் Bias குறையும்.

Underfitting - training டேட்டாவை கொண்டு algorithm சரியாக fit ஆகாத போது. அதாவது ட்ரைனிங்லேயே சரியாய் கத்துக்காம இருந்தால் இது அது underfitting.

Overfitting என்பது ட்ரைனிங்லேயே ஓவரா ட்ரெயின் ஆகி டெஸ்டிங் டேட்டாவிற்கு ஏற்ற மாதிரி மாத்திக்க முடியாமல் சொதப்புவது. ட்ரைனிங்ல சுட சொல்லி கொடுக்கும்போது object ஸ்டெடியாருக்கும். ஆனா பீல்ட்ல object move ஆகும். ஆனா நான் ஸ்டெடியா இருந்தா தான் சுடுவேன்ன்னு சொல்லுற மாதிரி

High Variance, Low Bias என்றால் அது Overfitting.

பின்வரும் வரைபடங்களில் இதை பாருங்க, சரி இதை சரி செய்ய என்ன வழி என்றால் இரண்டு வழி.

இதில் overfittingயை மட்டுமே சரி செய்ய

2. ஒரு validation செட் டேட்டாவை hold back செய்வது.

1. டேட்டாவை அதிகரிக்கலாம்.

2. ட்ரைனிங் time அதிகரித்தல்.

3. மாடலின் காம்ப்ளெக்ஸிட்டியை அதிகரிக்கலாம்.

#EndofPartVIII