J'aide ceux qui se forment à la #datascience, au #machinelearning, et à l'#ia. Pour cela, j'écris ici des threads, et des articles sur mon blog (très bientôt)

How to get URL link on X (Twitter) App

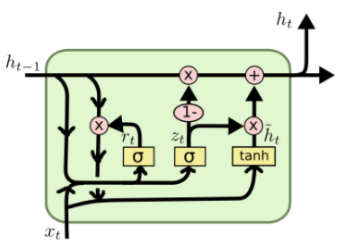

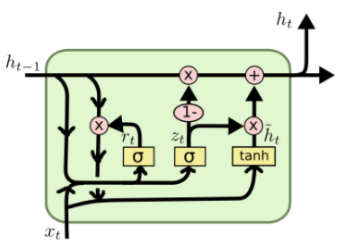

2. Le principe d'un réseau récurrent RNN est relativement simple

2. Le principe d'un réseau récurrent RNN est relativement simple

[Régression Logistique]

[Régression Logistique]https://twitter.com/ObjectifDataSci/status/1384513359417159681?s=20

https://twitter.com/ObjectifDataSci/status/1384120799091564548?s=20