Existem várias razões de ser difícil compreender os fenômenos que observamos, muita razões para nem sempre as coisas serem o que parecem. Hoje vou falar de TRÊS coisas relacionadas a essa dificuldade. Pronto para mais um fio 🧶de #DataScience #Statistics #Science? 😃🥳 1/20

2/20 Talvez o mais óbvio sejam variáveis latentes ou ñ observadas/medidas. Em muitos casos, independente da quantidade de dados q vc observar sobre 2 eventos, você seguirá vendo uma correlação q fará você achar que um evento está causando o outro. Em uma determinada região, por

3/20 exemplo, foi observado q quando o consumo de sorvete aumentava, mais pessoas morriam por ataques de tubarão e acidentes em piscinas. Quando o consumo de sorvete caía, menos pessoas morriam por ataques de tubarão e acidentes em piscina. Nenhuma quantidade de dados sobre

4/20 estes 2 eventos mudaria isso. Pelo contrário, a tendência c/ + dados é q o seu p-valor ficasse bem menor e sua crença de q essa correlação implica em causalidade maior (o q é uma falácia argumentativa chamada cum hoc ergo propter hoc, ou seja, achar q 2 eventos acontecendo

5/20 sempre juntos, significa q um causa o outro). O problema aqui é q tem uma terceira variável q não medimos e, ao ignorá-la, ficamos inclinados a achar que de fato há uma relação direta entre consumo de sorvete e esses acidentes “aquáticos”. Essa terceira variável latente, ñ

6/20 medida, é a temperatura. Quanto mais quente, maiores as chances do consumo de sorvete aumentar, e maiores as chances das pessoas irem se banhar em piscinas e na praia. Mais frio? Menos provável, para ambos. É esperado q + acidentes ocorram quando muitas pessoas vão à praia,

7/20 do que quando pouquíssimas vão. Se você calculasse a probabilidade conjunta entre consumo de sorvete e cada um desses dois outros eventos (acidentes com tubarão ou em piscinas), dado a temperatura, você iria observar que elas são independentes. Ou seja, P(A,B|C) = P(A)P(B).

8/20 Existir uma variável latente que tem efeito causal nas variáveis que você mediu costumam ser responsáveis por inferências enviesadas, isto é, estudos encontrando resultados que estão equivocados. Isso chama-se efeito confundidor. Esse é o nosso primeiro problema.

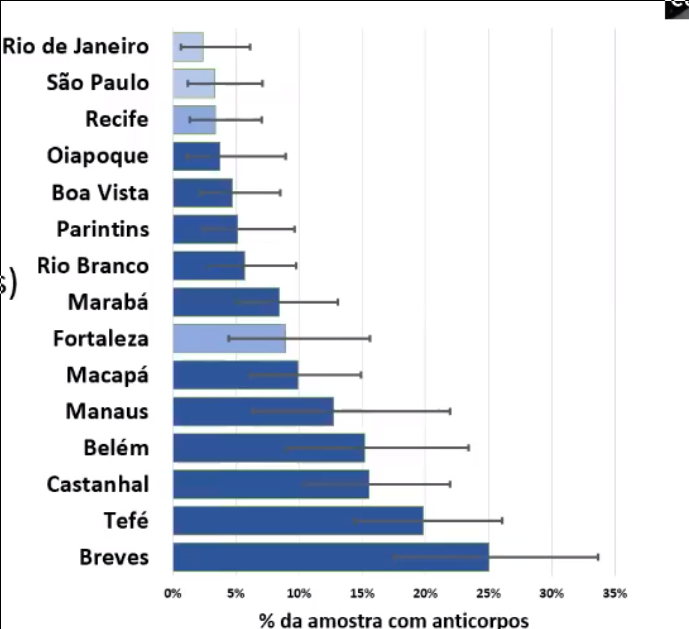

9/20 O segundo problema se trata de amostragem. Ele ocorre quando queremos inferir características de uma população com base em uma amostra dessa população, ou seja, uma seleção de indivíduos, e essa seleção não é representativa dessa população. O q eu quero dizer c isso? Imagine

10/20 que eu quero descrever o número de quartos nas residências brasileiras e como é inviável checar a casa de todos os brasileiros, eu faço uma seleção de 10.000 residências. No entanto, por várias razões, é possível que essas 10.000 residências não sejam representativas

11/20 da residência brasileira média. Digamos que eu fiz a medição apenas em capitais, em casas de famílias de renda média alta ou alta e assim por diante. Isso me levará a inferir adequadamente informações sobre ESSES INDIVÍDUOS, mas por não ter identificado esse viés de seleção

12/20 eu irei reportar que essas características são do brasileiro médio. Em alguns casos, isso é óbvio, como nesse caso imagino que seria. Em outros casos, isso é muito mais complicado. Em um estudo clínico, por exemplo, ao acaso pode ocorrer que meus pacientes em um grupo sejam

13/20 todos ex-fumantes. Já existem relatos na literatura sobre ser comum ex-fumantes não reportarem que são ex-fumantes e coisas do tipo. Non-compliance também é um problema sério, que é quando o paciente não segue as instruções dos pesquisadores. Podemos também ter situações

14/20 onde nem o paciente sabe que tem alguma outra doença e os pesquisadores também não saibam que isso influenciaria o resultado do estudo em andamento. Nosso segundo problema, portanto, é a seleção enviesada de indivíduos para o estudo.

15/20 O terceiro problema são erros de medição, ruído e coisas do tipo. Aqui, eu gostaria de trazer algo bem interessante e que de certo modo já faz parte da cultura popular. A teoria do caos! Um sistema caótico é aquele que é muito sensível às condições iniciais. Isso significa

16/20 q imprecisão de poucas casas decimais podem nos levar a resultados absurdamente diferentes. Vc mediu as variáveis do seu estudo c/ 6 casas decimais, 5,234611 por exemplo, e pensou: wow, isso que é precisão!! Mas, caso você esteja tratando de um sistema caótico

17/20 uma imprecisão muito pequena pode ser suficiente p/ vc encontrar resultados absurdamente diferentes. É esse tipo de coisa assustadora que faz parecer que sistemas caóticos são estocásticos, isto é, aleatórios. SÓ QUE NÃO! Eles são determinísticos 😃 A questão é medir com a

18/20 precisão necessária p/ ser possível fazer a predição. Observe os dois gráficos de um pêndulo duplo. Uma pequena variação nas condições iniciais fazem o comportamento ser bastante diferente. Uma das primeiras pessoas a se deparar com esse tipo de problema foi Isaac Newton e

19/20 em uma carta p/ um colega ele confessou q esse problema fazia sua cabeça doer e q ele iria apenas parar de pensar nisso hehehe. Esse é o nosso terceiro problema, imprecisão na medição! Existem várias razões para imprecisões, assim como para os outros problemas. Entenda esse

20/20 fio como 1 pincelada básica nesses 3 problemas. (1) Dificuldade em medir todas as variáveis, (2) dificuldade em medir todos os indivíduos e (3) dificuldade em fazer as medições com a precisão necessária. Ninguém disse que seria fácil fazer ciência, né? 😅 Mas vale a pena!!!

• • •

Missing some Tweet in this thread? You can try to

force a refresh