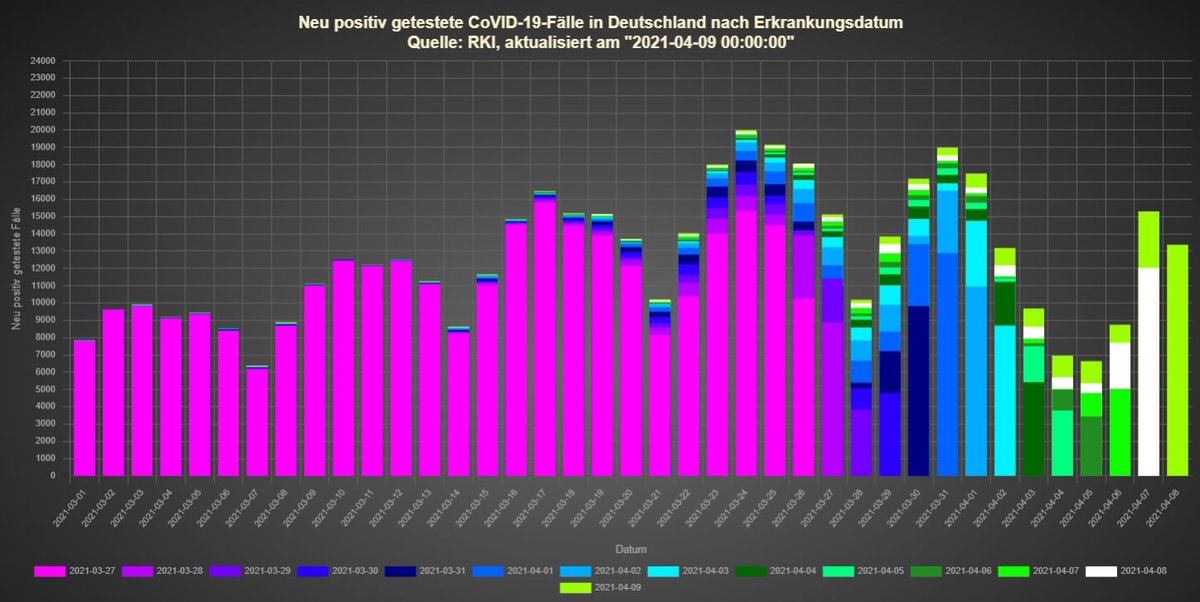

Kleines Projekt zur Frage: Wie viele #Fälle sind über die #Ostern-#Feiertage liegen geblieben?

Dafür werde ich jetzt täglich die #RKI #Fallzahlen nach #Meldedatum und #Erkrankungsdatum präsentieren.

#COVID19 #Corona

Dafür werde ich jetzt täglich die #RKI #Fallzahlen nach #Meldedatum und #Erkrankungsdatum präsentieren.

#COVID19 #Corona

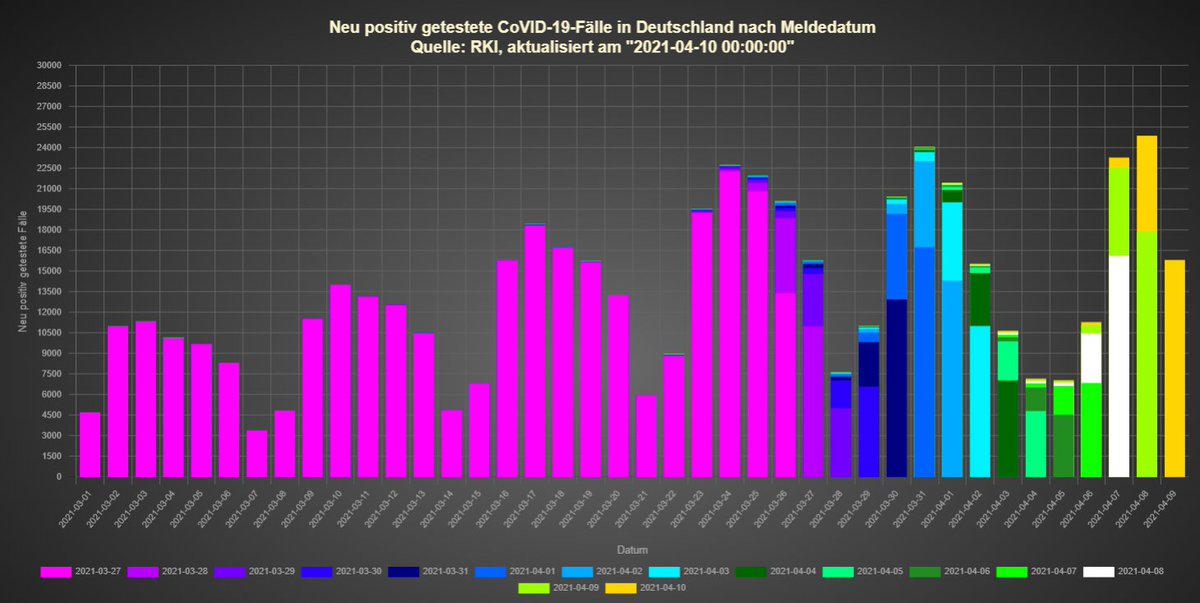

Datenstand 10.04.2021:

Nach Meldedatum weiterhin fast keine Oster-Nachmeldungen. Nur die Korrekturen auf Erkrankungsdatum verschieben Fälle in die Osterzeit.

Nach Meldedatum weiterhin fast keine Oster-Nachmeldungen. Nur die Korrekturen auf Erkrankungsdatum verschieben Fälle in die Osterzeit.

Datenstand 11.04.2021:

Mein Verdacht, dass es kaum Nachmeldungen für die Osterfeiertage geben wird, erhärtet sich immer mehr.

Gleichzeitig bedeutet es jedoch auch, dass die hohen Fallzahlen in dieser Woche bisher real und unverfälscht waren.

Mein Verdacht, dass es kaum Nachmeldungen für die Osterfeiertage geben wird, erhärtet sich immer mehr.

Gleichzeitig bedeutet es jedoch auch, dass die hohen Fallzahlen in dieser Woche bisher real und unverfälscht waren.

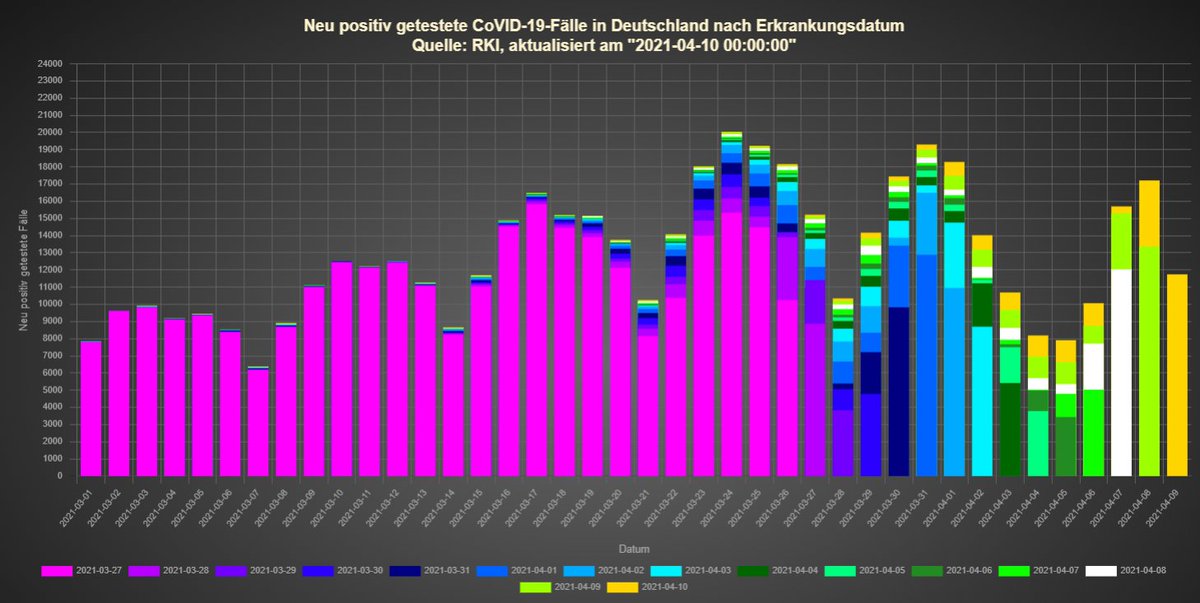

Datenstand 12.04.2021:

Sonntags ist in den Daten nie viel los, deswegen sind hier auch keine neuen Erkenntnisse zu gewinnen - mit einer Ausnahme: KW 14 wird wohl an den Nicht-Feiertagen etwas mehr Fälle als KW 12 gehabt haben.

Sonntags ist in den Daten nie viel los, deswegen sind hier auch keine neuen Erkenntnisse zu gewinnen - mit einer Ausnahme: KW 14 wird wohl an den Nicht-Feiertagen etwas mehr Fälle als KW 12 gehabt haben.

Datenstand 13.04.2021:

Ich denke ich werde das Projekt jetzt noch bis Ende der Woche fortsetzen. Danach macht es - zumindest mit Blick auf #Ostern - kaum mehr Sinn.

Heute, wie schon gestern, wenig los in Sachen #Nachmeldungen. Das ist aber normal. Spannend wird es ab morgen.

Ich denke ich werde das Projekt jetzt noch bis Ende der Woche fortsetzen. Danach macht es - zumindest mit Blick auf #Ostern - kaum mehr Sinn.

Heute, wie schon gestern, wenig los in Sachen #Nachmeldungen. Das ist aber normal. Spannend wird es ab morgen.

Datenstand 14.04.2021:

Wird jetzt deutlich, dass das Wachstum nicht mehr bei 20 - 30% liegt. Trotzdem wachsen die Säulen weiter an.

Interessant: Keine neuen Fälle nach Erkrankungsdatum am 09. und 10.04. über ganz Deutschland?!

Wird jetzt deutlich, dass das Wachstum nicht mehr bei 20 - 30% liegt. Trotzdem wachsen die Säulen weiter an.

Interessant: Keine neuen Fälle nach Erkrankungsdatum am 09. und 10.04. über ganz Deutschland?!

• • •

Missing some Tweet in this thread? You can try to

force a refresh