A hipótese só pode possuir dois valores: Verdadeiro ou Falso (sem paradoxos, galera! 😂)

Hipótese nula (denotada H_0): é uma hipótese que, normalmente, vai contra o que queremos provar;

Hipótese alternativa (denotada H_1): uma hipótese de acordo com o que queremos provar.

Assim, só rejeitamos a hipótese nula se tivermos evidência forte o suficiente contra ela (um análogo de evidência de culpa “beyond any reasonable doubt” dos julgamentos, para condenar um suspeito).

Erro tipo I: Rejeitar a hipótese nula dado que ela é verdadeira;

Erro tipo II: Não rejeitar a hipóese nula dados que ela é falsa.

Fato triste: Matematicamente, não conseguimos controlar os dois erros ao mesmo tempo.

1: Controlar o erro tipo I;

2: Controlar o erro tipo II;

3: Controlar combinações lineares entre os erros tipo I e tipo II.

Desta forma, o que costuma-se fazer normalmente?

O exemplo abaixo nos ajuda a ilustrar o que costuma ser feito.

H_0: “o suspeito é inocente” (é a hipótese contrária à tese dela e que precisa de evidência forte para ser rejeitada);

H_1: “o suspeito é culpado”.

Erro Tipo I: Condenar inocente;

Erro Tipo II: Soltar culpado.

É um consenso que é mais grave condenar um inocente e assim, neste caso, haveria uma preferência por controlar o erro tipo I.

De fato, é isso que é feito nas análises estatística: controla-se o erro tipo I.

Mas… O quer dizer controlar o erro?

A primeira definição que precisamos é de “estatística” (não a ciência, mas sim uma definição matemática).

Exemplo de estatística: média amostral (X_1 + … X_n)/n

Matematicamente,queremos que a distribuição da estatística mude com a hipótese

Neste caso, a estatística é chamada de “estatística do teste”.

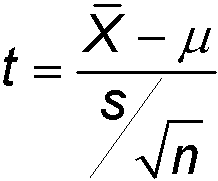

Um exemplo clássico é a estatística t para uma amostra normal iid.

É diferente do estimador, que não pode, de forma alguma, depender de parâmetros desconhecidos.

Como queremos controlar o erro tipo I (onde supomos que a hipótese nula é verdadeira), supomos que a hipótese nula é verdadeira, e obtemos a distribuição da estatística do teste em questão.

Assintótica aqui costuma significar o caso limite quando o tamanho amostral tende a infinito

Mas temos outros casos assintóticos…

Como já vimos que o padrão é “controlar” o erro tipo I, vamos controlar a probabilidade do teste “errar” sob a hipótese nula.

P_0(Estatística do teste PERTENCER à região C) = 1 – alpha,

onde P_0 é a medida de probabilidade supondo H_0 verdadeira, tal que conhecemos a distribuição (exata ou assintótica) da estatística do teste.

C é chamada de “região crítica” e depende de alpha.

Normalmente trabalha-se com o nível de significância alpha = 5%, é chamado de nível de significância padrão ou usual.

Fim da parte 1 da thread!

Já ficou longa. Fim de semana que vem (se houver interesse) teremos a Parte 2!

Importância de um planejamento de experimentos adequado; Importância das suposições; Testes sequenciais (erros comuns ao fazer), Consistência lógica (ou não!).