📱 #IA : les #algorithmes sont-ils sexistes ? Racistes ? Homophobes ?

Conçus par l'homme ils peuvent en effet reproduire et amplifier des discriminations. Comment s'en prémunir ? 🧐

➡️ Un rapport dirigé par @AnneBouverot @TDelaporte

institutmontaigne.org/publications/a…

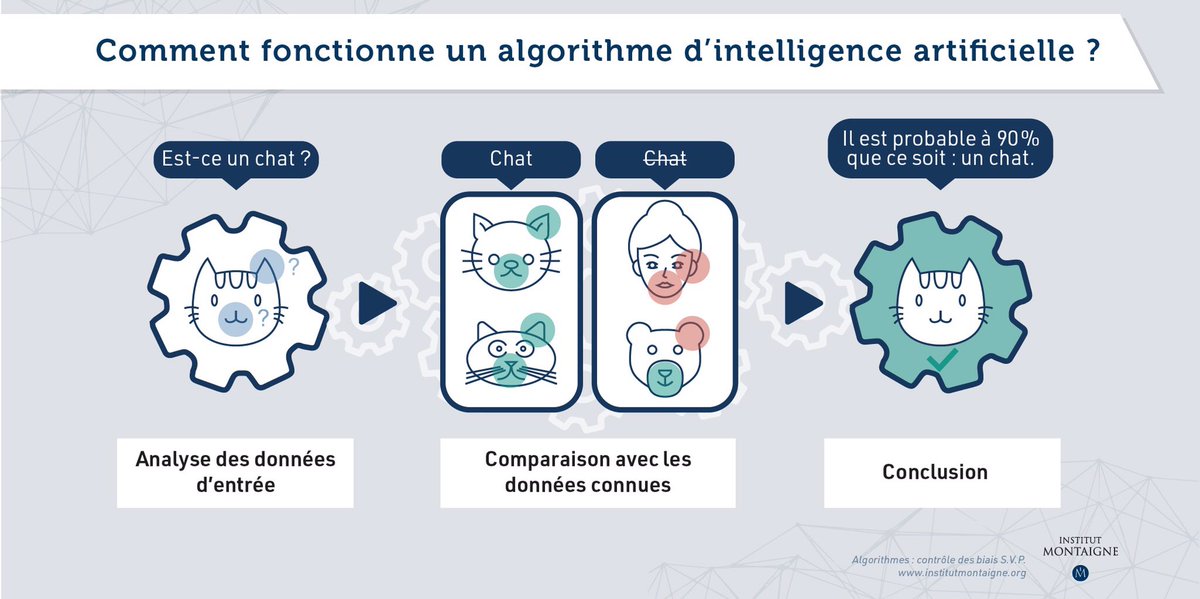

📱 #IA : les #algorithmes, tout le monde en parle. Mais sauriez-vous expliquer comment cela fonctionne si on vous posait la question ?

Le point en infographie. 🔎

➡️ Découvrez nos propositions pour combattre les potentiels biais.

institutmontaigne.org/publications/a…

📱 #IA : quand on parle de "biais des #algorithmes", qu'entendons-nous par là ? 🤔

Accrochez vos ceintures, on vous explique ! ⬇️ #thread

1/5

institutmontaigne.org/publications/a…

Reprenons depuis le début. 🤓

Un #algorithme sert à analyser des données en quantité et à des vitesses inaccessibles à l’être humain.

👨🏽💻👩💻 Une fois les données analysées, un #algorithme tire statistiquement des conclusions réutilisables.

Le revers de la médaille ? 🤔

Les #algorithmes peuvent faire résonner, voire accentuer les pires biais humains : sexisme, racisme, injustice sociale…

À chaque étape de leur construction, les #algorithmes risquent effectivement d’être « biaisés » soit :

1️⃣ techniquement

Exemple : un biais peut se glisser dans la base de données

2️⃣ ou par la société

Exemple : en reproduisant un stéréotype

Alors pour que les #algorithmes puissent rester des outils au service des humains, il est essentiel de :

💡 Mettre en lumière ces erreurs

✍️ Les corriger

C’est l’objet de notre rapport ! Par ici pour en savoir plus.

institutmontaigne.org/publications/a…

latribune.fr/technos-medias…

lexpress.fr/actualite/soci…

usine-digitale.fr/article/labels…

lopinion.fr/edition/politi…